صورة المؤلف

لقد واجهنا جميعًا مؤخرًا وقتًا عصيبًا للغاية في اللحاق بأحدث الإصدارات في مساحة LLM. في الأسابيع القليلة الماضية ، أصبحت العديد من بدائل ChatGPT مفتوحة المصدر شائعة.

وفي هذه المقالة سوف نتعرف على ملف الدردشة وسلسلة الدردشة، وهو بديل ChatGPT مفتوح المصدر وخفيف الوزن.

هيا بنا نذهب!

عمل الباحثون في جامعة تسينغهوا في الصين على تطوير سلسلة نماذج ChatGLM التي لها أداء مشابه لنماذج أخرى مثل GPT-3 و BLOOM.

ChatGLM هو نموذج ثنائي اللغة ثنائي اللغة تم تدريبه على اللغتين الصينية والإنجليزية. حاليًا ، النماذج التالية متوفرة:

- ChatGLM-130B: برنامج ماجستير مفتوح المصدر

- ChatGLM-100B: ليست مفتوحة المصدر ، ولكنها متاحة من خلال وصول الدعوة فقط

- ChatGLM-6B: بديل خفيف الوزن مفتوح المصدر

على الرغم من أن هذه النماذج قد تبدو مشابهة لمجموعة Generative Pretrained Transformer (GPT) لنماذج اللغات الكبيرة ، فإن نموذج اللغة العامة (GLM) إطار عمل ما قبل التدريب هو ما يجعلهم مختلفين. سنتعلم المزيد عن هذا في القسم التالي.

في التعلم الآلي ، ستعرف أن GLMs هي النماذج الخطية المعممة، ولكن GLM في ChatGLM تعني نموذج اللغة العامة.

إطار عمل GLM قبل التدريب

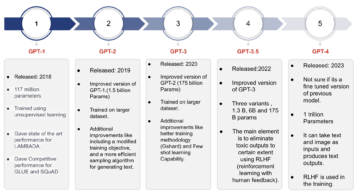

تمت دراسة التدريب المسبق لـ LLM على نطاق واسع ولا يزال مجالًا للبحث النشط. دعنا نحاول فهم الاختلافات الرئيسية بين نماذج التدريب المسبق GLM ونماذج GPT.

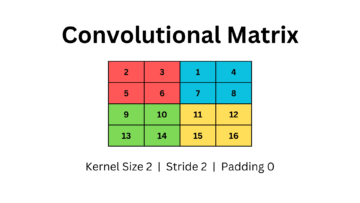

تستخدم عائلة نماذج GPT-3 نمذجة لغة رجعية تلقائية لوحدة فك التشفير فقط. في GLM ، من ناحية أخرى ، تتم صياغة تحسين الهدف على أنه مشكلة ملء الفراغ الانحدار التلقائي.

جي إل إم | مصدر الصورة

بعبارات بسيطة ، ملء الفراغ الارتدادي التلقائي يتضمن مسح امتداد مستمر من النص ، ثم إعادة بناء النص بالتتابع هذا الطمس. بالإضافة إلى الأقنعة الأقصر ، يوجد قناع أطول يزيل عشوائيًا الفراغات الطويلة من النص من نهاية الجمل. يتم ذلك بحيث يؤدي النموذج أداءً جيدًا بشكل معقول في فهم اللغة الطبيعية بالإضافة إلى مهام التوليد.

هناك اختلاف آخر في نوع الانتباه المستخدم. تستخدم مجموعة GPT لنماذج اللغات الكبيرة الانتباه أحادي الاتجاه ، بينما تستخدم مجموعة GLM من LLMs الاهتمام ثنائي الاتجاه. يمكن أن يؤدي استخدام الاهتمام ثنائي الاتجاه على السياقات غير المقنعة إلى التقاط التبعيات بشكل أفضل وتحسين الأداء في مهام فهم اللغة الطبيعية.

تفعيل GELU

في GLM ، يتم استخدام تنشيط GELU (وحدات خطأ غاوسي الخطية) بدلاً من تنشيط ReLU [1].

عمليات تنشيط GELU و ReLU و ELU | مصدر الصورة

تنشيط GELU وله قيم غير صفرية لجميع المدخلات وله الشكل التالي [3]:

تم العثور على تنشيط GELU لتحسين الأداء بالمقارنة مع عمليات التنشيط ReLU ، على الرغم من أنها أكثر كثافة من الناحية الحسابية من ReLU.

في سلسلة GLM من LLM ، ChatGLM-130B وهو مفتوح المصدر ويعمل مثل نموذج Da-Vinci GPT-3. كما ذكرنا ، حتى كتابة هذا المقال ، هناك إصدار ChatGLM-100B ، والذي يقتصر على الوصول بدعوة فقط.

الدردشة

التفاصيل التالية حول ChatGLM-6B لجعلها أكثر سهولة للمستخدمين النهائيين:

- لديها حوالي 6.2 مليار معلمة.

- تم تدريب النموذج مسبقًا على 1 تريليون رمز - بالتساوي من الإنجليزية والصينية.

- بعد ذلك ، يتم استخدام تقنيات مثل الضبط الدقيق الخاضع للإشراف والتعلم المعزز مع التغذية الراجعة البشرية.

دعنا نختتم مناقشتنا من خلال استعراض مزايا وقيود ChatGLM:

المزايا

من كونه نموذج ثنائي اللغة إلى نموذج مفتوح المصدر يمكنك تشغيله محليًا ، يتمتع ChatGLM-6B بالمزايا التالية:

- يتم تدريب معظم نماذج اللغات الكبيرة السائدة على مجموعة كبيرة من النصوص الإنجليزية ، ونماذج اللغات الكبيرة للغات الأخرى ليست شائعة. سلسلة ChatGLM من LLM ثنائية اللغة وهي خيار رائع للصينية. النموذج لديه أداء جيد باللغتين الإنجليزية والصينية.

- تم تحسين ChatGLM-6B لأجهزة المستخدم. غالبًا ما يكون لدى المستخدمين النهائيين موارد حوسبة محدودة على أجهزتهم ، لذلك يصبح من المستحيل تقريبًا تشغيل LLM محليًا - بدون الوصول إلى وحدات معالجة الرسومات عالية الأداء. مع تكميم INT4، يمكن تشغيل ChatGLM-6B بمتطلبات ذاكرة متواضعة تصل إلى 6 جيجابايت.

- يؤدي أداءً جيدًا في مجموعة متنوعة من المهام بما في ذلك التلخيص والمحادثات الفردية ومتعددة الاستعلام.

- على الرغم من العدد الأصغر بكثير من المعلمات مقارنةً بـ LLMs السائد الأخرى ، يدعم ChatGLM-6B طول سياق يصل إلى 2048.

القيود

بعد ذلك ، دعنا ندرج بعض قيود ChatGLM-6B:

- على الرغم من أن ChatGLM هو نموذج ثنائي اللغة ، فمن المحتمل أن يكون أداؤه باللغة الإنجليزية دون المستوى الأمثل. يمكن أن يعزى ذلك إلى التعليمات المستخدمة في التدريب في الغالب باللغة الصينية.

- لأن ChatGLM-6B لديه إلى حد كبير عدد أقل من المعلمات بالمقارنة مع LLMs الأخرى مثل BLOOM و GPT-3 و ChatGLM-130B ، قد يكون الأداء أسوأ عندما يكون السياق طويلاً للغاية. نتيجة لذلك ، قد يقدم ChatGLM-6B معلومات غير دقيقة في كثير من الأحيان أكثر من النماذج التي تحتوي على عدد أكبر من المعلمات.

- نماذج اللغات الصغيرة لها سعة ذاكرة محدودة. لذلك ، في الدردشات متعددة الأدوار ، قد يتدهور أداء النموذج قليلاً.

- يعد التحيز والمعلومات الخاطئة والسمية قيودًا على جميع LLMs ، كما أن ChatGLM عرضة لهذه أيضًا.

كخطوة تالية ، قم بتشغيل ChatGLM-6B محليًا أو جرب العرض التوضيحي على مساحات HuggingFace. إذا كنت ترغب في التعمق في عمل LLM ، فإليك قائمة بـ دورات مجانية على نماذج اللغات الكبيرة.

[1] Z Du و Y Qian وآخرون GLM: نموذج اللغة العامة التدريب المسبق مع الانحدار التلقائي للحشو الفارغ، دوري أبطال آسيا 2022

[2] أ زينج ، إكس ليو وآخرون ، GLM-130B - نموذج مفتوح ثنائي اللغة محدد مسبقًا، ICML 2023

[3] D Hendryks، K Gimpel، وحدات خطأ غاوسي الخطية (GELUs)، arXiv ، 2016

[4] ChatGLM-6B: عرض توضيحي على HuggingFace Spaces

[5] جيثب ريبو

بالا بريا سي هو كاتب تقني يستمتع بإنشاء محتوى طويل. تشمل مجالات اهتمامها الرياضيات والبرمجة وعلوم البيانات. تشارك ما تعلمته مع مجتمع المطورين من خلال تأليف البرامج التعليمية والأدلة الإرشادية والمزيد.

- محتوى مدعوم من تحسين محركات البحث وتوزيع العلاقات العامة. تضخيم اليوم.

- أفلاطونايستريم. ذكاء بيانات Web3. تضخيم المعرفة. الوصول هنا.

- سك المستقبل مع أدرين أشلي. الوصول هنا.

- المصدر https://www.kdnuggets.com/2023/04/chatglm6b-lightweight-opensource-chatgpt-alternative.html?utm_source=rss&utm_medium=rss&utm_campaign=chatglm-6b-a-lightweight-open-source-chatgpt-alternative

- :لديها

- :يكون

- :ليس

- $ UP

- 1

- a

- من نحن

- الوصول

- يمكن الوصول

- تفعيل

- التنشيط

- نشط

- إضافة

- مزايا

- AL

- الكل

- البديل

- بالبدائل

- an

- و

- هي

- المنطقة

- المناطق

- البند

- AS

- At

- اهتمام

- التأليف

- السيارات

- متاح

- BE

- أصبح

- يصبح

- كان

- يجري

- أفضل

- ما بين

- مليار

- إزهار

- على حد سواء

- لكن

- by

- CAN

- أسر

- شات جي بي تي

- الصين

- الصينية

- خيار

- مشترك

- مجتمع

- مماثل

- مقارنة

- الحوسبة

- محتوى

- سياق الكلام

- السياقات

- متواصل

- دورات

- خلق

- حاليا

- البيانات

- علم البيانات

- أعمق

- تجربة

- تفاصيل

- المطور

- تطوير

- الأجهزة

- فرق

- الخلافات

- مختلف

- مناقشة

- فعل

- E & T

- النهاية

- عربي

- خطأ

- للعائلات

- ردود الفعل

- قليل

- أقل

- متابعيك

- في حالة

- النموذج المرفق

- وجدت

- تبدأ من

- العلاجات العامة

- جيل

- توليدي

- دولار فقط واحصل على خصم XNUMX% على جميع

- منح

- الذهاب

- خير

- وحدات معالجة الرسومات

- عظيم

- تجمع

- دليل

- يد

- الثابت

- يملك

- وجود

- لها

- هنا

- أداء عالي

- HTML

- HTTPS

- تعانق الوجه

- الانسان

- if

- مستحيل

- تحسن

- in

- غير دقيق

- تتضمن

- بما فيه

- معلومات

- بدلًا من ذلك

- تعليمات

- مصلحة

- إلى

- ينطوي

- IT

- انها

- JPG

- KD nuggets

- القفل

- علم

- لغة

- اللغات

- كبير

- أكبر

- اسم العائلة

- آخر

- تعلم

- تعلم

- الطول

- خفيفة الوزن

- مثل

- على الأرجح

- القيود

- محدود

- لينكدين:

- قائمة

- محليا

- طويل

- يعد

- منخفض

- آلة

- آلة التعلم

- التيار

- جعل

- يصنع

- قناع

- ماسكات

- الرياضيات

- مايو..

- مكبر الصوت : يدعم، مع دعم ميكروفون مدمج لمنع الضوضاء

- المذكورة

- معلومات خاطئة

- نموذج

- تصميم

- عارضات ازياء

- الأكثر من ذلك

- طبيعي

- اللغة الطبيعية

- فهم اللغة الطبيعية

- التالي

- عدد

- NVIDIA

- موضوعي

- of

- غالبا

- on

- جاكيت

- المصدر المفتوح

- التحسين

- الأمثل

- or

- أخرى

- لنا

- خارج

- على مدى

- المعلمات

- أداء

- ينفذ

- أفلاطون

- الذكاء افلاطون البيانات

- أفلاطون داتا

- أكثر الاستفسارات

- قبل

- برمجة وتطوير

- تعزيز التعلم

- النشرات

- المتطلبات

- بحث

- الموارد

- مقيد

- نتيجة

- يجري

- s

- علوم

- القسم

- مسلسلات

- عدة

- مشاركة

- هي

- مماثل

- الاشارات

- عزباء

- الأصغر

- So

- الفضاء

- المساحات

- امتداد

- المدرجات

- خطوة

- لا يزال

- مدروس

- هذه

- فائق

- الدعم

- عرضة

- المهام

- تقني

- تقنيات

- سياسة الحجب وتقييد الوصول

- من

- أن

- •

- من مشاركة

- منهم

- then

- هناك.

- وبالتالي

- تشبه

- عبر

- الوقت

- إلى

- جدا

- متدرب

- قادة الإيمان

- تريليون

- تسينغهوا

- الدروس

- نوع

- فهم

- فهم

- الوحدات

- جامعة

- تستخدم

- مستعمل

- مستخدم

- المستخدمين

- استخدام

- القيم

- تشكيلة

- الإصدار

- أسابيع

- حسن

- ابحث عن

- متى

- التي

- من الذى

- مع

- عمل

- عامل

- أسوأ

- التفاف

- كاتب

- جاري الكتابة

- X

- لصحتك!

- زفيرنت