গুডহার্টের আইন বিখ্যাতভাবে বলেছেন: "যখন একটি পরিমাপ একটি লক্ষ্যে পরিণত হয়, তখন এটি একটি ভাল পরিমাপ হওয়া বন্ধ করে দেয়।" যদিও মূলত অর্থনীতি থেকে, এটি এমন কিছু যা আমাদের ওপেনএআই-এর সাথে লড়াই করতে হবে যখন পরিমাপ করা কঠিন বা ব্যয়বহুল উদ্দেশ্যগুলিকে কীভাবে অপ্টিমাইজ করা যায়। এটা প্রায়ই কিছু পরিচয় করিয়ে দেওয়া প্রয়োজন প্রক্সি উদ্দেশ্য এটি পরিমাপ করা সহজ বা সস্তা, কিন্তু যখন আমরা এটি করি, তখন আমাদের সতর্কতা অবলম্বন করতে হবে যাতে এটি খুব বেশি অপ্টিমাইজ না হয়।

উদাহরণস্বরূপ, আমাদের কাজের অংশ হিসাবে শ্রেণীবদ্ধ করা মানব অভিপ্রায় এবং মূল্যবোধ সহ GPT-3 এর মতো মডেল, আমরা "কীভাবে সহায়ক এই প্রতিক্রিয়া কি?", বা "কিভাবে বাস্তবিকভাবে সঠিক এটা কি দাবি?" এগুলি এমন জটিল উদ্দেশ্য যেগুলির জন্য মানুষকে সাবধানে জিনিসগুলি পরীক্ষা করতে হবে। এই কারণে, আমরা এই মানব পছন্দগুলি ভবিষ্যদ্বাণী করার জন্য একটি মডেলকে প্রশিক্ষণ দিই, যা একটি নামে পরিচিত পুরস্কার মডেল, এবং একটি প্রক্সি উদ্দেশ্য হিসাবে পুরস্কার মডেলের ভবিষ্যদ্বাণীগুলি ব্যবহার করুন৷ কিন্তু প্রকৃত উদ্দেশ্য কতটা ভালোভাবে অপ্টিমাইজ করা হচ্ছে তার ট্র্যাক রাখা গুরুত্বপূর্ণ।

এই পোস্টে আমরা কীভাবে এটি করি তার পিছনের কিছু গণিত দেখব। আমরা এমন একটি সেটিংয়ে ফোকাস করব যা বিশ্লেষণ করার জন্য বিশেষভাবে পরিষ্কার, যেখানে আমাদের প্রকৃত উদ্দেশ্যের অ্যাক্সেস আছে। বাস্তবে, এমনকি মানুষের পছন্দগুলিও আমরা যা সম্পর্কে সত্যিই চিন্তা করি তা পরিমাপ করতে ব্যর্থ হতে পারে, তবে আমরা এই পোস্টে সেই সমস্যাটিকে সরিয়ে রাখছি।

$n$-এর সেরা নমুনা

প্রক্সি উদ্দেশ্য অপ্টিমাইজ করতে পারে এমন অনেক উপায় আছে, কিন্তু সম্ভবত সবচেয়ে সহজ $n$-এর সেরা নমুনা, এই নামেও পরিচিত প্রত্যাখ্যান নমুনা or reranking. আমরা কেবল $n$ বার নমুনা করি এবং প্রক্সি উদ্দেশ্য অনুসারে সর্বোচ্চ স্কোর করে এমন একটি গ্রহণ করি।

যদিও এই পদ্ধতিটি খুবই সহজ, এটি আসলে আরো উন্নত কৌশল যেমন রিইনফোর্সমেন্ট লার্নিং এর সাথে প্রতিযোগিতামূলক হতে পারে, যদিও বেশি ইনফরেন্স-টাইম কম্পিউট খরচ করে। উদাহরণস্বরূপ, মধ্যে ওয়েবজিপিটি, আমাদের সেরা-এর-$64$ মডেলটি আমাদের শক্তিবৃদ্ধি শেখার মডেলকে ছাড়িয়ে গেছে, সম্ভবত আংশিকভাবে কারণ $64$-এর সেরা মডেলটি আরও অনেক ওয়েবসাইট ব্রাউজ করতে পেরেছে। এমনকি $4$-এর সর্বোত্তম-প্রয়োগ করা মানুষের পছন্দগুলিকে একটি উল্লেখযোগ্য বৃদ্ধি প্রদান করেছে।

উপরন্তু, সর্বোত্তম-অফ-$n$ নমুনার নির্ভরযোগ্য কার্যকারিতা রয়েছে এবং গাণিতিকভাবে বিশ্লেষণ করার জন্য এটি সহজবোধ্য, এটি গুডহার্টের আইন এবং সম্পর্কিত ঘটনাগুলির অভিজ্ঞতামূলক গবেষণার জন্য উপযুক্ত করে তোলে।

$n$-এর সেরা নমুনার গণিত

আসুন আরও আনুষ্ঠানিকভাবে $n$-এর সেরা নমুনা অধ্যয়ন করি। ধরুন আমাদের কাছে কিছু নমুনা স্থান আছে $S$ (যেমন সম্ভাব্য প্রশ্ন-উত্তর জোড়ার সেট), কিছু সম্ভাব্যতা বন্টন $P$ ওভার $S$, একটি প্রকৃত উদ্দেশ্য (বা "পুরস্কার") $R_{text{true}}:Stomathbb R$, এবং একটি প্রক্সি উদ্দেশ্য $R_{text{proxy}}: Stomathbb R$। ধরা যাক যে আমরা একরকম $R_{text{proxy}}$ অপ্টিমাইজ করি এবং এর ফলে কিছু নতুন বিতরণ পাই $P^প্রাইম$। তারপর:

- প্রত্যাশা $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ পরিমাপ করে যে আমরা সত্যিকারের উদ্দেশ্য কতটা ভালোভাবে অপ্টিমাইজ করেছি।

- সার্জারির কেএল বিচ্যুতি $D_{text{KL}}left(P^primeparallel Pright)$ আমরা কতটা অপ্টিমাইজেশন করেছি তা পরিমাপ করে। উদাহরণস্বরূপ, যদি $P^prime$ $P$ থেকে প্রথম নমুনা গ্রহণ করে প্রাপ্ত হয় যা কিছু উপসেটে থাকে $S^primesubseteq S$, তাহলে এই KL ডাইভারজেন্স হল নেতিবাচক লগ সম্ভাব্যতা যা $P$ থেকে একটি নমুনা $S^prime$ এ রয়েছে।

এটি দেখা যাচ্ছে যে $n$-এর সেরা নমুনার ক্ষেত্রে, এই উভয় পরিমাণই $P$ থেকে নমুনা ব্যবহার করে দক্ষতার সাথে অনুমান করা যেতে পারে।

আগে প্রত্যাশার দিকে তাকাই। নিষ্পাপ পন্থা হল একটি মন্টে কার্লো অনুমানকারী ব্যবহার করা: অনেকবার সেরা-অফ-$n$ নমুনা চালান, সেই নমুনাগুলিতে প্রকৃত উদ্দেশ্য পরিমাপ করুন এবং ফলাফলগুলি গড় করুন৷ যাইহোক, একটি ভাল অনুমানকারী আছে. যদি আমাদের সামগ্রিক $P$ থেকে $Ngeq n$ নমুনা থাকে, তাহলে আমরা একই সাথে বিবেচনা করতে পারি প্রতিটি সম্ভাব্য উপসেট $n$ আকারের এই নমুনাগুলির মধ্যে, প্রতিটি নমুনাকে উপসেটের সংখ্যা অনুসারে ওজন করুন যার জন্য এটি প্রক্সি উদ্দেশ্য অনুসারে সেরা, এবং তারপর ওজনযুক্ত গড় সত্যিকারের উদ্দেশ্য স্কোর নিন। এই ওজন মাত্র দ্বিপদী সহগ $binom{k-1}{n-1}$, যেখানে $k$ হল প্রক্সি উদ্দেশ্যের অধীনে নমুনার র্যাঙ্ক, $1$ (সবচেয়ে খারাপ) থেকে $N$ (সর্বোত্তম) পর্যন্ত। নমুনাগুলিকে আরও দক্ষতার সাথে ব্যবহার করার পাশাপাশি, এটি আমাদেরকে $n$ এর বিভিন্ন মানের জন্য নমুনাগুলি পুনরায় ব্যবহার করার অনুমতি দেয়।

KL ডাইভারজেন্সের জন্য, আশ্চর্যজনকভাবে, এটিতে একটি সঠিক সূত্র রয়েছে যা যেকোন অবিচ্ছিন্ন সম্ভাব্যতা বন্টনের জন্য কাজ করে $P$ (অর্থাৎ, যতক্ষণ না $P$ এর কোনো বিন্দু ভর নেই)। একজন সহজে অনুমান করতে পারে যে উত্তরটি $log n$, যেহেতু best-of-$n$ ডিস্ট্রিবিউশনের শীর্ষ $frac 1n$ নেওয়ার মতো কিছু করছে, এবং এটি মোটামুটি সঠিক: সঠিক উত্তর হল $log n-frac{n-1}n$.

একসাথে, এই অনুমানকারীগুলি আমাদের সহজেই বিশ্লেষণ করতে দেয় যে কীভাবে প্রকৃত উদ্দেশ্য প্রক্সি লক্ষ্যে প্রয়োগ করা অপ্টিমাইজেশনের পরিমাণের সাথে পরিবর্তিত হয়।

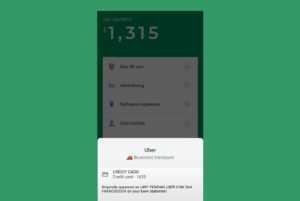

এখানে থেকে একটি বাস্তব জীবনের উদাহরণ ওয়েবজিপিটি:

WebGPT 175B-এর জন্য $n$-এর সেরা পারফরম্যান্স

WebGPT-এর জন্য সর্বোত্তম-অফ-$n$ পারফরম্যান্স, ছায়াযুক্ত অঞ্চলগুলিকে উপস্থাপন করে $pm 1$ স্ট্যান্ডার্ড ত্রুটি, এবং KL অক্ষ একটি বর্গমূল স্কেল অনুসরণ করে। এখানে, মূল বন্টন ($P$) 175B মডেল দ্বারা প্রদত্ত হয় যারা আচরণ ক্লোনিং ব্যবহার করে প্রশিক্ষিত হয়, প্রক্সি উদ্দেশ্যটি সেরা-অফ-$n$ ($R_{text{proxy}}$) গণনা করতে ব্যবহৃত হয় পুরষ্কার মডেল, এবং আমরা তিনটি যুক্তিযুক্ত "সত্য" উদ্দেশ্য বিবেচনা করি ($R_{টেক্সট{true}}$): প্রশিক্ষণের পুরস্কার মডেল নিজেই, একটি বৈধতা পুরস্কারের মডেল যা ধরে রাখা ডেটাতে প্রশিক্ষিত, এবং প্রকৃত মানুষের পছন্দ। প্রক্সি উদ্দেশ্যের খুব বেশি অপ্টিমাইজেশন নেই, তবে আমরা আশা করব সেখানে উচ্চতর KL-এ থাকবে।

সর্বোত্তম-$n$ স্যাম্পলিংয়ের বাইরে যাওয়া

$n$-এর সেরা স্যাম্পলিংয়ের প্রধান সীমাবদ্ধতা হল যে KL ডাইভারজেন্স লগারিদমিকভাবে $n$ এর সাথে বৃদ্ধি পায়, তাই এটি শুধুমাত্র অল্প পরিমাণ অপ্টিমাইজেশন প্রয়োগ করার জন্য উপযুক্ত।

আরো অপ্টিমাইজেশান প্রয়োগ করতে, আমরা সাধারণত রিইনফোর্সমেন্ট লার্নিং ব্যবহার করি। সেটিংসে আমরা এখন পর্যন্ত অধ্যয়ন করেছি, যেমন সংক্ষিপ্তকরণ, আমরা সাধারণত প্রায় 10 এর KL এ পৌঁছাতে সক্ষম হয়েছি বাদাম গুডহার্টের আইনের কারণে প্রকৃত উদ্দেশ্য হ্রাস পেতে শুরু করার আগে শক্তিবৃদ্ধি শিক্ষা ব্যবহার করা। এই KL ব্যবহার করে পৌঁছানোর জন্য আমাদের প্রায় 60,000 হতে $n$ নিতে হবে সেরা-$n$, এবং আমরা আশা করি আমাদের পুরষ্কার মডেলিং এবং শক্তিবৃদ্ধি শেখার অনুশীলনের উন্নতির সাথে এর থেকে অনেক বড় KL-এ পৌঁছতে সক্ষম হব।

যাইহোক, সব ন্যাট সমান নয়। অভিজ্ঞতাগতভাবে, ছোট KL বাজেটের জন্য, সর্বোত্তম-অফ-$n$ শক্তিবৃদ্ধি শেখার চেয়ে প্রক্সি এবং প্রকৃত উদ্দেশ্য উভয়কেই অপ্টিমাইজ করে। স্বজ্ঞাতভাবে, সর্বোত্তম-অফ-$n$ হল "ব্রুট ফোর্স" পদ্ধতি, এটিকে আরও তথ্য-তাত্ত্বিকভাবে শক্তিবৃদ্ধি শেখার চেয়ে দক্ষ করে তোলে, কিন্তু বড় কেএল-এ কম গণনাগতভাবে দক্ষ।

আমরা আমাদের কাজের অংশ হিসাবে প্রক্সি উদ্দেশ্যগুলির স্কেলিং বৈশিষ্ট্যগুলি সক্রিয়ভাবে অধ্যয়ন করছি৷ শ্রেণীবদ্ধ করা মানব অভিপ্রায় এবং মূল্যবোধের সাথে আমাদের মডেল। আপনি যদি এই গবেষণায় আমাদের সাহায্য করতে চান, আমরা আছি হায়ারিং!

- AI

- ai শিল্প

- এআই আর্ট জেনারেটর

- আইআই রোবট

- কৃত্রিম বুদ্ধিমত্তা

- কৃত্রিম বুদ্ধিমত্তা সার্টিফিকেশন

- ব্যাংকিং এ কৃত্রিম বুদ্ধিমত্তা

- কৃত্রিম বুদ্ধিমত্তার রোবট

- কৃত্রিম বুদ্ধিমত্তার রোবট

- কৃত্রিম বুদ্ধিমত্তা সফ্টওয়্যার

- blockchain

- ব্লকচেইন সম্মেলন এআই

- coingenius

- কথোপকথন কৃত্রিম বুদ্ধিমত্তা

- ক্রিপ্টো সম্মেলন এআই

- ডাল-ই

- গভীর জ্ঞানার্জন

- গুগল আই

- মেশিন লার্নিং

- OpenAI

- Plato

- প্লেটো এআই

- প্লেটো ডেটা ইন্টেলিজেন্স

- প্লেটো গেম

- প্লেটোডাটা

- প্লেটোগেমিং

- গবেষণা

- স্কেল ai

- বাক্য গঠন

- zephyrnet