Dataintegrationsprocesser drager fordel af automatiseret test ligesom enhver anden software. Alligevel er det sjældent at finde et datapipeline-projekt med et passende sæt af automatiserede tests. Selv når et projekt har mange tests, er de ofte ustrukturerede, kommunikerer ikke deres formål og er svære at køre.

Et kendetegn ved datapipeline udvikling er den hyppige udgivelse af data af høj kvalitet for at få brugerfeedback og accept. Ved afslutningen af hver datapipeline-iteration forventes det, at dataene er af høj kvalitet til næste fase.

Automatiseret test er afgørende for integrationstest af datapipelines. Manuel test er upraktisk i meget iterative og adaptive udviklingsmiljøer.

Primære problemer med manuel datatestning

For det første tager det for lang tid og er en kritisk hæmmer for den hyppige levering af rørledninger. Hold, der primært er afhængige af manuel test, ender med at udskyde test til dedikerede testperioder, hvilket tillader fejl at akkumulere.

For det andet er manuel datapipeline-test utilstrækkeligt reproducerbar til regressionstest.

Automatisering af datapipelinetestene kræver indledende planlægning og kontinuerlig omhu, men når først de tekniske teams har vedtaget automatisering, er projektets succes mere sikret.

Varianter af datapipelines

- Udtræk, transformer og indlæs (ETL)

- Udtræk, indlæs og transformér (ELT)

- Data sø, data warehouse pipelines

- Real-time pipelines

- Machine learning pipelines

Datapipeline-komponenter til overvejelse af testautomatisering

Datapipelines består af flere komponenter, der hver især er ansvarlige for en specifik opgave. Elementerne i en datapipeline omfatter:

- Datakilder: Oprindelsen af data

- Dataindtagelse: Processen med at indsamle data fra datakilden

- Datatransformation: Processen med at transformere de indsamlede data til et format, der kan bruges til yderligere analyse

- Databekræftelser/valideringer: Processen for at sikre, at dataene er nøjagtige og konsistente

- Data opbevaring: Processen med at lagre de transformerede og validerede data i et datavarehus eller datasø

- Dataanalyse: Processen med at analysere de lagrede data for at identificere mønstre, tendenser og indsigt

Bedste praksis for automatisering af datapipelinetest

Hvad og hvornår du skal automatisere (eller endda hvis du har brug for automatisering) er afgørende beslutninger for test- (eller udviklings)teamet. Valget af passende produktegenskaber til automatisering bestemmer i høj grad automatiseringens succes.

Når du automatiserer tests for en datapipeline, omfatter bedste praksis:

- Definer klare og specifikke testmål: Inden du begynder at teste, er det vigtigt at definere, hvad du vil opnå gennem test. Hvis du gør det, hjælper det dig med at skabe effektive, effektive test, der giver værdifuld indsigt.

- Test alle arbejdsgange i datapipelinen: En datapipeline består normalt af flere komponenter: dataindtagelse, behandling, transformation og lagring. Det er vigtigt at teste hver komponent for at sikre den korrekte og jævne strøm af data gennem pipelinen.

- Brug troværdige testdata: Når du tester en datapipeline, er det vigtigt at bruge realistiske data, der efterligner scenarier i den virkelige verden. Dette vil hjælpe med at identificere eventuelle problemer, der kan opstå ved håndtering af forskellige datatyper.

- Automatiser med effektive værktøjer: Dette kan opnås ved hjælp af testrammer og værktøjer.

- Overvåg rørledningen regelmæssigt: Selv efter at testen er afsluttet, er det vigtigt at overvåge rørledningen regelmæssigt for at sikre, at den fungerer efter hensigten. Dette vil hjælpe med at identificere problemer, før de bliver kritiske problemer.

- Engager interessenter: Involver interessenter såsom dataanalytikere, dataingeniører og forretningsbrugere i testprocessen. Dette vil være med til at sikre, at testene er relevante og værdifulde for alle interessenter.

- Vedligehold dokumentation: Det er vigtigt at vedligeholde dokumenter, der beskriver testene, testcases og testresultater. Dette vil hjælpe med at sikre, at testene kan replikeres og vedligeholdes over tid.

Vær forsigtig; automatisering af skiftende ustabile funktioner bør undgås. I dag kan intet kendt forretningsværktøj eller sæt af metoder/processer betragtes som en komplet end-to-end test af datapipelinen.

Overvej dine testautomatiseringsmål

Datapipeline testautomatisering beskrives som at bruge værktøjer til at kontrollere 1) testudførelse, 2) sammenligninger af faktiske resultater med forudsagte resultater, og 3) opsætning af testforudsætninger og andre testkontrol- og testrapporteringsfunktioner.

Generelt involverer testautomatisering automatisering af en eksisterende manuel proces, der bruger en formel testproces.

Selvom manuelle datapipeline-tests kan afsløre mange datafejl, er de besværlige og tidskrævende. Derudover kan manuel test være ineffektiv til at opdage visse defekter.

Datapipeline-automatisering involverer udvikling af testprogrammer, som ellers skulle udføres manuelt. Når først testene er automatiseret, kan de hurtigt gentages. Dette er ofte den mest omkostningseffektive metode til en datapipeline, der kan have en lang levetid. Selv mindre rettelser eller forbedringer i løbet af pipelinens levetid kan få funktioner til at bryde, som fungerede tidligere.

Integrering af automatiseret test i udvikling af datapipeline giver et unikt sæt udfordringer. Nuværende automatiserede softwareudviklingstestværktøjer er ikke let at tilpasse til database- og datapipelineprojekter.

Den brede vifte af datapipeline-arkitekturer komplicerer disse udfordringer yderligere, fordi de involverer flere databaser, der kræver speciel kodning til dataudtræk, transformationer, indlæsning, data rensning, datasammenlægninger og databerigelse.

Testautomatiseringsværktøjer kan være dyre og bruges normalt sammen med manuel test. De kan dog blive omkostningseffektive i det lange løb, især når de bruges gentagne gange i regressionstest.

Hyppige kandidater til testautomatisering

- BI rapport test

- Erhverv, overholdelse af myndigheder

- Dataaggregeringsbehandling

- Datarensning og arkivering

- Datakvalitetstest

- Dataafstemning (f.eks. kilde til mål)

- Datatransformationer

- Dimensionstabeldata indlæses

- End-to-end test

- ETL, ELT validerings- og verifikationstest

- Faktatabel data indlæses

- Bekræftelse af indlæsning af fil/data

- Inkrementel belastningstest

- Test af belastning og skalerbarhed

- Manglende filer, poster, felter

- Ydelsestest

- Henvisningsintegritet

- Regressionstest

- Sikkerhedsprøvning

- Kildedatatest og profilering

- Staging, ODS-datavalideringer

- Enheds-, integrations- og regressionstest

Automatisering af disse test kan være nødvendig på grund af kompleksiteten af behandlingen og antallet af kilder og mål, der bør verificeres.

For de fleste projekter er datapipeline-testprocesser designet til at verificere og implementere datakvalitet.

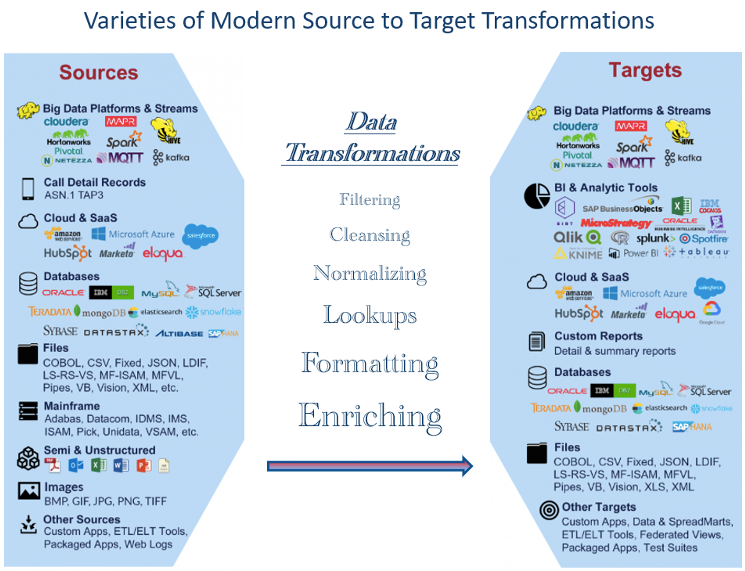

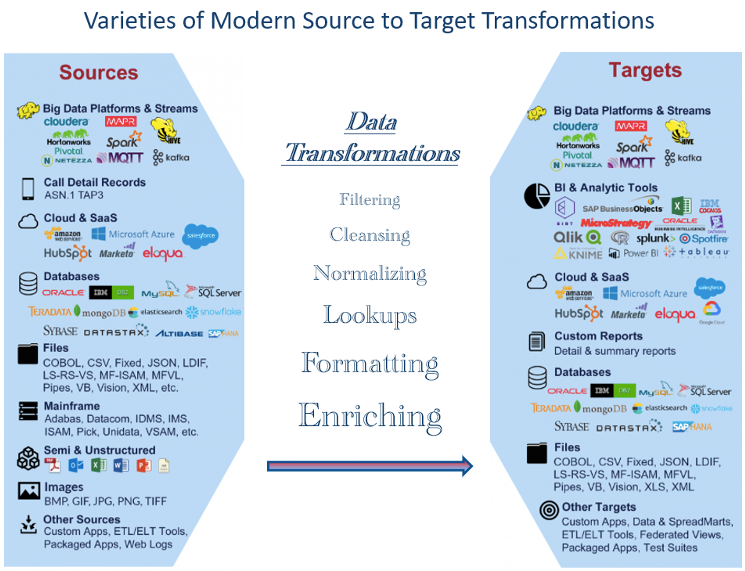

De mange forskellige datatyper, der er tilgængelige i dag, giver testudfordringer

Der er en bred vifte af datatyper tilgængelige i dag, lige fra traditionelle strukturerede datatyper såsom tekst, tal og datoer til ustrukturerede datatyper såsom lyd, billeder og video. Derudover er forskellige typer semi-strukturerede data, såsom XML og JSON, meget brugt i webudvikling og dataudveksling.

Med fremkomsten af Internet of Things (IoT) har der været en eksplosion i forskellige datatyper, herunder sensordata, lokationsdata og maskine-til-maskine kommunikationsdata. Efterhånden som disse datatyper udtrækkes og transformeres, kan test blive mere kompliceret uden passende værktøjer. Dette har ført til nye datastyringsteknologier og analytiske teknikker som strømbehandling, edge computing og realtidsanalyse.

Figur 1 viser eksempler på datatyper, der er meget udbredt i dag. Det store antal repræsenterer udfordringer, når man skal teste, om de nødvendige transformationer er korrekt udført. Som et resultat heraf skal dataprofessionelle være velbevandret i en bred vifte af datatyper og kunne tilpasses til at teste nye tendenser og teknologier.

Evaluer rørledningskomponenter til mulig automatiseret test

Et nøgleelement i agile og andre moderne udviklinger er automatiseret test. Vi kan anvende denne bevidsthed på datapipelinen.

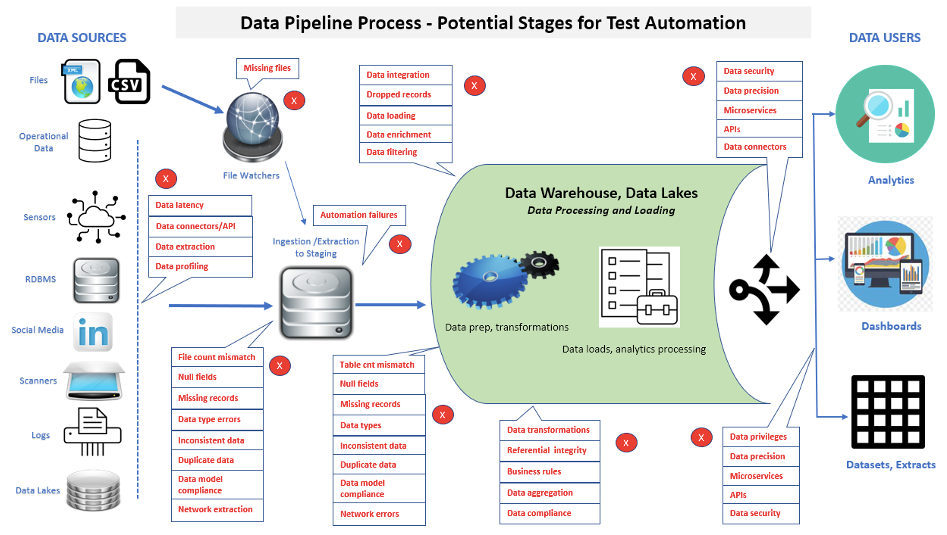

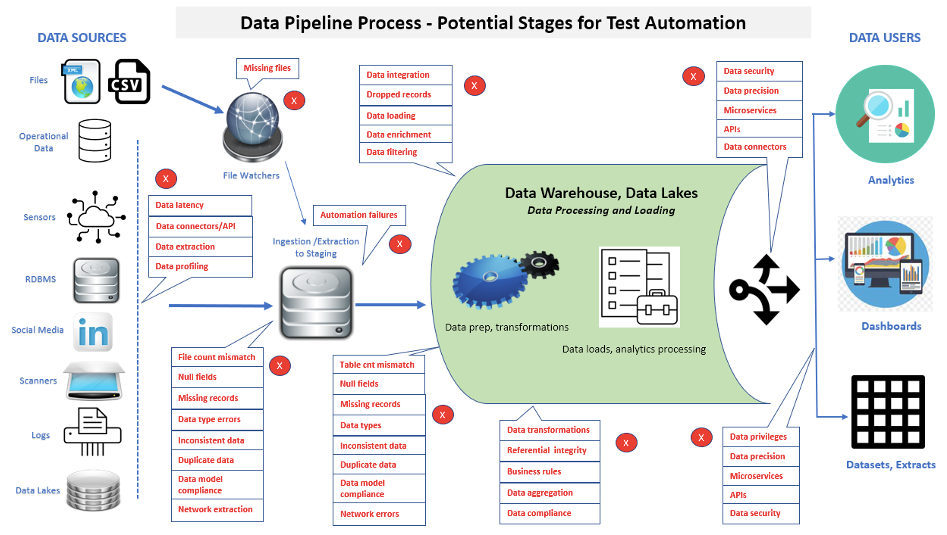

Et væsentligt aspekt af datapipeline-test er, at antallet af udførte test vil fortsætte med at stige for at kontrollere ekstra funktionalitet og vedligeholdelse. Figur 2 viser mange områder, hvor testautomatisering kan anvendes i en datapipeline.

Når du implementerer testautomatisering, kan data spores fra kildelag, gennem datapipelinebehandling, til belastninger i datapipelinen og til sidst til frontend-applikationer eller rapporter. Antag, at der findes korrupte data i en frontend-applikation eller -rapport. I så fald kan udførelsen af automatiserede suiter hjælpe hurtigere med at afgøre, om individuelle problemer er placeret i datakilder, en datapipelineproces, en nyligt indlæst datapipelinedatabase/datamart eller business intelligence/analytics-rapporter.

En vægt på hurtig identifikation af data og ydeevneproblemer i komplekse datapipeline-arkitekturer er et nøgleværktøj til at fremme udviklingseffektivitet, forkorte byggecyklusser og opfylde mål for udgivelseskriterier.

Bestem kategorier af test, der skal automatiseres

Tricket er at bestemme, hvad der skal automatiseres, og hvordan man håndterer hver opgave. Et sæt spørgsmål bør overvejes ved automatisering af tests, såsom:

- Hvad koster det at automatisere testene?

- Hvem er ansvarlig for testautomatisering (f.eks. Dev., QA, dataingeniører)?

- Hvilke testværktøjer skal bruges (f.eks. open source, leverandør)?

- Vil de valgte værktøjer leve op til alle forventninger?

- Hvordan vil testresultaterne blive rapporteret?

- Hvem fortolker testresultaterne?

- Hvordan vil testscripts blive vedligeholdt?

- Hvordan vil vi organisere scripts for nem og præcis adgang?

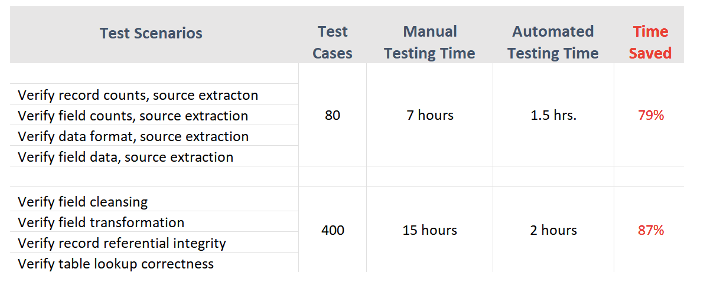

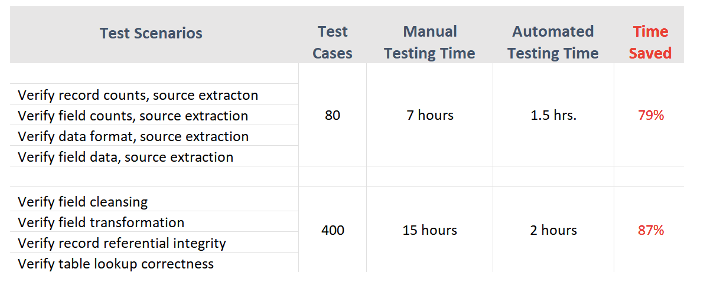

Figur 3 viser eksempler på tidsvarigheder (til testudførelse, defektidentifikationer og rapportering) for manuelle kontra automatiserede testcases fra en faktisk projektoplevelse.

Automatiseret datapipeline-test har til formål at dække de mest kritiske funktioner til indlæsning af en datapipeline - synkronisering og afstemning af kilde- og måldata.

Fordele og begrænsninger ved automatiseret test

Test automatiseringsudfordringer

- Rapport test: Test af business intelligence eller analytiske rapporter gennem automatisering

- Datakompleksitet: Datapipelinetest involverer ofte komplekse datastrukturer og transformationer, som kan være udfordrende at automatisere og kræver specialiseret ekspertise.

- Pipeline kompleksitet: Datapipelines kan være komplekse og kan involvere flere behandlingsstadier, hvilket kan være udfordrende at teste og fejlfinde. Derudover kan ændringer af en del af rørledningen have utilsigtede konsekvenser nedstrøms.

Test automatiseringsfordele

- Eksekverer testsager hurtigere: Automatisering kan fremskynde implementeringen af testscenarier.

- Opretter en genanvendelig testpakke: Når først testscripts er kørt med automatiseringsværktøjerne, kan de sikkerhedskopieres til nem genkaldelse og genbrug.

- Letter testrapportering: Et interessant træk ved mange automatiserede værktøjer er deres evne til at producere rapporter og testfiler. Disse egenskaber repræsenterer nøjagtigt datastatus, identificerer tydeligt mangler og bruges i overensstemmelsesrevisioner.

- Reducerer personale- og omarbejdningsomkostninger: Tid brugt på manuel test eller gentest efter udbedring af mangler kan bruges på andre tiltag i IT-afdelingen.

Potentielle begrænsninger

- Kan ikke helt erstatte manuel test: Selvom automatisering kan bruges til forskellige applikationer og testcases, det kan ikke helt erstatte manuel test. Indviklede testsager vil stadig eksistere, hvor automatisering ikke vil fange alt, og for brugeraccepttest skal slutbrugere ofte udføre test manuelt. Derfor er det afgørende at have den rigtige kombination af automatiseret og manuel test i processen.

- Pris for værktøjer: Kommercielle testværktøjer kan være dyre, afhængigt af deres størrelse og funktionalitet. På overfladen kan en virksomhed se dette som en unødvendig omkostning. Men genbrug alene kan hurtigt gøre det til et aktiv.

- Udgifter til træning: Testere bør trænes ikke kun i programmering, men også i at planlægge automatiserede tests. Automatiserede værktøjer kan være komplicerede at bruge og kan have brug for brugertræning.

- Automatisering kræver planlægning, forberedelse og dedikerede ressourcer: Succesen med automatiseret test er hovedsageligt afhængig af præcise testkrav og omhyggelig udvikling af testcases før testning begynder. Desværre er udvikling af testcase stadig primært en manuel proces. Fordi hver organisation og datapipeline-applikation kan være unik, vil mange automatiserede testværktøjer ikke skabe testcases.

Kom godt i gang med Data Pipeline Test Automation

Ikke alle datapipeline-tests er egnede til automatisering. Vurder ovenstående situationer for at afgøre, hvilke typer automatisering der vil gavne din testproces, og hvor meget der er behov for. Evaluer dine testkrav og identificer effektivitetsgevinster, der kan opnås gennem automatiseret test. Datapipeline-teams, der afsætter lang tid til regressionstest, vil drage størst fordel.

Udvikle en business case for automatiseret test. IT skal først gøre sagen gældende for at formidle værdien til virksomheden.

Vurder mulighederne. Efter at have vurderet den aktuelle tilstand og kravene i it-afdelingen, skal du bestemme, hvilke værktøjer der passer til organisationens testprocesser og miljøer. Valgmulighederne kan omfatte leverandører, open source, interne eller en blanding af værktøjer.

konklusioner

Da testautomatisering hurtigt er blevet et væsentligt alternativ til manuel test, leder flere og flere virksomheder efter værktøjer og strategier til succesfuld implementering af automatisering. Dette har ført til en betydelig vækst af testautomatiseringsværktøjer baseret på Appium, Selenium, Katalon Studio og mange andre. Datapipeline og dataingeniører, BI og kvalitetssikringsteams skal dog have de rigtige programmeringsevner for at bruge disse automatiseringsværktøjer fuldt ud.

Mange it-eksperter har forudsagt, at videnskløften mellem testere og udviklere skal og vil blive reduceret løbende. Automatiserede datapipeline-testværktøjer kan reducere tidsforbruget på at teste kode betydeligt sammenlignet med konventionelle manuelle metoder.

Efterhånden som mulighederne for udvikling af datapipeline fortsætter med at stige, øges også behovet for mere omfattende og moderne automatiseret datatest.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://www.dataversity.net/best-practices-in-data-pipeline-test-automation/

- :er

- $OP

- 1

- a

- evne

- over

- accept

- adgang

- Ophobe

- præcis

- præcist

- opnå

- opnået

- tilføjet

- Desuden

- Derudover

- vedtage

- advent

- Efter

- aggregering

- adræt

- målsætninger

- Alle

- tillade

- alene

- alternativ

- Skønt

- analyse

- Analytikere

- Analytisk

- Analytisk

- analytics

- analysere

- ,

- Anvendelse

- applikationer

- anvendt

- Indløs

- passende

- ER

- områder

- AS

- udseende

- Vurdering

- aktiv

- sikkerhed

- sikker

- At

- lyd

- revisioner

- automatisere

- Automatiseret

- Automatisering

- Automation

- til rådighed

- undgås

- bevidsthed

- Backed

- baseret

- grundlag

- BE

- fordi

- bliver

- før

- Begyndelse

- gavner det dig

- BEDSTE

- bedste praksis

- mellem

- Pause

- bred

- bugs

- bygge

- virksomhed

- business intelligence

- virksomheder

- CAN

- kandidater

- kan ikke

- kapaciteter

- fange

- forsigtig

- tilfælde

- tilfælde

- kategorier

- Årsag

- vis

- udfordringer

- udfordrende

- Ændringer

- skiftende

- karakteristisk

- karakteristika

- kontrollere

- valgt

- klar

- tydeligt

- kode

- Kodning

- Indsamling

- kombination

- kommunikere

- Kommunikation

- sammenlignet

- fuldføre

- fuldstændig

- komplekse

- kompleksitet

- Compliance

- kompliceret

- komponent

- komponenter

- omfattende

- computing

- Konsekvenser

- betydelig

- betragtes

- fortsæt

- kontinuerlig

- kontinuerligt

- kontrol

- konventionelle

- korrekt

- Koste

- omkostningseffektiv

- Omkostninger

- dæksel

- skabe

- troværdig

- kriterier

- kritisk

- afgørende

- Nuværende

- Nuværende tilstand

- cykler

- data

- data berigelse

- Dataudveksling

- datastyring

- datakvalitet

- datalager

- Database

- databaser

- DATAVERSITET

- Datoer

- afgørelser

- dedikeret

- levering

- Afdeling

- afhængig

- Afhængigt

- beskrevet

- konstrueret

- Bestem

- bestemmer

- bestemmelse

- dev

- udviklere

- udvikling

- Udvikling

- udvikling

- forskellige

- diligence

- displays

- dokumentation

- dokumenter

- gør

- e

- hver

- tidligere

- let

- Edge

- kant computing

- Effektiv

- effektivitet

- effektivitet

- effektiv

- element

- elementer

- smergel

- vægt

- ende til ende

- Ingeniører

- sikre

- miljøer

- især

- væsentlig

- evaluere

- Endog

- Hver

- at alt

- eksempler

- udveksling

- udførelse

- eksisterende

- forventninger

- forventet

- dyrt

- erfaring

- ekspertise

- eksperter

- udvinding

- hurtigere

- Feature

- Funktionalitet

- tilbagemeldinger

- Figur

- Filer

- Endelig

- finde

- Fornavn

- fejl

- flow

- Til

- formel

- format

- fundet

- rammer

- hyppig

- fra

- fuldt ud

- funktionalitet

- funktioner

- yderligere

- Gevinst

- gevinster

- kløft

- Regering

- Vækst

- håndtere

- Håndtering

- Hård Ost

- Have

- have

- hjælpe

- Høj

- høj kvalitet

- stærkt

- Hvordan

- How To

- Men

- HTTPS

- Identifikation

- identificere

- billeder

- gennemføre

- implementering

- gennemføre

- vigtigt

- in

- omfatter

- Herunder

- Forøg

- Stigninger

- individuel

- initial

- initiativer

- integration

- Intelligens

- interessant

- interne

- Internet

- tingenes internet

- involvere

- involverer

- tingenes internet

- spørgsmål

- IT

- iteration

- json

- Nøgle

- viden

- kendt

- sø

- vid udstrækning

- lag

- læring

- Led

- Livet

- levetid

- ligesom

- begrænsninger

- belastning

- lastning

- belastninger

- placeret

- placering

- Lang

- leder

- vedligeholdelse

- lave

- ledelse

- manuel

- manuelt

- mange

- max-bredde

- Mød

- møde

- metode

- metoder

- mindre

- Moderne

- Overvåg

- mere

- mest

- flere

- nødvendig

- Behov

- behov

- behov

- Ny

- næste

- nummer

- numre

- målsætninger

- of

- on

- ONE

- åbent

- open source

- Indstillinger

- organisation

- Oprindelse

- Andet

- Andre

- Ellers

- del

- mønstre

- udføre

- ydeevne

- perioder

- fase

- pipeline

- planlægning

- plato

- Platon Data Intelligence

- PlatoData

- mulig

- praksis

- brug

- forudsagde

- gaver

- primært

- problemer

- behandle

- Processer

- forarbejdning

- producere

- Produkt

- professionelle partnere

- Programmering

- Programmer

- projekt

- projekter

- Fremme

- passende

- give

- giver

- formål

- Spørgsmål og svar

- kvalitet

- Spørgsmål

- hurtigt

- rækkevidde

- spænder

- hurtige

- hurtigt

- SJÆLDEN

- virkelige verden

- realtid

- realistisk

- forsoning

- optegnelser

- reducere

- regression

- fast

- regelmæssigt

- frigive

- relevant

- stole

- gentaget

- GENTAGNE GANGE

- erstatte

- replikeres

- indberette

- rapporteret

- Rapportering

- Rapporter

- repræsentere

- repræsenterer

- kræver

- påkrævet

- Krav

- Kræver

- Ressourcer

- ansvarlige

- resultere

- Resultater

- genanvendelige

- afsløre

- Kør

- Skalerbarhed

- scenarier

- planlægning

- scripts

- valg

- tjeneste

- sæt

- setup

- flere

- bør

- Shows

- signifikant

- betydeligt

- situationer

- Størrelse

- færdigheder

- So

- Software

- softwareudvikling

- Kilde

- Kilder

- særligt

- specialiserede

- specifikke

- hastighed

- brugt

- bemanding

- etaper

- interessenter

- starte

- påbegyndt

- Tilstand

- Status

- Stadig

- opbevaring

- opbevaret

- strategier

- strøm

- struktureret

- Studio

- succes

- Succesfuld

- sådan

- egnede

- suite

- overflade

- synkronisering

- bord

- tager

- mål

- mål

- Opgaver

- hold

- hold

- Teknisk

- teknikker

- Teknologier

- prøve

- Test

- tests

- at

- deres

- derfor

- Disse

- ting

- Gennem

- tid

- tidskrævende

- til

- i dag

- også

- værktøj

- værktøjer

- traditionelle

- uddannet

- Kurser

- Transform

- Transformation

- transformationer

- omdannet

- omdanne

- Tendenser

- typer

- enestående

- brug

- Bruger

- brugere

- sædvanligvis

- valideret

- validering

- Værdifuld

- værdi

- række

- forskellige

- Vast

- sælger

- leverandører

- Verifikation

- verificeres

- verificere

- video

- Specifikation

- afgørende

- vs

- Warehouse

- web

- Web udvikling

- Hvad

- hvorvidt

- som

- WHO

- bred

- bredt

- vilje

- med

- inden for

- uden

- arbejdsgange

- arbejder

- ville

- XML

- Din

- zephyrnet