Bruce Warrington via Unsplash

Grunden til, at maskinlæringsmodeller generelt bliver smartere, skyldes deres afhængighed af at bruge mærkede data til at hjælpe dem med at skelne mellem to lignende objekter.

Uden disse mærkede datasæt vil du dog støde på store forhindringer, når du opretter den mest effektive og troværdige maskinlæringsmodel. Mærkede datasæt under træningsfasen af en model er vigtige.

Deep learning er blevet brugt i vid udstrækning til at løse opgaver som computersyn ved hjælp af superviseret læring. Men som med mange ting i livet, kommer det med begrænsninger. Overvåget klassificering kræver en høj mængde og kvalitet af mærkede træningsdata for at kunne producere en robust model. Det betyder, at klassificeringsmodellen ikke kan håndtere usete klasser.

Og vi ved alle, hvor meget regnekraft, genoptræning, tid og penge det kræver at træne en dyb læringsmodel.

Men kan en model stadig være i stand til at skelne mellem to objekter uden at have brugt træningsdata? Ja, det kaldes nulskudslæring. Zero-shot learning er en models evne til at kunne udføre en opgave uden at have modtaget eller brugt træningseksempler.

Mennesker er naturligvis i stand til nul-skudslæring uden at skulle lægge mange kræfter i. Vores hjerner gemmer allerede ordbøger og giver os mulighed for at differentiere objekter ved at se på deres fysiske egenskaber på grund af vores nuværende vidensbase. Vi kan bruge denne videnbase til at se ligheder og forskelle mellem objekter og finde sammenhængen mellem dem.

Lad os f.eks. sige, at vi forsøger at bygge en klassifikationsmodel på dyrearter. Ifølge OurWorldInData, var der beregnet 2.13 millioner arter i 2021. Hvis vi vil skabe den mest effektive klassificeringsmodel for dyrearter, ville vi derfor have brug for 2.13 millioner forskellige klasser. Der vil også være behov for en masse data. Data i høj kvantitet og kvalitet er svære at finde.

Så hvordan løser nul-skudslæring dette problem?

Fordi nul-skudslæring ikke kræver, at modellen har lært træningsdataene og hvordan man klassificerer klasser, giver det os mulighed for at stole mindre på modellens behov for mærkede data.

Det følgende er, hvad dine data skal bestå af for at fortsætte med nul-skudslæring.

Set Klasser

Denne består af de dataklasser, som tidligere er blevet brugt til at træne en model.

Usynlige klasser

Dette består af de dataklasser, der IKKE er blevet brugt til at træne en model, og den nye nul-skuds læringsmodel vil generalisere.

Hjælpeoplysninger

Da dataene i de usete klasser ikke er mærket, vil nul-skudslæring kræve hjælpeoplysninger for at lære og finde korrelationer, links og egenskaber. Dette kan være i form af ordindlejringer, beskrivelser og semantisk information.

Zero-shot læringsmetoder

Zero-shot learning bruges typisk i:

- Klassifikatorbaserede metoder

- Instansbaserede metoder

Praktikophold

Zero-shot learning bruges til at bygge modeller for klasser, der ikke træner ved hjælp af mærkede data, derfor kræver det disse to faser:

1. Træning

Træningsfasen er processen med læringsmetoden, der forsøger at fange så meget viden som muligt om dataens kvaliteter. Vi kan se dette som læringsfasen.

2. Inferens

Under inferensfasen bliver al den lærte viden fra træningsfasen anvendt og brugt til at klassificere eksempler i et nyt sæt klasser. Vi kan se dette som forudsigelsesfasen.

Hvordan fungerer det?

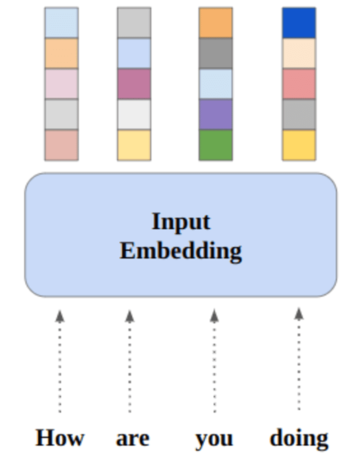

Viden fra de sete klasser vil blive overført til de usete klasser i et højdimensionelt vektorrum; dette kaldes semantisk rum. For eksempel, i billedklassificering vil det semantiske rum sammen med billedet gennemgå to trin:

1. Fælles indstøbningsrum

Det er her, de semantiske vektorer og vektorerne for det visuelle træk projiceres til.

2. Højeste lighed

Det er her funktioner matches med dem fra en uset klasse.

For at hjælpe med at forstå processen med de to faser (træning og inferens), lad os anvende dem i brugen af billedklassificering.

Kurser

Jari Hytönen via Unsplash

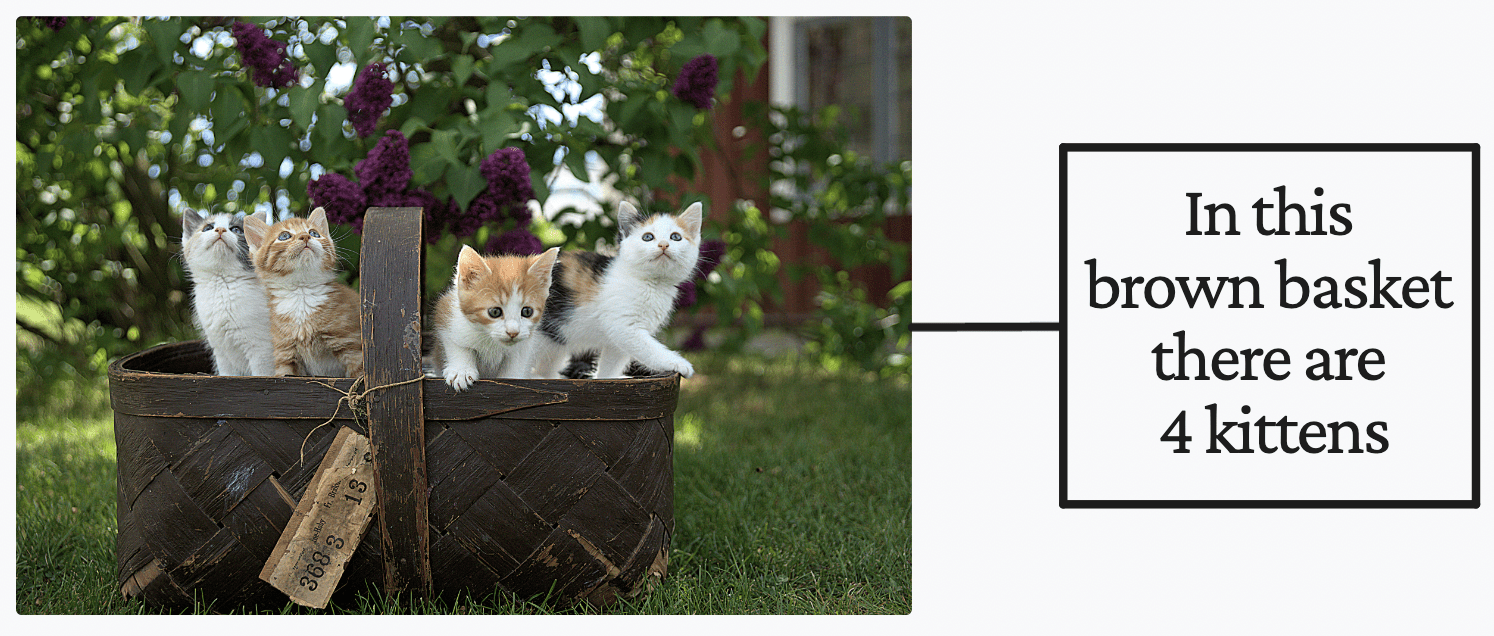

Hvis du som menneske skulle læse teksten til højre på billedet ovenfor, ville du med det samme antage, at der er 4 killinger i en brun kurv. Men lad os sige, at du ikke aner, hvad en 'killing' er. Du vil antage, at der er en brun kurv med 4 ting indeni, som kaldes 'killinger'. Når du støder på flere billeder, der indeholder noget, der ligner en 'killing', vil du være i stand til at skelne en 'killing' fra andre dyr.

Dette er, hvad der sker, når du bruger Kontrastiv sprog-billede fortræning (CLIP) af OpenAI til nul-shot læring i billedklassificering. Det er kendt som hjælpeoplysninger.

Du tænker måske, 'godt det er bare mærket data'. Jeg forstår, hvorfor du ville tro det, men det er de ikke. Hjælpeoplysninger er ikke etiketter af data, de er en form for supervision for at hjælpe modellen med at lære under træningsfasen.

Når en nul-skuds-læringsmodel ser en tilstrækkelig mængde billed-tekst-parringer, vil den være i stand til at differentiere og forstå sætninger, og hvordan de korrelerer med bestemte mønstre i billederne. Ved hjælp af CLIP-teknikken 'kontrastiv læring' har nulskudslæringsmodellen været i stand til at akkumulere et godt vidensgrundlag for at kunne lave forudsigelser om klassifikationsopgaver.

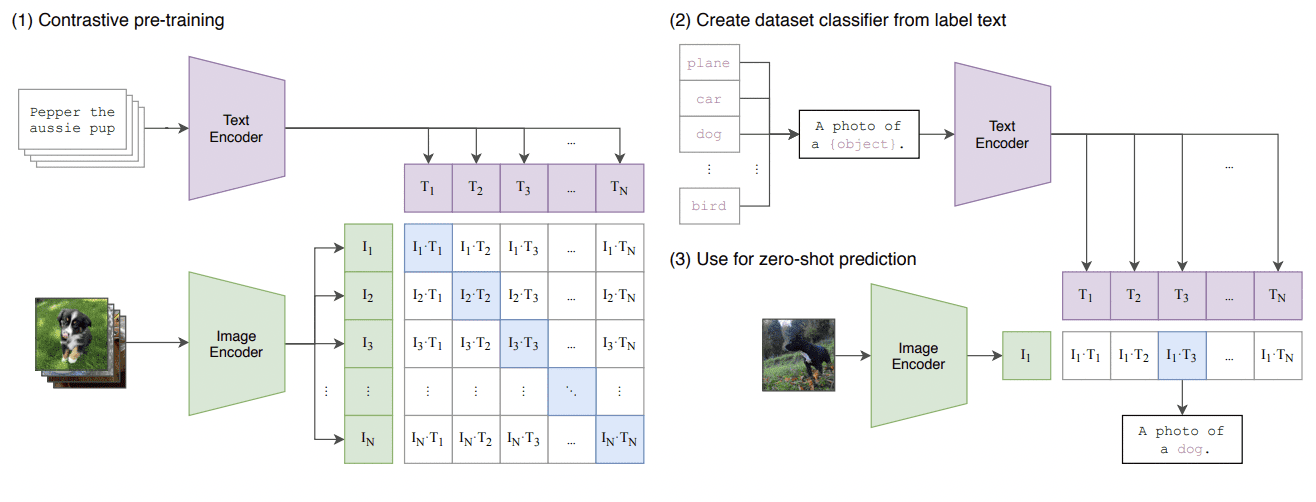

Dette er et resumé af CLIP-tilgangen, hvor de træner en billedkoder og en tekstkoder sammen for at forudsige de korrekte parringer af en batch af (billede, tekst) træningseksempler. Se venligst billedet nedenfor:

Lære overførbare visuelle modeller fra naturligt sprogovervågning

Inferens

Når modellen har gennemgået træningsstadiet, har den en god videnbase om billed-tekst-parring og kan nu bruges til at lave forudsigelser. Men før vi kan komme direkte i gang med at lave forudsigelser, skal vi konfigurere klassificeringsopgaven ved at oprette en liste over alle mulige etiketter, som modellen kunne udskrive.

Hvis vi for eksempel holder os til billedklassificeringsopgaven på dyrearter, skal vi bruge en liste over alle dyrearter. Hver af disse etiketter vil blive kodet, T? til T? ved at bruge den fortrænede tekstkoder, der fandt sted i træningsfasen.

Når etiketterne er blevet kodet, kan vi indtaste billeder gennem den forudtrænede billedkoder. Vi vil bruge den afstandsmetriske cosinus-lighed til at beregne lighederne mellem billedkodningen og hver tekstetiketkodning.

Klassificeringen af billedet sker ud fra etiketten med størst lighed med billedet. Og det er sådan nul-shot-læring opnås, specifikt i billedklassificering.

knaphed på data

Som nævnt før, er høje kvantitets- og kvalitetsdata svære at få fingrene i. I modsætning til mennesker, der allerede besidder nul-skud indlæringsevnen, kræver maskiner input mærkede data for at lære og derefter være i stand til at tilpasse sig varianser, der kan forekomme naturligt.

Hvis vi ser på dyrearteksemplet, var der så mange. Og da antallet af kategorier fortsætter med at vokse i forskellige domæner, vil det kræve meget arbejde at følge med indsamlingen af kommenterede data.

På grund af dette er nul-skudslæring blevet mere værdifuld for os. Flere og flere forskere er interesserede i automatisk attributgenkendelse for at kompensere for manglen på tilgængelige data.

Datamærkning

En anden fordel ved zero-shot learning er dens datamærkningsegenskaber. Datamærkning kan være arbejdskrævende og meget trættende, og på grund af dette kan det føre til fejl under processen. Datamærkning kræver eksperter, såsom læger, der arbejder på et biomedicinsk datasæt, hvilket er meget dyrt og tidskrævende.

Zero-shot learning bliver mere populær på grund af ovennævnte databegrænsninger. Der er et par artikler, jeg vil anbefale dig at læse, hvis du er interesseret i dens evner:

Nisha Arya er dataforsker og freelance teknisk skribent. Hun er særligt interesseret i at give Data Science karriererådgivning eller tutorials og teoribaseret viden omkring Data Science. Hun ønsker også at udforske de forskellige måder, kunstig intelligens er/kan gavne menneskets levetid. En ivrig lærende, der søger at udvide sin tekniske viden og skrivefærdigheder, samtidig med at hun hjælper med at vejlede andre.

- SEO Powered Content & PR Distribution. Bliv forstærket i dag.

- Platoblokkæde. Web3 Metaverse Intelligence. Viden forstærket. Adgang her.

- Kilde: https://www.kdnuggets.com/2022/12/zeroshot-learning-explained.html?utm_source=rss&utm_medium=rss&utm_campaign=zero-shot-learning-explained

- 2021

- a

- evner

- evne

- I stand

- Om

- over

- Ifølge

- Ophobe

- opnået

- tværs

- tilpasse

- rådgivning

- mod

- Alle

- tillader

- allerede

- beløb

- ,

- dyr

- dyr

- anvendt

- Indløs

- tilgang

- omkring

- kunstig

- kunstig intelligens

- Automatisk Ur

- til rådighed

- bund

- baseret

- kurven

- bliver

- blive

- før

- være

- jf. nedenstående

- gavner det dig

- mellem

- biomedicinsk

- udvide

- bygge

- beregnet

- kaldet

- Kan få

- kan ikke

- stand

- fange

- Karriere

- kategorier

- vis

- klasse

- klasser

- klassificering

- Klassificere

- Indsamling

- Kom

- fuldføre

- computerkraft

- Compute

- computer

- Computer Vision

- fortsætter

- kunne

- skabe

- Oprettelse af

- Nuværende

- data

- datalogi

- dataforsker

- datasæt

- dyb

- dyb læring

- Afhængighed

- forskelle

- forskellige

- differentiere

- afstand

- Domæner

- i løbet af

- hver

- Effektiv

- indsats

- fejl

- eksempel

- eksempler

- dyrt

- eksperter

- forklarede

- udforske

- Feature

- Funktionalitet

- få

- Finde

- efter

- formular

- freelance

- fra

- Generelt

- få

- godt

- størst

- Grow

- vejlede

- håndtere

- hænder

- sker

- Hård Ost

- have

- hjælpe

- hjælpe

- Høj

- højeste

- stærkt

- Hvordan

- How To

- Men

- HTTPS

- menneskelig

- Mennesker

- idé

- billede

- Billedklassificering

- billeder

- vigtigt

- in

- oplysninger

- indgang

- Intelligens

- interesseret

- IT

- Keen

- Holde

- Kend

- viden

- kendt

- etiket

- mærkning

- Etiketter

- Mangel

- Sprog

- føre

- LÆR

- lærte

- læring

- Livet

- begrænsninger

- LINK

- links

- Liste

- levetid

- Se

- leder

- UDSEENDE

- Lot

- maskine

- machine learning

- Maskiner

- større

- lave

- Making

- mange

- midler

- medicinsk

- nævnte

- metode

- metoder

- metrisk

- måske

- million

- model

- modeller

- penge

- mere

- mest

- Natural

- Behov

- Ny

- nummer

- objekter

- forhindringer

- forekom

- ONE

- OpenAI

- ordrer

- Andet

- Andre

- parring

- parringer

- papirer

- især

- mønstre

- fase

- sætninger

- fysisk

- plato

- Platon Data Intelligence

- PlatoData

- Vær venlig

- Populær

- mulig

- magt

- forudsige

- Forudsigelser

- tidligere

- Problem

- behandle

- producere

- professionelle partnere

- fremskrevet

- egenskaber

- leverer

- sætte

- kvaliteter

- kvalitet

- mængde

- Læs

- grund

- modtaget

- anerkendelse

- anbefaler

- kræver

- Kræver

- forskere

- restriktioner

- robust

- Videnskab

- Videnskabsmand

- søger

- Sees

- sæt

- lignende

- ligheder

- færdigheder

- smartere

- So

- SOLVE

- noget

- Space

- specifikt

- Stage

- etaper

- Steps

- stikning

- Stadig

- butik

- sådan

- tilstrækkeligt

- RESUMÉ

- tilsyn

- Tag

- tager

- Opgaver

- opgaver

- tech

- Teknisk

- deres

- derfor

- ting

- Tænker

- Gennem

- tid

- tidskrævende

- til

- sammen

- Tog

- Kurser

- overført

- troværdig

- tutorials

- typisk

- forstå

- us

- brug

- udnyttet

- Værdifuld

- via

- Specifikation

- vision

- måder

- Hvad

- som

- Mens

- WHO

- bredt

- vilje

- uden

- ord

- Arbejde

- arbejder

- ville

- forfatter

- skrivning

- Din

- zephyrnet

- Zero-Shot Learning