Dieser Artikel wurde als Teil des veröffentlicht Data-Science-Blogathon

Über uns

Databricks ist, vereinfacht gesagt, eine webbasierte Plattform für Data Warehousing und maschinelles Lernen, die von den Machern von Spark entwickelt wurde. Aber Databricks ist noch viel mehr. Es ist ein One-Stop-Produkt für alle Datenanforderungen, von der Datenspeicherung, Analysedaten und der Gewinnung von Erkenntnissen mit SparkSQL, dem Erstellen von Vorhersagemodellen mit SparkML, und bietet auch aktive Verbindungen zu Visualisierungstools wie PowerBI, Tableau, Qlikview usw. Es kann angezeigt werden wie Facebook von Big Data.

Unternehmen generieren eine große Datenmenge, zum Beispiel hat Amazon verschiedene Quellen zur operativen Datengenerierung wie Amazon App-Klicks, Amazon Pay, Transaktionsdaten wie Kauf, Nachbestellung, Stornierung, Prime Viewership-Daten, es hat auch eine Amazon-Echo-Stimme Informationen, Bewertungen und Bewertungsinformationen, verschiedene Verkäuferinformationen über Kategorien hinweg, um nur einige zu nennen. Das Data-Engineering-Team kümmert sich um verschiedene ETL, um sicherzustellen, dass die Daten bezogen, bereinigt und qualitätsgeprüft und in Data Warehouses gespeichert werden. In typischen Systemen ohne Spark kann eine einzelne Aufgabe wie das Speichern von POS-Daten in einer SQL-Tabelle zwischen 60 Minuten und 600 Minuten dauern. Aber mit Databricks wird all dies mit Spark leicht gemacht. ETLs sparen schneller wertvolle Zeit und verschaffen den Beteiligten einen Wettbewerbsvorteil.

Beispiel: Stellen Sie sich eine Batch-Pipeline für die Kreditgenehmigung vor, die jede Nacht um 9:100 Uhr mit 24 Millionen Anträgen ausgelöst wird. Herkömmliche Modelle benötigen Tage, um die Eingabedaten auszuwerten und eine Ausgabe bereitzustellen, was zu Betriebsverzögerungen und unzufriedenen Kunden führt, z. B. bei Point-Banking-Systemen. Was, wenn der Prozess unterwegs abgeschlossen ist und der Kredit in Sekundenschnelle genehmigt wird wie in Fintech-Apps, das bringt Databricks mit einer Reihe von Produkten und Lösungen auf den Tisch. Schnellere ETLs und einfachere Entscheidungsfindung. Unternehmen brauchen 48-XNUMX Stunden, um wöchentliche Betriebsdaten in Lager zu laden, und dies führt zu Verzögerungen im bevorstehenden Arbeitsablauf und könnte auch zu verpassten Gelegenheiten führen.

Databricks ist in Amazon Web Services, Microsoft Azure und Google Cloud Platform integriert, was die Integration in diese wichtigen Cloud-Computing-Infrastrukturen erleichtert. Einige der großen Firmen wie Starbucks,

Dieser Artikel konzentriert sich auf Databricks für Data Science-Enthusiasten. Weitere Informationen finden Sie in den Databricks Youtube-Seite für das Selbe.

Inhaltsverzeichnis

- Vorlesen.

-

Über die Databricks-Community-Edition.

-

DataLake/Seehaus.

-

Rollenbasierte Einführung von Databricks.

-

Vorteile von Databricks.

-

Apache Funken

- Schritt für Schritt Anleitung -

-

Nützliche Ressourcen.

-

Zertifizierung von Data Bricks.

-

Endnoten.

Frühere Lesungen zu Analytics Vidhya

Analytics Vidhya bietet hochwertige Inhalte rund um pyspark, die Goto-Sprache auf Databricks, SQL und das Apache Spark-Framework. Es wäre sehr hilfreich, sie auch zu überfliegen. Nachfolgend finden Sie einige relevante Artikel.

- PySpark für Anfänger – Machen Sie Ihre ersten Schritte in Big Data Analytics (mit Code)

- Eine Einführung in die Datenanalyse mit Spark SQL

- Einführung in Spark MLlib für Big Data und maschinelles Lernen

- So verwenden Sie ein Modell für maschinelles Lernen, um Vorhersagen zu Streaming-Daten mit PySpark zu treffen

- Wie verbinde ich DataBricks und MongoDB Atlas mithilfe der Python-API?

- Databricks und RStudio starten Plattform, um R für Big-Data-Projekte einfacher denn je zu machen!

Über die Databricks-Community-Edition

- Die Community-Version von Databricks wird auf AWS gehostet und ist kostenlos.

- Ipython-Notebooks können auf die Plattform importiert und wie gewohnt verwendet werden.

- 15-GB-Cluster, ein Cluster-Manager und die Notebook-Umgebung werden bereitgestellt und die Nutzung ist zeitlich unbegrenzt.

- Unterstützt SQL, Scala, Python, Pyspark.

- Bietet eine interaktive Notebook-Umgebung.

Die kostenpflichtige Version von Databricks hat eine 14-tägige Testphase, muss jedoch zusammen mit AWS oder Azure oder GCP verwendet werden.

Bild 2

Datensee

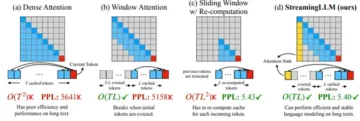

Seehaus oder Daten See – ist ein in Databricks verwendeter Marketingbegriff für Speicherschichten, die strukturierte oder unstrukturierte, Streaming- oder Batch-Informationen aufnehmen können. Es ist eine einfache Plattform, um alle Daten zu speichern. Data Lake von Databricks wird Delta Lake genannt. Unten sind einige Merkmale des Deltasees.

- Es basiert auf dem Parque-Dateiformat.

- Kompatibel mit Apache Spark.

- Versionierung von Daten.

- ACID-Transaktionen – (Atomizität, Konsistenz, Isolation, Dauerhaftigkeit) gewährleisten Datendauerhaftigkeit und -konsistenz.

- Batch- und Streaming-Datensenke

- Unterstützt das Löschen und Upserting in Tabellen mit APIs

- Kann Millionen von Dateien mit Spark abfragen

| Datensee Gitter |

Datensee |

Daten Seehaus |

Data Warehouse |

|

Arten von Daten |

Alle Typen: Strukturierte Daten, semistrukturierte Daten, unstrukturierte (Roh-)Daten | Alle Typen: Strukturierte Daten, semistrukturierte Daten, unstrukturierte (Roh-)Daten | Nur strukturierte Daten |

| Kosten | $ | $ | $ $ $ |

| Format | Offenes Format | Offenes Format | Das geschlossene, proprietäre Format |

| Skalierbarkeit | Skalierbar, um beliebige Datenmengen zu niedrigen Kosten zu speichern, unabhängig vom Typ | Skalierbar, um beliebige Datenmengen zu niedrigen Kosten zu speichern, unabhängig vom Typ | Das Hochskalieren wird aufgrund der Anbieterkosten exponentiell teurer |

|

Beabsichtigte Benutzer |

Eingeschränkt: Datenwissenschaftler | Vereinheitlicht: Datenanalysten, Data Scientists, Machine-Learning-Ingenieure | Eingeschränkt: Datenanalysten |

|

Benutzerfreundlichkeit |

Schwierig: Das Durchsuchen großer Mengen von Rohdaten kann ohne Tools zum Organisieren und Katalogisieren der Daten schwierig sein | Einfach: Bietet Einfachheit und Struktur eines Data Warehouse mit den breiteren Anwendungsfällen eines Data Lake | Einfach: Die Struktur eines Data Warehouse ermöglicht es Benutzern, schnell und einfach auf Daten für Reporting und Analysen zuzugreifen |

Bild 3

Rollenbasierte Einführung von Databricks

Datenanalyst/Business-Analyst: Da Analysen, RACs, Visualisierungen das Brot und Butter von Analysten sind, muss der Fokus auf BI-Integration und Databricks SQL liegen. Lesen Sie mehr über das Tableau-Visualisierungstool hier.

Daten Scientist: Data Scientists haben in größeren Organisationen klar definierte Rollen, aber in kleineren Organisationen trägt Data Scientist verschiedene Hüte, man kann alle 3 Rollen eines Analysten, Data Engineers, Bi-Visualisierers usw. besitzen. In einer klar definierten Rolle Data Scientists sind für die Beschaffung von Daten verantwortlich, eine Fähigkeit, die angesichts moderner ML-Algorithmen grob vernachlässigt wird. Erstellen Sie Vorhersagemodelle, verwalten Sie die Modellbereitstellung. Datendrift überwachen,

Wichtige Fähigkeiten

- Datenbeschaffung – Identifizieren Sie Datenquellen und nutzen Sie sie, um ganzheitliche Modelle zu erstellen.

- Erstellen Sie Vorhersagemodelle.

- Modelllebenszyklus.

- Modellbereitstellung.

Dateningenieur: Weitgehend verantwortlich für die Erstellung von ETLs und die Verwaltung des ständigen Flusses ständig wachsender Daten. Verarbeiten, bereinigen und qualitätsüberprüfen Sie die Daten, bevor Sie sie in operative Tabellen übertragen. Die Modellbereitstellung und der Plattformsupport sind weitere Aufgaben, die den Dateningenieuren anvertraut werden.

Databricks müssen entweder mit Azure/AWS/GCP kombiniert werden und aufgrund der relativ höheren Kosten ist die Akzeptanz in kleinen/mittleren Startups in Indien relativ gering.

Vorteile von Databricks

- Unterstützung der Frameworks (scikit-learn, TensorFlow,Keras), Bibliotheken (matplotlib, pandas, numpy), Skriptsprachen (zB R, Python, Scala oder SQL), Tools und IDEs (JupyterLab, RStudio).

-

Databricks bietet eine Unified Data Analytics Platform, Dateningenieure, Datenwissenschaftler, Datenanalysten und Geschäftsanalysten können alle gemeinsam auf demselben Notebook arbeiten.

-

Flexibilität über verschiedene Ökosysteme hinweg – AWS, GCP, Azure.

-

Datenzuverlässigkeit und Skalierbarkeit durch Delta Lake.

-

Grundlegende integrierte Visualisierungen.

-

AutoML- und Modelllebenszyklus-Management durch MLFLUSS.

-

Hyperparameter-Tuning-Unterstützung durch HYPEROPTIERT.

-

Github- und Bitbucket-Integration

- 10x schnellere ETLs.

Apache Funken

Spark ist ein Tool zum Koordinieren von Aufgaben/Jobs über einen Computercluster hinweg. Diese Maschinencluster werden von einem Cluster-Manager verwaltet, es könnte entweder YARN (noch ein weiterer Ressourcenverhandler) oder Mesos oder Sparks sein Standalone Clustermanager bzw. Es unterstützt Sprachen wie Scala, Python, SQL, Java und R. Die Spark-Anwendung besteht aus einem Treiber und Executoren.

Das Fahrer Knoten ist für drei Dinge verantwortlich:

- Pflegen von Informationen über die Spark-Anwendung;

- Auf ein Benutzerprogramm reagieren.

- Analysieren, Verteilen und Planen der Arbeit zwischen den Ausführenden.

Das Testamentsvollstrecker sind für zwei Dinge zuständig:

- Ausführungscode, der ihm vom Treiber zugewiesen wurde.

- Berichten des Zustands der Berechnung auf diesem Executor an den Treiberknoten.

Das Clustermanager ist verantwortlich:

- Steuern von physischen Maschinen und weist Spark-Anwendungen Ressourcen zu.

In diesem Artikel erfahren Sie mehr über Spark – Verstehen Sie die interne Funktionsweise von Apache Spark.

Bild 4

Schritt-für-Schritt-Anleitung zu Databricks

Die Community Edition von Databricks kann kostenlos verwendet werden und hat 2 Hauptrollen: 1. Data Science and Engineering und 2. Machine Learning. Der Machine Learning-Pfad verfügt über eine zusätzliche Modell- und Experiment-Registrierung, in der Experimente nachverfolgt werden können MLFLUSS. Databricks bietet Jupyter-Notebooks zum Arbeiten, die von Teams gemeinsam genutzt werden können, was die Zusammenarbeit erleichtert.

Erstellen Sie einen Cluster:

Damit die Notebooks funktionieren, müssen sie in einem Cluster bereitgestellt werden. Databricks stellt 1 Treiber (15.3 GB Speicher, 2 Kerne, 1 DBU) kostenlos zur Verfügung.

- Auswählen Erstellen, dann klicken Sie auf Gruppe.

- Geben Sie einen Clusternamen an.

- Wählen Sie Databricks Runtime Version – 9.1 (Scala 2.12, Spark 3.1.2) oder andere Laufzeiten, GPU sind für die kostenlose Version nicht verfügbar.

- Wählen Sie die Verfügbarkeitszone als AUTO aus, um die nächste verfügbare Zone zu konfigurieren.

- Es kann einige Minuten dauern, bis der Cluster betriebsbereit ist.

-

Der Cluster wird nach einer Leerlaufzeit von zwei Stunden automatisch beendet.

- Um den Cluster zu schließen, gibt es 2 Möglichkeiten: Beenden und später neu starten. Löschen Sie zweitens den Cluster vollständig. Durch das Löschen des Clusters wird das Notebook nicht gelöscht, da Notebooks auf jedem verfügbaren Cluster gemountet werden können, der für den jeweiligen Job relevant ist.

Alternativ

- Wählen Sie Berechnen

- Wählen Sie bei Cluster erstellen aus und befolgen Sie dann Schritt 2 weiter oben.

Erstellen Sie ein Notizbuch:

- Wählen Sie die Option zum Erstellen und klicken Sie dann auf Notizbuch.

- Geben Sie dem Notizbuch einen relevanten Namen.

- Wählen Sie die bevorzugte Sprache aus – SQL, Scale, Python, R.

- Wählen Sie einen Cluster aus, auf dem das Notebook ausgeführt werden soll.

Arbeitsmappe veröffentlichen:

Sobald die Analyse abgeschlossen ist, können Databricks-Notebooks veröffentlicht werden (öffentlich verfügbar) und die Links sind für 6 Monate verfügbar.

Veröffentlichtes Notizbuch importieren:

Veröffentlichte Databricks-Notebooks können sowohl über URL als auch über physische Dateien importiert werden. Zum Importieren mit URL.

- Wählen Sie Arbeitsbereich und wechseln Sie zu dem Ordner, in dem die Datei gespeichert werden soll.

- Klicken Sie auf Importieren und dann erscheint ein neues Dialogfeld.

- Fügen Sie die URL ein und klicken Sie auf Importieren.

- Verwenden Sie das Link und importieren Sie ein SparkSQL-Tutorial in den Arbeitsbereich.

Ausführen von SQL auf Databricks

Erstellen Sie ein neues Notizbuch und wählen Sie als Sprache SQL aus. Wählen Sie im Notebook die Option Daten hochladen aus und laden Sie die CSV-Datei hoch.

Schreiben Sie die Daten in events002

%python df1 = spark.read.format("csv").load("dbfs:/FileStore/shared_uploads/[E-Mail geschützt] /test-3.csv",header="true", inferSchema="true") df1.write.format("delta").mode("overwrite").save("/mnt/delta/events002")

Erstellen Sie eine SQL-Tabelle mit dem folgenden Code:

DROP TABLE, WENN VORHANDEN Diamanten; TABELLENrauten ERSTELLEN MIT DELTA LOCATION '/mnt/delta/events002/'

Führen Sie SQL-Befehle aus, um Daten abzufragen:

* aus Diamanten auswählen Limit 10 Hersteller auswählen, (*) als Freq zählen aus Diamanten gruppieren um 1 bestellen nach 2 desc

Visualisieren Sie die SQL-Ausgabe auf dem Databricks-Notebook

Die ausgegebenen Datenrahmen können direkt im Notebook visualisiert werden. Wählen Sie das Balkensymbol unten aus und wählen Sie das entsprechende Diagramm aus. Es stehen insgesamt 11 Diagrammtypen zur Verfügung.

- Balkendiagramm

- Streudiagramm

- Landkarten

- Liniendiagramm

- Flächendiagramm

- Kuchendiagramm

- Quantildiagramm

- Histogramm

- Box-Plot

- QQ-Plot

- Pivot (Excel-ähnliche Pivot-Chart-Schnittstelle. )

End-to-End-Klassifizierung für maschinelles Lernen auf Databricks

Die Unterstützung für maschinelles Lernen von Databricks wächst von Tag zu Tag, MLlib ist die Machine Learning (ML)-Bibliothek von Spark, die für Machine Learning-Aktivitäten auf Spark entwickelt wurde. Nachfolgend finden Sie ein Klassifizierungsbeispiel zur Vorhersage der Qualität des portugiesischen „Vinho Verde“-Weins basierend auf den physikalisch-chemischen Eigenschaften des Weins.

Laden Sie die Daten mit dem . herunter Link, laden Sie winequality-red.csv und winequality-white.csv auf Ihren lokalen Computer herunter. Und laden Sie die CSV-Datei mit dem Daten hochladen Befehl in der Symbolleiste.

Pandas importieren als pd red_wine = pd.read_csv("/dbfs/FileStore/shared_uploads/[E-Mail geschützt] /winequality_red.csv") white_wine = pd.read_csv("/dbfs/FileStore/shared_uploads/[E-Mail geschützt] /winequality_white.csv")

white_wine['is_red'] = 0.0 red_wine['is_red'] = 1.0 data_df = pd.concat([white_wine, red_wine], axis=0)

Plotten :

Zeichnen Sie ein Histogramm des Y-Labels:

importieren Seaborn als sns

sns.distplot(data.quality, kde=False)

Boxplots zum Vergleichen von Features und Y-Label:

import matplotlib.pyplot als plt dims = (3, 4) f, axis = plt.subplots(dims[0], dims[1], figsize=(25, 15)) axis_i, axis_j = 0, 0 für Spalte in Daten .columns: if col == 'is_red' or col == 'quality': weiter # Boxplots können nicht auf Indikatorvariablen verwendet werden sns.boxplot(x=high_quality, y=data[col], ax=axes[axis_i, axis_j ]) achse_j += 1 wenn achse_j == dims[1]: achse_i += 1 achse_j = 0

Split-Zug-Testdaten:

aus sklearn.model_selection import train_test_split

train, test = train_test_split(data, random_state=123)

X_train = train.drop(["Qualität"], Achse=1)

X_test = test.drop(["Qualität"], Achse=1)

y_train = train.qualität

y_test = test.qualität

Erstellen Sie ein Basismodell:

import mlflow import mlflow.pyfunc import mlflow.sklearn import numpy als np import sklearn von sklearn.ensemble import RandomForestClassifier von sklearn.metrics import roc_auc_score von mlflow.models.signature import infer_signature von mlflow Predict-Methode des RandomForestClassifier von sklearn gibt eine binäre Klassifizierung (0 oder 1) zurück. # Der folgende Code erstellt eine Wrapper-Funktion, SklearnModelWrapper, die # die Methode predict_proba verwendet, um die Wahrscheinlichkeit zurückzugeben, dass die Beobachtung zu jeder Klasse gehört. class SklearnModelWrapper(mlflow.pyfunc.PythonModel): def __init__(self, model): self.model = model def Predict(self, context, model_input): return self.model.predict_proba(model_input)[:,1] # mlflow. start_run erstellt einen neuen MLflow-Lauf, um die Leistung dieses Modells zu verfolgen. # Im Kontext rufen Sie mlflow.log_param auf, um die verwendeten Parameter zu verfolgen, und # mlflow.log_metric, um Metriken wie Genauigkeit aufzuzeichnen. with mlflow.start_run(run_name='untuned_random_forest'): n_estimators = 10 model = RandomForestClassifier(n_estimators=n_estimators, random_state=np.random.RandomState(123)) model.fit(X_train, y_train) # Predict_proba gibt [prob_negative, prob_positive] zurück , also Slice die Ausgabe mit [:, 1] Predictions_test = model.predict_proba(X_test)[:,1] auc_score = roc_auc_score(y_test, Predictions_test) mlflow.log_param('n_estimators', n_estimators) # Nutze die Fläche unter der ROC-Kurve als Metrik. mlflow.log_metric('auc', auc_score) WrappedModel = SklearnModelWrapper(model) # Das Modell mit einer Signatur protokollieren, die das Schema der Ein- und Ausgaben des Modells definiert. # Wenn das Modell bereitgestellt wird, wird diese Signatur verwendet, um Eingaben zu validieren. Signatur = infer_signature(X_train, WrappedModel.predict(None, X_train)) # MLflow enthält Dienstprogramme zum Erstellen einer Conda-Umgebung, die verwendet wird, um Modelle bereitzustellen. # Die erforderlichen Abhängigkeiten werden einer Datei conda.yaml hinzugefügt, die zusammen mit dem Modell protokolliert wird. conda_env = _mlflow_conda_env( zusätzliche_conda_deps=Keine, zusätzliche_pip_deps=["cloudpickle=={}".format(cloudpickle.__version__), "scikit-learn=={}".format(sklearn.__version__)], ml zusätzliche_conda_channels= .None, .pyfunc.log_model("random_forest_model", python_model=wrappedModel, conda_env=conda_env, signature=signature)

Ableiten der Merkmalswichtigkeit:

feature_importances = pd.DataFrame(model.feature_importances_, index=X_train.columns.tolist(), column=['importance']) feature_importances.sort_values('importance', ascending=False)

Experimentieren Sie mit XGBoost und Hyperopt:

Hyperopt ist ein Hyperparameter-Tuning-Framework, das auf bayesscher Optimierung basiert. Die Rastersuche ist zeitaufwendig und die Zufallssuche ist zwar besser als die Rastersuche, liefert jedoch keine optimalen Ergebnisse. Hyperopt-Know-how Artikel zu Analytics Vidhya.

from hyperopt import fmin, tpe, hp, SparkTrials, Trials, STATUS_OK from hyperopt.pyll import scope from math import exp import mlflow.xgboost import numpy as np import xgboost as xgb search_space = { 'max_depth': scope.int(hp.quniform ('max_depth', 4, 100, 1)), 'learning_rate': hp.loguniform('learning_rate', -3, 0), 'reg_alpha': hp.loguniform('reg_alpha', -5, -1), 'reg_lambda': hp.loguniform('reg_lambda', -6, -1), 'min_child_weight': hp.loguniform('min_child_weight', -1, 3), 'objective': 'binary:logistic', 'seed' : 123, # Setzt einen Seed für deterministisches Training } def train_model(params): # Beim MLflow-Autologging werden Hyperparameter und das trainierte Modell automatisch in MLflow protokolliert. mlflow.xgboost.autolog() with mlflow.start_run(nested=True): train = xgb.DMatrix(data=X_train, label=y_train) test = xgb.DMatrix(data=X_test, label=y_test) # Test bestanden so setzen, dass xgb eine Bewertungsmetrik verfolgen kann. XGBoost beendet das Training, wenn sich die Bewertungsmetrik # nicht mehr verbessert. booster = xgb.train(params=params, dtrain=train, num_boost_round=1000, evals=[(test, "test")], early_stopping_rounds=50) Predictions_test = booster.predict(test) auc_score = roc_auc_score(y_test, Predictions_test) mlflow.log_metric('auc', auc_score) signature = infer_signature(X_train, booster.predict(train)) mlflow.xgboost.log_model(booster, "model", signature=signature) # Setze den Verlust auf -1*auc_score, also fmin maximiert die auc_score return {'status': STATUS_OK, 'loss': -1*auc_score, 'booster': booster.attributes()} # Größere Parallelität führt zu Beschleunigungen, aber zu einem weniger optimalen Hyperparameter-Sweep. # Ein sinnvoller Wert für Parallelität ist die Quadratwurzel von max_evals. spark_trials = SparkTrials(parallelism=10) # Führe fmin in einem MLflow-Laufkontext aus, sodass jede Hyperparameterkonfiguration als untergeordneter Lauf eines übergeordneten Laufs # mit dem Namen "xgboost_models" protokolliert wird. mit mlflow.start_run(run_name='xgboost_models'): best_params = fmin( fn=train_model, space=search_space, algo=tpe.suggest, max_evals=96, Trials=spark_trials, rstate=np.random.RandomState(123) )

Rufen Sie schließlich das beste Modell aus dem MLFLOW-Lauf ab:

best_run = mlflow.search_runs(order_by=['metrics.auc DESC']).iloc[0] print(f'AUC von Best Run: {best_run["metrics.auc"]}')

Praxis – Warenkorbanalyse auf Databricks

Verwenden Sie das Online-Notizbuch um InstaKart-Lebensmitteldaten und empfohlene Upselling-/Cross-Selling-Möglichkeiten mittels Warenkorbanalyse zu analysieren.

Dashboarding auf Databricks:

Databricks verfügt über eine Funktion zum Erstellen eines interaktiven Dashboards mit den bereits vorhandenen Codes, Bildern und Ausgaben.

- Umzug nach Anzeigen Menü und wählen Sie + Neues Dashboard

- Geben Sie dem Dashboard einen Namen.

- Klicken Sie in der oberen rechten Ecke jeder Zelle auf das kleine Balkendiagramm.

- Es zeigt das verfügbare Dashboard für das Notebook an.

- Wenn der Codeblock oder das Bild auf dem Dashboard sein muss, aktivieren Sie das Kontrollkästchen.

- Alle angekreuzten Zellen werden auf dem Dashboard angezeigt.

- Die Zelle und bei Bedarf einfach mit der Drag-and-Drop-Funktion organisiert werden.

Nützliche Ressourcen und Referenzen

- Prognosen bei Starbucks mit Databricks.

- Databricks-Community für Diskussionen zu verschiedenen Themen.

- Universitätsallianz Databricks – Bietet Hochschullehrern sowie Studenten kostenlosen Zugang zur Plattform.

- Webinare und E-Books von Databricks.

- Ebook über Deltasee.

- E-Book zum ML-Lebenszyklus.

- Datalake-Databricks Erklärung

- Dashboarding auf Databricks.

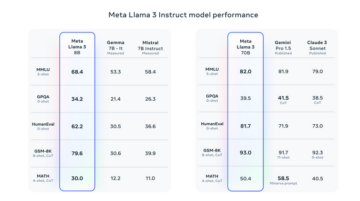

Databricks-Zertifizierung

Databricks bietet Live Instructor Lead Training, sowie Programme zum Selbststudium, die Einzelpersonen helfen, die Plattform besser zu verstehen. Die im eigenen Tempo Kurs kostet 2000 $. Es bietet auch eine Zertifizierung basierend auf der Rollenanpassung. Die üblichen Karrierewege sind Unternehmensleiter, Plattformadministrator, SQL-Analyst, Dateningenieur, Datenwissenschaftler.

Es gibt vier Zertifizierungen, nämlich

- Databricks zertifizierter Associate Developer für Apache Spark – Für Spark-Entwickler.

- Databricks Certified Professional Data Scientist – Für alles rund um ML.

- Azure Databricks Certified Associate Platform Administrator – ist eine Prüfung, die das Verständnis der Grundlagen der Netzwerkinfrastruktur und -sicherheit, Identität und Zugriff, Clusternutzung und Automatisierung mit der Azure Databricks-Plattform bewertet.

- Databricks Certified Professional Data Engineer – Alles rund um ETL, Pipelines und Bereitstellung.

Bild 5

Endnoten

Dieser Artikel kratzt nur an der Oberfläche dessen, wozu Databricks fähig ist. Databricks kann noch viel mehr, was in diesem Artikel nicht behandelt wird, und für Datenenthusiasten ist es eine wahre Fundgrube. Also übe und lerne immer weiter.

Viel Glück! Hier ist mein Linkedin Profil, falls Sie mit mir in Kontakt treten möchten. Ich freue mich, mit Ihnen verbunden zu sein. Lesen Sie auch meine anderen Artikel zu Data Science und Analytics hier.

Bildreferenzen:

Bild 1: https://databricks.com/product/data-lakehouse

Bild 2: https://databricks.com/try-databricks

Bild 3: https://databricks.com/blog/2021/05/19/evolution-to-the-data-lakehouse.html

Bild 4: https://pages.databricks.com/definitive-guide-spark.html

Bild 5: jsdsdhttps://academy.databricks.com/catalog

Die in diesem Artikel gezeigten Medien sind nicht Eigentum von Analytics Vidhya und werden nach Ermessen des Autors verwendet.

Quelle: https://www.analyticsvidhya.com/blog/2021/09/a-comprehensive-guide-on-databricks-beginners/

- "

- 100

- 11

- 9

- Zugang

- aktiv

- Aktivitäten

- Administrator

- Adoption

- Algorithmen

- Alle

- Amazon

- Amazon Echo

- Amazon Web Services

- Analyse

- Analytiker

- Analytik

- Apache

- Apache Funken

- Bienen

- App

- Anwendung

- Anwendungen

- Bereich

- um

- Artikel

- Artikel

- Atlas

- Auto

- Automation

- Verfügbarkeit

- AWS

- Azure

- Bankinggg

- Bankensysteme

- Baseline

- Grundlagen

- BESTE

- Big Data

- Box

- Brot

- bauen

- Geschäft

- Unternehmen

- Kauf

- rufen Sie uns an!

- Karriere

- Fälle

- Zertifizierung

- der

- Einstufung

- geschlossen

- Cloud

- Cloud Computing

- Cloud-Plattform

- Code

- gemeinsam

- community

- Berechnen

- Computer

- Computing

- Verbindungen

- verbrauchen

- Inhalt

- fortsetzen

- Kosten

- Schöpfer

- Kurve

- Kunden

- Armaturenbrett

- technische Daten

- Datenanalyse

- Datenanalyse

- Datensee

- Datenwissenschaft

- Datenwissenschaftler

- Datenspeichervorrichtung

- Data Warehouse

- Data Warehouse

- Databricks

- Tag

- Decision Making

- Verzögerungen

- Delta

- Entwickler:in / Unternehmen

- Entwickler

- Fahrer

- Drop

- Echo

- Ecosystems

- Edge

- Ingenieur

- Entwicklung

- Ingenieure

- Arbeitsumfeld

- etc

- Experiment

- Gesicht

- Merkmal

- Eigenschaften

- FinTech

- Vorname

- Fluss

- Setzen Sie mit Achtsamkeit

- folgen

- Format

- Unser Ansatz

- Frei

- Funktion

- gif

- Cumolocity

- GPU

- Gitter

- Lebensmittelgeschäft

- Gruppe an

- persönlichem Wachstum

- Guide

- hier

- HP

- HTTPS

- ICON

- ICS

- identifizieren

- Identitätsschutz

- Image

- Indien

- Information

- Infrastruktur

- Einblicke

- Integration

- interaktive

- Isolierung

- IT

- Javac

- Job

- keras

- Sprache

- Sprachen

- grosse

- starten

- führen

- lernen

- Hebelwirkung

- Bibliothek

- Belastung

- Darlehen

- aus einer regionalen

- Standorte

- Maschinelles Lernen

- Maschinen

- Dur

- Making

- Management

- Hersteller

- Markt

- Marketing

- Mathe

- Medien

- Metrik

- Microsoft

- ML

- ML-Algorithmen

- Modell

- MongoDB

- Monat

- schlauer bewegen

- Netzwerk

- Laptops

- Einkauf & Prozesse

- Entwicklungsmöglichkeiten

- Option

- Optionen

- Auftrag

- Andere

- AUFMERKSAMKEIT

- Leistung

- physikalisch

- Drehpunkt

- Plattform

- Portugiesisch

- Po

- Prognosen

- Produkt

- Produkte

- Programm

- Programme

- veröffentlichen

- Python

- Qualität

- Roh

- Rohdaten

- Lesebrillen

- Ressourcen

- Downloads

- Die Ergebnisse

- Rückgabe

- Bewertungen

- Führen Sie

- Laufen

- Einsparung

- Scala

- Skalierbarkeit

- Skalieren

- Wissenschaft

- Wissenschaftler

- Suche

- Sicherheitdienst

- Samen

- Sellers

- Lösungen

- kompensieren

- von Locals geführtes

- Einfacher

- So

- Lösungen

- SQL

- quadratisch

- Starbucks

- Startups

- Bundesstaat

- Status

- Lagerung

- speichern

- Streaming

- Support

- Unterstützt

- Oberfläche

- Sweep

- Systeme und Techniken

- Tableau

- auch Lehrer

- Tensorfluss

- Test

- Zeit

- Top

- Themen

- verfolgen sind

- Ausbildung

- Transaktion

- Transaktionen

- Versuch

- Lernprogramm

- Universität

- Nutzer

- Dienstprogramme

- Wert

- Visualisierung

- Stimme

- Warehouse

- Lagerung

- Netz

- Web-Services

- wöchentlich

- WEIN

- .

- Arbeiten

- Arbeitsablauf.

- Youtube