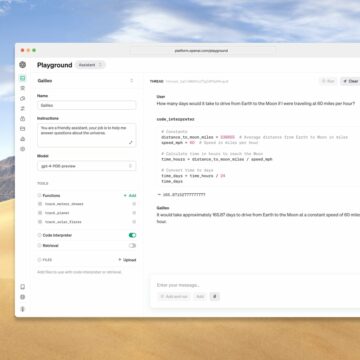

Cohere, OpenAI und AI21 Labs haben eine vorläufige Reihe von Best Practices entwickelt, die auf alle Organisationen anwendbar sind, die große Sprachmodelle entwickeln oder einsetzen. Computer, die lesen und schreiben können, sind da, und sie haben das Potenzial, das tägliche Leben grundlegend zu beeinflussen. Die Zukunft der Mensch-Maschine-Interaktion ist voller Möglichkeiten und Versprechen, aber jede leistungsstarke Technologie erfordert einen sorgfältigen Einsatz.

Die nachstehende gemeinsame Erklärung stellt einen Schritt zum Aufbau einer Gemeinschaft dar, um die globalen Herausforderungen des KI-Fortschritts anzugehen, und wir ermutigen andere Organisationen, die sich beteiligen möchten, sich zu melden.

Gemeinsame Empfehlung für die Bereitstellung von Sprachmodellen

Wir empfehlen mehrere Schlüsselprinzipien, um Anbietern von Large Language Models (LLMs) dabei zu helfen, die Risiken dieser Technologie zu mindern, um ihr volles Versprechen zu erfüllen, die menschlichen Fähigkeiten zu erweitern.

Obwohl diese Prinzipien speziell auf der Grundlage unserer Erfahrung mit der Bereitstellung von LLMs über eine API entwickelt wurden, hoffen wir, dass sie unabhängig von der Veröffentlichungsstrategie (z. B. Open-Sourcing oder Verwendung innerhalb eines Unternehmens) nützlich sind. Wir gehen davon aus, dass sich diese Empfehlungen im Laufe der Zeit erheblich ändern werden, da die kommerzielle Verwendung von LLMs und die damit verbundenen Sicherheitsüberlegungen neu sind und sich weiterentwickeln. Wir informieren uns aktiv über LLM-Beschränkungen und Möglichkeiten für Missbrauch und gehen diese an. Wir werden diese Prinzipien und Praktiken im Laufe der Zeit in Zusammenarbeit mit der breiteren Community aktualisieren.

Wir teilen diese Prinzipien in der Hoffnung, dass andere LLM-Anbieter daraus lernen und sie übernehmen können, und um die öffentliche Diskussion über die Entwicklung und den Einsatz von LLM voranzutreiben.

Missbrauch verbieten

Veröffentlichen Sie Nutzungsrichtlinien und Nutzungsbedingungen von LLMs in einer Weise, die materiellen Schaden für Einzelpersonen, Gemeinschaften und die Gesellschaft verbietet, wie etwa durch Spam, Betrug oder Astroturfing. Nutzungsrichtlinien sollten auch Bereiche spezifizieren, in denen die LLM-Nutzung eine zusätzliche Prüfung erfordert, und hochriskante Anwendungsfälle verbieten, die nicht angemessen sind, wie z. B. die Klassifizierung von Personen basierend auf geschützten Merkmalen.

Erstellen Sie Systeme und Infrastrukturen, um Nutzungsrichtlinien durchzusetzen. Dies kann Ratenbegrenzungen, Inhaltsfilterung, Anwendungsgenehmigung vor dem Produktionszugriff, Überwachung auf anomale Aktivitäten und andere Minderungsmaßnahmen umfassen.

Minimieren Sie unbeabsichtigten Schaden

Mindern Sie proaktiv schädliches Modellverhalten. Best Practices umfassen eine umfassende Modellbewertung zur korrekten Bewertung von Einschränkungen, die Minimierung potenzieller Verzerrungsquellen in Schulungskorpora und Techniken zur Minimierung unsicheren Verhaltens, z. B. durch Lernen aus menschlichem Feedback.

Dokumentieren Sie bekannte Schwachstellen und SchwachstellenB. Voreingenommenheit oder die Fähigkeit, unsicheren Code zu erstellen, da in manchen Fällen kein Grad an vorbeugenden Maßnahmen das Potenzial für unbeabsichtigte Schäden vollständig ausschließen kann. Die Dokumentation sollte auch modell- und anwendungsfallspezifische Best Practices für die Sicherheit enthalten.

Überlegt mit Stakeholdern zusammenarbeiten

Bauen Sie Teams mit unterschiedlichen Hintergründen auf und erbitten breite Beiträge. Unterschiedliche Perspektiven sind erforderlich, um zu charakterisieren und zu behandeln, wie Sprachmodelle in der Vielfalt der realen Welt funktionieren, wo sie, wenn sie nicht überprüft werden, Vorurteile verstärken oder für einige Gruppen nicht funktionieren können.

Offenlegung der gewonnenen Erkenntnisse in Bezug auf die Sicherheit und den Missbrauch von LLM um eine breite Akzeptanz zu ermöglichen und bei der branchenübergreifenden Iteration von Best Practices zu helfen.

Behandeln Sie alle Arbeitskräfte in der Lieferkette des Sprachmodells mit Respekt. Beispielsweise sollten Anbieter hohe Standards für die Arbeitsbedingungen derjenigen haben, die Modellergebnisse intern überprüfen, und Anbieter an genau festgelegte Standards halten (z. B. sicherstellen, dass Etikettierer in der Lage sind, sich von einer bestimmten Aufgabe abzumelden).

Als LLM-Anbieter stellt die Veröffentlichung dieser Prinzipien einen ersten Schritt dar, um gemeinsam eine sicherere Entwicklung und Bereitstellung von großen Sprachmodellen zu leiten. Wir freuen uns darauf, weiterhin miteinander und mit anderen Parteien zusammenzuarbeiten, um weitere Möglichkeiten zu identifizieren, um unbeabsichtigte Schäden durch Sprachmodelle zu reduzieren und die böswillige Verwendung von Sprachmodellen zu verhindern.

Unterstützung durch andere Organisationen

„Während LLMs viel versprechend sind, haben sie erhebliche inhärente Sicherheitsprobleme, an denen gearbeitet werden muss. Diese Best Practices dienen als wichtiger Schritt, um die Nachteile dieser Modelle zu minimieren und ihren potenziellen Nutzen zu maximieren.“

– Anthropisch

„Da große Sprachmodelle (LLMs) immer leistungsfähiger und aussagekräftiger geworden sind, wird die Risikominderung immer wichtiger. Wir begrüßen diese und andere Bemühungen, um proaktiv zu versuchen, Schäden zu mindern und den Benutzern Bereiche aufzuzeigen, die besondere Sorgfalt erfordern. Die hier skizzierten Prinzipien sind ein wichtiger Beitrag zum globalen Gespräch.“

—John Bansemer, Direktor des CyberAI-Projekts und Senior Fellow, Center for Security and Emerging Technology (CSET)

„Google bekräftigt die Bedeutung umfassender Strategien bei der Analyse von Modell- und Trainingsdaten, um die Risiken von Schaden, Voreingenommenheit und Falschdarstellung zu mindern. Es ist ein durchdachter Schritt dieser KI-Anbieter, die Prinzipien und die Dokumentation zur KI-Sicherheit zu fördern.“

—Google Cloud-Plattform (GCP)

„Die Sicherheit von Basismodellen, wie großen Sprachmodellen, ist ein wachsendes gesellschaftliches Anliegen. Wir loben Cohere, OpenAI und AI21 Labs dafür, dass sie einen ersten Schritt unternommen haben, um allgemeine Prinzipien für eine verantwortungsvolle Entwicklung und Bereitstellung aus der Perspektive von Modellentwicklern zu skizzieren. Es gibt noch viel zu tun, und wir glauben, dass es wichtig ist, mehr Stimmen aus Wissenschaft, Industrie und Zivilgesellschaft einzubeziehen, um detailliertere Prinzipien und Gemeinschaftsnormen zu entwickeln. Wie wir in unserem letzten sagen Blog-Post, es kommt nicht nur auf das Endergebnis an, sondern auf die Legitimität des Prozesses.“

—Percy Liang, Direktor des Stanford Center for Research on Foundation Models (CRFM)

Werde Partner

Wenn Sie Sprachmodelle entwickeln oder daran arbeiten, deren Risiken zu mindern, würden wir gerne mit Ihnen sprechen. Bitte melden Sie sich unter bestpractices@openai.com.

- Fähigkeit

- Über uns

- Zugang

- Erreichen

- Action

- Aktivität

- Adresse

- Adressierung

- Adoption

- vorantreiben

- AI

- Alle

- Bienen

- anwendbar

- Anwendung

- angemessen

- weil

- werden

- unten

- Vorteile

- BESTE

- Best Practices

- Building

- Fähigkeiten

- Fälle

- Kette

- Herausforderungen

- Übernehmen

- Cloud

- Cloud-Plattform

- Code

- zusammenarbeiten

- Zusammenarbeit

- kommerziell

- Communities

- community

- Unternehmen

- uneingeschränkt

- umfassend

- Computer

- Bedingungen

- Überlegungen

- Container

- Inhalt

- fortsetzen

- Gespräch

- technische Daten

- Bereitstellen

- Einsatz

- detailliert

- entwickeln

- entwickelt

- Entwickler

- Entwicklung

- Entwicklung

- Fleiß

- Direktor

- Diversität

- Domains

- Bemühungen

- beseitigen

- aufstrebenden

- ermöglichen

- ermutigen

- engagieren

- Gewährleistung

- essential

- Auswertung

- sich entwickelnden

- Beispiel

- aufgeregt

- erwarten

- ERFAHRUNGEN

- expressiv

- Feedback

- Filterung

- Vorname

- Foundation

- Betrug

- voller

- grundlegend

- Zukunft

- Global

- Gruppen

- persönlichem Wachstum

- Richtlinien

- Hilfe

- hier

- High

- hohes Risiko

- Hervorheben

- hofft,

- Ultraschall

- HTTPS

- human

- identifizieren

- Impact der HXNUMXO Observatorien

- Bedeutung

- wichtig

- das

- zunehmend

- Einzelpersonen

- Energiegewinnung

- Infrastruktur

- inhärent

- Varianten des Eingangssignals:

- Interaktion

- Probleme

- IT

- Wesentliche

- bekannt

- Arbeit

- Labs

- Sprache

- grosse

- LERNEN

- gelernt

- lernen

- Legitimität

- Lessons Learned

- ich liebe

- Maschine

- Ihres Materials

- Angelegenheiten

- Modell

- für

- Überwachung

- mehr

- Bedürfnisse

- betreiben

- Entwicklungsmöglichkeiten

- Auftrag

- Organisation

- Organisationen

- Andere

- teilnehmen

- Personen

- Perspektive

- Perspektiven

- Plattform

- Möglichkeit

- Potenzial

- größte treibende

- Prozessdefinierung

- produziert

- Produktion

- Projekt

- Versprechen

- fördern

- geschützt

- Bereitstellung

- Öffentlichkeit

- Publishing

- RE

- erreichen

- realen Welt

- empfehlen

- Veteran

- in Bezug auf

- Release

- representiert

- erfordert

- Forschungsprojekte

- für ihren Verlust verantwortlich.

- Risiko

- Risiken

- Sicherheit

- Sicherheit

- Sicherheitdienst

- kompensieren

- mehrere

- ,,teilen"

- signifikant

- Social Media

- Gesellschaft

- einige

- Spam

- speziell

- Normen

- Bundesstaat

- Erklärung

- Strategien

- Strategie

- liefern

- Supply Chain

- Systeme und Techniken

- Einnahme

- Reden

- Techniken

- Technologie

- AGB

- Das

- Durch

- Zeit

- aufnehmen

- gegenüber

- Ausbildung

- Aktualisierung

- -

- Anwendungsfälle

- Nutzer

- Anbieter

- STIMMEN

- willkommen

- während

- WHO

- weit verbreitet

- .

- Arbeiten

- gearbeitet

- arbeiten,

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- würde