In der Woche vom 19. Aprilth2021 veranstaltete die Linley Group ihre Prozessorkonferenz im Frühjahr. Die Linley Group genießt den Ruf, hervorragende Konferenzen auszurichten. Und die diesjährige Frühjahrstagung bildete da keine Ausnahme. Es gab eine Reihe sehr informativer Vorträge von verschiedenen Unternehmen, die das Publikum über die neuesten Forschungs- und Entwicklungsarbeiten in der Branche informierten. Die Vorträge waren in acht verschiedene Themenbereiche kategorisiert. Die Themen waren Edge AI, Embedded SoC Design, Scaling AI Training, AI SoC Design, Netzwerkinfrastruktur für AI und 5G, Edge AI Software, Signalverarbeitung und effiziente KI-Inferenz.

Künstliche Intelligenz (KI) als Technologie hat in den letzten Jahren viel Aufmerksamkeit und Investitionen auf sich gezogen. Die Konferenz spiegelte dies sicherlich in der Anzahl der Themenkategorien im Zusammenhang mit KI wider. Innerhalb der breiteren Kategorie der KI war Edge AI ein Thema, das zu Recht einen unfairen Anteil an Präsentationen hatte. Edge Computing verzeichnet ein schnelles Wachstum, das durch IoT, 5G und andere Anwendungen mit geringen Latenzanforderungen vorangetrieben wird.

Eine der Präsentationen in der Kategorie „Edge AI“ trug den Titel „Verbesserung der RISC-V-Vektorerweiterungen zur Beschleunigung der Leistung bei ML-Workloads.“ Der Vortrag wurde von Chris Lattner gehalten, Präsident für Technik und Produkt bei SiFive, Inc. Chris lieferte überzeugende Argumente dafür, warum die auf RISC-V-Vektorerweiterungen basierende Lösung von SiFive hervorragend für KI-gesteuerte Anwendungen geeignet ist. Das Folgende ist meine Meinung.

Marktanforderungen:

So schnell der Markt für Edge Computing wächst, werden auch die Leistungs- und Energieanforderungen dieser Anwendungen immer anspruchsvoller. Viele dieser Anwendungen sind KI-gesteuert und fallen in die Kategorie der Workloads für maschinelles Lernen (ML). Und die Einführung von KI verschiebt den Verarbeitungsbedarf mehr in Richtung Datenmanipulation als in Richtung Allzweck-Computing. Deep Learning liegt ML-Modellen zugrunde und umfasst die Verarbeitung großer Datenmengen. Da sich ML-Modelle schnell weiterentwickeln, wäre eine ideale Lösung eine Lösung, die Folgendes optimiert: Leistung, Leistung, einfache Integration neuer ML-Modelle und Umfang der daraus resultierenden Hardware- und/oder Softwareänderungen.

RISC-V-Vektorvorteil:

Die ursprüngliche Motivation hinter der Initiative, die uns die RISC-V-Architektur beschert hat, ist das Experimentieren. Experimentieren, um Chipdesigns zu entwickeln, die trotz der erwarteten Verlangsamung des Mooreschen Gesetzes eine bessere Leistung erbringen. RISC-V basiert auf der Idee, bestimmte Chips maßgeschneidert herstellen zu können, bei denen Sie auswählen können, welche Befehlssatzerweiterungen Sie verwenden. Vektorerweiterungen ermöglichen die Verarbeitung von Vektoren beliebiger Länge mithilfe von Funktionen, die Vektoren fester Länge verarbeiten. Durch die Vektorverarbeitung kann vorhandene Software ohne Neukompilierung ausgeführt werden, wenn die Hardware in Form von mehr ALUs und anderen Funktionseinheiten aktualisiert wird. Hinsichtlich der etablierten Hardwarebasis und des unterstützenden Ökosystems wie Compiler-Technologien wurden erhebliche Fortschritte erzielt.

RISC-V kann durch benutzerdefinierte Erweiterungen für eine bestimmte Domäne oder Anwendung optimiert werden. Als offene Standard-Befehlssatzarchitektur genießen RISC-V-Benutzer große Flexibilität bei der Auswahl eines Lieferanten für ihre Chip-Design-Anforderungen.

Das Angebot von SiFive:

SiFive hat den Vorteil des RISC-V-Vektors durch das Hinzufügen neuer Vektorerweiterungen zur Beschleunigung der Ausführung vieler verschiedener neuronaler Netzwerkmodelle erweitert. In Abbildung 1 sehen Sie ein Beispiel für die Art der Beschleunigung, die mit den Add-on-Erweiterungen von SiFive im Vergleich zur alleinigen Verwendung der Basisvektorerweiterungen von RISC-V erzielt werden kann. Bei der Intelligence Mit der Lösung lassen sich auch Rechenzentrumsanwendungen realisieren.

Abbildung 1:

SiFive-Vorteil:

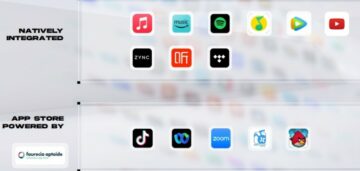

- Die Intelligence X280-Lösung von SiFive unterstützt die Open-Source-Plattformen TensorFlow und TensorFlow Lite für maschinelles Lernen vollständig (siehe Abbildung 2).

- SiFive bietet eine einfache Möglichkeit, den vorhandenen Code des Kunden, der auf anderen Architekturen basiert, auf die RISC-V-Vektorarchitektur zu migrieren. SiFive kann beispielsweise ARM-Neon-Code in RISC-V-V-Assembly-Code übersetzen

- SiFive ermöglicht seinen Kunden die Möglichkeit, benutzerdefinierte Erweiterungen zu ihren RISC-V-Implementierungen hinzuzufügen

- SiFive erweitert über seine Geschäftseinheit OpenFive kundenspezifische Chip-Implementierungsdienste, um domänenspezifische Siliziumanforderungen zu erfüllen

Abbildung 2:

Zusammenfassung:

Kurz gesagt: SiFive-Kunden können ihre Anwendungen einfach und schnell implementieren, unabhängig davon, ob es sich bei den Anwendungen um Edge-KI-Workloads oder herkömmliche Workloads im Rechenzentrumstyp handelt. Wenn Sie daran interessiert sind, von den SiFive-Lösungen zur Beschleunigung der Leistung Ihrer ML-Workloads zu profitieren, empfehle ich Ihnen, sich zu registrieren und anzuhören Chris' gesamter Vortrag Besprechen Sie dann mit SiFive Möglichkeiten, die verschiedenen Angebote für die Entwicklung Ihrer Produkte zu nutzen.

Teile diesen Beitrag über: Quelle: https://semiwiki.com/ip/sifive/299157-enhancing-risc-v-vector-extensions-to-accelerate-performance-on-ml-workloads/

- 2021

- 5G

- Erweiterung

- Adoption

- Vorteil

- AI

- KI-Adoption

- KI-Training

- Anwendung

- Anwendungen

- April

- Architektur

- ARM

- Publikum

- Geschäft

- Chip

- Pommes frites

- Code

- Unternehmen

- Computing

- Konferenz

- Kongressbegleitung

- Kunden

- technische Daten

- Data Center

- tiefe Lernen

- Design

- entwickeln

- Entwicklung

- angetrieben

- Ökosystem

- Edge

- Edge-Computing

- Entwicklung

- Ausführung

- Erweiterungen

- Gesicht

- FAST

- Abbildung

- passen

- Flexibilität

- unten stehende Formular

- voller

- Allgemeines

- groß

- Gruppe an

- persönlichem Wachstum

- Wachstum

- Hardware

- HTTPS

- Idee

- Inc.

- Energiegewinnung

- Infrastruktur

- Initiative

- Intelligenz

- Investition

- iot

- IT

- grosse

- neueste

- Recht

- lernen

- Hebelwirkung

- Maschinelles Lernen

- Manipulation

- Markt

- Angelegenheiten

- ML

- Neon

- Netzwerk

- Neural

- neuronale Netzwerk

- bieten

- Angebote

- XNUMXh geöffnet

- Andere

- Leistung

- Plattformen

- Werkzeuge

- Presentations

- Präsident

- Produkt

- Produkte

- Voraussetzungen:

- Forschungsprojekte

- Forschung und Entwicklung

- Führen Sie

- Skalierung

- Leistungen

- kompensieren

- Teilen

- So

- Software

- Lösungen

- Feder

- Support

- Unterstützt

- Gespräche

- Technologies

- Technologie

- Tensorfluss

- Die Initiative

- Ausbildung

- us

- Nutzer

- Woche

- .

- Arbeiten

- Jahr

- Ausbeute