Kommentar In den USA sind in diesem Jahr bisher mehr als 250 Massenerschießungen erfolgt, und KI-Befürworter glauben, die Lösung gefunden zu haben. Keine Waffenkontrolle, aber bessere Technik, wenig überraschend.

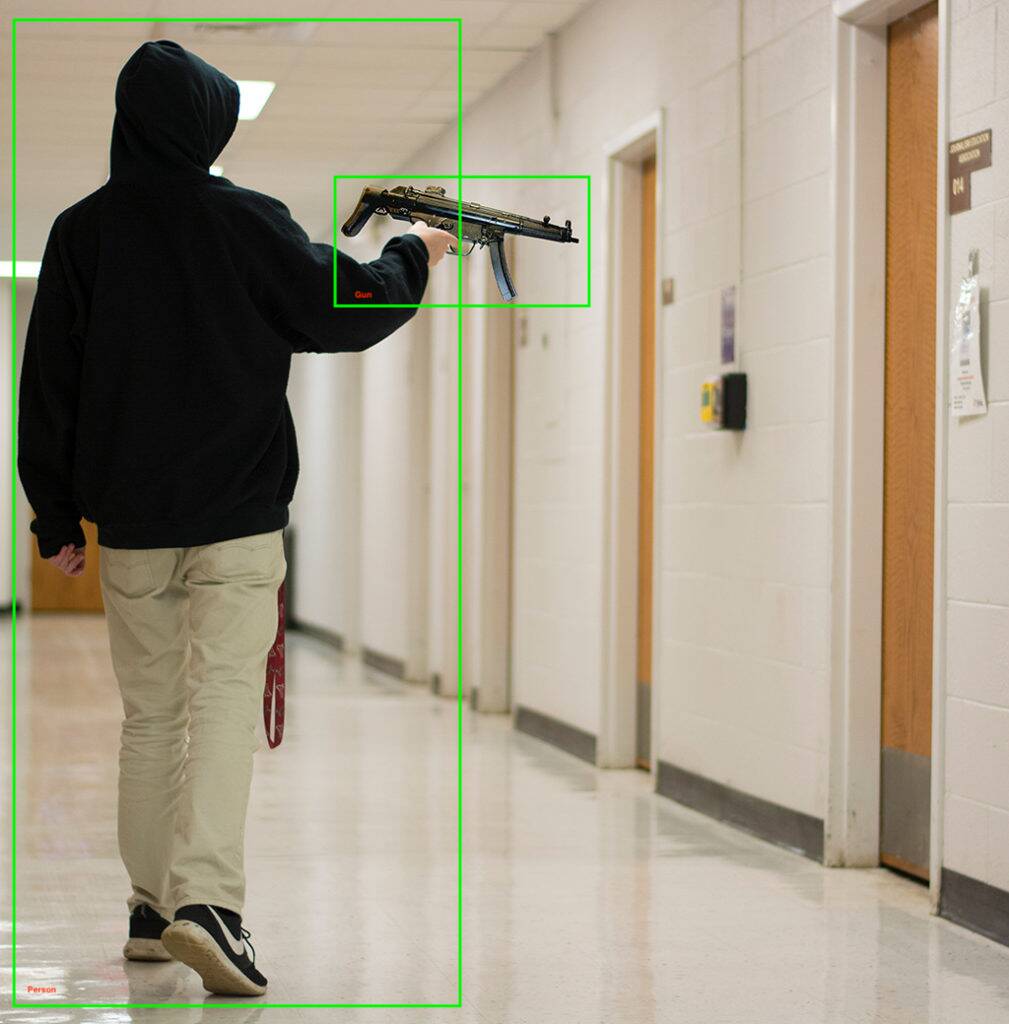

Das Unternehmen für maschinelles Lernen, Kogniz, gab am Dienstag bekannt, dass es eine einsatzbereite Lösung hinzufügt Waffenerkennungsmodell zu seiner Computer-Vision-Plattform. Das System, so wird uns gesagt, kann Waffen erkennen, die von Überwachungskameras gesehen werden, und Benachrichtigungen an gefährdete Personen senden, die Polizei benachrichtigen, Gebäude absperren und andere Sicherheitsaufgaben ausführen.

Neben der Erkennung von Schusswaffen verwendet Kogniz seine anderen Computer-Vision-Module, um ungewöhnliches Verhalten zu erkennen, z. B. wenn Kinder durch Flure sprinten oder jemand durch ein Fenster klettert, was auf einen aktiven Schützen hindeuten könnte.

Wenn Sie sich über die Fehlalarm- oder Fehlerrate des Codes wundern, sagt Kogniz, dass er eine „Multi-Pass-KI“ und „ein geschultes Team menschlicher Verifizierer“ hat, die die Ergebnisse seiner Erkennungssoftware überprüfen. Entweder Sie begrüßen diese zusätzliche Ebene der Bestätigung oder sehen darin eine Technologie, die möglicherweise genau dann auf Menschen zurückgreift, wenn die Computer am dringendsten benötigt werden.

„[Unsere Lösung] macht es Unternehmen, Regierungsbehörden, Schulen und Krankenhäusern erheblich einfacher, sich auf ein aktives Shooter-Event vorzubereiten und dann zu helfen, den Schaden zu verringern, der durch ein aktives Shooter-Event verursacht wird“, sagte Daniel Putterman, CEO von Kogniz.

Kogniz ist nicht das erste Computer-Vision-Unternehmen, das in das Waffenerkennungsspiel einsteigt – es gibt eine beträchtliche Liste von Unternehmen, die ähnliche Technologien einsetzen, und einige, wie ZeroEyes, sind ausschließlich auf die Erkennung von Schusswaffen spezialisiert.

„Durch die Verteilung ihrer Aufmerksamkeit auf mehrere Angebote sind Entwickler weniger in der Lage, den allerbesten Service bei der Waffenerkennung zu bieten“, sagte ZeroEyes in a Blog-Post. Die Technologie von ZeroEyes wurde an Schulen in 14 US-Bundesstaaten eingesetzt, darunter Oxford-Gymnasium in der Metro Detroit, wo ein 15-jähriger Schütze letztes Jahr vier tötete und sieben verletzte.

Andere Anbieter – wie Defendry, das über eine Sicherheitssuite mit einer Panikknopf-App, Audio-Schusssensoren, Ersthelfer-Drohnen und Waffenerkennungs-KI verfügt; und Omnilert – befinden sich in diesem deprimierenden Wachstumsmarkt. Weitere Unternehmen im Bereich der KI-Waffenerkennung sind Arcarith, Athena Securities und Scylla.

Reicht die Zeit eigentlich?

Im Jahr 2019 dauerte die Reaktion der Polizei auf eine Massenerschießung in Dayton, Ohio, nur 32 Sekunden, in denen neun Menschen starben. Eine Schießerei im Jahr 2021 in einer FedEx-Einrichtung in Indianapolis, bei der neun Menschen getötet wurden, war ebenfalls vorbei, bevor die Bullen eintreffen konnten, obwohl sie es in nur wenigen Minuten taten.

Beide Fälle werfen die Frage auf, ob die KI-Waffenerkennung die Reaktionszeiten ausreichend verkürzen kann, um Leben zu retten. Vor allem, wenn die Beamten zu verängstigt sind oder lieber nicht reagieren, wie etwa beim Massenmord in Uvalde.

Es wurden mehrere andere KI-basierte Methoden zur Verhinderung von Massenschießereien vorgeschlagen, wie z intelligente Waffen die nicht feuern, wenn sie ein menschliches Ziel entdecken. Andere haben vorgeschlagen, KIs mit Daten aus vergangenen Schießereien, lokalen Waffenkäufen und sozioökonomischen Daten zu trainieren, um Trends zu finden, die auf eine geplante Schießerei hinweisen, und soziale Medien nach ähnlichen Indikatoren zu durchsuchen.

Es gibt auch AI Voreingenommenheit, eine gut dokumentiertes Problem dass sogar diverse Datensätze und ein ausgewogenes Training kann scheinbar nicht gelöst werden. Nehmen Sie einen Einsatz von Gesichts- und Waffenerkennungstechnologie im Jahr 2020 in einem New Yorker Schulbezirk: E-Mails zwischen dem Schulbezirk und dem Unternehmen, das das System eingesetzt hat, zeigen häufig Bedenken darüber falsch identifizieren Dinge wie Besenstiele für Waffen.

Jay Stanley, Senior Policy Analyst der ACLU, sprach mit der Veröffentlichung Deseret News aus Utah sagte Er war besorgt, dass Computer-Vision-Systeme zu einer Welt führen könnten, „in der Menschen es vermeiden, so etwas Einfaches wie das Herunterspringen eines Bürgersteigs zu tun, aus Angst, Anomaliedetektoren auszulösen und von der Polizei verhört zu werden“.

Ein möglicher Einsatz von KI könnte jedoch vielversprechender sein: ein 2018 Studie vom Cincinnati Children's Hospital Medical Center fanden heraus, dass die KI-Analyse von Therapiesitzungen in 91 Prozent der Fälle mit den Gefahreneinschätzungen von Psychiatern und Beratern übereinstimmte. Die Hinzufügung von demografischen und sozioökonomischen Daten verbesserte lediglich die Ergebnisse bei der Identifizierung von Jugendlichen, die gefährdet waren, eine Gewalttat zu begehen.

Ist maschinelles Lernen bei so vielen potenziellen Komplikationen wirklich bereit, Massenmord zu verhindern?

Waffengewalt ist die Mörder Nummer eins von Kindern und Jugendlichen in Amerika, die jeden Tag durchschnittlich 12 jungen Menschen das Leben nehmen und 32 weitere verletzen. KI kann helfen, aber ohne ihre Mängel anzugehen, sind vielleicht auch weniger technologische Ansätze erforderlich. Eine stärkere, breiter verfügbare psychiatrische Versorgung könnte ein guter Anfang sein.

Anfang dieses Monats Präsident Biden namens unter anderem für ein Verbot von Angriffswaffen, erweiterte Hintergrundüberprüfungen und Beschränkungen der Magazinkapazität, die er als „rationale, vernünftige Maßnahmen“ bezeichnete. ®

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Das Register

- Zephyrnet