Da KI-Modelle immer größer werden, sinkt die Menge an Geld und Energie erforderlich, um sie zu schulen, ist zu einem heiklen Thema geworden. Ein neuer Ansatz, der einen der grundlegenden Bausteine der Disziplin umschreibt, könnte eine mögliche Problemumgehung bieten.

Seit GPT-3 demonstrierten die signifikanten Leistungssprünge, die durch einfaches Erhöhen erreichbar sindAufgrund der Größe einzelner Modelle haben führende Unternehmen der KI-Branche Ressourcen für Schulungen aufgehäuft immer massivere neuronale Netze.

Aber dies kostet Unmengen an Geld, erfordert enorme Rechenressourcen und verbraucht enorme Mengen an Energie. Dies wird zunehmend als Problem angesehen, nicht nur wegen der Auswirkungen auf die Umwelt, sondern auch, weil es kleineren KI-Unternehmen den Wettbewerb erschwert und dadurch die Macht in den Händen von Branchenführern konzentriert.

Jetzt haben Forscher der Universität Oxford einen neuen Ansatz skizziert, der Potenzial haben könntely Trainingszeiten halbieren. Sie tun dies, indem sie einen der grundlegendsten Bestandteile der heutigen neuronalen netzwerkbasierten KI-Systeme neu schreiben: Backpropagation.

Wie ein neuronales Netzwerk Daten verarbeitet, hängt von der Stärke der Verbindungen zwischen seinen verschiedenen Neuronen ab. Damit sie also nützliche Arbeit leisten, müssen Sie diese Verbindungen zunächst anpassen, bis sie die Daten so verarbeiten, wie Sie es möchten. Sie tun dies, indem Sie das Netzwerk mit für das Problem relevanten Daten trainieren, indem Sie einen Prozess namens Backpropagation verwenden, der in zwei Phasen unterteilt ist.

Der Vorwärtslauf besteht darin, Daten durch das Netzwerk zu speisen und sie dazu zu bringen, Vorhersagen zu treffen. Beim Rückwärtsdurchgang werden Messungen der Genauigkeit dieser Vorhersagen verwendet, um das Netzwerk zurückzugehen und herauszufinden, wie die Stärke verschiedener Verbindungen angepasst werden sollte, um die Leistung zu verbessern. Durch mehrmaliges Wiederholen dieses Vorgangs mit vielen Daten arbeitet das Netzwerk schrittweise an einer optimalen Konfiguration von Verbindungen, die das jeweilige Problem löst.

Dieser sich wiederholende Prozess ist der Grund, warum es so lange dauert, KI zu trainieren, aber die Oxford-Forscher haben möglicherweise einen Weg gefunden, die Dinge zu vereinfachen. ichna Vorabdruck veröffentlicht am arXiv, sie deSchreiben Sie einen neuen Trainingsansatz, der den Rückwärtspass vollständig überflüssig macht. Stattdessen macht ihr Algorithmus Schätzungen darüber, wie Gewichte benötigt werden be beim Vorwärtsdurchgang geändert, und es stellt sich heraus, dass diese Annäherungen nahe genug sind, um eine vergleichbare Leistung wie bei der Backpropagation zu erzielen.

Die Forscher zeigten, dass der Ansatz verwendet werden kann, um eine Vielzahl verschiedener maschineller Lernalgorithmen zu trainieren, aber da er nur einen Vorwärtsdurchgang beinhaltet, konnte er die Trainingszeiten um bis zu die Hälfte verkürzen.

Es ist ein einfacher mathematischer Trick, Andrew Corbett von der University of Exeter in Großbritannien sagte New Scientist, aber coHelfen Sie mit, eine der dringendsten Herausforderungen zu bewältigen, denen sich die KI heute gegenübersieht. „Es ist eine sehr, sehr wichtige Sache, die es zu lösen gilt, denn es ist der Engpass der maschinellen Lernalgorithmen“, sagte er.

Wie breit anwendbar der Ansatz ist, bleibt allerdings abzuwarten. In ihrer Arbeit zeigen die Forscher, dass der Unterschied bei den Laufzeitkosten mit zunehmender Anzahl von Schichten in einem neuronalen Netzwerk schrumpft, was darauf hindeutet, dass die Technik bei größeren Modellen möglicherweise abnehmende Renditen erzielt.

Die Forscher stellen jedoch auch fest, dass sie eine Reihe von Möglichkeiten identifiziert haben, die Funktionsweise von Standardalgorithmen für maschinelles Lernen zu optimieren, um sie besser an ihre Methode anzupassen, was zu weiteren Leistungssteigerungen führen könnte.

Die Forschung könnte möglicherweise auch zu einem anhaltenden Rätsel der menschlichen Intelligenz beitragen. Künstliche neuronale Netze bleiben eines unserer besten Werkzeuge, um zu untersuchen, wie das Gehirn lernt, aber es haEs ist seit langem bekannt, dass Backpropagation aufgrund fehlender Rückwärtskonnektivität zwischen Neuronen biologisch nicht plausibel ist. Ein Lernansatz, der nur einen Vorwärtsgang erfordert, kann helfen, Licht ins Dunkel zu bringen, wie unser Gehirn das Lernproblem löst.

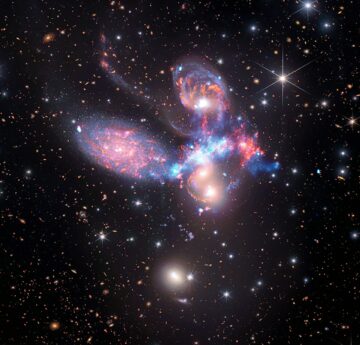

Bild-Kredit: Pexels / 9144 Bilder

- "

- AI

- Algorithmus

- Algorithmen

- Betrag

- Beträge

- anwendbar

- Ansatz

- künstlich

- werden

- BESTE

- Building

- Herausforderungen

- Computing

- Konfiguration

- Verbindungen

- Konnektivität

- beitragen

- Kosten

- könnte

- Kredit

- technische Daten

- weisen nach, dass

- anders

- enorm

- Umwelt-

- Schätzungen

- zugewandt

- FAST

- beschleunigt

- Vorname

- vorwärts

- gefunden

- bekommen

- Hilfe

- Ultraschall

- HTTPS

- riesig

- human

- wichtig

- zu unterstützen,

- Energiegewinnung

- Intelligenz

- Problem

- IT

- bekannt

- größer

- führen

- lernen

- !

- Lang

- Maschine

- Maschinelles Lernen

- MACHT

- Making

- massiv

- Modell

- für

- Geld

- vor allem warme

- Netzwerk

- netzwerkbasiert

- Netzwerke

- Anzahl

- Entwicklungsmöglichkeiten

- Oxford

- Oxford University

- Papier

- Leistung

- Potenzial

- Werkzeuge

- Prognosen

- Aufgabenstellung:

- Prozessdefinierung

- anpassen

- die

- relevant

- falls angefordert

- Forschungsprojekte

- Forscher

- Downloads

- Rückgabe

- Führen Sie

- Said

- signifikant

- Einfacher

- Größe

- So

- LÖSEN

- Geschwindigkeit

- gespalten

- Systeme und Techniken

- Durch

- heute

- heutigen

- Werkzeuge

- Ausbildung

- Uk

- Universität

- verschiedene

- Arbeiten

- trainieren

- Werk