Εικόνα από συγγραφέα

Πρόσφατα όλοι δυσκολευόμαστε πολύ να προλάβουμε τις τελευταίες εκδόσεις στον χώρο του LLM. Τις τελευταίες εβδομάδες, αρκετές εναλλακτικές λύσεις ChatGPT ανοιχτού κώδικα έχουν γίνει δημοφιλείς.

Και σε αυτό το άρθρο θα μάθουμε για το ChatGLM σειρά και ChatGLM-6B, μια ανοιχτού κώδικα και ελαφριά εναλλακτική λύση ChatGPT.

Ας ξεκινήσουμε!

Ερευνητές στο Πανεπιστήμιο Tsinghua στην Κίνα εργάστηκαν για την ανάπτυξη της σειράς μοντέλων ChatGLM που έχουν συγκρίσιμες επιδόσεις με άλλα μοντέλα όπως το GPT-3 και το BLOOM.

Το ChatGLM είναι ένα δίγλωσσο μοντέλο μεγάλης γλώσσας που εκπαιδεύεται τόσο στα κινέζικα όσο και στα αγγλικά. Επί του παρόντος, είναι διαθέσιμα τα ακόλουθα μοντέλα:

- ChatGLM-130B: ένα LLM ανοιχτού κώδικα

- ChatGLM-100B: δεν είναι ανοιχτού κώδικα, αλλά διατίθεται μέσω πρόσβασης μόνο με πρόσκληση

- ChatGLM-6B: μια ελαφριά εναλλακτική λύση ανοιχτού κώδικα

Αν και αυτά τα μοντέλα μπορεί να φαίνονται παρόμοια με την ομάδα μοντέλων μεγάλων γλωσσών Generative Pretrained Transformer (GPT), το Πλαίσιο προκατάρτισης General Language Model (GLM). είναι αυτό που τους κάνει διαφορετικούς. Θα μάθουμε περισσότερα για αυτό στην επόμενη ενότητα.

Στη μηχανική μάθηση, θα γνωρίζετε τα GLM ως γενικευμένα γραμμικά μοντέλα, αλλά το GLM στο ChatGLM σημαίνει Γενικό Γλωσσικό Μοντέλο.

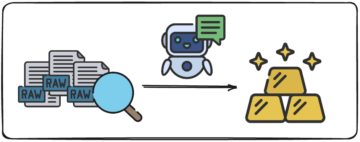

Πλαίσιο προκατάρτισης GLM

Η προεκπαίδευση LLM έχει μελετηθεί εκτενώς και εξακολουθεί να είναι ένας τομέας ενεργού έρευνας. Ας προσπαθήσουμε να κατανοήσουμε τις βασικές διαφορές μεταξύ της προεκπαίδευσης GLM και των μοντέλων τύπου GPT.

Η οικογένεια μοντέλων GPT-3 χρησιμοποιεί μοντελοποίηση γλώσσας αυτόματης παλινδρόμησης μόνο με αποκωδικοποιητή. Στο GLM, από την άλλη πλευρά, η βελτιστοποίηση του στόχου διατυπώνεται ως ένα Πρόβλημα συμπλήρωσης κενού με αυτόματη παλινδρόμηση.

GLM | Πηγή εικόνας

Με απλά λόγια, αυτόματη παλίνδρομη συμπλήρωση κενού περιλαμβάνει τη διαγραφή ενός συνεχούς εύρους κειμένου και, στη συνέχεια, τη διαδοχική ανακατασκευή του κειμένου αυτού του κενού. Εκτός από τις πιο σύντομες μάσκες, υπάρχει μια μεγαλύτερη μάσκα που αφαιρεί τυχαία μεγάλα κενά κειμένου από το τέλος των προτάσεων. Αυτό γίνεται έτσι ώστε το μοντέλο να αποδίδει αρκετά καλά στην κατανόηση φυσικής γλώσσας καθώς και σε εργασίες παραγωγής.

Μια άλλη διαφορά είναι στον τύπο της προσοχής που χρησιμοποιείται. Η ομάδα μεγάλων γλωσσικών μοντέλων GPT χρησιμοποιεί μονοκατευθυντική προσοχή, ενώ η ομάδα GLM των LLM χρησιμοποιεί αμφίδρομη προσοχή. Η χρήση αμφίδρομης προσοχής σε περιβάλλοντα χωρίς μάσκα μπορεί να αποτυπώσει καλύτερα τις εξαρτήσεις και μπορεί να βελτιώσει την απόδοση σε εργασίες κατανόησης φυσικής γλώσσας.

Ενεργοποίηση GELU

Στο GLM, χρησιμοποιείται η ενεργοποίηση GELU (Gaussian Error Linear Units) αντί για την ενεργοποίηση ReLU [1].

Ενεργοποιήσεις GELU, ReLU και ELU | Πηγή εικόνας

Η ενεργοποίηση GELU και έχει μη μηδενικές τιμές για όλες τις εισόδους και έχει την ακόλουθη μορφή [3]:

Η ενεργοποίηση GELU βρέθηκε ότι βελτιώνει την απόδοση σε σύγκριση με τις ενεργοποιήσεις ReLU, αν και υπολογιστικά πιο εντατική από το ReLU.

Στη σειρά GLM των LLM, το ChatGLM-130B που είναι ανοιχτού κώδικα και έχει καλή απόδοση όπως και το μοντέλο Da-Vinci του GPT-3. Όπως αναφέρθηκε, από τη συγγραφή αυτού του άρθρου, υπάρχει μια έκδοση ChatGLM-100B, η οποία περιορίζεται στην πρόσβαση μόνο με πρόσκληση.

ChatGLM-6B

Οι ακόλουθες λεπτομέρειες σχετικά με το ChatGLM-6B για να γίνει πιο προσιτό στους τελικούς χρήστες:

- Έχει περίπου 6.2 δισεκατομμύρια παραμέτρους.

- Το μοντέλο είναι προεκπαιδευμένο σε 1 τρισεκατομμύριο μάρκες—εξίσου από αγγλικά και κινέζικα.

- Στη συνέχεια, χρησιμοποιούνται τεχνικές όπως η εποπτευόμενη λεπτομέρεια και η ενισχυτική μάθηση με ανθρώπινη ανατροφοδότηση.

Ας ολοκληρώσουμε τη συζήτησή μας εξετάζοντας τα πλεονεκτήματα και τους περιορισμούς του ChatGLM:

Πλεονεκτήματα

Από το να είναι ένα δίγλωσσο μοντέλο σε ένα μοντέλο ανοιχτού κώδικα που μπορείτε να εκτελέσετε τοπικά, το ChatGLM-6B έχει τα ακόλουθα πλεονεκτήματα:

- Τα περισσότερα βασικά μοντέλα μεγάλων γλωσσών εκπαιδεύονται σε μεγάλα σώματα αγγλικού κειμένου και τα μεγάλα γλωσσικά μοντέλα για άλλες γλώσσες δεν είναι τόσο κοινά. Η σειρά ChatGLM των LLM είναι δίγλωσση και μια εξαιρετική επιλογή για τα κινέζικα. Το μοντέλο έχει καλές επιδόσεις τόσο στα αγγλικά όσο και στα κινέζικα.

- Το ChatGLM-6B είναι βελτιστοποιημένο για συσκευές χρήστη. Οι τελικοί χρήστες έχουν συχνά περιορισμένους υπολογιστικούς πόρους στις συσκευές τους, επομένως καθίσταται σχεδόν αδύνατο να εκτελούνται τοπικά LLM—χωρίς πρόσβαση σε GPU υψηλής απόδοσης. Με Κβαντισμός INT4, το ChatGLM-6B μπορεί να τρέξει με μέτρια απαίτηση μνήμης έως και 6 GB.

- Αποδίδει καλά σε μια ποικιλία εργασιών, συμπεριλαμβανομένων της σύνοψης και των συνομιλιών μεμονωμένων και πολλαπλών ερωτημάτων.

- Παρά τον σημαντικά μικρότερο αριθμό παραμέτρων σε σύγκριση με άλλα κύρια LLM, το ChatGLM-6B υποστηρίζει μήκος περιβάλλοντος έως και 2048.

Περιορισμοί

Στη συνέχεια, ας παραθέσουμε μερικούς περιορισμούς του ChatGLM-6B:

- Αν και το ChatGLM είναι ένα δίγλωσσο μοντέλο, η απόδοσή του στα αγγλικά είναι πιθανότατα μη βέλτιστη. Αυτό μπορεί να αποδοθεί στις οδηγίες που χρησιμοποιούνται στην προπόνηση κυρίως στα κινέζικα.

- Επειδή το ChatGLM-6B έχει ουσιαστικά λιγότερες παραμέτρους σε σύγκριση με άλλα LLM όπως το BLOOM, το GPT-3 και το ChatGLM-130B, η απόδοση μπορεί να είναι χειρότερη όταν το περιβάλλον είναι πολύ μεγάλο. Ως αποτέλεσμα, το ChatGLM-6B μπορεί να δίνει ανακριβείς πληροφορίες πιο συχνά από τα μοντέλα με μεγαλύτερο αριθμό παραμέτρων.

- Τα μικρά γλωσσικά μοντέλα έχουν περιορισμένη χωρητικότητα μνήμης. Επομένως, στις συνομιλίες πολλαπλών στροφών, η απόδοση του μοντέλου μπορεί να υποβαθμιστεί ελαφρώς.

- Η μεροληψία, η παραπληροφόρηση και η τοξικότητα είναι περιορισμοί όλων των LLM και το ChatGLM είναι επίσης ευαίσθητο σε αυτούς.

Ως επόμενο βήμα, εκτελέστε το ChatGLM-6B τοπικά ή δοκιμάστε την επίδειξη σε χώρους HuggingFace. Εάν θέλετε να εμβαθύνετε στη λειτουργία των LLMs, εδώ είναι μια λίστα με δωρεάν μαθήματα για μεγάλα γλωσσικά μοντέλα.

[1] Z Du, Y Qian et al., GLM: Γενικό Μοντέλο Γλωσσών Προεκπαίδευσης με Αυτοπαλινδρομική Συμπλήρωση κενών, ACL 2022

[2] A Zheng, X Liu et al., GLM-130B – Ένα ανοιχτό δίγλωσσο προεκπαιδευμένο μοντέλο, ICML 2023

[3] D Hendryks, K Gimpel, Γραμμικές μονάδες σφάλματος Gauss (GELU), arXiv, 2016

[4] ChatGLM-6B: Επίδειξη στο HuggingFace Spaces

[5] Repo GitHub

Bala Priya C είναι ένας τεχνικός συγγραφέας που του αρέσει να δημιουργεί περιεχόμενο μεγάλης μορφής. Οι τομείς ενδιαφέροντός της περιλαμβάνουν τα μαθηματικά, τον προγραμματισμό και την επιστήμη δεδομένων. Μοιράζεται τη μάθησή της με την κοινότητα των προγραμματιστών γράφοντας σεμινάρια, οδηγούς με οδηγίες και πολλά άλλα.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoAiStream. Web3 Data Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- Minting the Future με την Adryenn Ashley. Πρόσβαση εδώ.

- πηγή: https://www.kdnuggets.com/2023/04/chatglm6b-lightweight-opensource-chatgpt-alternative.html?utm_source=rss&utm_medium=rss&utm_campaign=chatglm-6b-a-lightweight-open-source-chatgpt-alternative

- :έχει

- :είναι

- :δεν

- $UP

- 1

- a

- Σχετικά

- πρόσβαση

- προσιτός

- Δραστηριοποίηση

- ενεργοποιήσεις

- ενεργός

- Επιπλέον

- πλεονεκτήματα

- AL

- Όλα

- εναλλακτική λύση

- εναλλακτικές λύσεις

- an

- και

- ΕΙΝΑΙ

- ΠΕΡΙΟΧΗ

- περιοχές

- άρθρο

- AS

- At

- προσοχή

- συγγραφικός

- αυτόματη

- διαθέσιμος

- BE

- γίνονται

- γίνεται

- ήταν

- είναι

- Καλύτερα

- μεταξύ

- Δισεκατομμύριο

- άνθηση

- και οι δύο

- αλλά

- by

- CAN

- πιάνω

- ChatGPT

- Κίνα

- κινέζικο

- επιλογή

- Κοινός

- κοινότητα

- συγκρίσιμος

- σύγκριση

- χρήση υπολογιστή

- περιεχόμενο

- συμφραζόμενα

- πλαίσια

- συνεχής

- μαθήματα

- δημιουργία

- Τη στιγμή

- ημερομηνία

- επιστημονικά δεδομένα

- βαθύτερη

- Διαδήλωση

- καθέκαστα

- Εργολάβος

- ανάπτυξη

- Συσκευές

- διαφορά

- διαφορές

- διαφορετικές

- συζήτηση

- γίνεται

- Ε & Τ

- τέλος

- Αγγλικά

- σφάλμα

- οικογένεια

- ανατροφοδότηση

- λίγοι

- λιγότερα

- Εξής

- Για

- μορφή

- Βρέθηκαν

- από

- General

- γενεά

- γενετική

- παίρνω

- Δώστε

- μετάβαση

- καλός

- GPU

- εξαιρετική

- Group

- Οδηγοί

- χέρι

- Σκληρά

- Έχω

- που έχει

- αυτήν

- εδώ

- υψηλή απόδοση

- HTML

- HTTPS

- Πρόσωπο αγκαλιάς

- ανθρώπινος

- if

- αδύνατος

- βελτίωση

- in

- ανακριβής

- περιλαμβάνουν

- Συμπεριλαμβανομένου

- πληροφορίες

- αντί

- οδηγίες

- τόκος

- σε

- περιλαμβάνει

- IT

- ΤΟΥ

- jpg

- KDnuggets

- Κλειδί

- Ξέρω

- Γλώσσα

- Γλώσσες

- large

- μεγαλύτερος

- Επίθετο

- αργότερο

- ΜΑΘΑΊΝΩ

- μάθηση

- Μήκος

- πυγμάχος ελαφρού βάρους

- Μου αρέσει

- Πιθανός

- περιορισμούς

- Περιωρισμένος

- Λίστα

- τοπικά

- Μακριά

- πλέον

- Χαμηλός

- μηχανή

- μάθηση μηχανής

- Mainstream

- κάνω

- ΚΑΝΕΙ

- μάσκα

- Masks

- μαθηματικά

- Ενδέχεται..

- Μνήμη

- που αναφέρθηκαν

- Κακή πληροφορία

- μοντέλο

- μοντελοποίηση

- μοντέλα

- περισσότερο

- Φυσικό

- Φυσική γλώσσα

- Φυσική κατανόηση της γλώσσας

- επόμενη

- αριθμός

- Nvidia

- σκοπός

- of

- συχνά

- on

- ανοίξτε

- ανοικτού κώδικα

- βελτιστοποίηση

- βελτιστοποιημένη

- or

- ΑΛΛΑ

- δικός μας

- έξω

- επί

- παράμετροι

- επίδοση

- εκτελεί

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- Δημοφιλής

- προ

- Προγραμματισμός

- ενίσχυση μάθησης

- Δελτία

- απαίτηση

- έρευνα

- Υποστηρικτικό υλικό

- περιορισμένος

- αποτέλεσμα

- τρέξιμο

- s

- Επιστήμη

- Τμήμα

- Σειρές

- διάφοροι

- Μερίδια

- αυτή

- παρόμοιες

- Απλούς

- ενιαίας

- μικρότερος

- So

- Χώρος

- χώρων

- σπιθαμή

- στέκεται

- Βήμα

- Ακόμη

- μελετημένος

- τέτοιος

- Σούπερ

- Υποστηρίζει

- ευαίσθητος

- εργασίες

- Τεχνικός

- τεχνικές

- όροι

- από

- ότι

- Η

- τους

- Τους

- τότε

- Εκεί.

- επομένως

- Αυτοί

- αυτό

- Μέσω

- ώρα

- προς την

- πολύ

- εκπαιδευμένο

- Εκπαίδευση

- Τρισεκατομμύριο

- Tsinghua

- tutorials

- τύπος

- καταλαβαίνω

- κατανόηση

- μονάδες

- πανεπιστήμιο

- χρήση

- μεταχειρισμένος

- Χρήστες

- Χρήστες

- χρησιμοποιώντας

- Αξίες

- ποικιλία

- εκδοχή

- Εβδ.

- ΛΟΙΠΌΝ

- Τι

- πότε

- Ποιό

- Ο ΟΠΟΊΟΣ

- με

- εργάστηκαν

- εργαζόμενος

- χειρότερος

- τυλίξτε

- συγγραφέας

- γραφή

- X

- εσείς

- zephyrnet