Εικόνα από συγγραφέα

Το XAI είναι η τεχνητή νοημοσύνη που επιτρέπει στους ανθρώπους να κατανοούν τα αποτελέσματα και τις διαδικασίες λήψης αποφάσεων του μοντέλου ή του συστήματος.

Επεξηγησιμότητα προ-μοντελοποίησης

Το εξηγήσιμο AI ξεκινά με εξηγήσιμα δεδομένα και σαφή, ερμηνεύσιμη μηχανική χαρακτηριστικών.

Επεξήγηση μοντελοποίησης

Όταν επιλέγετε ένα μοντέλο για ένα συγκεκριμένο πρόβλημα, είναι γενικά καλύτερο να χρησιμοποιείτε το πιο ερμηνεύσιμο μοντέλο που εξακολουθεί να επιτυγχάνει καλά προγνωστικά αποτελέσματα.

Επεξηγησιμότητα μετά το μοντέλο

Αυτό περιλαμβάνει τεχνικές όπως η διαταραχή, όπου αναλύεται η επίδραση της αλλαγής μιας μεμονωμένης μεταβλητής στην έξοδο του μοντέλου, όπως οι τιμές SHAP για μετά την προπόνηση.

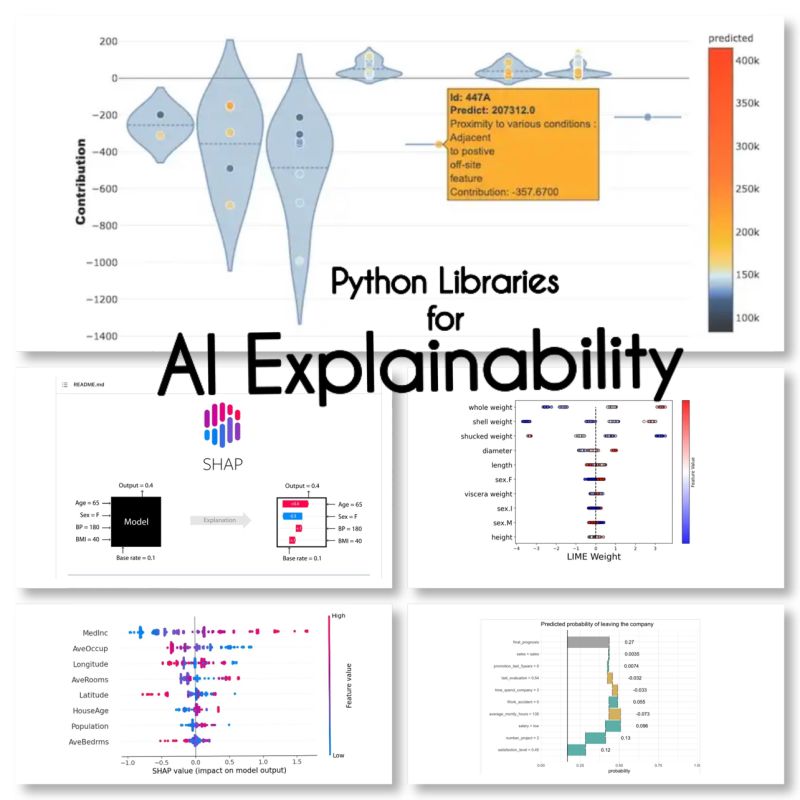

Βρήκα αυτές τις 10 βιβλιοθήκες Python για επεξήγηση AI:

SHAP (Shapley Additive Explanations)

Το SHAP είναι ένα μοντέλο αγνωστικιστής και λειτουργεί αναλύοντας τη συμβολή κάθε χαρακτηριστικού και αποδίδοντας μια βαθμολογία σε κάθε χαρακτηριστικό.

LIME (Τοπικό ερμηνευτικό μοντέλο-αγνωστικές επεξηγήσεις)

Το LIME είναι μια άλλη αγνωστική μέθοδος μοντέλου που λειτουργεί προσεγγίζοντας τη συμπεριφορά του μοντέλου τοπικά γύρω από μια συγκεκριμένη πρόβλεψη.

ELi5

Το Eli5 είναι μια βιβλιοθήκη για εντοπισμό σφαλμάτων και επεξήγηση ταξινομητών. Παρέχει βαθμολογίες σπουδαιότητας χαρακτηριστικών, καθώς και «κωδικούς λόγους» για scikit-learn, Keras, xgboost, LightGBM, CatBoost.

Shapash

Το Shapash είναι μια βιβλιοθήκη Python που στοχεύει να κάνει τη μηχανική μάθηση ερμηνεύσιμη και κατανοητή σε όλους. Το Shapash παρέχει διάφορους τύπους οπτικοποίησης με σαφείς ετικέτες.

Άγκυρες

Τα Anchors είναι μια μέθοδος για τη δημιουργία κανόνων που μπορούν να ερμηνευτούν από τον άνθρωπο που μπορούν να χρησιμοποιηθούν για να εξηγήσουν τις προβλέψεις ενός μοντέλου μηχανικής μάθησης.

XAI (Εξήγηση AI)

Το XAI είναι μια βιβλιοθήκη για την επεξήγηση και την οπτικοποίηση των προβλέψεων των μοντέλων μηχανικής μάθησης, συμπεριλαμβανομένων των βαθμολογιών σημασίας χαρακτηριστικών.

Επαθε βλάβη

Το BreakDown είναι ένα εργαλείο που μπορεί να χρησιμοποιηθεί για να εξηγήσει τις προβλέψεις γραμμικών μοντέλων. Λειτουργεί αποσυνθέτοντας την έξοδο του μοντέλου στη συνεισφορά κάθε χαρακτηριστικού εισόδου.

ερμηνεύω-κείμενο

Το interpret-text είναι μια βιβλιοθήκη για την εξήγηση των προβλέψεων των μοντέλων επεξεργασίας φυσικής γλώσσας.

iml (Ερμηνευόμενη Μηχανική Εκμάθηση)

Το iml περιέχει επί του παρόντος τη διεπαφή και τον κώδικα IO από το έργο Shap, και ενδεχομένως θα κάνει το ίδιο και για το έργο Lime.

aix360 (AI Explainability 360)

Το aix360 περιλαμβάνει ένα ολοκληρωμένο σύνολο αλγορίθμων που καλύπτουν διαφορετικές διαστάσεις

OmniXAI

Το OmniXAI (συντομογραφία του Omni eXplainable AI), αντιμετωπίζει αρκετά προβλήματα με την ερμηνεία των κρίσεων που παράγονται από μοντέλα μηχανικής μάθησης στην πράξη.

Έχω ξεχάσει καμιά βιβλιοθήκη;

Πηγές

Maryam Miradi είναι επικεφαλής της AI και της Επιστήμης Δεδομένων με διδακτορικό στη Μηχανική Μάθηση και τη Βαθιά Εκμάθηση, με εξειδίκευση στο NLP και στο Computer Vision. Έχει 15+ χρόνια εμπειρίας στη δημιουργία επιτυχημένων λύσεων AI με ιστορικό παράδοσης πάνω από 40 επιτυχημένων έργων. Έχει εργαστεί για 12 διαφορετικούς οργανισμούς σε ποικίλους κλάδους, όπως η Ανίχνευση Οικονομικού Εγκλήματος, η Ενέργεια, οι Τράπεζες, το Λιανικό εμπόριο, το ηλεκτρονικό εμπόριο και η κυβέρνηση.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- Platoblockchain. Web3 Metaverse Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- πηγή: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- διευθύνσεις

- Μετά το

- AI

- στόχοι

- αλγόριθμοι

- επιτρέπει

- και

- Άλλος

- γύρω

- τεχνητός

- τεχνητή νοημοσύνη

- Τράπεζες

- ΚΑΛΎΤΕΡΟΣ

- Σπάζοντας

- αλλαγή

- επιλέγοντας

- καθαρός

- κωδικός

- περιεκτικός

- υπολογιστή

- Computer Vision

- Περιέχει

- συμβολή

- κάλυμμα

- δημιουργία

- Έγκλημα

- Τη στιγμή

- ημερομηνία

- επιστημονικά δεδομένα

- Λήψη Αποφάσεων

- αποφάσεις

- βαθύς

- βαθιά μάθηση

- παράδοση

- διαφορετικές

- κάτω

- e-commerce

- κάθε

- αποτέλεσμα

- ενέργεια

- Μηχανική

- όλοι

- εμπειρία

- Εξηγήστε

- Επεξήγηση

- Επεξήγηση AI

- εξηγώντας

- Χαρακτηριστικό

- οικονομικός

- οικονομικό-έγκλημα

- ξεχασμένος

- Βρέθηκαν

- από

- γενικά

- παραγωγής

- καλός

- Κυβέρνηση

- HTTPS

- Οι άνθρωποι

- σπουδαιότητα

- in

- περιλαμβάνει

- Συμπεριλαμβανομένου

- βιομηχανίες

- εισαγωγή

- Νοημοσύνη

- περιβάλλον λειτουργίας

- IT

- κρίσεις

- KDnuggets

- keras

- Ετικέτες

- Γλώσσα

- οδηγήσει

- μάθηση

- βιβλιοθήκες

- Βιβλιοθήκη

- Άσβεστος

- τοπικός

- τοπικά

- μηχανή

- μάθηση μηχανής

- κάνω

- μέθοδος

- μοντέλο

- μοντέλα

- πλέον

- Φυσικό

- Φυσική γλώσσα

- Επεξεργασία φυσικής γλώσσας

- nlp

- Omni

- Οργανισμοί

- Ειδικότερα

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- ενδεχομένως

- πρακτική

- πρόβλεψη

- Προβλέψεις

- Πρόβλημα

- προβλήματα

- Διεργασίες

- μεταποίηση

- Παράγεται

- σχέδιο

- έργα

- παρέχει

- Python

- λόγος

- ρεκόρ

- Αποτελέσματα

- λιανική πώληση

- κανόνες

- ίδιο

- Επιστήμη

- scikit-μάθετε

- σειρά

- διάφοροι

- Κοντά

- ενιαίας

- Λύσεις

- ειδικευμένος

- συγκεκριμένες

- ξεκινά

- Ακόμη

- επιτυχής

- τέτοιος

- σύστημα

- τεχνικές

- Η

- προς την

- εργαλείο

- τροχιά

- Εκπαίδευση

- τύποι

- καταλαβαίνω

- κατανοητός

- χρήση

- Αξίες

- ποικιλία

- όραμα

- οραματισμός

- Ποιό

- θα

- εργάστηκαν

- λειτουργεί

- XGBoost

- χρόνια

- Σας

- zephyrnet