Imagen del autor

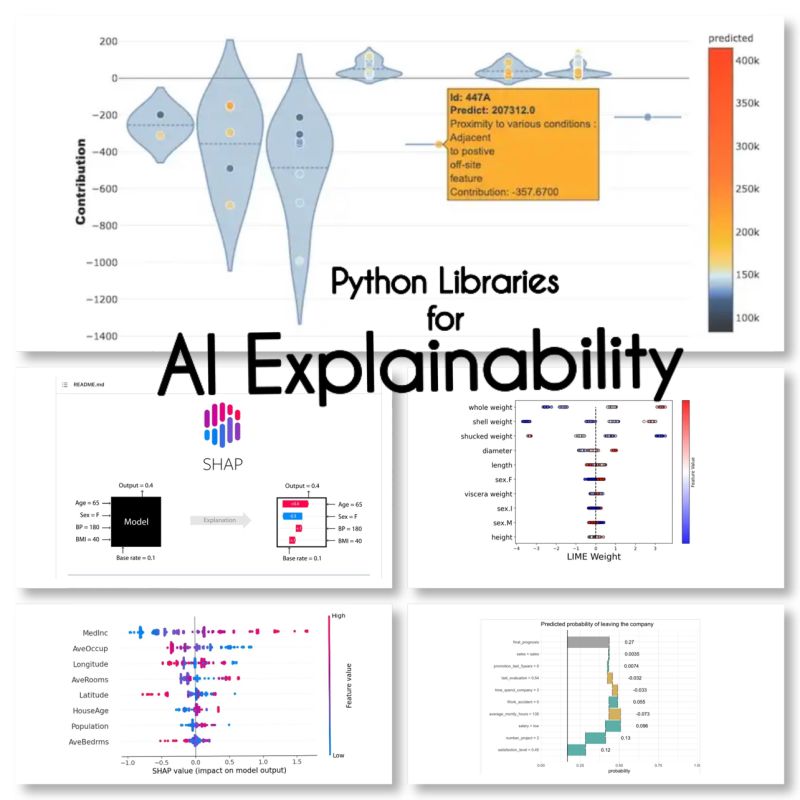

XAI es inteligencia artificial que permite a los humanos comprender los resultados y los procesos de toma de decisiones del modelo o sistema.

Pre-modelado Explicabilidad

La IA explicable comienza con datos explicables e ingeniería de funciones clara e interpretable.

Explicabilidad del modelado

Al elegir un modelo para un problema en particular, generalmente es mejor usar el modelo más interpretable que aún logre buenos resultados predictivos.

Explicabilidad posterior al modelo

Esto incluye técnicas como la perturbación, donde se analiza el efecto de cambiar una sola variable en la salida del modelo, como los valores SHAP para después del entrenamiento.

Encontré estas 10 bibliotecas de Python para la explicabilidad de la IA:

SHAP (explicaciones del aditivo SHapley)

SHAP es un modelo agnóstico y funciona desglosando la contribución de cada función y atribuyendo una puntuación a cada función.

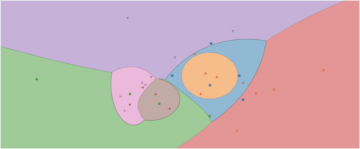

LIME (Explicaciones locales interpretables agnósticas del modelo)

LIME es otro método agnóstico del modelo que funciona aproximando el comportamiento del modelo localmente en torno a una predicción específica.

ELi5

Eli5 es una biblioteca para depurar y explicar clasificadores. Proporciona puntajes de importancia de características, así como "códigos de razón" para scikit-learn, Keras, xgboost, LightGBM, CatBoost.

Shapash

Shapash es una biblioteca de Python que tiene como objetivo hacer que el aprendizaje automático sea interpretable y comprensible para todos. Shapash proporciona varios tipos de visualización con etiquetas explícitas.

anclas

Anchors es un método para generar reglas interpretables por humanos que se pueden usar para explicar las predicciones de un modelo de aprendizaje automático.

XAI (IA explicable)

XAI es una biblioteca para explicar y visualizar las predicciones de los modelos de aprendizaje automático, incluidas las puntuaciones de importancia de las características.

Desglose

BreakDown es una herramienta que se puede utilizar para explicar las predicciones de los modelos lineales. Funciona descomponiendo la salida del modelo en la contribución de cada característica de entrada.

interpretar-texto

interpret-text es una biblioteca para explicar las predicciones de los modelos de procesamiento del lenguaje natural.

iml (aprendizaje automático interpretable)

iml actualmente contiene la interfaz y el código IO del proyecto Shap, y potencialmente también hará lo mismo para el proyecto Lime.

aix360 (Explicabilidad de IA 360)

aix360 incluye un conjunto completo de algoritmos que cubren diferentes dimensiones

OmniXAI

OmniXAI (abreviatura de Omni eXplainable AI) aborda varios problemas con la interpretación de juicios producidos por modelos de aprendizaje automático en la práctica.

¿Me he olvidado de alguna biblioteca?

Fuentes

Maryam Miradi es líder en inteligencia artificial y ciencia de datos con un doctorado en aprendizaje automático y aprendizaje profundo, especializado en PNL y visión artificial. Tiene más de 15 años de experiencia en la creación de soluciones de IA exitosas con un historial de entrega de más de 40 proyectos exitosos. Ha trabajado para 12 organizaciones diferentes en una variedad de industrias, incluida la detección de delitos financieros, energía, banca, comercio minorista, comercio electrónico y gobierno.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- direcciones

- Después

- AI

- paquete de capacitación DWoVH

- algoritmos

- permite

- y

- Otra

- en torno a

- artificial

- inteligencia artificial

- Bancario

- MEJOR

- Ruptura

- cambio

- la elección de

- limpiar

- código

- exhaustivo

- computadora

- Visión por computador

- contiene

- contribución

- Protectora

- Creamos

- Delito

- En la actualidad

- datos

- Ciencia de los datos

- Toma de Decisiones

- decisiones

- profundo

- deep learning

- entregar

- una experiencia diferente

- DE INSCRIPCIÓN

- comercio electrónico

- cada una

- efecto

- energía

- Ingeniería

- todos

- experience

- Explicar

- Explicabilidad

- IA explicable

- explicando

- Feature

- financiero

- delitos financieros

- olvidado

- encontrado

- Desde

- en general

- la generación de

- candidato

- Gobierno

- HTTPS

- Humanos

- importancia

- in

- incluye

- Incluye

- industrias

- Las opciones de entrada

- Intelligence

- Interfaz

- IT

- juicios

- nuggets

- keras

- Etiquetas

- idioma

- Lead

- aprendizaje

- bibliotecas

- Biblioteca

- Limón

- Etiqueta LinkedIn

- local

- localmente

- máquina

- máquina de aprendizaje

- para lograr

- Método

- modelo

- modelos

- MEJOR DE TU

- Natural

- Lenguaje natural

- Procesamiento natural del lenguaje

- nlp

- Omni

- Organización

- particular

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- la posibilidad

- predicción

- Predicciones

- Problema

- problemas

- en costes

- tratamiento

- producido

- proyecto

- proyecta

- proporciona un

- Python

- razón

- grabar

- Resultados

- el comercio minorista

- reglas

- mismo

- Ciencia:

- scikit-aprender

- set

- Varios

- En Corto

- soltero

- Soluciones

- especializado

- soluciones y

- comienza

- Sin embargo

- exitosos

- tal

- te

- técnicas

- El

- a

- del IRS

- seguir

- Formación

- tipos

- entender

- comprensible

- utilizan el

- Valores

- variedad

- visión

- visualización

- que

- seguirá

- trabajado

- funciona

- XGBoost

- años

- tú

- zephyrnet