Comentario Los esfuerzos de Apple por agregar IA generativa a sus iDevices no deberían sorprender a nadie, pero los usos actuales de la tecnología por parte de Cupertino y las limitaciones del hardware móvil sugieren que no será una característica importante de iOS en el futuro cercano.

Apple no se ha sumado a la reciente ola de impulso a la IA generativa, e incluso ha evitado en general los términos “IA” o “Inteligencia Artificial” en sus recientes presentaciones magistrales en comparación con muchas empresas. Sin embargo, el aprendizaje automático ha sido, y sigue siendo, una capacidad clave para Apple, principalmente en segundo plano, al servicio de mejoras sutiles en la experiencia del usuario.

El uso de IA por parte de Apple para manejar imágenes es un ejemplo de la tecnología que funciona en segundo plano. Cuando iThings captura fotografías, los algoritmos de aprendizaje automático se ponen a trabajar para identificar y etiquetar sujetos, ejecutar reconocimiento óptico de caracteres y agregar enlaces.

En 2024, ese tipo de IA invisible no es suficiente. Los rivales de Apple están promocionando la IA generativa como una capacidad esencial para cada dispositivo y aplicación. Según un reciente Financial Times reporte, Apple ha estado comprando silenciosamente empresas de inteligencia artificial y desarrollando sus propios modelos de lenguaje de gran tamaño para asegurarse de poder cumplir.

La ventaja del hardware de Apple

Las unidades de procesamiento neuronal (NPU) en el silicio casero de Apple manejan sus implementaciones de IA existentes. Apple ha empleado los aceleradores, a los que denomina "motores neuronales" desde el debut del sistema en chip A2017 de 11 y los utiliza para manejar cargas de trabajo de aprendizaje automático más pequeñas para liberar la CPU y la GPU de un dispositivo para otras tareas.

Las NPU de Apple son particularmente poderosas. El A17 Pro que se encuentra en el iPhone 15 Pro es capaz de alcanzar 35 TOPS, el doble que su predecesor, y aproximadamente el doble de eso de algunas NPU que Intel y AMD ofrecen para su uso en PC.

Los últimos chips Snapdragon de Qualcomm están a la altura de los de Apple en términos de rendimiento de NPU. Al igual que Apple, Qualcomm también tiene años de experiencia en NPU en dispositivos móviles. AMD e Intel son relativamente nuevos en el campo.

Apple no ha compartido el rendimiento de punto flotante o entero para la GPU del chip, aunque ha promocionado su destreza al ejecutar juegos, como Resident Evil 4 Remake y Assassin's Creed Mirage. Esto sugiere que la potencia computacional no es el factor limitante para ejecutar modelos de IA más grandes en la plataforma.

Esto se ve respaldado por el hecho de que el silicio de la serie M de Apple, utilizado en sus líneas Mac y iPad, ha demostrado ser particularmente potente para ejecutar cargas de trabajo de inferencia de IA. En nuestras pruebas, con la memoria adecuada (tuvimos problemas con menos de 16 GB), una Macbook Air M1 que ahora tiene tres años era más que capaz de ejecutar Llama 2 7B con una precisión de 8 bits y era aún más ágil con una memoria de 4 bits. versión cuantificada del modelo. Por cierto, si quieres probar esto en tu Mac M1, Ollama.ai hace que ejecutar Llama 2 sea muy sencillo.

Donde Apple puede verse obligada a hacer concesiones de hardware es en la memoria.

En términos generales, los modelos de IA necesitan alrededor de un gigabyte de memoria por cada mil millones de parámetros, cuando se ejecutan con una precisión de 8 bits. Esto se puede reducir a la mitad bajando a una precisión más baja, algo como Int-4, o desarrollando modelos cuantificados más pequeños.

Llama 2 7B se ha convertido en un punto de referencia común para PC y teléfonos inteligentes con IA debido a su tamaño relativamente pequeño y sus requisitos de cálculo cuando se ejecutan lotes pequeños. Utilizando la cuantificación de 4 bits, los requisitos del modelo se pueden reducir a 3.5 GB.

Pero incluso con 8 GB de RAM en el iPhone 15 Pro, sospechamos que la próxima generación de teléfonos de Apple puede necesitar más memoria, o que los modelos tendrán que ser más pequeños y específicos. Esta es probablemente una de las razones por las que Apple está optando por desarrollar sus propios modelos en lugar de cooptar modelos como Stable Diffusion o Llama 2 para ejecutarse en Int-4, como hemos visto en Qualcomm.

También hay alguna evidencia que sugiere que Apple puede haber encontrado una manera de solucionar el problema de la memoria. Como lo detectó el Financial Times, en diciembre, los investigadores de Apple publicaron [(PDF)] un artículo que demuestra la capacidad de ejecutar LLM en un dispositivo utilizando memoria flash.

Espere un enfoque más conservador hacia la IA

Cuando Apple introduzca la funcionalidad de IA en sus plataformas móviles y de escritorio, esperamos que adopte un enfoque relativamente conservador.

Convertir a Siri en algo que la gente no necesita hablar como si fuera un niño en edad preescolar parece un lugar obvio para comenzar. Hacer eso podría significar darle a un LLM la tarea de analizar la información en un formulario que Siri pueda entender más fácilmente, para que el robot pueda ofrecer mejores respuestas.

Siri podría confundirse menos fácilmente si formula una consulta de manera indirecta, lo que resulta en respuestas más efectivas.

En teoría, esto debería tener un par de beneficios. El primero es que Apple debería poder salirse con la suya utilizando un modelo mucho más pequeño que algo como Llama 2. El segundo, es que debería evitar en gran medida el problema de que el LLM produzca respuestas erróneas.

Podríamos estar equivocados, pero Apple tiene un historial de llegar tarde a implementar las últimas tecnologías, pero luego encuentra el éxito donde otros han fracasado al tomarse el tiempo para refinar y pulir las funciones hasta que sean realmente útiles.

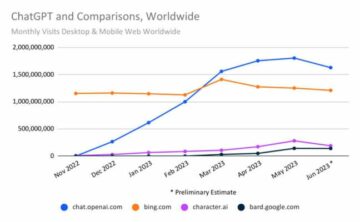

Y por lo que vale, la IA generativa aún tiene que demostrar que es un éxito: la gran apuesta del chatbot de Microsoft para darle vida al motor de búsqueda Bing, el favorito de nadie. no ha traducido en un importante aumento de cuota de mercado.

Apple, mientras tanto, se llevó la corona como 2024 proveedor superior de teléfonos inteligentes mientras despliega solo IA invisible. ®

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://go.theregister.com/feed/www.theregister.com/2024/01/25/apple_generative_ai/

- :posee

- :es

- :no

- :dónde

- $ UP

- 15%

- 2024

- 35%

- 8

- a

- capacidad

- Poder

- Nuestra Empresa

- aceleradores

- Conforme

- add

- la adición de

- AI

- Modelos AI

- AIRE

- algoritmos

- también

- Aunque

- AMD

- an

- y

- respuestas

- nadie

- Apple

- Aplicación

- enfoque

- somos

- en torno a

- artificial

- inteligencia artificial

- AS

- asesino

- At

- evitar

- evitar

- lejos

- Atrás

- fondo

- BE

- a las que has recomendado

- esto

- "Ser"

- beneficios

- Bet

- mejores

- Big

- más grande

- mil millones

- Bing

- Bot

- RESPIRAR

- brisa

- negocios

- pero

- Comprar

- by

- PUEDEN

- capacidad

- capaz

- capturar

- personaje

- reconocimiento de caracteres

- chatterbot

- sus hijos

- chip

- Papas fritas

- CO

- Algunos

- Empresas

- en comparación con

- cálculo

- computational

- potencia de cálculo

- concesiones

- confundido

- Conservador

- restricciones

- continúa

- podría

- Parejas

- CPU

- corona

- Corte

- debut

- Diciembre

- entregamos

- vas demostrando

- Desplegando

- computadora de escritorio

- desarrollar

- el desarrollo

- dispositivo

- Dispositivos

- Difusión

- sí

- No

- "Hacer"

- don

- doble

- Dejar caer

- dos

- pasan fácilmente

- Eficaz

- esfuerzos

- ya sea

- empleado

- Motor

- garantizar

- esencial

- Incluso

- Cada

- evidencia sólida

- ejemplo

- existente

- experience

- hecho

- factor

- Fallidos

- Favoritos

- Feature

- Caracteristicas

- sentir

- campo

- la búsqueda de

- Nombre

- Flash

- flotante

- Footprint

- forzado

- formulario

- encontrado

- Gratuito

- Desde

- FT

- a la fatiga

- futuras

- Juegos

- Gen

- en general

- generativo

- IA generativa

- obtener

- dado

- Diezmos y Ofrendas

- Go

- GPU

- cortado por la mitad

- encargarse de

- Materiales

- Tienen

- Golpear

- HTTPS

- Identifique

- if

- imágenes

- implementar

- implementaciones

- mejoras

- in

- aumente

- Las opciones de entrada

- Intel

- Intelligence

- dentro

- introducir

- invisible

- iOS

- iPad

- iPhone

- ISN

- IT

- SUS

- Trabajos

- se unió a

- jpg

- Clave

- Notas clave

- Presentaciones magistrales

- Label

- idioma

- large

- principalmente

- Tarde

- más reciente

- aprendizaje

- menos

- Vida

- como

- que otros

- limitar

- líneas

- enlaces

- Llama

- inferior

- Mac

- macbook

- máquina

- máquina de aprendizaje

- gran

- para lograr

- HACE

- muchos

- Mercado

- cuota de mercado

- Puede..

- personalizado

- Mientras tanto

- Salud Cerebral

- Microsoft

- menor de edad

- Mirage

- Móvil

- dispositivos móviles

- modelo

- modelos

- más,

- cuales son las que reflejan

- mucho más

- Cerca

- ¿ Necesita ayuda

- Nuevo

- Next

- próxima generación

- no

- ahora

- obvio

- of

- LANZAMIENTO

- on

- ONE

- , solamente

- óptico

- reconocimiento óptico de caracteres

- optando

- or

- Otro

- Otros

- nuestros

- EL DESARROLLADOR

- Papel

- parámetros

- particularmente

- PCs

- (PDF)

- actuación

- móviles

- Fotos

- Colocar

- plataforma

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- punto

- Polaco

- intenso

- industria

- poderoso

- Precisión

- predecesor

- Presentations

- Pro

- Problema

- tratamiento

- productor

- Demostrar.

- probado

- valor

- publicado

- Emprendedor

- Qualcomm

- tranquilamente

- RAM

- más bien

- realmente

- razones

- reciente

- reconocimiento

- grabar

- referencia

- FILTRO

- relativamente

- Requisitos

- investigadores

- Resident Evil 4

- respuestas

- resultante

- Derecho

- rivales

- Ejecutar

- correr

- s

- Buscar

- motor de búsqueda

- Segundo

- parece

- visto

- de coches

- Compartir

- compartido

- tienes

- Silicio

- desde

- sirio

- tamaños

- chica

- menores

- teléfono inteligente

- teléfonos inteligentes

- Boca de dragón

- So

- algo

- algo

- hablar

- habla

- estable

- comienzo

- comercial

- sugieren

- Sugiere

- Apoyar

- sorpresa

- sorprendido

- T

- ETIQUETA

- ¡Prepárate!

- toma

- afectados

- tecnología

- Tecnologías

- Tecnología

- términos

- Pruebas

- que

- esa

- El proyecto

- Les

- luego

- teoría

- Ahí.

- ellos

- así

- equipo

- a

- se

- Tops

- promocionado

- seguir

- Historial

- problema

- try

- entender

- unidades que

- hasta

- utilizan el

- usado

- eficiente

- Usuario

- experiencia como usuario

- usos

- usando

- Ve

- versión

- quieres

- fue

- Trenzado

- Camino..

- we

- ¿

- cuando

- que

- mientras

- seguirá

- Actividades:

- valor

- Mal

- años

- aún

- Usted

- tú

- zephyrnet