Comentario Se han producido más de 250 tiroteos masivos en EE. UU. en lo que va del año, y los defensores de la IA creen que tienen la solución. No es control de armas, sino mejor tecnología, como era de esperar.

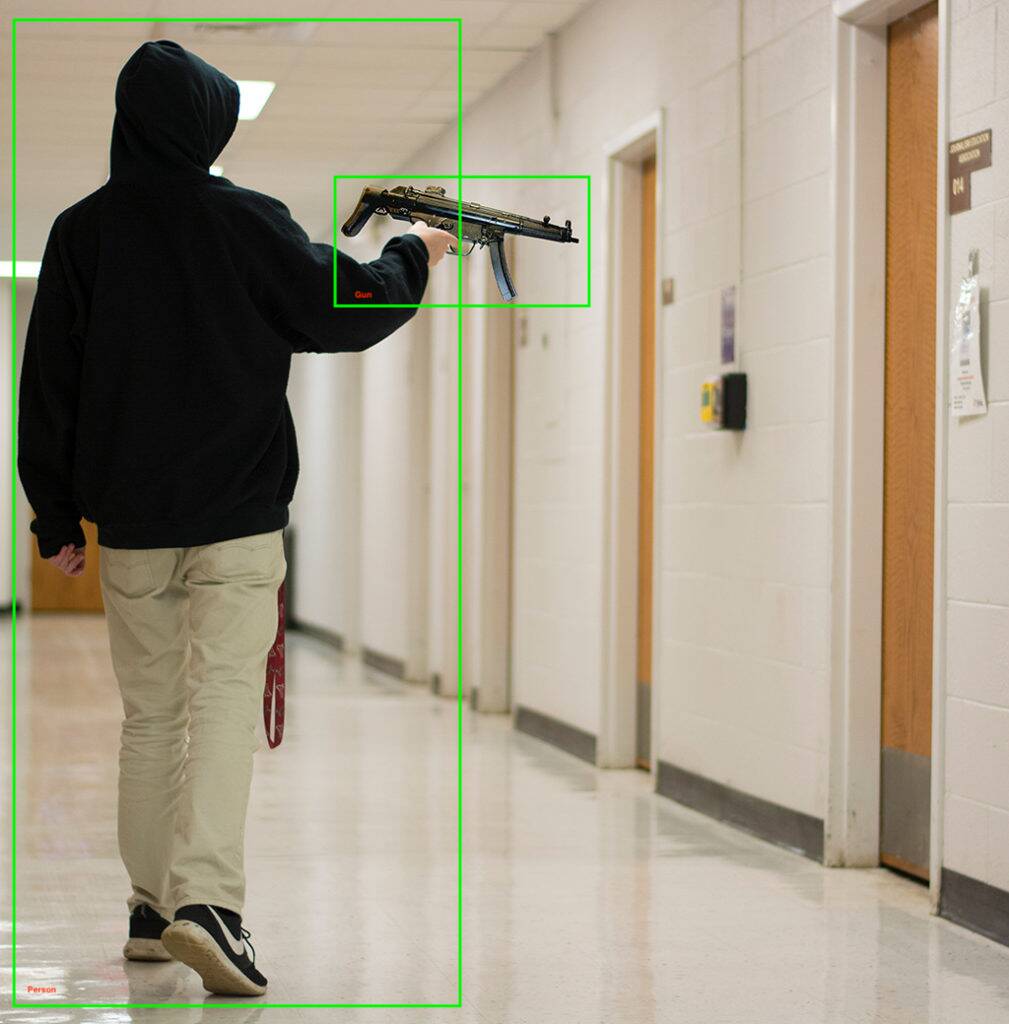

El negocio de aprendizaje automático Kogniz anunció el martes que estaba agregando un software listo para implementar modelo de detección de armas a su plataforma de visión artificial. Se nos dice que el sistema puede detectar armas vistas por cámaras de seguridad y enviar notificaciones a quienes están en riesgo, notificando a la policía, cerrando edificios y realizando otras tareas de seguridad.

Además de detectar armas de fuego, Kogniz usa sus otros módulos de visión por computadora para detectar comportamientos inusuales, como niños corriendo por los pasillos o alguien trepando por una ventana, lo que podría indicar un tirador activo.

Si se pregunta acerca de la tasa de errores o falsos positivos del código, Kogniz dice que tiene una "IA de varias pasadas" y "un equipo capacitado de verificadores humanos" que verifican los resultados de su software de detección. O le da la bienvenida a ese nivel adicional de confirmación, o lo ve como una tecnología que potencialmente recurre a los humanos justo cuando más se necesitan las computadoras.

“[Nuestra solución es] hacer que sea mucho más fácil para las empresas, las agencias gubernamentales, las escuelas y los hospitales prepararse y luego ayudar a reducir el daño causado por un tiroteo activo”, dijo el director ejecutivo de Kogniz, Daniel Putterman.

Kogniz no es la primera compañía de visión por computadora en ingresar al juego del reconocimiento de armas: hay una lista considerable de compañías que implementan tecnología similar y algunas, como ZeroEyes, se especializan en nada más que detección de armas de fuego.

“Al distribuir su atención en múltiples ofertas, los desarrolladores tienen menos capacidad para brindar el mejor servicio en detección de armas”, dijo ZeroEyes en un comunicado. del blog. La tecnología de ZeroEyes se ha implementado en escuelas en 14 estados, incluidos High School secundaria de Oxford en el área metropolitana de Detroit, donde un tirador de 15 años mató a cuatro e hirió a siete el año pasado.

Otros proveedores, como Defendry, que tiene un paquete de seguridad que incluye una aplicación de botón de pánico, sensores de disparo de audio, drones de primeros auxilios y detección de armas AI; y Omnilert, se encuentran en este mercado de crecimiento deprimente. Otras compañías en el campo de detección de armas de IA incluyen Arcarith, Athena Securities y Scylla.

¿Hay realmente suficiente tiempo?

En 2019, la respuesta policial a un tiroteo masivo en Dayton, Ohio, fue de solo 32 segundos, tiempo durante el cual murieron nueve personas. Un tiroteo de 2021 en una instalación de FedEx en Indianápolis que mató a nueve personas también terminó antes de que llegara la policía, aunque lo hicieron en solo minutos.

Ambos casos plantean la cuestión de si la detección de armas de IA puede reducir los tiempos de respuesta lo suficiente como para salvar vidas. Particularmente si los oficiales están demasiado asustados o deciden no responder, como en el asesinato en masa en Uvalde.

Se han propuesto varios otros métodos de prevención de tiroteos masivos basados en IA, como armas inteligentes que no dispararán si detectan un objetivo humano. Otros han propuesto capacitar a las IA con datos de tiroteos anteriores, compras locales de armas y datos socioeconómicos para encontrar tendencias indicativas de un tiroteo planeado, así como escanear las redes sociales en busca de indicadores similares.

También hay Sesgo AI, problema bien documentado que incluso conjuntos de datos diversos y entrenamiento equilibrado parece que no puede resolver. Tomemos como ejemplo una implementación en 2020 de tecnología de reconocimiento facial y de armas en un distrito escolar de Nueva York: los correos electrónicos entre el distrito escolar y la empresa que implementó el sistema muestran inquietudes al respecto. identificando erróneamente cosas, como palos de escoba para pistolas.

En declaraciones a la publicación de Utah Deseret News, el analista senior de políticas de la ACLU Jay Stanley dijo le preocupaba que los sistemas de visión por computadora pudieran conducir a un mundo “donde las personas evitan hacer algo tan simple como saltar por la acera por temor a activar los detectores de anomalías y ser interrogados por la policía”.

Sin embargo, un posible uso de la IA podría ser más prometedor: un 2018 estudio del Cincinnati Children's Hospital Medical Center descubrió que el análisis de IA de las sesiones de terapia coincidía con las evaluaciones de peligro de los psiquiatras y consejeros el 91 por ciento de las veces. La adición de datos demográficos y socioeconómicos solo mejoró los resultados en la identificación de jóvenes que estaban en riesgo de cometer un acto violento.

Con tantas complicaciones potenciales, ¿el aprendizaje automático está realmente listo para prevenir asesinatos en masa?

La violencia armada es la asesino número uno de niños y adolescentes en Estados Unidos, cobrando un promedio de 12 vidas jóvenes y lesionando a 32 más, cada día. La IA puede ayudar, pero sin abordar sus deficiencias, quizás también se necesiten enfoques menos tecnológicos. Una atención de salud mental más sólida y más ampliamente disponible podría ser un buen comienzo.

A principios de este mes, el presidente Biden , que son para, entre otras cosas, una prohibición de armas de asalto, verificaciones de antecedentes ampliadas y límites en la capacidad de la revista, a lo que llamó "medidas racionales y de sentido común". ®

- AI

- arte ai

- generador de arte ai

- robot ai

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- El registro

- zephyrnet