El aprendizaje automático (ML) se ha convertido en una de las técnicas de inteligencia artificial más utilizadas por varias empresas, instituciones e individuos que se dedican al negocio de la automatización. Esto se debe a las mejoras considerables en el acceso a los datos y al aumento de la potencia computacional, que permiten a los profesionales lograr resultados significativos en varias áreas.

Hoy en día, cuando se trata de datos de imágenes, los algoritmos ML pueden interpretar las imágenes de la misma manera que lo hacen nuestros cerebros. Estos se utilizan en casi todas partes, desde el reconocimiento facial mientras capturamos imágenes en nuestros teléfonos inteligentes, automatizando el tedioso trabajo manual, los autos autónomos y todo lo demás.

En este blog, profundizaremos en los fundamentos del procesamiento de imágenes de aprendizaje automático y discutiremos varias tecnologías que podríamos aprovechar para construir algoritmos de vanguardia en datos de imágenes.

- ¿Qué es el procesamiento de imágenes y por qué es importante?

- Trabajo del procesamiento de imágenes de aprendizaje automático

- Bibliotecas y marcos para el procesamiento de imágenes de aprendizaje automático

- Redes neuronales profundas en imágenes

- Conclusión

¿Qué es el procesamiento de imágenes y por qué es importante?

El procesamiento de imágenes (IP) es una tecnología informática aplicada a las imágenes que nos ayuda a procesar, analizar y extraer información útil de ellas.

Se encuentra entre las tecnologías de rápido crecimiento y ha evolucionado ampliamente a lo largo de los años. Hoy en día, varias empresas y organizaciones de diferentes sectores utilizan el procesamiento de imágenes para varias aplicaciones como visualización, extracción de información de imágenes, reconocimiento de patrones, clasificación, segmentación y muchas más.

Principalmente, existen dos métodos para el procesamiento de imágenes: procesamiento de imágenes analógico y digital. El método de IP analógica se aplica a copias impresas, como fotografías escaneadas e impresiones, y las salidas aquí suelen ser imágenes. En comparación, la IP digital se utiliza para manipular imágenes digitales mediante el uso de computadoras; las salidas aquí suelen ser información relacionada con esa imagen, como datos sobre funciones, características, cuadros delimitadores o máscaras.

Como se discutió con Machine Learning y Deep Learning, las técnicas de procesamiento de imágenes pueden volverse más poderosas.

A continuación, se muestran algunos casos de uso familiares que aprovechan las técnicas de procesamiento de imágenes de AA:

- Imágenes / visualización médicas: Ayude a los profesionales médicos a interpretar las imágenes médicas y diagnosticar anomalías más rápidamente.

- Aplicación de la ley y seguridad: Ayuda en vigilancia y autenticación biométrica.

- Tecnología de conducción autónoma: Ayuda a detectar objetos e imitar señales e interacciones visuales humanas.

- Gaming: Mejora de las experiencias de juego de realidad aumentada y realidad virtual.

- Restauración y nitidez de imágenes: Mejore la calidad de las imágenes o agregue filtros populares, etc.

- Reconocimiento de patrones: Clasificar y reconocer objetos / patrones en imágenes y comprender información contextual.Recuperación de imágenes: Reconoce imágenes para una recuperación más rápida de grandes conjuntos de datos.

En la siguiente sección, aprenderemos algunos de los fundamentos detrás del procesamiento de imágenes de aprendizaje automático.

Trabajo del procesamiento de imágenes de aprendizaje automático

Por lo general, los algoritmos de aprendizaje automático tienen una canalización o pasos específicos para aprender de los datos. Tomemos un ejemplo genérico del mismo y modelemos un algoritmo de trabajo para un caso de uso de procesamiento de imágenes.

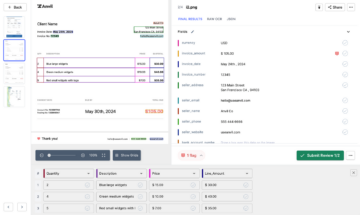

En primer lugar, los algoritmos ML necesitan una cantidad considerable de datos de alta calidad para aprender y predecir resultados altamente precisos. Por lo tanto, tendremos que asegurarnos de que las imágenes estén bien procesadas, anotadas y sean genéricas para el procesamiento de imágenes ML. Aquí es donde la Visión por Computadora (CV) entra en escena; es un campo en el que las máquinas pueden comprender los datos de la imagen. Con CV, podemos procesar, cargar, transformar y manipular imágenes para construir un conjunto de datos ideal para el algoritmo de aprendizaje automático.

Por ejemplo, digamos que queremos construir un algoritmo que prediga si una imagen dada tiene un perro o un gato. Para ello, necesitaremos recopilar imágenes de perros y gatos y preprocesarlas mediante CV. Los pasos de preprocesamiento incluyen:

- Conversión de todas las imágenes al mismo formato.

- Recortando las regiones innecesarias en las imágenes.

- Transformarlos en números para que los algoritmos aprendan de ellos (matriz de números).

Las computadoras ven una imagen de entrada como una matriz de píxeles y depende de la resolución de la imagen. Según la resolución de la imagen, verá altura * ancho * dimensión. Por ejemplo, una imagen de una matriz de 6 x 6 x 3 de una matriz de RGB (3 se refiere a valores RGB) y una imagen de una matriz de 4 x 4 x 1 de una matriz de la imagen en escala de grises.

Estas características (datos que se procesan) se utilizan en la siguiente fase: elegir y construir un algoritmo de aprendizaje automático para clasificar vectores de características desconocidas dada una extensa base de datos de vectores de características cuyas clasificaciones son conocidas. Para ello, tendremos que elegir un algoritmo ideal; algunos de los más populares incluyen redes bayesianas, árboles de decisión, algoritmos genéticos, vecinos más cercanos y redes neuronales, etc.

A continuación se muestra una captura de pantalla del flujo de trabajo de procesamiento de imágenes de aprendizaje automático clásico para datos de imagen:

Los algoritmos aprenden de los patrones basados en los datos de entrenamiento con parámetros particulares. Sin embargo, siempre podemos ajustar el modelo entrenado en función de las métricas de rendimiento. Por último, podemos usar el modelo entrenado para hacer nuevas predicciones sobre datos invisibles.

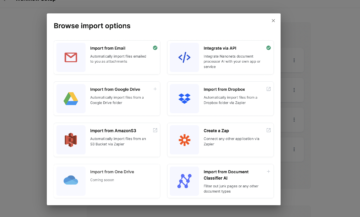

En la siguiente sección, revisaremos algunas de las tecnologías y marcos que podemos utilizar para crear un modelo de procesamiento de imágenes de aprendizaje automático.

Bibliotecas y marcos para el procesamiento de imágenes de aprendizaje automático

En la actualidad, existen más de 250 lenguajes de programación, según el índice TIOBE. De estos, Python es uno de los lenguajes de programación más populares que los desarrolladores / profesionales utilizan mucho para el aprendizaje automático. Sin embargo, siempre podemos cambiar a un idioma que se adapte al caso de uso. Ahora, veremos algunos de los marcos que utilizamos para varias aplicaciones.

OpenCV: OpenCV-Python es una biblioteca de enlaces de Python diseñada para resolver problemas de visión por computadora. Es simple y superfácil de usar.

Aspectos interesantes

- Gran biblioteca de algoritmos de procesamiento de imágenes

- Código abierto + gran comunidad

- Funciona tanto en imágenes como en videos

- Extensión de la API de Java

- Funciona con GPU

- Multiplataforma

Flujo tensor: Desarrollado por Google, Tensorflow es uno de los marcos de desarrollo de aprendizaje automático de extremo a extremo más populares.

Aspectos interesantes

- Amplia gama de algoritmos ML, NN

- Código abierto + gran comunidad

- Trabajar en varios procesadores en paralelo

- GPU configurado

- Multiplataforma

PyTorch: PyTorch (de Facebook) es uno de los marcos de redes neuronales más queridos por los investigadores. Es más pitónico en comparación con otras bibliotecas ML.

Aspectos interesantes

- Entrenamiento de distribución

- Soporte en la nube

- Código abierto + gran comunidad

- Funciona con GPU

- Listo para producción

Caffe: Caffe es un marco de aprendizaje profundo creado pensando en la expresión, la velocidad y la modularidad. Está desarrollado por Berkeley AI Research (BAIR) y por contribuyentes de la comunidad.

Aspectos interesantes

- Código abierto + gran comunidad

- Basado en C ++

- Arquitectura expresiva

- Ejecución fácil y más rápida

emgucv: CV Emgu es un contenedor .Net multiplataforma para la biblioteca de procesamiento de imágenes OpenCV.

Aspectos interesantes

- Código abierto y multiplataforma

- Trabajar con lenguajes compatibles con .NET: C #, VB, VC ++, IronPython, etc.

- Compatible con Visual Studio, Xamarin Studio y Unity

Caja de herramientas de procesamiento de imágenes MATLAB: Las aplicaciones Image Processing Toolbox le permiten automatizar los flujos de trabajo de procesamiento de imágenes comunes. Puede segmentar de forma interactiva datos de imágenes, comparar técnicas de registro de imágenes y procesar grandes conjuntos de datos por lotes.

Aspectos interesantes

- Amplia gama de técnicas de procesamiento de imágenes de aprendizaje profundo

- CUDA habilitado

- Flujos de trabajo de procesamiento de imágenes 3D

WebGazer: WebGrazer es una biblioteca basada en JS para el seguimiento ocular que utiliza cámaras web estándar para inferir las ubicaciones de las miradas de los visitantes de la web en una página en tiempo real.

Aspectos interesantes

- Modelos de predicción de múltiples miradas

- Soporte continuo y código abierto durante más de 4 años

- Sin hardware especial; WebGazer.js usa su cámara web

Apache Marvin-IA: Marvin-AI es una plataforma de inteligencia artificial de código abierto que ayuda a ofrecer soluciones complejas respaldadas por una arquitectura estandarizada de alta escala, baja latencia, agnóstica del lenguaje y simplificando la explotación y el modelado.

Aspectos interesantes

- Código abierto y bien documentado

- CLI fácil de usar

- Procesamiento de imágenes multiproceso

- Extracción de características de los componentes de la imagen

Miscnn: Un marco de código abierto basado en aprendizaje profundo para la segmentación de imágenes médicas.

Aspectos interesantes

- Código abierto y bien documentado

- Creación de pipelines de segmentación

- Herramientas de preprocesamiento y posprocesamiento decentes

- Implementación de CNN

Kornia: Biblioteca de visión por computadora diferenciable de código abierto basada en PyTorch.

Aspectos interesantes

- Técnicas de procesamiento de imágenes ricas y de bajo nivel

- Código abierto y gran comunidad

- Programación diferenciable para grandes aplicaciones

- Listo para producción, habilitado para JIT

VXL: VXL (la Visión-algo-Libraries) es una colección de bibliotecas de C ++ diseñadas para la investigación e implementación de la visión por computadora.

Aspectos interesantes

- Open Source

- Flujos de trabajo de procesamiento de imágenes 3D

- Diseñar una interfaz gráfica de usuario

Procesamiento de imágenes de aprendizaje profundo

Hoy en día, varias técnicas de procesamiento de imágenes de aprendizaje automático aprovechan las redes de aprendizaje profundo. Se trata de un tipo de marco especial que imita al cerebro humano para aprender de los datos y hacer modelos. Una arquitectura de red neuronal familiar que logró un avance significativo en los datos de imágenes son las redes neuronales de convolución, también llamadas CNN. Ahora veamos cómo se utilizan las CNN en imágenes con diferentes tareas de procesamiento de imágenes para construir modelos de vanguardia.

La red neuronal convolucional se basa en tres capas principales, que son:

- Capa convolucional

- Capa de agrupación

- Capa completamente conectada

Capa convolucional: La capa convolucional es el corazón de CNN, hace la mayor parte del trabajo para identificar las características en la imagen dada. Luego, en la capa de convolución, consideramos bloques cuadrados de algún tamaño aleatorio de la imagen de entrada y aplicamos el producto escalar con el filtro (tamaño de filtro aleatorio). Si las dos matrices (el parche y el filtro) tienen valores altos en las mismas posiciones, la salida de la capa de convolución será alta (lo que da el lado brillante de la imagen). Si no lo hacen, será bajo (el lado oscuro de la imagen). De esta manera, un solo valor de la salida del producto escalar puede decirnos si el patrón de píxeles en la imagen subyacente coincide con el patrón de píxeles expresado por nuestro filtro.

Revisemos esto a través de un ejemplo, donde queremos aplicar un filtro para detectar bordes verticales de una imagen usando convolución y ver cómo funcionan las matemáticas.

Capa de agrupación: Cuando identificamos las características usando las capas convolucionales, tenemos múltiples mapas de características. Estos mapas de características resultan cuando se aplica la operación convolucional entre la imagen de entrada y el filtro. Por lo tanto, necesitamos una operación más que reduzca la resolución de la imagen. Por lo tanto, para facilitar el proceso de aprendizaje a la red, los valores de los píxeles en las matrices se reducen mediante la operación de "agrupación". Operan de forma autónoma en cada segmento de profundidad de la entrada y lo redimensionan espacialmente, utilizando las dos operaciones diferentes:

- Agrupación máxima: devuelve el valor máximo de la matriz de la imagen cubierta por el núcleo.

- Agrupación promedio: devuelve el promedio de todos los valores de la matriz de la imagen cubierta por el núcleo.

A continuación se muestra un ejemplo de cómo se calcula una operación de agrupación en la matriz de píxeles dada.

Capa completamente conectada: La capa completamente conectada (FC) opera en una entrada plana donde cada entrada está conectada a todas las neuronas. Por lo general, se utilizan al final de la red para conectar las capas ocultas a la capa de salida, lo que ayuda a optimizar las puntuaciones de la clase.

Aquí hay una captura de pantalla de toda la arquitectura CNN de las tres capas juntas:

Conclusión

En este blog, hemos visto cómo el aprendizaje automático y las técnicas de procesamiento de imágenes de aprendizaje profundo ayudan a construir modelos de alto rendimiento a escala. Hemos revisado algunas de las bibliotecas de código abierto de Python, C ++, C # más conocidas que podemos utilizar para construir pipelines de procesamiento de imágenes Ml para preprocesar, analizar y extraer información de las imágenes. Por último, hemos revisado las CNN, una de las arquitecturas de procesamiento de imágenes de aprendizaje profundo más queridas, para construir modelos de vanguardia a partir de datos de imágenes. Estos tenían una amplia gama de aplicaciones que incluyen clasificación, segmentación, extracción de información, transferencia de estilo y muchas más.

Fuente: https://nanonets.com/blog/machine-learning-image-processing/

- "

- &

- de la máquina

- AI

- ai investigación

- algoritmo

- algoritmos

- Todos

- entre

- APACHE

- abejas

- aplicaciones

- aplicaciones

- arquitectura

- Arte

- Realidad Aumentada

- Autenticación

- Automatización

- Berkeley

- Blog

- sesos

- build

- Construir la

- carros

- cases

- Gatos

- clasificación

- CNN

- Algunos

- vibrante e inclusiva

- Empresas

- Visión por computador

- computadoras

- red neuronal convolucional

- multi-plataforma

- datos

- Base de datos

- deep learning

- Developer

- Desarrollo

- digital

- Perros

- conducción

- etc.

- Experiencias

- Extracción

- ojos

- Cara

- Reconocimiento facial

- Feature

- Caracteristicas

- filtros

- formato

- Marco conceptual

- Las Bases (Fundamentales)

- juego de azar

- GitHub

- Escala de grises

- maravillosa

- Creciendo

- Materiales

- esta página

- Alta

- Cómo

- HTTPS

- Identifique

- imagen

- Segmentación de imagen

- Proyección de imagen

- índice

- información

- extracción de información

- instituciones

- IP

- IT

- idioma

- Idiomas

- large

- APRENDE:

- aprendizaje

- Apalancamiento

- Biblioteca

- carga

- máquina de aprendizaje

- Máquinas

- Mapas

- Mascarillas

- las matemáticas

- servicios

- imagenes medicas

- Métrica

- ML

- Algoritmos ML

- modelo

- Más popular

- vecinos

- red

- del sistema,

- telecomunicaciones

- Neural

- red neural

- redes neuronales

- números

- habiertos

- de código abierto

- OpenCV

- Operaciones

- Otro

- Patch

- Patrón de Costura

- actuación

- imagen

- pixel

- plataforma

- Popular

- industria

- predicción

- Predicciones

- presente

- Producto

- profesionales

- Programación

- lenguajes de programación

- Python

- piñón

- Qualcomm

- calidad

- distancia

- en tiempo real

- Realidad

- Registro

- la investigación

- Resultados

- devoluciones

- una estrategia SEO para aparecer en las búsquedas de Google.

- Escala

- Sectores

- Autos de auto conducción

- auto-manejo

- sencillos

- Tamaño

- teléfonos inteligentes

- Soluciones

- RESOLVER

- velocidad

- cuadrado

- Estado

- Soportado

- vigilancia

- Switch

- Tecnologías

- Tecnología

- tensorflow

- Seguimiento

- Formación

- us

- propuesta de

- VC

- Virtual

- Realidad virtual

- visión

- visualización

- web

- QUIENES

- Actividades:

- flujo de trabajo

- funciona

- X

- años