La IA y las computadoras convencionales son una pareja hecha en el infierno.

La razón principal es cómo se configuran actualmente los chips de hardware. Basado en la arquitectura tradicional de Von Neumann, el chip aísla el almacenamiento de memoria de sus procesadores principales. Cada cálculo es un viaje de pesadilla de lunes por la mañana, con el chip constantemente transportando datos de un lado a otro de cada compartimento, formando un notorio "pared de memoria."

Si alguna vez se ha quedado atascado en el tráfico, conoce la frustración: lleva tiempo y energía desperdiciada. A medida que los algoritmos de IA se vuelven cada vez más complejos, el problema empeora cada vez más.

Entonces, ¿por qué no diseñar un chip basado en el cerebro, una posible combinación perfecta para las redes neuronales profundas?

Ingrese chips de computación en memoria, o CIM. Fieles a su nombre, estos chips calculan y almacenan la memoria en el mismo sitio. Olvídese de los desplazamientos; los chips son alternativas altamente eficientes para trabajar desde casa, eliminando el problema del cuello de botella del tráfico de datos y prometiendo una mayor eficiencia y un menor consumo de energía.

O eso dice la teoría. La mayoría de los chips CIM que ejecutan algoritmos de IA se han centrado únicamente en el diseño de chips, mostrando sus capacidades mediante simulaciones del chip en lugar de ejecutar tareas en hardware completo. Los chips también tienen dificultades para adaptarse a múltiples tareas diferentes de IA (reconocimiento de imágenes, percepción de voz), lo que limita su integración en teléfonos inteligentes u otros dispositivos cotidianos.

Este mes, un estudio in Naturaleza CIM actualizado desde cero. En lugar de centrarse únicamente en el diseño del chip, el equipo internacional, dirigido por los expertos en hardware neuromórfico, el Dr. HS Philip Wong de Stanford y el Dr. Gert Cauwenberghs de UC San Diego, optimizó toda la configuración, desde la tecnología hasta la arquitectura y los algoritmos que calibran el hardware. .

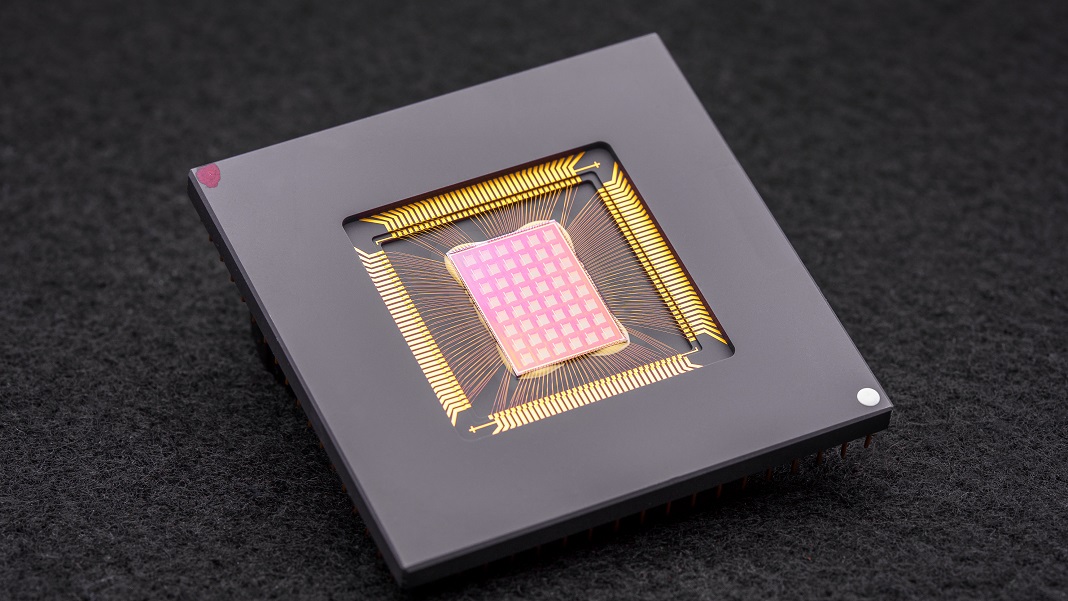

El chip NeuRRAM resultante es un poderoso gigante informático neuromórfico con 48 núcleos paralelos y 3 millones de celdas de memoria. Extremadamente versátil, el chip abordó múltiples tareas estándar de IA, como leer números escritos a mano, identificar automóviles y otros objetos en imágenes y decodificar grabaciones de voz, con más del 84 por ciento de precisión.

Si bien la tasa de éxito puede parecer mediocre, compite con los chips digitales existentes pero ahorra energía de manera espectacular. Para los autores, está un paso más cerca de llevar la IA directamente a nuestros dispositivos en lugar de tener que transferir datos a la nube para su cómputo.

"Hacer esos cálculos en el chip en lugar de enviar información hacia y desde la nube podría permitir una IA más rápida, más segura, más barata y más escalable en el futuro, y dar acceso a más personas al poder de la IA". dijo Wong

Inspiración neuronal

Chips específicos de IA son ahora una asombrosa moneda de diez centavos por docena. Desde la Unidad de procesamiento de tensores (TPU) de Google y la arquitectura de supercomputadora Dojo de Tesla hasta Baidu y Amazon, los gigantes tecnológicos están invirtiendo millones en la fiebre del oro de los chips de IA para construir procesadores que admitan algoritmos de aprendizaje profundo cada vez más sofisticados. Algunos incluso aprovechar el aprendizaje automático para diseñar arquitecturas de chips adaptado para el software de IA, completando el círculo de la carrera.

Un concepto particularmente intrigante proviene directamente del cerebro. A medida que los datos pasan a través de nuestras neuronas, se "conectan" en redes a través de "muelles" físicos llamados sinapsis. Estas estructuras, ubicadas en la parte superior de las ramas neuronales como pequeños hongos, son multitareas: calculan y almacenan datos a través de cambios en su composición proteica.

En otras palabras, las neuronas, a diferencia de las computadoras clásicas, no necesitan transferir datos de la memoria a las CPU. Esto le da al cerebro su ventaja sobre los dispositivos digitales: es altamente eficiente energéticamente y realiza múltiples cálculos simultáneamente, todo empacado en una gelatina de tres libras dentro del cráneo.

¿Por qué no recrear aspectos del cerebro?

Participar computación neuromórfica. Un truco fue usar RRAM, o dispositivos de memoria resistivos de acceso aleatorio (también denominados 'memristores'). Las RRAM almacenan memoria incluso cuando se corta la energía al cambiar la resistencia de su hardware. Al igual que las sinapsis, estos componentes se pueden empaquetar en conjuntos densos en un área pequeña, creando circuitos capaces de realizar cálculos muy complejos sin volumen. Cuando se combina con CMOS, un proceso de fabricación para construir circuitos en nuestros microprocesadores y chips actuales, el dúo se vuelve aún más poderoso para ejecutar algoritmos de aprendizaje profundo.

Pero tiene un costo. “El cómputo analógico altamente paralelo dentro de la arquitectura RRAM-CIM brinda una eficiencia superior, pero dificulta lograr el mismo nivel de flexibilidad funcional y precisión computacional que en los circuitos digitales”, dijeron los autores.

Genio de optimización

El nuevo estudio profundizó en cada parte de un chip RRAM-CIM, rediseñándolo para un uso práctico.

Comienza con la tecnología. NeuRRAM cuenta con 48 núcleos que se computan en paralelo, con dispositivos RRAM entrelazados físicamente en circuitos CMOS. Al igual que una neurona, cada núcleo se puede apagar individualmente cuando no se usa, conservando la energía mientras su memoria se almacena en la RRAM.

Estas celdas RRAM, las tres millones de ellas, están vinculadas para que los datos puedan transferirse en ambas direcciones. Es un diseño crucial, que permite que el chip se adapte de manera flexible a múltiples tipos diferentes de algoritmos de IA, explicaron los autores. Por ejemplo, un tipo de red neuronal profunda, CNN (red neuronal convolucional), es particularmente excelente para la visión por computadora, pero necesita que los datos fluyan en una sola dirección. En contraste, los LSTM, un tipo de red neuronal profunda que se usa a menudo para el reconocimiento de audio, procesa datos de manera recurrente para hacer coincidir las señales con el tiempo. Al igual que las sinapsis, el chip codifica la fuerza con la que una "neurona" RRAM se conecta a otra.

Esta arquitectura hizo posible ajustar el flujo de datos para minimizar los atascos de tráfico. Al igual que expandir el tráfico de un solo carril a varios carriles, el chip podría duplicar la "memoria" actual de una red de la mayoría de los problemas computacionales intensivos, de modo que varios núcleos analicen el problema simultáneamente.

Un retoque final a los chips CIM anteriores fue un puente más sólido entre la computación similar al cerebro, a menudo analógica, y el procesamiento digital. Aquí, el chip utiliza un circuito de neuronas que puede convertir fácilmente la computación analógica en señales digitales. Es un paso adelante con respecto a las configuraciones previas "hambrientas de energía y hambrientas de área", explicaron los autores.

Las optimizaciones funcionaron. Poniendo a prueba su teoría, el equipo fabricó el chip NeuRRAM y desarrolló algoritmos para programar el hardware para diferentes algoritmos, como Play Station 5 ejecutando diferentes juegos.

En una multitud de pruebas comparativas, el chip se desempeñó como un campeón. Al ejecutar una CNN de siete capas en el chip, NeuRRAM tuvo una tasa de error de menos del uno por ciento al reconocer dígitos escritos a mano utilizando la popular base de datos MNIST.

También sobresalió en tareas más difíciles. Al cargar otra red neuronal profunda popular, LSTM, el chip fue aproximadamente un 85 por ciento correcto cuando se le desafió con el reconocimiento de comandos de voz de Google. Usando solo ocho núcleos, el chip, que se ejecuta en otra arquitectura de IA, pudo recuperar imágenes ruidosas, reduciendo los errores en aproximadamente un 70 por ciento.

Entonces, ¿qué?

Una palabra: energía.

La mayoría de los algoritmos de IA consumen mucha energía. NeuRRAM funcionó a la mitad del costo de energía de los chips RRAM-CIM de última generación anteriores, traduciendo aún más la promesa de ahorro de energía con la computación neuromórfica en realidad.

Pero lo más destacado del estudio es su estrategia. Con demasiada frecuencia, al diseñar chips, los científicos necesitan equilibrar la eficiencia, la versatilidad y la precisión para múltiples tareas, métricas que a menudo están en desacuerdo entre sí. El problema se complica aún más cuando toda la computación se realiza directamente en el hardware. NeuRRAM demostró que es posible luchar contra todas las bestias a la vez.

La estrategia utilizada aquí se puede utilizar para optimizar otros dispositivos informáticos neuromórficos como tecnología de memoria de cambio de fases, dijeron los autores.

Por ahora, NeuRRAM es una prueba de concepto que muestra que un chip físico, en lugar de una simulación del mismo, funciona según lo previsto. Pero hay margen de mejora, incluida una mayor escala de las RRAM y la reducción de su tamaño para que algún día pueda caber en nuestros teléfonos.

“Tal vez hoy se usa para realizar tareas simples de IA, como la detección de palabras clave o la detección humana, pero mañana podría permitir una experiencia de usuario completamente diferente. Imagine el análisis de video en tiempo real combinado con el reconocimiento de voz, todo dentro de un dispositivo diminuto”. dijo autor del estudio Dr. Weier Wan. “Como investigadora e ingeniera, mi ambición es llevar las innovaciones de investigación de los laboratorios al uso práctico”.

Crédito de la imagen: David Baillot/Universidad de California San Diego