f Modelos ML. También profundizará en las técnicas de tubería ETL utilizadas para la limpieza de datos, el preprocesamiento y la ingeniería de características. Al final de este artículo, tendrá una comprensión sólida de la importancia de la calidad de los datos en ML y las técnicas utilizadas para garantizar datos de alta calidad. Esto ayudará a implementar estas técnicas en proyectos del mundo real y mejorar el rendimiento de sus modelos ML.

OBJETIVOS DE APRENDIZAJE

- Comprender los conceptos básicos del aprendizaje automático y sus diversas aplicaciones.

- Reconocer la importancia de la calidad de los datos en el éxito de los modelos de aprendizaje automático.

- Familiarizarse con la canalización de ETL y su función para garantizar la calidad de los datos.

- Aprender múltiples técnicas para la limpieza de datos, incluido el manejo de datos faltantes y duplicados, valores atípicos y ruido, y variables categóricas.

- Comprender la importancia del preprocesamiento de datos y la ingeniería de características para mejorar la calidad de los datos utilizados en los modelos de ML.

- Experiencia práctica en la implementación de una canalización ETL completa mediante código, incluida la extracción, transformación y carga de datos.

- Familiarizarse con la inyección de datos y cómo puede afectar el rendimiento de los modelos de ML.

- Comprender el concepto y la importancia de la ingeniería de funciones en el aprendizaje automático.

Este artículo fue publicado como parte del Blogatón de ciencia de datos.

Índice del contenido

- Introducción

- ¿Qué es el Aprendizaje Automático?

- ¿Por qué los datos son críticos en el aprendizaje automático?

- ¿Recopilación de datos a través de ETL Pipeline?

- ¿Qué es la inyección de datos?

- La importancia de la limpieza de datos

- ¿Qué es el preprocesamiento de datos?

- Una inmersión en la ingeniería de características

- Código completo para ETL-Pipeline

- Conclusión

¿Qué es el Aprendizaje Automático?

El aprendizaje automático es una forma de inteligencia artificial que permite que las computadoras aprendan y mejoren en función de la experiencia sin programación explícita. Desempeña un papel crucial en la realización de predicciones, la identificación de patrones en los datos y la toma de decisiones sin intervención humana. Esto da como resultado un sistema más preciso y eficiente.

El aprendizaje automático es una parte esencial de nuestras vidas y se usa en aplicaciones que van desde asistentes virtuales hasta automóviles autónomos, atención médica, finanzas, transporte y comercio electrónico.

Los datos, especialmente el aprendizaje automático, son uno de los componentes críticos de cualquier modelo. Siempre depende de la calidad de los datos que alimentas a tu modelo. Examinemos por qué los datos son tan esenciales para el aprendizaje automático.

¿Por qué los datos son críticos en el aprendizaje automático?

Estamos rodeados de mucha información todos los días. Los gigantes tecnológicos como Amazon, Facebook y Google recopilan grandes cantidades de datos diariamente. Pero, ¿por qué recopilan datos? Tiene razón si ha visto que Amazon y Google respaldan los productos que está buscando.

Finalmente, los datos de las técnicas de aprendizaje automático juegan un papel esencial en la implementación de este modelo. En resumen, los datos son el combustible que impulsa el aprendizaje automático y la disponibilidad de datos de alta calidad es fundamental para crear modelos precisos y confiables. Muchos tipos de datos se utilizan en el aprendizaje automático, incluidos los datos categóricos, numéricos, de series temporales y de texto. Los datos se recopilan a través de una canalización ETL. ¿Qué es una tubería ETL?

Recopilación de datos a través de ETL Pipeline

La preparación de datos para el aprendizaje automático a menudo se denomina canalización ETL para extracción, transformación y carga.

- Extracción: El primer paso en la canalización de ETL es extraer datos de varias fuentes. Puede incluir la extracción de datos de bases de datos, API o archivos simples como CSV o Excel. Los datos pueden ser estructurados o no estructurados.

Aquí hay un ejemplo de cómo extraemos datos de un archivo CSV.

Código Python:

import pandas as pd

#read csv file

df = pd.read_csv("data.csv")

#extract specific data

name = df["name"]

age = df["age"]

address = df["address"]

#print extracted data

print("Name:", name)

print("Age:", age)

print("Address:", address)

- : Es el proceso de transformar los datos para que sean aptos para su uso en modelos de aprendizaje automático. Esto puede incluir limpiar los datos para eliminar errores o inconsistencias, estandarizar los datos y convertir los datos a un formato que el modelo pueda usar. Este paso también incluye la ingeniería de características, donde los datos sin procesar se transforman en un conjunto de características que se utilizarán como entrada para el modelo.

- Este es un código simple para convertir datos de json a DataFrame.

import json

import pandas as pd

#load json file

with open("data.json", "r") as json_file:

data = json.load(json_file)

#convert json data to a DataFrame

df = pd.DataFrame(data)

#write to csv

df.to_csv("data.csv", index=False)

- Carga: El paso final es cargar o cargar los datos convertidos en el destino. Puede ser una base de datos, un almacén de datos o un sistema de archivos. Los datos resultantes están listos para su uso posterior, como el entrenamiento o la prueba de modelos de aprendizaje automático.

Aquí hay un código simple que muestra cómo cargamos datos usando los pandas:

import pandas as pd

df = pd.read_csv('data.csv')

Después de recopilar los datos, generalmente usamos la inyección de datos si encontramos valores faltantes.

¿Qué es la inyección de datos?

Se pueden agregar datos nuevos a un servidor de datos existente por varias razones para actualizar la base de datos con datos nuevos y agregar datos más diversos para mejorar el rendimiento de los modelos de aprendizaje automático. O la corrección de errores del conjunto de datos original generalmente se realiza mediante la automatización con algunas herramientas útiles.

Hay tres tipos.

- Inserción por lotes: Los datos se insertan de forma masiva, suele ser a una hora fija

- Inyección en tiempo real: Los datos se inyectan inmediatamente cuando se generan.

- Inyección de flujo: Los datos se inyectan en un flujo continuo. A menudo se utiliza en tiempo real.

Aquí hay un ejemplo de código de cómo inyectamos datos usando la función de agregar usando la biblioteca pandas.

La siguiente etapa de la canalización de datos es la limpieza de datos.

import pandas as pd # Create an empty DataFrame

df = pd.DataFrame() # Add some data to the DataFrame

df = df.append({'Name': 'John', 'Age': 30, 'Country': 'US'}, ignore_index=True)

df = df.append({'Name': 'Jane', 'Age': 25, 'Country': 'UK'}, ignore_index=True) # Print the DataFrame

print(df)

La importancia de la limpieza de datos

Limpieza de datos es la eliminación o corrección de errores en los datos. Esto puede incluir la eliminación de valores faltantes y duplicados y la gestión de valores atípicos. La limpieza de datos es un proceso iterativo, y los nuevos conocimientos pueden requerir que regrese y realice cambios. En Python, la biblioteca pandas se usa a menudo para limpiar datos.

Hay razones importantes para limpiar los datos.

- Calidad de datos: La calidad de los datos es crucial para un análisis preciso y fiable. Una información más precisa y consistente puede conducir a resultados reales y una mejor toma de decisiones.

- Rendimiento del aprendizaje automático: Los datos sucios pueden afectar negativamente el rendimiento de los modelos de aprendizaje automático. Limpiar sus datos mejora la precisión y confiabilidad de su modelo.

- Almacenamiento y recuperación de datos: Los datos limpios son más fáciles de almacenar y recuperar y reducen el riesgo de errores e inconsistencias en el almacenamiento y la recuperación de datos.

- Gobierno de datos: La limpieza de datos es crucial para garantizar la integridad de los datos y el cumplimiento de las políticas y regulaciones regulatorias de datos.

- Almacenamiento de datos: Borrar datos ayuda a guardar datos para uso y análisis a largo plazo.

Aquí hay un código que muestra cómo descartar valores faltantes y eliminar duplicados usando la biblioteca pandas:

df = df.dropna()

df = df.drop_duplicates() # Fill missing values

df = df.fillna(value=-1)

Aquí hay otro ejemplo de cómo limpiamos los datos usando varias técnicas.

import pandas as pd # Create a sample DataFrame

data = {'Name': ['John', 'Jane', 'Mike', 'Sarah', 'NaN'], 'Age': [30, 25, 35, 32, None], 'Country': ['US', 'UK', 'Canada', 'Australia', 'NaN']}

df = pd.DataFrame(data) # Drop missing values

df = df.dropna() # Remove duplicates

df = df.drop_duplicates() # Handle outliers

df = df[df['Age'] < 40] # Print the cleaned DataFrame

print(df)

La tercera etapa de la canalización de datos es el preprocesamiento de datos,

También es bueno comprender claramente los datos y las funciones antes de aplicar cualquier método de limpieza y probar el rendimiento del modelo después de limpiar los datos.

¿Qué es el preprocesamiento de datos?

El procesamiento de datos está preparando datos para su uso en modelos de aprendizaje automático. Este es un paso esencial en el aprendizaje automático porque garantiza que los datos estén en un formato que el modelo pueda usar y que se resuelvan los errores o inconsistencias.

El procesamiento de datos generalmente implica una combinación de limpieza de datos, transformación de datos y estandarización de datos. Los pasos específicos en el procesamiento de datos dependen del tipo de datos y del modelo de aprendizaje automático que esté utilizando. Sin embargo, aquí hay algunos pasos generales:

- Limpieza de datos: elimine errores, incoherencias y valores atípicos de la base de datos.

- Transformación de datos: Transformación de datos en una forma que pueda ser utilizada por modelos de aprendizaje automático, como cambiar variables categóricas a variables numéricas.

- Datos Normalización: escala los datos en un rango específico entre 0 y 1, lo que ayuda a mejorar el rendimiento de algunos modelos de aprendizaje automático.

- Agregar datos: agregue cambios o manipulaciones a los puntos de datos existentes para crear otros nuevos.

- Selección o extracción de características: identifique y seleccione las características esenciales de sus datos para usarlas como entrada para su modelo de aprendizaje automático.

- Detección de valores atípicos: identifique y elimine puntos de datos que se desvíen significativamente de grandes cantidades de datos. Los valores atípicos pueden alterar los resultados analíticos y afectar negativamente el rendimiento de los modelos de aprendizaje automático.

- Detectar duplicados: identifique y elimine puntos de datos duplicados. Los datos duplicados pueden dar lugar a resultados inexactos o poco fiables y aumentar el tamaño de su conjunto de datos, lo que dificulta su procesamiento y análisis.

- Identificar tendencias: Encuentre patrones y tendencias en sus datos que puede usar para informar predicciones futuras o comprender mejor la naturaleza de sus datos.

El procesamiento de datos es esencial en el aprendizaje automático porque garantiza que los datos estén en una forma que el modelo pueda usar y que se eliminen los errores o las incoherencias. Esto mejora el rendimiento del modelo y la precisión de la predicción.

Aquí hay un código simple que muestra cómo usar la clase LabelEncoder para escalar variables categóricas a valores numéricos y la clase MinMaxScaler para escalar variables numéricas.

import pandas as pd

from sklearn.preprocessing import MinMaxScaler, StandardScaler, OneHotEncoder, LabelEncoder # Create a sample DataFrame

data = {'Name': ['John', 'Jane', 'Mike', 'Sarah'], 'Age': [30, 25, 35, 32], 'Country': ['US', 'UK', 'Canada', 'Australia'], 'Gender':['M','F','M','F']}

df = pd.DataFrame(data) # Convert categorical variables to numerical

encoder = LabelEncoder()

df["Gender"] = encoder.fit_transform(df["Gender"]) # One hot encoding

onehot_encoder = OneHotEncoder()

country_encoded = onehot_encoder.fit_transform(df[['Country']])

df = pd.concat([df, pd.DataFrame(country_encoded.toarray())], axis=1)

df = df.drop(['Country'], axis=1) # Scale numerical variables

scaler = MinMaxScaler()

df[['Age']] = scaler.fit_transform(df[['Age']]) # Print the preprocessed DataFrame

print(df)

La etapa final de la canalización de datos es la ingeniería de características,

Una inmersión en la ingeniería de características

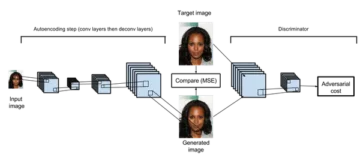

Ingeniería de características transforma los datos sin procesar en características que se pueden usar como entrada para modelos de aprendizaje automático. Esto implica identificar y extraer los datos más críticos de la materia prima y convertirlos a un formato que el modelo pueda usar. La ingeniería de características es esencial en el aprendizaje automático porque puede afectar significativamente el rendimiento del modelo.

Las diferentes técnicas que se pueden utilizar para la ingeniería de características son:

- Feature Extracción: Extraiga información relevante de los datos sin procesar. Por ejemplo, identifique las funciones más importantes o combine funciones existentes para crear nuevas funciones.

- Modificación de atributos: Cambie el tipo de atributo, como cambiar una variable categórica a una variable numérica o ampliar los datos para que se ajusten a un rango específico.

- Selección de características: Determine las características esenciales de sus datos para usar como entrada en su modelo de aprendizaje automático.

- Reducción de dimensión: Reduzca la cantidad de funciones en la base de datos eliminando funciones redundantes o irrelevantes.

- Agregar datos: agregue cambios o manipulaciones a los puntos de datos existentes para crear otros nuevos.

La ingeniería de características requiere una buena comprensión de sus datos, el problema a resolver y los algoritmos de aprendizaje automático a utilizar. Este proceso es iterativo y experimental y puede requerir varias iteraciones para encontrar el conjunto de características óptimo que mejore el rendimiento de nuestro modelo.

Código completo para toda la canalización de ETL

Aquí hay un ejemplo de una tubería ETL completa que usa las bibliotecas pandas y scikit-learn:

import pandas as pd

from sklearn.preprocessing import MinMaxScaler, StandardScaler, OneHotEncoder, LabelEncoder # Extract data from CSV file

df = pd.read_csv('data.csv') # Data cleaning

df = df.dropna()

df = df.drop_duplicates() # Data transformation

encoder = LabelEncoder()

df["Gender"] = encoder.fit_transform(df["Gender"]) onehot_encoder = OneHotEncoder()

country_encoded = onehot_encoder.fit_transform(df[['Country']])

df = pd.concat([df, pd.DataFrame(country_encoded.toarray())], axis=1)

df = df.drop(['Country'], axis=1) scaler = MinMaxScaler()

df[['Age']] = scaler.fit_transform(df[['Age']]) # Load data into a new CSV file

df.to_csv('cleaned_data.csv', index=False)

Los datos se recuperan primero de un archivo CSV utilizando la función pandas read_csv() de este ejemplo. Luego, la limpieza de datos se realiza eliminando los valores faltantes y los duplicados. Esto se hace usando LabelEncoder para cambiar variables categóricas a numéricas, OneHotEncoder para escalar variables categóricas a números y MinMaxScaler para escalar variables numéricas. Finalmente, los datos eliminados se leen en un nuevo archivo CSV utilizando la función pandas to_csv().

Tenga en cuenta que este ejemplo es una versión muy simplificada de la canalización ETL. En un escenario real, la tubería puede ser más compleja e involucrar más procesamiento y subcontratación, costeo, etc. Puede incluir métodos como. Además, la trazabilidad de los datos también es fundamental. Es decir, rastrea el origen de los datos, sus cambios y dónde están, no solo lo ayuda a comprender la calidad de sus datos, sino que también lo ayuda a depurar y revisar su canalización. Además, es esencial comprender claramente los datos y las características antes de aplicar métodos de procesamiento posterior y verificar el rendimiento del modelo después del procesamiento previo. Información.

Conclusión

La calidad de los datos es fundamental para el éxito de los modelos de aprendizaje automático. Cuidando cada paso del proceso, desde la recopilación de datos hasta la limpieza, el procesamiento y la validación, puede asegurarse de que sus datos sean de la más alta calidad. Esto permitirá que su modelo haga predicciones más precisas, lo que generará mejores resultados y proyectos exitosos de aprendizaje automático.

Ahora sabrás la importancia de la calidad de los datos en el aprendizaje automático. Estas son algunas de las conclusiones clave de mi artículo:

Puntos clave

- Comprender el impacto de la mala calidad de los datos en los modelos de aprendizaje automático y los resultados resultantes.

- Reconocer la importancia de la calidad de los datos en el éxito de los modelos de aprendizaje automático.

- Familiarizarme con la canalización de ETL y su función para garantizar la calidad de los datos.

- Adquirir habilidades para la limpieza de datos, el preprocesamiento y las técnicas de ingeniería de características para mejorar la calidad de los datos utilizados en los modelos de ML.

- Comprender el concepto y la importancia de la ingeniería de funciones en el aprendizaje automático.

- Técnicas de aprendizaje para seleccionar, crear y transformar funciones para mejorar el rendimiento de los modelos de ML.

¡Gracias por leer! ¿Quieres compartir algo no mencionado anteriormente? ¿Pensamientos? Siéntete libre de comentar abajo.

Los medios que se muestran en este artículo no son propiedad de Analytics Vidhya y se utilizan a discreción del autor.

Relacionado:

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.analyticsvidhya.com/blog/2023/01/the-role-of-data-quality-in-machine-learning/

- 1

- a

- arriba

- la exactitud

- preciso

- adición

- dirección

- negativamente

- afectar

- Después

- algoritmos

- hacerlo

- Amazon

- cantidades

- análisis

- Pruebas analíticas

- Analytics

- Analítica Vidhya

- analizar

- y

- Otra

- API

- aplicaciones

- La aplicación de

- artículo

- artificial

- inteligencia artificial

- asistentes

- Australia

- Automatización

- disponibilidad

- Atrás

- basado

- conceptos básicos

- porque

- antes

- a continuación

- mejores

- entre

- Ubicación: Canadá

- servicios sociales

- carros

- el cambio

- Cambios

- cambio

- comprobación

- clase

- Limpieza

- con claridad.

- código

- recoger

- El cobro

- combinación

- combinar

- comentario

- completar

- integraciones

- compliance

- componentes

- computadoras

- concepto

- consistente

- continuo

- convertir

- convertido

- país

- Para crear

- Creamos

- crítico

- crucial

- todos los días

- datos

- puntos de datos

- proceso de datos

- calidad de los datos

- conjunto de datos

- almacenamiento de datos

- Base de datos

- bases de datos

- día

- Toma de Decisiones

- decisiones

- depende

- destino

- Determinar

- difícil

- discreción

- diverso

- Soltar

- duplicados

- comercio electrónico

- más fácil

- eficiente

- permite

- endosar

- Ingeniería

- garantizar

- asegura

- asegurando que

- Todo

- error

- Errores

- especialmente

- esencial

- etc.

- Éter (ETH)

- Cada

- diario

- ejemplo

- Excel

- existente

- experience

- extraerlos

- Extracción

- Feature

- Caracteristicas

- Archive

- archivos

- llenar

- final

- Finalmente

- financiar

- Encuentre

- Nombre

- cómodo

- fijas

- formulario

- formato

- Gratuito

- De

- Combustible

- función

- promover

- futuras

- Género

- General

- en general

- generado

- Go

- candidato

- encargarse de

- Manejo

- práctico

- la salud

- ayuda

- ayuda

- esta página

- alta calidad

- más alto

- HOT

- Cómo

- Como Hacer

- Sin embargo

- HTTPS

- humana

- Identifique

- identificar

- inmediatamente

- Impacto

- implementar

- implementación

- importar

- importancia

- importante

- mejorar

- mejora

- la mejora de

- in

- incorrecto

- incluir

- incluye

- Incluye

- aumente

- información

- Las opciones de entrada

- Insights

- integración

- integridad

- Intelligence

- intervención

- involucrar

- IT

- iteraciones

- Juan

- json

- Clave

- Saber

- large

- Lead

- líder

- APRENDE:

- aprendizaje

- bibliotecas

- Biblioteca

- Vidas

- carga

- carga

- compromiso a largo plazo

- mirando

- Lote

- máquina

- máquina de aprendizaje

- Técnicas de aprendizaje automático

- para lograr

- Realizar

- administrar

- muchos

- materiales

- max-ancho

- Medios

- mencionado

- métodos

- que falta

- ML

- modelo

- modelos

- más,

- MEJOR DE TU

- múltiples

- nombre

- Naturaleza

- negativamente

- Nuevo

- Nuevas características

- Next

- ruido

- número

- números

- ONE

- óptimo

- Natural

- reconocida por

- Outsourcing

- propiedad

- Los pandas

- parte

- .

- actuación

- industrial

- Natural

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- puntos

- políticas

- pobre

- predicción

- Predicciones

- preparación

- Imprimir

- Problema

- tratamiento

- Productos

- Programación

- proyecta

- publicado

- Python

- calidad

- distancia

- que van

- Crudo

- datos en bruto

- Leer

- ready

- real

- mundo real

- en tiempo real

- razones

- reducir

- reduce

- referido

- reglamentos

- regulador

- fiabilidad

- confianza

- eliminación

- remove

- Remoto

- la eliminación de

- exigir

- requiere

- resuelto

- resultante

- Resultados

- una estrategia SEO para aparecer en las búsquedas de Google.

- Riesgo

- Función

- Guardar

- Escala

- Ciencia:

- scikit-aprender

- seleccionar

- selección

- auto-manejo

- Serie

- set

- Varios

- Compartir

- En Corto

- mostrado

- Shows

- significativamente

- sencillos

- simplificado

- Tamaño

- habilidades

- So

- sólido

- algo

- algo

- Fuentes

- soluciones y

- Etapa

- estandarizando

- paso

- pasos

- STORAGE

- tienda

- stream

- estructurado

- comercial

- exitosos

- tal

- adecuado

- rodeado

- te

- Cuadro

- Takeaways

- toma

- tecnología

- los gigantes tecnológicos

- técnicas

- test

- Pruebas

- El

- Lo esencial

- su

- Código

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- Series de tiempo

- a

- Trazabilidad

- Formación

- transformado

- transformadora

- de transporte

- Tendencias

- tipos

- Uk

- entender

- comprensión

- Actualizar

- us

- utilizan el

- generalmente

- validación

- Valores

- diversos

- Vasto

- versión

- Virtual

- ¿

- Que es

- que

- seguirá

- limpieza

- dentro de

- sin

- tú

- zephyrnet

- zoom

![Guía para el manejo de archivos en Python [explicada con ejemplos]](https://platoaistream.net/wp-content/uploads/2024/01/guide-to-file-handling-in-python-explained-with-examples-360x202.jpg)