Pilt autorilt

XAI on tehisintellekt, mis võimaldab inimestel mõista mudeli või süsteemi tulemusi ja otsustusprotsesse.

Eelmodelleerimise seletatavus

Selgitav tehisintellekt algab seletatavate andmete ja selgete, tõlgendatavate funktsioonide kavandamisega.

Modelleerimise seletatavus

Konkreetse probleemi jaoks mudeli valimisel on üldiselt kõige parem kasutada kõige paremini tõlgendatavat mudelit, mis annab siiski häid ennustavaid tulemusi.

Mudelijärgne seletatavus

See hõlmab selliseid tehnikaid nagu häirimine, kus analüüsitakse ühe muutuja muutmise mõju mudeli väljundile, näiteks SHAP-i väärtused pärast treeningut.

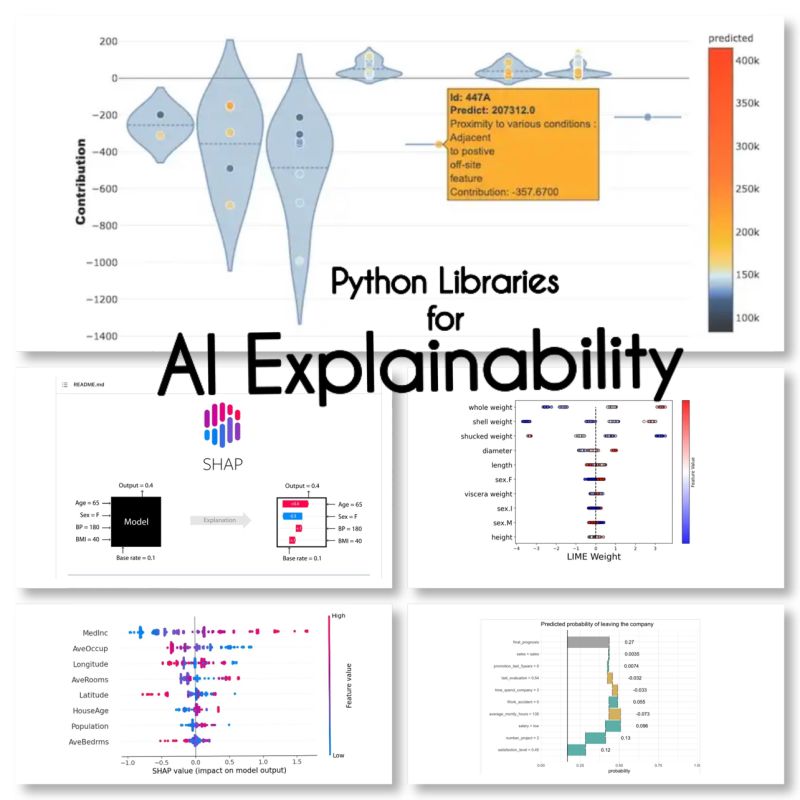

Leidsin need 10 Pythoni teeki AI seletatavuse jaoks:

SHAP (SHapley lisandite seletused)

SHAP on mudelagnostik ja töötab iga funktsiooni panuse jagamisel ja igale funktsioonile hinde omistamise kaudu.

LIME (kohalikud tõlgendatavad mudeliagnostilised seletused)

LIME on veel üks mudeliagnostiline meetod, mis toimib mudeli käitumise lokaalse lähendamise teel konkreetse ennustuse ümber.

ELi5

Eli5 on raamatukogu silumiseks ja klassifikaatorite selgitamiseks. See pakub funktsioonide tähtsuse hindu, aga ka põhjuskoode scikit-learni, Kerase, xgboosti, LightGBM-i ja CatBoosti jaoks.

Shapash

Shapash on Pythoni teek, mille eesmärk on muuta masinõpe kõigile tõlgendatavaks ja arusaadavaks. Shapash pakub mitut tüüpi visualiseerimist selgesõnaliste siltidega.

Ankrud

Ankrud on meetod inimesele tõlgendatavate reeglite genereerimiseks, mida saab kasutada masinõppemudeli ennustuste selgitamiseks.

XAI (selgitatav AI)

XAI on raamatukogu masinõppemudelite prognooside, sealhulgas funktsioonide tähtsuse skooride selgitamiseks ja visualiseerimiseks.

Lagunema

BreakDown on tööriist, mida saab kasutada lineaarsete mudelite prognooside selgitamiseks. See toimib, jagades mudeli väljundi iga sisendfunktsiooni panuseks.

tõlgenda-teksti

interpret-text on raamatukogu loomuliku keele töötlemise mudelite ennustuste selgitamiseks.

iml (tõlgendatav masinõpe)

iml sisaldab praegu Shapi projekti liidest ja IO-koodi ning võib-olla teeb see sama ka projekti Lime'i jaoks.

aix360 (AI Explainability 360)

aix360 sisaldab laiaulatuslikku algoritmide komplekti, mis hõlmavad erinevaid mõõtmeid

OmniXAI

OmniXAI (lühend sõnast Omni eXplainable AI) käsitleb mitmeid masinõppemudelite praktikas tehtud otsuste tõlgendamisega seotud probleeme.

Kas ma olen mõne raamatukogu unustanud?

Allikad

Maryam Miradi on tehisintellekti ja andmeteaduse juht, doktorikraadiga masinõppe ja süvaõppe alal, spetsialiseerunud NLP-le ja arvutinägemisele. Tal on üle 15-aastane kogemus edukate tehisintellektilahenduste loomisel ning tal on kogemusi üle 40 eduka projekti elluviimisel. Ta on töötanud 12 erinevas organisatsioonis erinevates tööstusharudes, sealhulgas finantskuritegevuse tuvastamises, energeetikas, panganduses, jaekaubanduses, e-kaubanduses ja valitsuses.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- Platoblockchain. Web3 metaversiooni intelligentsus. Täiustatud teadmised. Juurdepääs siia.

- Allikas: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- aadressid

- pärast

- AI

- Eesmärgid

- algoritme

- võimaldab

- ja

- Teine

- ümber

- kunstlik

- tehisintellekti

- Pangandus

- BEST

- Purustamine

- muutuv

- valimine

- selge

- kood

- terviklik

- arvuti

- Arvuti visioon

- sisaldab

- panus

- cover

- loomine

- Kuritegevus

- Praegu

- andmed

- andmeteadus

- Otsuse tegemine

- otsused

- sügav

- sügav õpe

- edastamine

- erinev

- alla

- e-kaubandus

- iga

- mõju

- energia

- Inseneriteadus

- igaüks

- kogemus

- Selgitama

- Seletatavus

- Seletatav tehisintellekt

- selgitades

- tunnusjoon

- finants-

- finantskuritegevus

- unustatud

- avastatud

- Alates

- üldiselt

- teeniva

- hea

- Valitsus

- HTTPS

- Inimestel

- tähtsus

- in

- hõlmab

- Kaasa arvatud

- tööstusharudes

- sisend

- Intelligentsus

- Interface

- IT

- otsuseid

- KDnuggets

- keras

- Labels

- keel

- viima

- õppimine

- raamatukogud

- Raamatukogu

- laim

- kohalik

- kohapeal

- masin

- masinõpe

- tegema

- meetod

- mudel

- mudelid

- kõige

- Natural

- Loomulik keel

- Natural Language Processing

- nlp

- Omni

- organisatsiooniline

- eriline

- Platon

- Platoni andmete intelligentsus

- PlatoData

- potentsiaalselt

- tava

- ennustus

- Ennustused

- Probleem

- probleeme

- Protsessid

- töötlemine

- Toodetud

- projekt

- projektid

- annab

- Python

- põhjus

- rekord

- Tulemused

- jaemüük

- eeskirjade

- sama

- teadus

- skikit õppima

- komplekt

- mitu

- Lühike

- ühekordne

- Lahendused

- spetsialiseerunud

- konkreetse

- algab

- Veel

- edukas

- selline

- süsteem

- tehnikat

- .

- et

- tööriist

- jälgida

- koolitus

- liigid

- mõistma

- arusaadav

- kasutama

- Väärtused

- sort

- nägemus

- visualiseerimine

- mis

- will

- töötas

- töötab

- XGBoost

- aastat

- Sinu

- sephyrnet