Goodharti seadus Kuulus ütleb: "Kui meetmest saab sihtmärk, lakkab see olemast hea meede." Kuigi see pärineb algselt majandusest, peame OpenAI-s sellega võitlema, kui mõtleme välja, kuidas optimeerida eesmärke, mida on raske või kulukas mõõta. Sageli on vaja mõnda tutvustada proksi eesmärk seda on lihtsam või odavam mõõta, kuid seda tehes peame olema ettevaatlikud, et seda liiga palju mitte optimeerida.

Näiteks osana meie tööst viia mudeleid nagu GPT-3, millel on inimlikud eesmärgid ja väärtused, tahaksime optimeerida selliseid asju nagu „Kuidas kasulik kas see on vastus?” või „Kuidas faktiliselt täpne kas see on väide?" Need on keerulised eesmärgid, mis nõuavad inimestelt asjade hoolikat kontrollimist. Sel põhjusel koolitame mudelit nende inimeste eelistuste ennustamiseks, mida nimetatakse a tasu mudelja kasutage preemiamudeli ennustusi asenduseesmärgina. Kuid oluline on jälgida, kui hästi tegelik eesmärk on optimeeritud.

Selles postituses vaatleme mõnda matemaatikat, kuidas me seda teeme. Keskendume seadistusele, mis on analüüsimiseks eriti puhas ja kus meil on juurdepääs tõelisele eesmärgile. Praktikas ei pruugi isegi inimeste eelistused mõõta seda, millest me tegelikult hoolime, kuid jätame selle probleemi selles postituses kõrvale.

Parim-$n$ proovivõtt

Puhverserveri eesmärki saab optimeerida mitmel viisil, kuid võib-olla on see kõige lihtsam parim-$n$ proovivõtt, tuntud ka kui tagasilükkamise proovide võtmine or ümberpaigutamine. Me lihtsalt proovime $n$ korda ja valime selle, mis saab vastavalt puhverserveri eesmärgile kõige kõrgema tulemuse.

Kuigi see meetod on väga lihtne, võib see tegelikult olla konkurentsivõimeline arenenumate tehnikatega, nagu tugevdav õpe, ehkki rohkemate järelduste aja arvutamise hinnaga. Näiteks sisse WebGPT, ületas meie 64$-st parim mudel meie tugevdamisõppe mudelit, võib-olla osaliselt seetõttu, et 64-$ parima hinnaga mudel sai sirvida palju rohkem veebisaite. Isegi 4 dollari parima hinna rakendamine andis inimeste eelistustele märkimisväärse tõuke.

Lisaks on parimal $n$ valimimisel usaldusväärne jõudlus ja seda on lihtne matemaatiliselt analüüsida, mistõttu sobib see hästi Goodharti seaduse ja sellega seotud nähtuste empiirilisteks uuringuteks.

Parima-$n$ valimi matemaatika

Uurime formaalsemalt parimat-$n$ valimit. Oletame, et meil on mingi näidisruum $S$ (näiteks võimalike küsimuste-vastuste paaride hulk), mingi tõenäosusjaotus $P$ üle $S$, tõeline eesmärk (või "tasu") $R_{text{true}}:Stomathbb R$, ja puhver-eesmärk $R_{text{proxy}}:Stomathbb R$. Oletame, et optimeerime kuidagi $R_{text{proxy}}$ ja saame seeläbi uue distributsiooni $P^prime$. siis:

- Ootus $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ mõõdab, kui hästi oleme tegeliku eesmärgi optimeerinud.

- . KL lahknemine $D_{text{KL}}left(P^primeparallel Pright)$ mõõdab, kui palju optimeerimist oleme teinud. Näiteks kui $P^prime$ saadakse, võttes $P$ esimese valimi, mis asub mingis alamhulgas $S^primesubseteq S$, siis see KL-i lahknevus on lihtsalt negatiivne log-tõenäosus, et $P$ valim asub väärtuses $S^prime$.

Selgub, et parima-$n$ proovivõtu korral saab mõlemat kogust tõhusalt hinnata, kasutades proove alates $P$.

Vaatame kõigepealt ootusi. Naiivne lähenemine on kasutada Monte Carlo hindajat: käitage mitu korda parimat $n$ valimit, mõõtke nende proovide tegelik eesmärk ja keskmistage tulemused. Siiski on parem hindaja. Kui meil on $Ngeq n$ proovid $P$-st üldiselt, siis saame samaaegselt kaaluda iga võimaliku alamhulga nendest proovidest suurusega $n$ kaaluge iga valimit alamhulkade arvuga, mille jaoks see on puhvereesmärgi järgi parim, ja seejärel võtke kaalutud keskmine tegelik eesmärgi skoor. See kaal on lihtsalt binoomkoefitsient $binom{k-1}{n-1}$, kus $k$ on valimi asetus puhverserveri eesmärgi all, alates $1$ (halvim) kuni $N$ (parim). Lisaks näidiste tõhusamale kasutamisele võimaldab see meil ka proove uuesti kasutada erinevate $n$ väärtuste jaoks.

Mis puutub KL-i lahknemisse, siis üllataval kombel selgub, et sellel on täpne valem, mis töötab iga pideva tõenäosusjaotuse $P$ korral (st seni, kuni $P$-l pole punktmassi). Võib naiivselt arvata, et vastus on $log n$, kuna $n$ parim teeb midagi, nagu võtab jaotuse $frac 1n$ ülemise osa, ja see on ligikaudu õige: täpne vastus on $log n-frac{n-1}n$.

Need hinnangud koos võimaldavad meil hõlpsasti analüüsida, kuidas tegelik eesmärk varieerub sõltuvalt puhvereesmärgile rakendatud optimeerimise mahust.

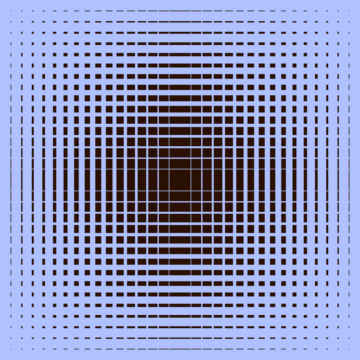

Siin on näide elust WebGPT:

WebGPT 175B jaoks parim jõudlus $n$ eest

WebGPT jaoks $n$ parim jõudlus, varjutatud piirkonnad tähistavad standardviga $pm 1$ ja KL-telg järgib ruutjuure skaalat. Siin annab algse jaotuse ($P$) 175B mudel, mis on koolitatud käitumise kloonimise abil, puhverserveri eesmärk, mida kasutatakse parima $n$ ($R_{text{proxy}}$) arvutamiseks, annab koolitus. tasu mudelit ja me võtame arvesse kolme oletatavat "tõelist" eesmärki ($R_{text{true}}$): koolitustasu mudel ise, väljastatud andmete põhjal koolitatud valideerimispreemia mudel ja tegelikud inimeste eelistused. Puhverserveri eesmärki pole palju üle optimeeritud, kuid eeldame, et see on kõrgemate KL-de korral.

See ületab $n$ parimatest proovivõtmist

Best-of-$n$ diskretsiooni peamiseks piiranguks on see, et KL-i lahknevus kasvab logaritmiliselt $n$-ga, seega sobib see vaid vähese optimeerimise rakendamiseks.

Suurema optimeerimise rakendamiseks kasutame tavaliselt tugevdusõpet. Seni uuritud seadetes, näiteks kokkuvõte, oleme tavaliselt suutnud saavutada umbes 10 KL-i nats kasutades tugevdusõpet enne, kui tegelik eesmärk Goodharti seaduse tõttu langema hakkab. Peaksime kuluma $ n $, et olla umbes 60,000 XNUMX, et jõuda sellesse KL-i kasutades parim $n$-st, ja loodame, et suudame jõuda palju suuremate KL-deni, kui täiustame oma tasu modelleerimise ja tugevdamise õppepraktikaid.

Samas pole kõik natsid võrdsed. Empiiriliselt optimeerib väikeste KL-i eelarvete puhul parim-$n$ parem nii puhverserveri kui ka tegelikke eesmärke kui tugevdav õpe. Intuitiivselt on parim $n$-st "toore jõu" lähenemisviis, mis muudab selle teabeteoreetiliselt tõhusamaks kui tugevdav õpe, kuid arvutuslikult vähem tõhus suurtes KL-des.

Osana oma tööst uurime aktiivselt puhverserveri eesmärkide skaleerimisomadusi viia meie mudelid inimlike kavatsuste ja väärtustega. Kui soovite meid selle uurimistööga aidata, siis me seda teeme rentides!

- AI

- ai kunst

- ai kunsti generaator

- on robot

- tehisintellekti

- tehisintellekti sertifikaat

- tehisintellekt panganduses

- tehisintellekti robot

- tehisintellekti robotid

- tehisintellekti tarkvara

- blockchain

- plokiahela konverents ai

- coingenius

- vestluslik tehisintellekt

- krüptokonverents ai

- dall's

- sügav õpe

- google ai

- masinõpe

- OpenAI

- Platon

- plato ai

- Platoni andmete intelligentsus

- Platoni mäng

- PlatoData

- platogaming

- teadustöö

- skaala ai

- süntaks

- sephyrnet