تصویر توسط نویسنده

XAI هوش مصنوعی است که به انسان اجازه می دهد تا نتایج و فرآیندهای تصمیم گیری مدل یا سیستم را درک کند.

پیش مدلسازی توضیح پذیری

هوش مصنوعی قابل توضیح با داده های قابل توضیح و مهندسی ویژگی های واضح و قابل تفسیر شروع می شود.

مدلسازی توضیح پذیری

هنگام انتخاب یک مدل برای یک مشکل خاص، به طور کلی بهتر است از قابل تفسیرترین مدل استفاده شود که همچنان به نتایج پیشبینی خوبی میرسد.

توضیح پذیری پس مدل

این شامل تکنیک هایی مانند اغتشاش است، که در آن اثر تغییر یک متغیر منفرد بر خروجی مدل مانند مقادیر SHAP برای بعد از آموزش تحلیل می شود.

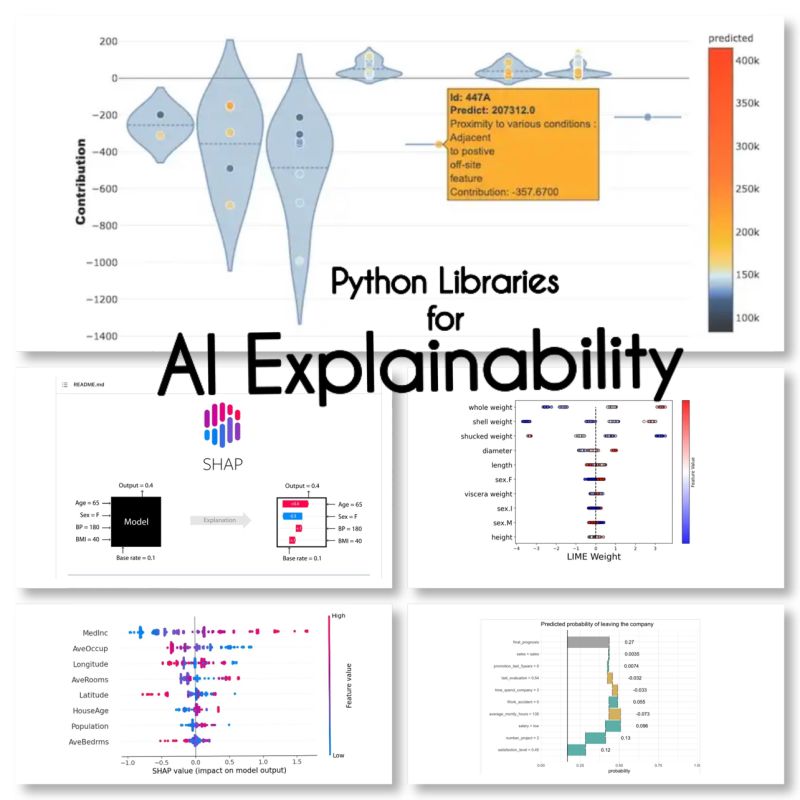

من این 10 کتابخانه پایتون را برای توضیح هوش مصنوعی پیدا کردم:

SHAP (توضیحات افزودنی SHapley)

SHAP یک مدل آگنوستیک است و با تجزیه سهم هر ویژگی و نسبت دادن امتیاز به هر ویژگی کار می کند.

LIME (توضیحات مدل قابل تفسیر محلی-آگنوستیک)

LIME یکی دیگر از روش های آگنوستیک مدل است که با تقریب رفتار مدل به صورت محلی حول یک پیش بینی خاص کار می کند.

ELi5

Eli5 کتابخانه ای برای اشکال زدایی و توضیح طبقه بندی کننده ها است. این امتیازات اهمیت ویژگی، و همچنین «کدهای دلیل» را برای scikit-learn، Keras، xgboost، LightGBM، CatBoost ارائه میکند.

شاپاش

Shapash یک کتابخانه پایتون است که هدف آن این است که یادگیری ماشین را برای همه قابل تفسیر و قابل درک کند. Shapash انواع مختلفی از تجسم را با برچسب های واضح ارائه می دهد.

مجریان

لنگرها روشی برای تولید قوانین قابل تفسیر برای انسان است که می تواند برای توضیح پیش بینی های یک مدل یادگیری ماشین استفاده شود.

XAI (هوش مصنوعی قابل توضیح)

XAI کتابخانه ای برای توضیح و تجسم پیش بینی های مدل های یادگیری ماشین از جمله امتیازات اهمیت ویژگی است.

درهم شکستن

BreakDown ابزاری است که می تواند برای توضیح پیش بینی های مدل های خطی استفاده شود. با تجزیه خروجی مدل به سهم هر ویژگی ورودی کار می کند.

تفسیر متن

interpret-text کتابخانه ای برای توضیح پیش بینی های مدل های پردازش زبان طبیعی است.

iml (یادگیری ماشینی قابل تفسیر)

iml در حال حاضر شامل رابط و کد IO از پروژه Shap است و احتمالاً همین کار را برای پروژه Lime نیز انجام خواهد داد.

aix360 (AI Explainability 360)

aix360 شامل مجموعه ای جامع از الگوریتم ها است که ابعاد مختلف را پوشش می دهد

OmniXAI

OmniXAI (مخفف Omni eXplainable AI)، به چندین مشکل در تفسیر قضاوت های تولید شده توسط مدل های یادگیری ماشین در عمل می پردازد.

آیا هیچ کتابخانه ای را فراموش کرده ام؟

منابع

مریم میرادی یک رهبر هوش مصنوعی و علوم داده با مدرک دکترا در یادگیری ماشین و یادگیری عمیق، متخصص در NLP و بینایی کامپیوتر است. او بیش از 15 سال تجربه ایجاد راه حل های موفق هوش مصنوعی با سابقه ارائه بیش از 40 پروژه موفق دارد. او برای 12 سازمان مختلف در صنایع مختلف از جمله تشخیص جرایم مالی، انرژی، بانکداری، خرده فروشی، تجارت الکترونیک و دولت کار کرده است.

- محتوای مبتنی بر SEO و توزیع روابط عمومی. امروز تقویت شوید.

- پلاتوبلاک چین. Web3 Metaverse Intelligence. دانش تقویت شده دسترسی به اینجا.

- منبع: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- آدرس

- پس از

- AI

- اهداف

- الگوریتم

- اجازه می دهد تا

- و

- دیگر

- دور و بر

- مصنوعی

- هوش مصنوعی

- بانکداری

- بهترین

- شکستن

- متغیر

- انتخاب

- واضح

- رمز

- جامع

- کامپیوتر

- چشم انداز کامپیوتر

- شامل

- سهم

- پوشش

- ایجاد

- جرم

- در حال حاضر

- داده ها

- علم اطلاعات

- تصمیم گیری

- تصمیم گیری

- عمیق

- یادگیری عمیق

- تحویل

- مختلف

- پایین

- تجارت الکترونیک

- هر

- اثر

- انرژی

- مهندسی

- هر کس

- تجربه

- توضیح دهید

- قابل توضیح

- AI قابل توضیح

- توضیح دادن

- ویژگی

- مالی

- مالی-جرم

- فراموش

- یافت

- از جانب

- عموما

- مولد

- خوب

- دولت

- HTTPS

- انسان

- اهمیت

- in

- شامل

- از جمله

- لوازم

- ورودی

- اطلاعات

- رابط

- IT

- قضاوت ها

- kdnuggets

- کراس

- برچسب ها

- زبان

- رهبری

- یادگیری

- کتابخانه ها

- کتابخانه

- اهک

- لینک

- محلی

- به صورت محلی

- دستگاه

- فراگیری ماشین

- ساخت

- روش

- مدل

- مدل

- اکثر

- طبیعی

- زبان طبیعی

- پردازش زبان طبیعی

- nlp

- هتلز

- سازمان های

- ویژه

- افلاطون

- هوش داده افلاطون

- PlatoData

- بالقوه

- تمرین

- پیش گویی

- پیش بینی

- مشکل

- مشکلات

- فرآیندهای

- در حال پردازش

- ساخته

- پروژه

- پروژه ها

- فراهم می کند

- پــایتــون

- دلیل

- رکورد

- نتایج

- خرده فروشی

- قوانین

- همان

- علم

- یادگیری

- تنظیم

- چند

- کوتاه

- تنها

- مزایا

- تخصصی

- خاص

- شروع می شود

- هنوز

- موفق

- چنین

- سیستم

- تکنیک

- La

- به

- ابزار

- مسیر

- آموزش

- انواع

- فهمیدن

- قابل فهم

- استفاده کنید

- ارزشها

- تنوع

- دید

- تجسم

- که

- اراده

- مشغول به کار

- با این نسخهها کار

- XGBoost

- سال

- شما

- زفیرنت