Lorsque Google a annoncé que son ordinateur quantique avait résolu un problème au-delà du capacité de la supercalculateur le plus puissant, il constituait une référence pour l'industrie. Mais des chercheurs chinois ont montré qu'ils pouvaient résoudre le même problème sur un supercalculateur normal en quelques secondes.

La promesse ultime du quantique informatique is sa capacité pour réaliser certaines prouesses informatiques beaucoup plus rapidement que les machines classiques, ou même résoudre des problèmes qui seraient essentiellement impossibles à résoudre en utilisant des approches traditionnelles.

Le domaine est encore naissant, et les appareils d'aujourd'hui sont bien trop petits pour être mis au travail sur des défis du monde réel. Mais dans un effort pour prouver que le domaine progresse, les développeurs de processeurs quantiques ont été impatients de trouver des problèmes qui n'ont peut-être pas beaucoup d'utilité pratique, mais qui peuvent démontrer les accélérations potentielles dont leur technologie est capable.

Google a fait une percée majeure sur ce front en 2019 lorsqu'il a affirmé que son Processeur Sycomore avait résolu un problème qui prendrait 10,000 200 ans à un supercalculateur en seulement XNUMX secondes. Le problème a été truqué en leur faveur, car il s'agissait essentiellement de simuler la sortie de leur processeur, mais en montrant qu'un ordinateur classique aurait du mal, ils ont pu revendiquer la «suprématie quantique», plus communément appelée «avantage quantique» aujourd'hui.

Mais maintenant, les chercheurs de Chinun avoir résolu le même problème en seulement 15 heures en utilisant sune conception algorithmique intelligente et un ordinateur modérément grand. Selon leurs calculs, cela ne prendrait que quelques dizaines de secondes s'ils avaient accès à des supercalculateurs de taille normale.

Le défi que s'était fixé Google était de simuler son processeur agissant plus ou moins comme un générateur de nombres aléatoires. La seule différence était qu’ils répétaient l’algorithme des millions de fois et qu’en raison de la nature de l’algorithme, un certain modèle devrait émerger dans les nombres aléatoires crachés.

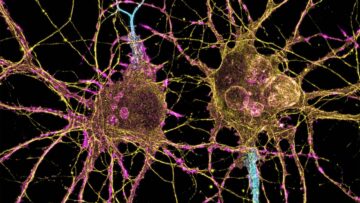

Simuler cela sur un ordinateur classique devrait rapidement devenir difficile à mesure que la taille du processeur augmente, car la quantité d'informations codées augmente de façon exponentielle avec chaque qubit supplémentaire. En utilisant des approches conventionnelles pour résoudre ce problème, Google a prédit qu'il faudrait 10,000 53 ans pour simuler son processeur de XNUMX qubits.

L'équipe de l'Institut de physique théorique de l'Académie chinoise des sciences s'est aautour de cela en retravaillant les mathématiques sous-jacentes utilisées pour résoudre le problème. Ils ont représenté le processeur comme un réseau 3D d'objets mathématiques appelés tenseurs qui représentent les portes logiques entre les 53 qubits. Ce réseau a été répété sur 20 couches, conçues pour représenter les 20 cycles parcourus par l'algorithme quantique avant que la sortie du processeur ne soit lue.

L'avantage d'utiliser des tenseurs est que les GPU, les puces qui ont propulsé la révolution du deep learning, sont capables de les traiter très rapidement en parallèle. Les chercheurs ont également profité du fait que les calculs de Google sur Sycamore n'étaient pas très précis, atteignant une fidélité de seulement 0.2 %. Cela leur a permis de sacrifier une partie de la précision de leur simulation pour augmenter sa vitesse, ce qu'ils ont fait en supprimant certaines des connexions entre les qubits.

Le résultat a été qu'ils ont réussi à simuler la sortie du processeur Sycamore avec une fidélité de 0.37 % en seulement 15 heures sur 512 GPU, soit une puissance de traitement considérablement inférieure à celle de la plupart des supercalculateurs. Un article décrivant les résultats est actuellement sous presse à Physical Review Letters, mais sans examen par les pairsed la pré-impression a été publiée en novembre dernier.

Bien que le résultat éclate quelque peu la bulle de suprématie quantique de Google, dans un e-mail à Sciences, la société a souligné qu'elle avait prédit que les algorithmes classiques s'amélioreraient dans son article de 2019. Mais ils ajoutent qu'ils ne pensent pas pouvoir suivre longtemps l'augmentation exponentielle des performances des ordinateurs quantiques.

Il s'agit d'avoir un lien direct avec le cœur des opérations de votre pas la seule expérience de suprématie quantique à être annulée. En 2020, un Chinois équipe ont affirmé qu'un problème que leur ordinateur quantique pourrait résoudre en 200 secondesnds prendrait 2.5 milliards d'années à un supercalculateur, mais en janvier, des chercheurs ont montré que cela ne prendrait en réalité que 73 jours.

Bien que cela n'annule pas les progrès réalisés dans le domaine, un chœur croissant de chercheurs affirme que mettre les machines quantiques et classiques les unes contre les autres sur ce type de problèmes de calcul abstraits ne donne pas vraiment une idée claire de la technologie. at.

Le véritable test, disent-ils, sera lorsque les ordinateurs quantiques seront capables de résoudre des problèmes du monde réel plus rapidement et plus efficacement que les problèmes classiques. Et cela semble être encore loin.

Crédit d'image: Google

- AI

- art de l'IA

- générateur d'art ai

- robot IA

- intelligence artificielle

- certification en intelligence artificielle

- intelligence artificielle en banque

- robot d'intelligence artificielle

- robots d'intelligence artificielle

- logiciel d'intelligence artificielle

- blockchain

- conférence blockchain ai

- cognitif

- informatique

- intelligence artificielle conversationnelle

- crypto conférence ai

- de dall

- l'apprentissage en profondeur

- google ai

- machine learning

- Platon

- platon ai

- Intelligence des données Platon

- Jeu de Platon

- PlatonDonnées

- jeu de platogamie

- échelle ai

- Singularity Hub

- syntaxe

- Les sujets

- zéphyrnet