L'IA et les ordinateurs conventionnels sont un match fait en enfer.

La raison principale est la façon dont les puces matérielles sont actuellement configurées. Basée sur l'architecture traditionnelle de Von Neumann, la puce isole le stockage de la mémoire de ses processeurs principaux. Chaque calcul est un trajet cauchemardesque le lundi matin, la puce faisant constamment la navette entre les données de chaque compartiment, formant un notoire "mur de la mémoire. »

Si vous avez déjà été coincé dans les embouteillages, vous connaissez la frustration : cela prend du temps et gaspille de l'énergie. À mesure que les algorithmes d'IA deviennent de plus en plus complexes, le problème s'aggrave de plus en plus.

Alors pourquoi ne pas concevoir une puce basée sur le cerveau, une adéquation potentielle parfaite avec les réseaux de neurones profonds ?

Entrez les puces de calcul en mémoire ou CIM. Fidèles à leur nom, ces puces calculent et stockent de la mémoire sur le même site. Oubliez les trajets ; les puces sont des alternatives de travail à domicile très efficaces, résolvant le problème de goulot d'étranglement du trafic de données et promettant une efficacité accrue et une consommation d'énergie réduite.

Ou alors va la théorie. La plupart des puces CIM exécutant des algorithmes d'IA se sont uniquement concentrées sur la conception de puces, mettant en valeur leurs capacités en utilisant des simulations de la puce plutôt que d'exécuter des tâches sur du matériel à part entière. Les puces ont également du mal à s'adapter à plusieurs tâches d'IA différentes (reconnaissance d'image, perception de la voix), ce qui limite leur intégration dans les smartphones ou d'autres appareils du quotidien.

Ce mois-ci, selon une étude in Nature CIM amélioré à partir de zéro. Plutôt que de se concentrer uniquement sur la conception de la puce, l'équipe internationale, dirigée par des experts en matériel neuromorphique, le Dr HS Philip Wong à Stanford et le Dr Gert Cauwenberghs à l'UC San Diego, a optimisé l'ensemble de la configuration, de la technologie à l'architecture en passant par les algorithmes qui calibrent le matériel. .

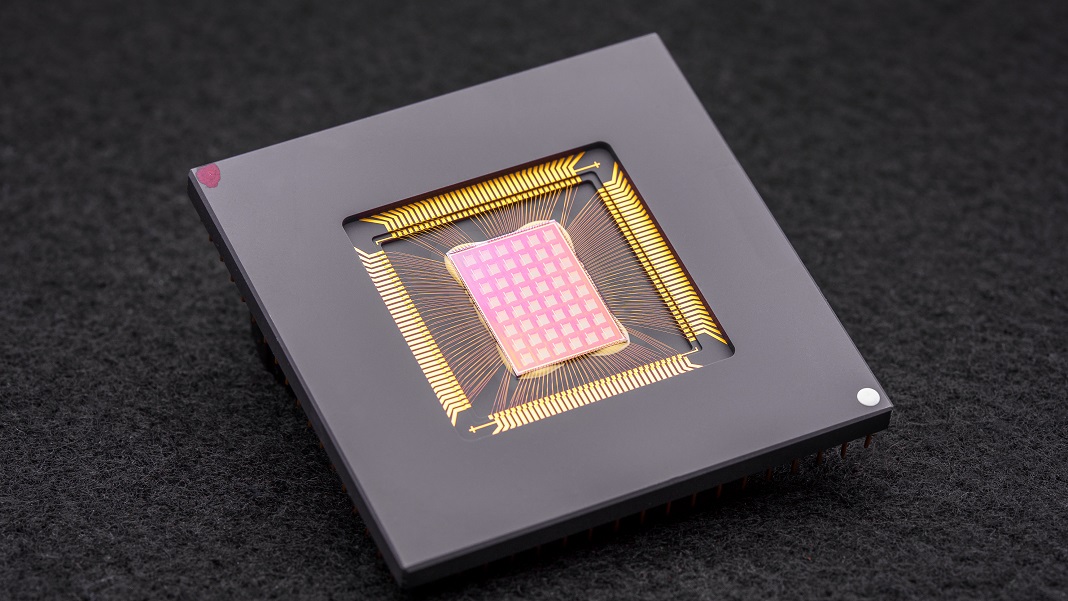

La puce NeuRRAM qui en résulte est un puissant mastodonte informatique neuromorphique avec 48 cœurs parallèles et 3 millions de cellules de mémoire. Extrêmement polyvalente, la puce s'est attaquée à plusieurs tâches standard d'IA, telles que la lecture de chiffres manuscrits, l'identification de voitures et d'autres objets dans des images et le décodage d'enregistrements vocaux, avec une précision de plus de 84 %.

Bien que le taux de réussite puisse sembler médiocre, il rivalise avec les puces numériques existantes mais économise considérablement d'énergie. Pour les auteurs, c'est un pas de plus vers l'introduction directe de l'IA sur nos appareils plutôt que d'avoir à transporter les données vers le cloud pour le calcul.

"Le fait d'effectuer ces calculs sur la puce au lieu d'envoyer des informations vers et depuis le cloud pourrait permettre une IA plus rapide, plus sécurisée, moins chère et plus évolutive à l'avenir, et donner à plus de personnes accès à la puissance de l'IA", a affirmé Valérie Plante. Wong

Inspiration neuronale

Puces spécifiques à l'IA sont maintenant un centime étonnant par douzaine. De l'unité de traitement Tensor (TPU) de Google et de l'architecture de superordinateur Dojo de Tesla à Baidu et Amazon, les géants de la technologie investissent des millions dans la ruée vers l'or des puces IA pour construire des processeurs qui prennent en charge des algorithmes d'apprentissage en profondeur de plus en plus sophistiqués. Certains même puiser dans l'apprentissage automatique pour concevoir des architectures de puces conçu pour les logiciels d'IA, bouclant la course.

Un concept particulièrement intrigant vient directement du cerveau. Au fur et à mesure que les données traversent nos neurones, elles se "connectent" à des réseaux via des "docks" physiques appelés synapses. Ces structures, assises au sommet de branches neurales comme de petits champignons, sont multitâches : elles calculent et stockent des données en modifiant leur composition protéique.

En d'autres termes, les neurones, contrairement aux ordinateurs classiques, n'ont pas besoin de transférer les données de la mémoire vers les processeurs. Cela donne au cerveau son avantage sur les appareils numériques : il est très économe en énergie et effectue plusieurs calculs simultanément, le tout emballé dans une gelée de trois livres fourrée à l'intérieur du crâne.

Pourquoi ne pas recréer des aspects du cerveau ?

Entrer calcul neuromorphique. Un hack consistait à utiliser des RRAM ou des dispositifs de mémoire à accès aléatoire résistifs (également appelés « memristors »). Les RRAM stockent de la mémoire même lorsqu'elles sont coupées de l'alimentation en modifiant la résistance de leur matériel. Semblables aux synapses, ces composants peuvent être regroupés en réseaux denses sur une zone minuscule, créant des circuits capables de calculs très complexes sans encombrement. Lorsqu'il est combiné avec CMOS, un processus de fabrication pour la construction de circuits dans nos microprocesseurs et puces actuels, le duo devient encore plus puissant pour exécuter des algorithmes d'apprentissage en profondeur.

Mais cela a un coût. "Le calcul analogique hautement parallèle dans l'architecture RRAM-CIM apporte une efficacité supérieure, mais il est difficile d'atteindre le même niveau de flexibilité fonctionnelle et de précision de calcul que dans les circuits numériques", ont déclaré les auteurs.

Génie de l'optimisation

La nouvelle étude s'est penchée sur chaque partie d'une puce RRAM-CIM, en la repensant pour une utilisation pratique.

Cela commence par la technologie. NeuRRAM dispose de 48 cœurs qui calculent en parallèle, avec des dispositifs RRAM physiquement entrelacés dans des circuits CMOS. Comme un neurone, chaque cœur peut être éteint individuellement lorsqu'il n'est pas utilisé, préservant ainsi l'énergie tandis que sa mémoire est stockée sur la RRAM.

Ces cellules RRAM, toutes trois millions, sont reliées afin que les données puissent être transférées dans les deux sens. C'est une conception cruciale, permettant à la puce de s'adapter de manière flexible à plusieurs types d'algorithmes d'IA différents, ont expliqué les auteurs. Par exemple, un type de réseau neuronal profond, CNN (réseau neuronal convolutif), est particulièrement efficace en vision par ordinateur, mais a besoin que les données circulent dans une seule direction. En revanche, les LSTM, un type de réseau neuronal profond souvent utilisé pour la reconnaissance audio, traitent de manière récurrente les données pour faire correspondre les signaux avec le temps. Comme les synapses, la puce code la force avec laquelle un «neurone» RRAM se connecte à un autre.

Cette architecture a permis d'affiner les flux de données pour minimiser les embouteillages. Comme l'expansion du trafic à voie unique vers plusieurs voies, la puce pourrait dupliquer la «mémoire» actuelle d'un réseau à partir des problèmes les plus intensifs en calcul, de sorte que plusieurs cœurs analysent le problème simultanément.

Une dernière retouche aux puces CIM précédentes était un pont plus fort entre le calcul de type cérébral - souvent analogique - et le traitement numérique. Ici, la puce utilise un circuit neuronal qui peut facilement convertir le calcul analogique en signaux numériques. C'est un pas en avant par rapport aux configurations précédentes « gourmandes en énergie et en surface », ont expliqué les auteurs.

Les optimisations ont fonctionné. Mettant leur théorie à l'épreuve, l'équipe a fabriqué la puce NeuRRAM et développé des algorithmes pour programmer le matériel pour différents algorithmes, comme la Play Station 5 exécutant différents jeux.

Dans une multitude de tests de référence, la puce a fonctionné comme un champion. Exécutant un CNN à sept couches sur la puce, NeuRRAM avait un taux d'erreur inférieur à XNUMX% lors de la reconnaissance des chiffres manuscrits à l'aide de la base de données populaire MNIST.

Il excellait également dans les tâches plus difficiles. En chargeant un autre réseau de neurones profonds populaire, LSTM, la puce était correcte à environ 85 % lorsqu'elle était confrontée à la reconnaissance des commandes vocales de Google. En utilisant seulement huit cœurs, la puce, fonctionnant sur une autre architecture d'intelligence artificielle, a pu récupérer des images bruyantes, réduisant les erreurs d'environ 70 %.

Et alors?

Un mot : énergie.

La plupart des algorithmes d'IA sont des porcs d'énergie totale. NeuRRAM fonctionnait à la moitié du coût énergétique des puces RRAM-CIM de pointe précédentes, traduisant davantage la promesse d'économies d'énergie avec l'informatique neuromorphique en réalité.

Mais la particularité de l'étude est sa stratégie. Trop souvent, lors de la conception de puces, les scientifiques doivent équilibrer l'efficacité, la polyvalence et la précision pour plusieurs tâches, des mesures qui sont souvent en contradiction les unes avec les autres. Le problème devient encore plus difficile lorsque tout le calcul est effectué directement sur le matériel. NeuRRAM a montré qu'il est possible de combattre toutes les bêtes à la fois.

La stratégie utilisée ici peut être utilisée pour optimiser d'autres dispositifs informatiques neuromorphiques tels que technologie de mémoire à changement de phases, ont déclaré les auteurs.

Pour l'instant, NeuRRAM est une preuve de concept, montrant qu'une puce physique, plutôt qu'une simulation de celle-ci, fonctionne comme prévu. Mais il y a place à l'amélioration, y compris la mise à l'échelle supplémentaire des RRAM et la réduction de sa taille pour qu'elle puisse un jour s'adapter à nos téléphones.

"Peut-être qu'aujourd'hui, il est utilisé pour effectuer des tâches d'IA simples telles que la détection de mots clés ou la détection humaine, mais demain, il pourrait permettre une expérience utilisateur complètement différente. Imaginez l'analyse vidéo en temps réel combinée à la reconnaissance vocale dans un petit appareil », a affirmé Valérie Plante. auteur de l'étude, le Dr Weier Wan. "En tant que chercheur et ingénieur, mon ambition est de mettre en pratique les innovations de la recherche issues des laboratoires."

Crédit image: David Baillot/Université de Californie à San Diego