Bruce Warrington via Unsplash

La raison pour laquelle les modèles d'apprentissage automatique en général deviennent plus intelligents est due à leur dépendance à l'utilisation de données étiquetées pour les aider à discerner entre deux objets similaires.

Cependant, sans ces ensembles de données étiquetés, vous rencontrerez des obstacles majeurs lors de la création du modèle d'apprentissage automatique le plus efficace et le plus fiable. Les ensembles de données étiquetés pendant la phase de formation d'un modèle sont importants.

L'apprentissage en profondeur a été largement utilisé pour résoudre des tâches telles que la vision par ordinateur en utilisant l'apprentissage supervisé. Cependant, comme pour beaucoup de choses dans la vie, cela s'accompagne de restrictions. La classification supervisée nécessite une quantité et une qualité élevées de données d'apprentissage étiquetées afin de produire un modèle robuste. Cela signifie que le modèle de classification ne peut pas gérer les classes invisibles.

Et nous savons tous combien de puissance de calcul, de recyclage, de temps et d'argent il faut pour former un modèle d'apprentissage en profondeur.

Mais un modèle peut-il encore être capable de discerner entre deux objets sans avoir utilisé de données d'apprentissage ? Oui, c'est ce qu'on appelle l'apprentissage zéro coup. L'apprentissage zéro coup est la capacité d'un modèle à pouvoir accomplir une tâche sans avoir reçu ou utilisé d'exemples de formation.

Les humains sont naturellement capables d'apprendre sans effort. Nos cerveaux stockent déjà des dictionnaires et nous permettent de différencier les objets en examinant leurs propriétés physiques grâce à notre base de connaissances actuelle. Nous pouvons utiliser cette base de connaissances pour voir les similitudes et les différences entre les objets et trouver le lien entre eux.

Par exemple, disons que nous essayons de construire un modèle de classification sur les espèces animales. Selon NotreMondeEnDonnées, il y avait 2.13 millions d'espèces calculées en 2021. Par conséquent, si nous voulons créer le modèle de classification le plus efficace pour les espèces animales, nous aurions besoin de 2.13 millions de classes différentes. De nombreuses données seront également nécessaires. Les données de grande quantité et de qualité sont difficiles à trouver.

Alors, comment l'apprentissage zéro coup résout-il ce problème ?

Étant donné que l'apprentissage zéro coup ne nécessite pas que le modèle ait appris les données d'apprentissage et comment classer les classes, il nous permet de nous fier moins au besoin du modèle en données étiquetées.

Voici ce que vos données devront être constituées pour procéder à l'apprentissage zéro coup.

Cours vus

Il s'agit des classes de données qui ont été précédemment utilisées pour former un modèle.

Cours Inédits

Il s'agit des classes de données qui n'ont PAS été utilisées pour former un modèle et le nouveau modèle d'apprentissage zéro coup se généralisera.

Informations auxiliaires

Comme les données des classes invisibles ne sont pas étiquetées, l'apprentissage zéro coup nécessitera des informations auxiliaires pour apprendre et trouver des corrélations, des liens et des propriétés. Cela peut prendre la forme d'incorporations de mots, de descriptions et d'informations sémantiques.

Méthodes d'apprentissage Zero-shot

L'apprentissage zéro coup est généralement utilisé dans :

- Méthodes basées sur les classificateurs

- Méthodes basées sur les instances

Étapes

L'apprentissage zéro coup est utilisé pour construire des modèles pour les classes qui ne s'entraînent pas à l'aide de données étiquetées, il nécessite donc ces deux étapes :

1. Formation

L'étape de formation est le processus de la méthode d'apprentissage essayant de capturer autant de connaissances que possible sur les qualités des données. Nous pouvons considérer cela comme la phase d'apprentissage.

2. Inférence

Au cours de la phase d'inférence, toutes les connaissances acquises lors de la phase de formation sont appliquées et utilisées afin de classer les exemples dans un nouvel ensemble de classes. Nous pouvons considérer cela comme la phase de réalisation des prédictions.

Comment ça marche?

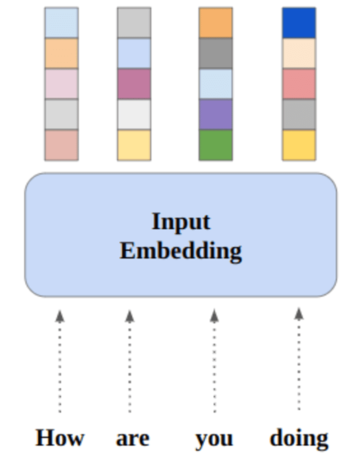

Les connaissances des classes vues seront transférées aux classes invisibles dans un espace vectoriel de grande dimension ; c'est ce qu'on appelle l'espace sémantique. Par exemple, dans la classification d'images, l'espace sémantique ainsi que l'image subiront deux étapes :

1. Espace d'encastrement commun

C'est là que les vecteurs sémantiques et les vecteurs de la caractéristique visuelle sont projetés.

2. Similitude la plus élevée

C'est là que les caractéristiques sont comparées à celles d'une classe invisible.

Pour aider à comprendre le processus avec les deux étapes (apprentissage et inférence), appliquons-les dans l'utilisation de la classification d'images.

Formation

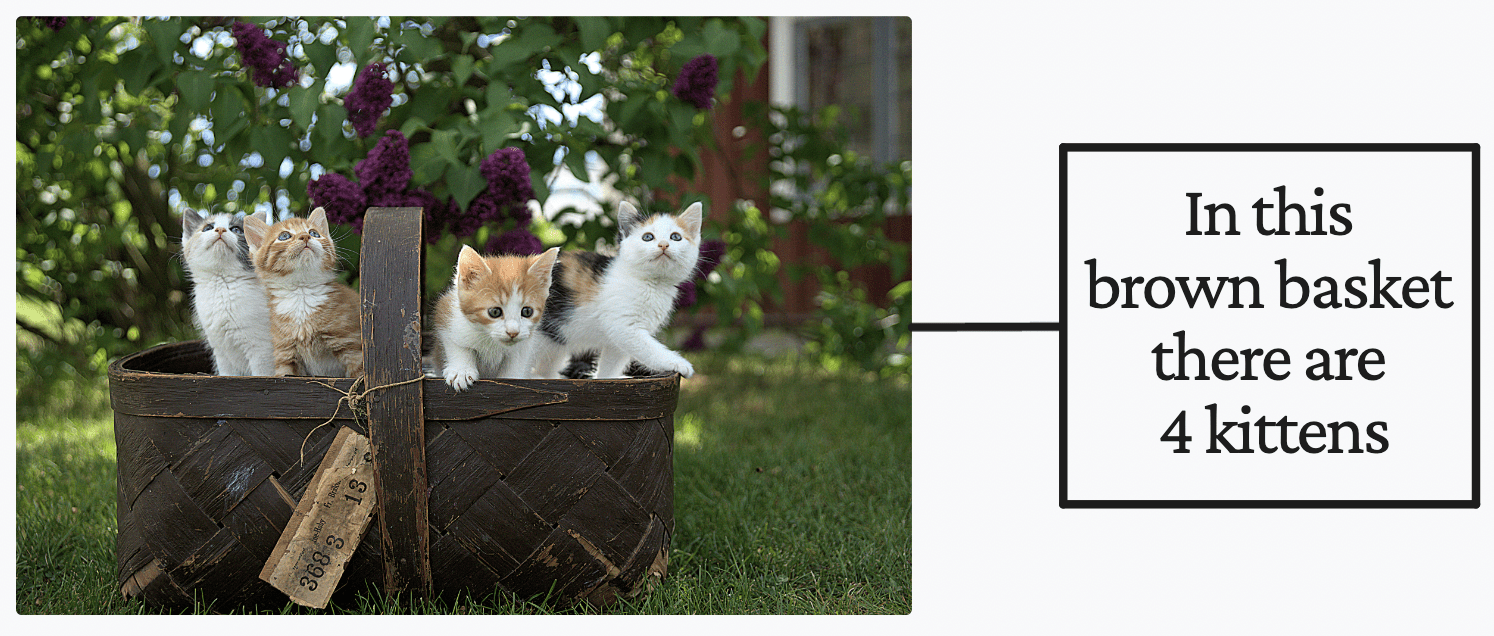

Jari Hytonen via Unsplash

En tant qu'être humain, si vous deviez lire le texte à droite dans l'image ci-dessus, vous supposeriez instantanément qu'il y a 4 chatons dans un panier marron. Mais disons que vous n'avez aucune idée de ce qu'est un « chaton ». Vous supposerez qu'il y a un panier marron avec 4 choses à l'intérieur, qui s'appellent des "chatons". Une fois que vous rencontrez plus d'images qui contiennent quelque chose qui ressemble à un « chaton », vous serez en mesure de différencier un « chaton » des autres animaux.

C'est ce qui se passe lorsque vous utilisez Préformation Contrastive Langage-Image (CLIP) par OpenAI pour un apprentissage zéro coup dans la classification d'images. Il s'agit d'informations auxiliaires.

Vous pensez peut-être, « eh bien, ce ne sont que des données étiquetées ». Je comprends pourquoi vous pensez cela, mais ils ne le sont pas. Les informations auxiliaires ne sont pas des étiquettes des données, elles sont une forme de supervision pour aider le modèle à apprendre pendant la phase de formation.

Lorsqu'un modèle d'apprentissage zéro coup voit une quantité suffisante d'appariements image-texte, il sera capable de différencier et de comprendre les phrases et leur corrélation avec certains modèles dans les images. En utilisant la technique CLIP « apprentissage contrastif », le modèle d'apprentissage zéro-shot a pu accumuler une bonne base de connaissances pour pouvoir faire des prédictions sur les tâches de classification.

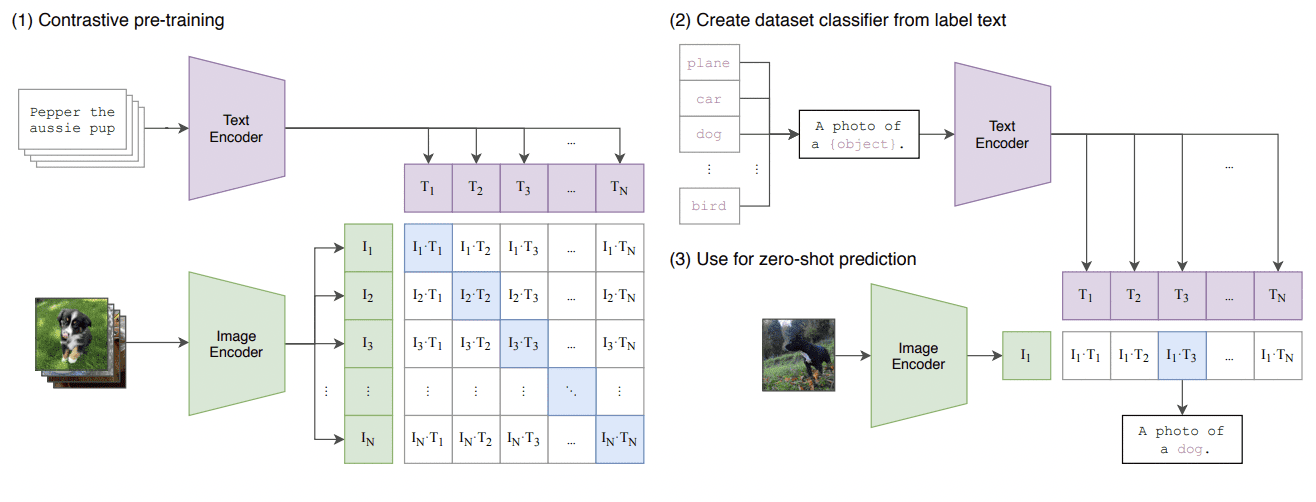

Ceci est un résumé de l'approche CLIP où ils entraînent ensemble un encodeur d'image et un encodeur de texte afin de prédire les appariements corrects d'un lot d'exemples d'entraînement (image, texte). Veuillez voir l'image ci-dessous :

Apprendre des modèles visuels transférables à partir de la supervision du langage naturel

Inférence

Une fois que le modèle a traversé la phase d'apprentissage, il possède une bonne base de connaissances sur l'appariement image-texte et peut maintenant être utilisé pour faire des prédictions. Mais avant de pouvoir commencer à faire des prédictions, nous devons configurer la tâche de classification en créant une liste de toutes les étiquettes possibles que le modèle pourrait générer.

Par exemple, pour s'en tenir à la tâche de classification d'images sur les espèces animales, nous aurons besoin d'une liste de toutes les espèces d'animaux. Chacune de ces étiquettes sera encodée, T? à T? à l'aide de l'encodeur de texte pré-entraîné qui s'est produit lors de l'étape d'apprentissage.

Une fois les étiquettes encodées, nous pouvons entrer des images via l'encodeur d'images pré-formé. Nous utiliserons la similarité cosinus métrique de distance pour calculer les similarités entre l'encodage d'image et chaque encodage d'étiquette de texte.

La classification de l'image se fait en fonction de l'étiquette présentant la plus grande similitude avec l'image. Et c'est ainsi que l'apprentissage zéro coup est réalisé, en particulier dans la classification des images.

Rareté des données

Comme mentionné précédemment, il est difficile d'obtenir des données de grande quantité et de qualité. Contrairement aux humains qui possèdent déjà la capacité d'apprentissage zéro coup, les machines ont besoin de données d'entrée étiquetées pour apprendre et ensuite être capables de s'adapter aux variances qui peuvent survenir naturellement.

Si on regarde l'exemple des espèces animales, il y en avait tellement. Et comme le nombre de catégories continue de croître dans différents domaines, il faudra beaucoup de travail pour suivre la collecte de données annotées.

Pour cette raison, l'apprentissage zéro coup est devenu plus précieux pour nous. De plus en plus de chercheurs s'intéressent à la reconnaissance automatique d'attributs pour pallier le manque de données disponibles.

Étiquetage des données

Un autre avantage de l'apprentissage zéro coup est ses propriétés d'étiquetage des données. L'étiquetage des données peut être laborieux et très fastidieux, et de ce fait, il peut entraîner des erreurs au cours du processus. L'étiquetage des données nécessite des experts, tels que des professionnels de la santé qui travaillent sur un ensemble de données biomédicales, ce qui est très coûteux et prend beaucoup de temps.

L'apprentissage zéro coup devient de plus en plus populaire en raison des limitations de données ci-dessus. Il y a quelques articles que je vous recommande de lire si vous êtes intéressé par ses capacités :

Nisha Arya est Data Scientist et rédacteur technique indépendant. Elle est particulièrement intéressée à fournir des conseils de carrière en science des données ou des tutoriels et des connaissances théoriques sur la science des données. Elle souhaite également explorer les différentes façons dont l'intelligence artificielle est/peut bénéficier à la longévité de la vie humaine. Une apprenante passionnée, cherchant à élargir ses connaissances techniques et ses compétences en écriture, tout en aidant à guider les autres.

- Contenu propulsé par le référencement et distribution de relations publiques. Soyez amplifié aujourd'hui.

- Platoblockchain. Intelligence métaverse Web3. Connaissance Amplifiée. Accéder ici.

- La source: https://www.kdnuggets.com/2022/12/zeroshot-learning-explained.html?utm_source=rss&utm_medium=rss&utm_campaign=zero-shot-learning-explained

- 2021

- a

- capacités

- capacité

- Capable

- À propos

- au dessus de

- Selon

- Accumuler

- atteint

- à travers

- adapter

- conseils

- à opposer à

- Tous

- permet

- déjà

- montant

- ainsi que

- animal

- animaux

- appliqué

- Appliquer

- une approche

- autour

- artificiel

- intelligence artificielle

- Automatique

- disponibles

- base

- basé

- panier

- devenez

- devenir

- before

- va

- ci-dessous

- profiter

- jusqu'à XNUMX fois

- biomédical

- élargir

- construire

- calculé

- appelé

- Peut obtenir

- ne peut pas

- capable

- capturer

- Carrière

- catégories

- certaines

- classe

- les classes

- classification

- Classer

- Collecte

- comment

- complet

- puissance de calcul

- calcul

- ordinateur

- Vision par ordinateur

- continue

- pourriez

- engendrent

- La création

- Courant

- données

- science des données

- Data Scientist

- ensembles de données

- profond

- l'apprentissage en profondeur

- Dépendance

- différences

- différent

- différencier

- distance

- domaines

- pendant

- chacun

- Efficace

- effort

- Erreurs

- exemple

- exemples

- cher

- de santé

- expliqué

- explorez

- Fonctionnalité

- Fonctionnalités:

- few

- Trouvez

- Abonnement

- formulaire

- freelance

- de

- Général

- obtenez

- Bien

- plus

- Croître

- guide

- manipuler

- Mains

- arrive

- Dur

- ayant

- aider

- aider

- Haute

- le plus élevé

- très

- Comment

- How To

- Cependant

- HTTPS

- humain

- Les êtres humains

- idée

- image

- Classification des images

- satellite

- important

- in

- d'information

- contribution

- Intelligence

- intéressé

- IT

- Vif

- XNUMX éléments à

- Savoir

- spécialisées

- connu

- Libellé

- l'étiquetage

- Etiquettes

- Peindre

- langue

- conduire

- APPRENTISSAGE

- savant

- apprentissage

- VIE

- limites

- LINK

- Gauche

- Liste

- longévité

- Style

- recherchez-

- LOOKS

- Lot

- click

- machine learning

- Les machines

- majeur

- faire

- Fabrication

- de nombreuses

- veux dire

- médical

- mentionné

- méthode

- méthodes

- métrique

- pourrait

- million

- modèle

- numériques jumeaux (digital twin models)

- de l'argent

- PLUS

- (en fait, presque toutes)

- Nature

- Besoin

- Nouveauté

- nombre

- objets

- obstacles

- a eu lieu

- ONE

- OpenAI

- de commander

- Autre

- Autres

- appariement

- appariements

- papiers

- particulièrement

- motifs

- phase

- les expressions clés

- Physique

- Platon

- Intelligence des données Platon

- PlatonDonnées

- veuillez cliquer

- Populaire

- possible

- power

- prévoir

- Prédictions

- précédemment

- Problème

- processus

- produire

- ,une équipe de professionnels qualifiés

- projetée

- propriétés

- aportando

- mettre

- qualités

- qualité

- Quantité

- Lire

- raison

- reçu

- reconnaissance

- recommander

- exigent

- a besoin

- chercheurs

- restrictions

- robuste

- Sciences

- Scientifique

- recherche

- voit

- set

- similaires

- similitudes

- compétences

- plus intelligents

- So

- RÉSOUDRE

- quelque chose

- Space

- spécifiquement

- Étape

- étapes

- Étapes

- collage

- Encore

- Boutique

- tel

- suffisant

- RÉSUMÉ

- surveillance

- Prenez

- prend

- Tâche

- tâches

- technologie

- Technique

- La

- leur

- donc

- des choses

- En pensant

- Avec

- fiable

- long

- à

- ensemble

- Train

- Formation

- transféré

- digne de confiance

- tutoriels

- typiquement

- comprendre

- us

- utilisé

- utilisé

- Précieux

- via

- Voir

- vision

- façons

- Quoi

- qui

- Si l’achat

- WHO

- largement

- sera

- sans

- Word

- Activités:

- de travail

- pourra

- écrivain

- écriture

- Votre

- zéphyrnet

- Apprentissage zéro coup