गुडहार्ट का नियम प्रसिद्ध रूप से कहते हैं: "जब कोई उपाय एक लक्ष्य बन जाता है, तो वह एक अच्छा उपाय नहीं रह जाता है।" हालांकि मूल रूप से अर्थशास्त्र से, यह कुछ ऐसा है जिसे हमें OpenAI से जूझना पड़ता है, जब यह पता लगाना होता है कि उन उद्देश्यों को कैसे अनुकूलित किया जाए जिन्हें मापना मुश्किल या महंगा है। कुछ का परिचय देना अक्सर आवश्यक होता है प्रॉक्सी उद्देश्य यह मापना आसान या सस्ता है, लेकिन जब हम ऐसा करते हैं, तो हमें सावधान रहना चाहिए कि हम इसे बहुत अधिक अनुकूलित न करें।

उदाहरण के लिए, हमारे काम के हिस्से के रूप में संरेखित करें मानव इरादे और मूल्यों के साथ जीपीटी -3 जैसे मॉडल, हम "कैसे" जैसी चीजों को अनुकूलित करना चाहते हैं सहायक क्या यह प्रतिक्रिया है?", या "कैसे" तथ्यात्मक रूप से सटीक क्या यह दावा है?"। ये जटिल उद्देश्य हैं जिनके लिए मनुष्यों को चीजों की सावधानीपूर्वक जांच करने की आवश्यकता होती है। इस कारण से, हम इन मानवीय प्राथमिकताओं की भविष्यवाणी करने के लिए एक मॉडल को प्रशिक्षित करते हैं, जिसे a . के रूप में जाना जाता है इनाम मॉडल, और एक प्रॉक्सी उद्देश्य के रूप में इनाम मॉडल की भविष्यवाणियों का उपयोग करें। लेकिन यह ट्रैक करना महत्वपूर्ण है कि वास्तविक उद्देश्य को कितनी अच्छी तरह अनुकूलित किया जा रहा है।

इस पोस्ट में हम यह कैसे करते हैं इसके पीछे के कुछ गणित को देखेंगे। हम एक ऐसी सेटिंग पर ध्यान केंद्रित करेंगे जो विश्लेषण करने के लिए विशेष रूप से साफ हो, जिसमें हमारे पास वास्तविक उद्देश्य तक पहुंच हो। व्यवहार में, यहां तक कि मानवीय प्राथमिकताएं भी यह मापने में विफल हो सकती हैं कि हम वास्तव में किस चीज की परवाह करते हैं, लेकिन हम इस पोस्ट में उस मुद्दे को एक तरफ रख रहे हैं।

बेस्ट-ऑफ़-$n$ सैंपलिंग

ऐसे कई तरीके हैं जिनसे कोई व्यक्ति प्रॉक्सी उद्देश्य को अनुकूलित कर सकता है, लेकिन शायद सबसे सरल है सर्वोत्तम-$n$ नमूनाकरण , जिसे अस्वीकृति नमूनाकरण or पुनर्रैंकिंग. हम केवल $n$ बार नमूना लेते हैं और प्रॉक्सी उद्देश्य के अनुसार उच्चतम स्कोर करने वाले को लेते हैं।

यद्यपि यह विधि बहुत सरल है, यह वास्तव में अधिक उन्नत तकनीकों जैसे कि सुदृढीकरण सीखने के साथ प्रतिस्पर्धी हो सकती है, यद्यपि अधिक अनुमान-समय गणना की कीमत पर। उदाहरण के लिए, में वेबजीपीटी, हमारे सर्वोत्तम-$64$ मॉडल ने हमारे सुदृढीकरण सीखने के मॉडल से बेहतर प्रदर्शन किया, शायद इसलिए कि $64$ के सर्वश्रेष्ठ मॉडल को कई और वेबसाइटों को ब्राउज़ करना पड़ा। यहां तक कि $4$ का सर्वोत्तम आवेदन करने से भी मानवीय प्राथमिकताओं में उल्लेखनीय वृद्धि हुई है।

इसके अलावा, सर्वोत्तम-$n$ नमूने का विश्वसनीय प्रदर्शन होता है और यह गणितीय रूप से विश्लेषण करने के लिए सीधा है, जिससे यह गुडहार्ट के नियम और संबंधित घटनाओं के अनुभवजन्य अध्ययनों के लिए उपयुक्त है।

सर्वोत्तम-$n$ नमूने का गणित

आइए अधिक औपचारिक रूप से सर्वोत्तम-$n$ नमूने का अध्ययन करें। मान लीजिए कि हमारे पास कुछ नमूना स्थान $S$ है (जैसे कि संभावित प्रश्न-उत्तर जोड़े का सेट), कुछ संभाव्यता वितरण $P$ खत्म हो गया है $एस$, एक सच्चा उद्देश्य (या "इनाम") $R_{पाठ{true}}:Stomathbb R$, और एक प्रॉक्सी उद्देश्य $R_{पाठ{प्रॉक्सी}}:Stomathbb R$। मान लें कि हम किसी तरह $R_{text{proxy}}$ का अनुकूलन करते हैं और इस तरह कुछ नया वितरण प्राप्त करते हैं $ पी ^ प्राइम $। तब:

- उम्मीद $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primerright)right]$ मापती है कि हमने सही उद्देश्य को कितनी अच्छी तरह अनुकूलित किया है।

- RSI केएल विचलन $D_{text{KL}}left(P^primeparallel Pright)$ मापता है कि हमने कितना अनुकूलन किया है। उदाहरण के लिए, यदि $P^प्राइम$ $P$ से पहला नमूना लेकर प्राप्त किया जाता है जो कुछ सबसेट में स्थित है $S^प्राइमसुबेटेक S$, तो यह केएल विचलन केवल नकारात्मक लॉग संभावना है कि $ पी $ से नमूना $ एस ^ प्राइम $ में निहित है।

यह पता चला है कि सर्वोत्तम-$n$ नमूने के मामले में, इन दोनों मात्राओं का अनुमान $P$ से नमूनों का उपयोग करके कुशलता से लगाया जा सकता है।

आइए पहले अपेक्षा को देखें। मोंटे कार्लो अनुमानक का उपयोग करने के लिए सरल दृष्टिकोण है: कई बार सर्वश्रेष्ठ-$ n $ नमूना चलाना, उन नमूनों पर सही उद्देश्य को मापना और परिणामों को औसत करना। हालांकि, एक बेहतर अनुमानक है। यदि हमारे पास कुल मिलाकर $P$ से $Ngeq n$ नमूने हैं, तो हम एक साथ विचार कर सकते हैं हर संभव उपसमुच्चय आकार $n$ के इन नमूनों में से, प्रत्येक नमूने को उपसमुच्चय की संख्या के आधार पर भारित करें जिसके लिए यह प्रॉक्सी उद्देश्य के अनुसार सबसे अच्छा है, और फिर भारित औसत वास्तविक उद्देश्य स्कोर लें। यह भार केवल द्विपद गुणांक है $बिनोम{k-1}{n-1}$, जहां $k$ प्रॉक्सी उद्देश्य के तहत नमूने की रैंक है, $1$ (सबसे खराब) से $N$ (सर्वोत्तम) तक। नमूनों का अधिक कुशलता से उपयोग करने के साथ-साथ यह हमें $n$ के विभिन्न मूल्यों के लिए नमूनों का पुन: उपयोग करने की भी अनुमति देता है।

केएल विचलन के लिए, आश्चर्यजनक रूप से, यह एक सटीक सूत्र है जो किसी भी निरंतर संभाव्यता वितरण $P$ (यानी, जब तक $P$ में कोई बिंदु द्रव्यमान नहीं है) के लिए काम करता है। कोई भोलेपन से अनुमान लगा सकता है कि इसका उत्तर है $लॉग एन$, चूँकि best-of-$n$ वितरण के शीर्ष $frac 1n$ को लेने जैसा कुछ कर रहा है, और यह लगभग सही है: सटीक उत्तर है $लॉग एन-फ़्रेक{n-1}n$।

साथ में, ये अनुमानक हमें आसानी से विश्लेषण करने की अनुमति देते हैं कि प्रॉक्सी उद्देश्य पर लागू अनुकूलन की मात्रा के साथ वास्तविक उद्देश्य कैसे बदलता है।

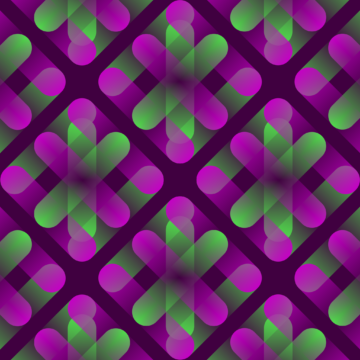

यहाँ से एक वास्तविक जीवन का उदाहरण है वेबजीपीटी:

WebGPT 175B के लिए सर्वश्रेष्ठ-$n$ प्रदर्शन

WebGPT के लिए सर्वश्रेष्ठ-$n$ प्रदर्शन, छायांकित क्षेत्रों के साथ $pm 1$ मानक त्रुटि का प्रतिनिधित्व करता है, और KL अक्ष एक वर्गमूल पैमाने का अनुसरण करता है। यहां, मूल वितरण ($P$) व्यवहार क्लोनिंग का उपयोग करके प्रशिक्षित 175B मॉडल द्वारा दिया गया है, सर्वोत्तम-$n$ ($R_{text{proxy}}$) की गणना करने के लिए उपयोग किया जाने वाला प्रॉक्सी उद्देश्य प्रशिक्षण द्वारा दिया गया है इनाम मॉडल, और हम तीन "सच्चे" उद्देश्यों ($R_{text{true}}$) पर विचार करते हैं: प्रशिक्षण इनाम मॉडल, होल्ड-आउट डेटा पर प्रशिक्षित एक सत्यापन इनाम मॉडल, और वास्तविक मानव प्राथमिकताएं। प्रॉक्सी उद्देश्य का बहुत अधिक अनुकूलन नहीं है, लेकिन हम उम्मीद करेंगे कि यह उच्चतर KL पर होगा।

सर्वोत्तम-$n$ नमूने से आगे जाना

सर्वोत्तम-$n$ नमूने की मुख्य सीमा यह है कि KL विचलन $n$ के साथ लघुगणकीय रूप से बढ़ता है, इसलिए यह केवल थोड़ी मात्रा में अनुकूलन लागू करने के लिए उपयुक्त है।

अधिक अनुकूलन लागू करने के लिए, हम आम तौर पर सुदृढीकरण सीखने का उपयोग करते हैं। सेटिंग्स में हमने अब तक अध्ययन किया है, जैसे संक्षिप्तीकरण, हम आम तौर पर लगभग 10 . के KL तक पहुँचने में सफल रहे हैं Nats गुडहार्ट के नियम के कारण वास्तविक उद्देश्य घटने से पहले सुदृढीकरण सीखने का उपयोग करना। हमें इस KL तक पहुंचने के लिए $n$ का उपयोग करके लगभग 60,000 लेना होगा बेस्ट-ऑफ़-$n$, और हम अपने इनाम मॉडलिंग और सुदृढीकरण सीखने की प्रथाओं में सुधार के साथ इससे कहीं अधिक बड़े केएल तक पहुंचने में सक्षम होने की उम्मीद करते हैं।

हालांकि, सभी नट्स समान नहीं होते हैं। आनुभविक रूप से, छोटे केएल बजट के लिए, $n$ का सर्वोत्तम सुदृढीकरण सीखने की तुलना में प्रॉक्सी और वास्तविक उद्देश्यों दोनों को बेहतर ढंग से अनुकूलित करता है। सहज रूप से, सर्वोत्तम-$n$ "जानवर बल" दृष्टिकोण है, जो इसे सुदृढीकरण सीखने की तुलना में अधिक जानकारी-सैद्धांतिक रूप से कुशल बनाता है, लेकिन बड़े KL पर कम कम्प्यूटेशनल रूप से कुशल है।

हम अपने काम के हिस्से के रूप में प्रॉक्सी उद्देश्यों के स्केलिंग गुणों का सक्रिय रूप से अध्ययन कर रहे हैं संरेखित करें मानवीय इरादे और मूल्यों के साथ हमारे मॉडल। यदि आप इस शोध में हमारी सहायता करना चाहते हैं, तो हम को काम पर रखने!

- AI

- ai कला

- ऐ कला जनरेटर

- ऐ रोबोट

- कृत्रिम बुद्धिमत्ता

- कृत्रिम बुद्धिमत्ता प्रमाणन

- बैंकिंग में आर्टिफिशियल इंटेलिजेंस

- आर्टिफिशियल इंटेलिजेंस रोबोट

- आर्टिफिशियल इंटेलिजेंस रोबोट

- कृत्रिम बुद्धि सॉफ्टवेयर

- blockchain

- ब्लॉकचेन सम्मेलन एआई

- कॉइनजीनियस

- संवादी कृत्रिम बुद्धिमत्ता

- क्रिप्टो सम्मेलन एआई

- दल-ए

- ध्यान लगा के पढ़ना या सीखना

- इसे गूगल करें

- यंत्र अधिगम

- OpenAI

- प्लेटो

- प्लेटो एआई

- प्लेटो डेटा इंटेलिजेंस

- प्लेटो गेम

- प्लेटोडाटा

- प्लेटोगेमिंग

- अनुसंधान

- स्केल एआई

- वाक्यविन्यास

- जेफिरनेट