Amazon EMR szerver nélküli lehetővé teszi a nyílt forráskódú big data keretrendszerek, például az Apache Spark és az Apache Hive futtatását fürtök és kiszolgálók kezelése nélkül. Az EMR Serverless segítségével bármilyen léptékben futtathatja az analitikai munkaterheléseket az automatikus skálázással, amely másodpercek alatt átméretezi az erőforrásokat, hogy megfeleljen a változó adatmennyiségeknek és feldolgozási követelményeknek. Az EMR Serverless automatikusan felfelé és lefelé méretezi az erőforrásokat, hogy az alkalmazásnak megfelelő kapacitást biztosítson.

Örömmel jelentjük be, hogy az EMR Serverless immár 8 vCPU-ból álló dolgozói konfigurációkat kínál akár 60 GB memóriával és 16 vCPU-t akár 120 GB memóriával, így több számítási és memóriaigényes munkaterhelést futtathat az EMR Serverless rendszeren. Az EMR Serverless alkalmazás belsőleg dolgozókat használ a munkaterhelések végrehajtásához. és a munkaterhelési követelményei alapján különböző dolgozói konfigurációkat konfigurálhat. Korábban az EMR Serverlessen elérhető legnagyobb dolgozói konfiguráció 4 vCPU volt, akár 30 GB memóriával. Ez a képesség különösen előnyös a következő gyakori forgatókönyvek esetén:

- Nehéz munkaterhelések keverése

- Memóriaigényes munkaterhelések

Nézzük meg ezeket a használati eseteket és a nagyobb dolgozói létszám előnyeit.

Előnyök, ha nagy létszámú munkásokat alkalmaznak az intenzív munkaterhelésekhez

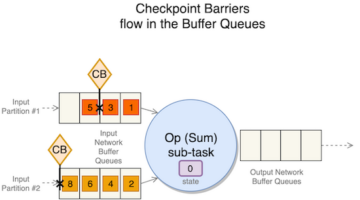

A Spark and Hive alkalmazásban a keverés akkor történik, amikor az adatokat újra kell osztani a fürtben a számítás során. Amikor az alkalmazás széles körű átalakításokat hajt végre, vagy csökkenti a műveleteket, mint pl join, groupBy, sortByvagy repartition, A Spark and Hive keverést indít el. Ezenkívül minden Spark szakaszt és Tez csúcsot egy keverési művelet határol. A Sparkot példaként véve alapértelmezés szerint 200 partíció van minden által meghatározott Spark-feladathoz spark.sql.shuffle.partitions. A Spark azonban menet közben kiszámolja a feladatok számát az adatméret és a végrehajtott művelet alapján. Ha egy nagy adatkészleten széles körű átalakítást hajtanak végre, előfordulhat, hogy GB-nyi vagy akár TB-nyi adatot kell lekérnie az összes feladatnak.

A keverés általában költséges mind az idő, mind az erőforrások tekintetében, és teljesítménybeli szűk keresztmetszetek kialakulásához vezethet. Ezért a keverés optimalizálása jelentős hatással lehet egy Spark-feladat teljesítményére és költségére. Nagy munkások esetén több adatot lehet lefoglalni az egyes végrehajtók memóriájába, ami minimalizálja a végrehajtók között kevert adatok számát. Ez viszont megnövekedett véletlenszerű olvasási teljesítményhez vezet, mivel a rendszer több adatot kér le helyben ugyanattól a dolgozótól, és kevesebb adatot fog lekérni távolról a többi dolgozótól.

kísérletek

Hogy bemutassuk, milyen előnyökkel jár a nagy létszámú dolgozók használata intenzív kevert lekérdezésekhez, használjuk q78 a TPC-DS-től, amely egy sok keverést igénylő Spark-lekérdezés, amely 167 GB adatot kever meg 12 Spark-fokozaton keresztül. Végezzünk el két iterációt ugyanannak a lekérdezésnek, különböző konfigurációkkal.

Az 1. teszt konfigurációi a következők:

- Az EMR szerver nélküli alkalmazás létrehozásakor kért végrehajtó mérete = 4 vCPU, 8 GB memória, 200 GB lemez

- Spark job konfiguráció:

spark.executor.cores= 4spark.executor.memory= 8spark.executor.instances= 48- Párhuzam = 192 (

spark.executor.instances*spark.executor.cores)

Az 2. teszt konfigurációi a következők:

- Az EMR szerver nélküli alkalmazás létrehozásakor kért végrehajtó mérete = 8 vCPU, 16 GB memória, 200 GB lemez

- Spark job konfiguráció:

spark.executor.cores= 8spark.executor.memory= 16spark.executor.instances= 24- Párhuzam = 192 (

spark.executor.instances*spark.executor.cores)

A dinamikus kiosztást is tiltsuk beállítással spark.dynamicAllocation.enabled nak nek false mindkét teszthez, hogy elkerülje a változó végrehajtó indítási idők miatti esetleges zajt, és konzisztens legyen az erőforrás-kihasználás mindkét tesztnél. Használjuk Spark Measure, amely egy nyílt forráskódú eszköz, amely leegyszerűsíti a Spark teljesítménymutatóinak gyűjtését és elemzését. Mivel fix számú végrehajtót használunk, a vCPU-k és a kért memória teljes száma mindkét tesztnél azonos. A következő táblázat összefoglalja a Spark Measure segítségével gyűjtött metrikák megfigyeléseit.

| . | A lekérdezéshez eltöltött teljes idő ezredmásodpercben | shuffleLocalBlocksFetched | shuffleRemoteBlocksFetched | shuffleLocalBytesRead | shuffleRemoteBytesRead | shuffleFetchWaitTime | shuffleWriteTime |

| Teszt 1 | 153244 | 114175 | 5291825 | 3.5 GB | 163.1 GB | 1.9 hr | 4.7 min |

| Teszt 2 | 108136 | 225448 | 5185552 | 6.9 GB | 159.7 GB | 3.2 min | 5.2 min |

Amint a táblázatból látható, jelentős különbségek vannak a teljesítményben a keverési fejlesztések miatt. A 2. teszt, feleannyi végrehajtóval, amelyek kétszer akkoraak, mint az 1. teszt, 29.44%-kal gyorsabban futott, és 1.97-szer több keverési adatot vettek le helyben az 1. teszthez képest ugyanazon lekérdezés, azonos párhuzamosság, valamint azonos összesített vCPU és memória erőforrások esetén. . Ezért profitálhat a jobb teljesítményből anélkül, hogy kompromisszumot kötne a költségekben vagy a munka párhuzamosságában a nagy végrehajtók segítségével. Hasonló teljesítményelőnyöket figyeltünk meg más, keverést igénylő TPC-DS lekérdezéseknél is, mint pl q23a és a q23b.

ajánlások

Annak megállapításához, hogy a nagy munkások hasznot húznak-e az intenzív keverést igénylő Spark-alkalmazásaiból, vegye figyelembe a következőket:

- Ellenőrizd a Szakmai lapon az EMR Serverless alkalmazás Spark History Server felhasználói felületén. Például a Spark History Server alábbi képernyőképe alapján megállapíthatjuk, hogy ez a Spark-feladat 167 GB véletlenszerű adatot írt és olvasott el 12 szakaszon keresztül, a Véletlenszerű olvasás és a Véletlenszerű írás oszlopok. Ha a munkái több mint 50 GB adatot kevernek, akkor előnyös lehet a nagyobb dolgozók alkalmazása 8 vagy 16 vCPU-val vagy

spark.executor.cores.

- Ellenőrizd a SQL / DataFrame fület az EMR Serverless alkalmazás Spark History Server felhasználói felületéről (csak Dataframe és Dataset API-k esetén). Amikor kiválasztja a végrehajtott Spark-műveletet, mint például a gyűjtés, az átvétel, a karakterlánc megjelenítése vagy a mentés, egy összesített DAG-t fog látni a cserék által elválasztott összes szakaszhoz. A DAG-ban minden csere egy keverési műveletnek felel meg, és tartalmazza a helyi és távoli bájtokat és blokkokat megkeverve, ahogy az a következő képernyőképen látható. Ha a lekért helyi keverési blokkok vagy bájtok mennyisége sokkal kevesebb a távoli blokkokhoz vagy bájtokhoz képest, akkor újrafuttathatja az alkalmazást nagyobb dolgozókkal (8 vagy 16 vCPU-val vagy spark.executor.cores), és áttekintheti ezeket a cseremetrikákat egy DAG-ban. hátha van valami javulás.

- Használja a Spark Measure eszközt a Spark-lekérdezéssel, hogy megkapja a keverési mérőszámokat a Spark illesztőprogramjában

stdoutnaplók, amint az a következő naplóban látható egy Spark-feladathoz. Tekintse át a véletlenszerű olvasáshoz szükséges időt (shuffleFetchWaitTime) és a shuffle írja (shuffleWriteTime), valamint a lekért helyi bájtok aránya a lekért távoli bájtokhoz képest. Ha a keverési művelet 2 percnél tovább tart, futtassa újra az alkalmazást nagyobb dolgozókkal (8 vagy 16 vCPU-val vagyspark.executor.cores) a Spark Measure segítségével a véletlen sorrendű lejátszási teljesítmény és a teljes munkaidő javulásának nyomon követéséhez.

A nagy létszámú munkások használatának előnyei nagy memóriaigényes munkaterhelések esetén

Bizonyos típusú munkaterhelések memóriaigényesek, és előnyös lehet a dolgozónként konfigurált több memória. Ebben a részben olyan gyakori forgatókönyveket tárgyalunk, amelyekben a nagy dolgozók hasznosak lehetnek a memóriaigényes munkaterhelések futtatásához.

Adatok torzítása

Az adattorzulás általában többféle adatkészletben fordul elő. Néhány gyakori példa a csalások felderítése, a népességelemzés és a jövedelemelosztás. Ha például anomáliákat szeretne észlelni az adatokban, akkor várhatóan csak az adatok kevesebb, mint 1%-a abnormális. Ha valamilyen összesítést szeretne végrehajtani a normál vagy abnormális rekordokon felül, az adatok 99%-át egyetlen dolgozó dolgozza fel, ami ahhoz vezethet, hogy a dolgozónak elfogy a memóriája. Adattorzulás figyelhető meg az olyan memóriaigényes átalakításoknál, mint pl groupBy, orderBy, join, ablak funkciók, collect_list, collect_set, stb. Csatlakozási típusok, mint pl BroadcastNestedLoopJoin és a Cartesan termék is eleve memóriaigényes és érzékeny az adatok torzítására. Hasonlóképpen, ha a bemeneti adatok Gzip-tömörítésűek, egyetlen Gzip-fájlt egynél több feladat nem tud elolvasni, mivel a Gzip-tömörítési típus feloszthatatlan. Ha néhány nagyon nagy Gzip fájl van a bemenetben, előfordulhat, hogy a feladatnak elfogy a memóriája, mert előfordulhat, hogy egyetlen feladatnak egy hatalmas Gzip fájlt kell beolvasnia, amely nem fér el a végrehajtó memóriájában.

Az adatok torzulásából eredő hibák enyhíthetők olyan stratégiák alkalmazásával, mint például a sózás. Ez azonban gyakran jelentős módosításokat tesz szükségessé a kódban, ami nem biztos, hogy megvalósítható olyan termelési munkaterhelés esetén, amely a bejövő adatmennyiség hirtelen megugrása által okozott soha nem látott adattorzulás miatt meghiúsult. Az egyszerűbb megoldás érdekében érdemes lehet növelni a dolgozói memóriát. Nagyobb dolgozók használata többel spark.executor.memory lehetővé teszi az adatok torzításának kezelését anélkül, hogy bármilyen változtatást végezne az alkalmazás kódjában.

gyorsítótárral

A teljesítmény javítása érdekében a Spark lehetővé teszi az adatkeretek, adatkészletek és RDD-k gyorsítótárazását a memóriában. Ez lehetővé teszi egy adatkeret többszöri újrafelhasználását az alkalmazásban anélkül, hogy újra kellene számolnia. Alapértelmezés szerint a végrehajtó JVM-jének legfeljebb 50%-át használják az adatkeretek gyorsítótárazására a property spark.memory.storageFraction. Például, ha a spark.executor.memory 30 GB-ra van állítva, majd 15 GB-ot használ a gyorsítótár tárolására, amely immunis a kilakoltatásra.

A gyorsítótár működésének alapértelmezett tárolási szintje a DISK_AND_MEMORY. Ha a gyorsítótárba helyezni kívánt adatkeret mérete nem fér el a végrehajtó memóriájában, a gyorsítótár egy része a lemezre kerül. Ha nincs elég hely a gyorsítótárazott adatok lemezre írásához, a blokkok kiürülnek, és Ön nem élvezheti a gyorsítótárazás előnyeit. A nagyobb dolgozók használata lehetővé teszi több adat gyorsítótárazását a memóriában, ami növeli a munka teljesítményét azáltal, hogy a gyorsítótárazott blokkokat kéri le a memóriából, nem pedig az alapul szolgáló tárolóból.

kísérletek

Például a következőket PySpark munka torzuláshoz vezet, mivel egy végrehajtó az adatok 99.95%-át olyan memóriaigényes aggregátumokkal dolgozza fel, mint pl. collect_list. A feladat egy nagyon nagy adatkeretet is gyorsítótáraz (2.2 TB). Futtassuk ugyanazt a feladatot két iterációban az EMR Serverless rendszeren a következő vCPU- és memóriakonfigurációkkal.

Futtassuk a 3. tesztet a korábban lehetséges legnagyobb dolgozói konfigurációkkal:

- Az EMR szerver nélküli alkalmazás létrehozásakor beállított végrehajtó mérete = 4 vCPU, 30 GB memória, 200 GB lemez

- Spark job konfiguráció:

spark.executor.cores= 4spark.executor.memory= 27 G

Futtassuk a 4. tesztet az újonnan kiadott nagy munkavégző konfigurációkkal:

- Az EMR szerver nélküli alkalmazás létrehozásakor beállított végrehajtó mérete = 8 vCPU, 60 GB memória, 200 GB lemez

- Spark job konfiguráció:

spark.executor.cores= 8spark.executor.memory= 54 G

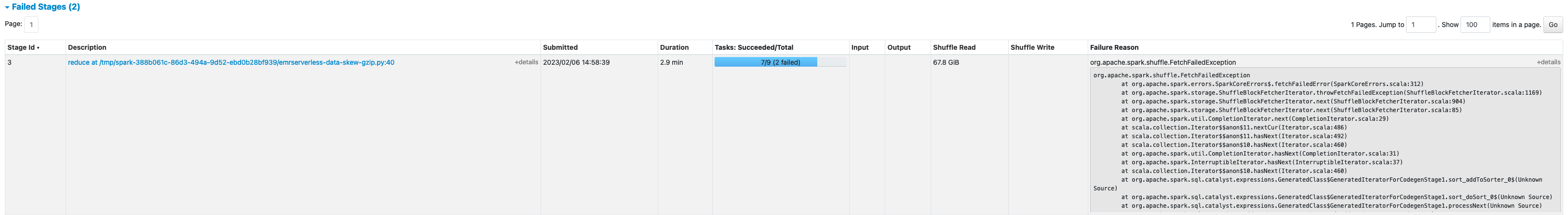

A 3. teszt meghiúsult FetchFailedException, ami azért következett be, mert a végrehajtó memória nem volt elegendő a feladathoz.

A 3. teszt Spark UI-jából azt is láthatjuk, hogy a végrehajtók lefoglalt tárolómemóriáját teljes mértékben kihasználták az adatkeretek gyorsítótárazására.

A gyorsítótárban lévő többi blokk kikerült a lemezre, amint az a végrehajtónál látható stderr rönk:

A megőrzött adatkeret körülbelül 33%-a gyorsítótárban volt a lemezen, amint az a képen látható Tárolás a Spark UI lapján.

A 4. teszt nagyobb végrehajtókkal és vCore-okkal sikeresen lefutott anélkül, hogy memóriával kapcsolatos hibákat dobott volna fel. Ezenkívül az adatkeretnek csak körülbelül 2.2%-a került gyorsítótárba a lemezre. Ezért az adatkeret gyorsítótárazott blokkjait a rendszer a memóriából fogja lekérni, nem pedig a lemezről, ami jobb teljesítményt nyújt.

ajánlások

Annak megállapításához, hogy a nagy munkások hasznosak-e a memóriaigényes Spark-alkalmazások számára, vegye figyelembe a következőket:

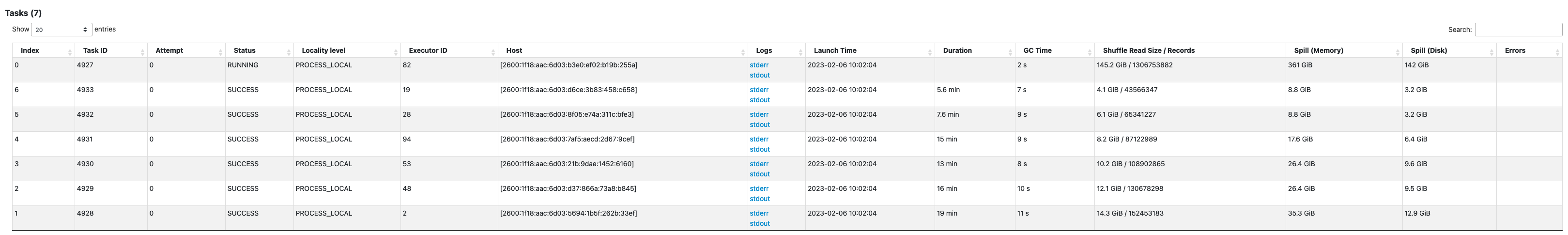

- A Spark felhasználói felület megtekintésével állapítsa meg, hogy a Spark-alkalmazásban vannak-e adatok torzulásai. A következő képernyőképe a Spark UI-ról egy példa-adattorzítási forgatókönyvet mutat be, ahol egy feladat feldolgozza az adatok nagy részét (145.2 GB), a Véletlenszerű olvasás méret. Ha egy vagy több feladat lényegesen több adatot dolgoz fel, mint más feladatok, futtassa újra az alkalmazást nagyobb dolgozókkal 60–120 G memóriával (

spark.executor.memory54 és 109 GB között állítható be, 10%-kal együttspark.executor.memoryOverhead).

- Ellenőrizd a Tárolás A Spark History Server lapján megtekintheti a memóriában tárolt adatok és a lemezről tárolt adatok arányát Méret a memóriában és a Méret a lemezen oszlopok. Ha az adatok több mint 10%-a gyorsítótárban van a lemezen, futtassa újra az alkalmazást nagyobb dolgozókkal, hogy növelje a memóriában tárolt adatok mennyiségét.

- A megfigyelés egy másik módja annak, hogy előre meg lehessen állapítani, hogy a munkának több memóriára van-e szüksége Csúcs JVM memória a Spark UI-n Végrehajtók lapon. Ha a használt JVM-memória csúcsértéke közel van a végrehajtó vagy az illesztőprogram memóriájához, létrehozhat egy alkalmazást egy nagyobb dolgozóval, és magasabb értéket konfigurálhat

spark.executor.memoryorspark.driver.memory. Például a következő képernyőképen a maximális JVM memóriahasználat 26 GB ésspark.executor.memory27 G-ra van állítva. Ebben az esetben előnyös lehet nagyobb dolgozók használata 60 GB memóriával ésspark.executor.memoryállítsa 54 G-ra.

Szempontok

Bár a nagy vCPU-k segítenek növelni a keverési blokkok helyét, más tényezők is szerepet játszanak, mint például a lemez átviteli sebessége, a lemez IOPS (bemeneti/kimeneti műveletek másodpercenként) és a hálózati sávszélesség. Egyes esetekben több, több lemezzel rendelkező kisebb dolgozó nagyobb IOPS-t, átviteli sebességet és összességében hálózati sávszélességet kínálhat, mint kevesebb nagy dolgozó. Javasoljuk, hogy vesse össze munkaterhelését a megfelelő vCPU-konfigurációkkal, hogy kiválaszthassa a munkaterheléséhez legjobban illő konfigurációt.

A sok keverést igénylő munkákhoz nagy lemezek használata javasolt. Az alkalmazás létrehozásakor minden egyes dolgozóhoz akár 200 GB-os lemezt is csatolhat. Nagy vCPU-k használata (spark.executor.cores) végrehajtónként növelheti a lemezkihasználást az egyes dolgozókon. Ha az alkalmazás a „Nincs hely az eszközön” beállítással meghiúsul, mert nem fér el a kevert adatok a lemezen, használjon több kisebb dolgozót 200 GB-os lemezzel.

Következtetés

Ebben a bejegyzésben megismerkedhetett a nagy végrehajtók használatának előnyeivel az EMR-kiszolgáló nélküli munkáihoz. A különböző dolgozói konfigurációkkal kapcsolatos további információkért lásd: Munkavállalói konfigurációk. A nagy dolgozói konfigurációk minden olyan régióban elérhetők, ahol az EMR Serverless működik elérhető.

A szerzőről

Veena Vasudevan Senior Partner Solutions Architect és Amazon EMR specialista az AWS-nél, aki a big data-ra és az elemzésekre összpontosít. Segít ügyfeleinek és partnereinek rendkívül optimalizált, méretezhető és biztonságos megoldások kidolgozásában; modernizálják építészetüket; és áttelepítik a nagy adatforgalmat az AWS-re.

Veena Vasudevan Senior Partner Solutions Architect és Amazon EMR specialista az AWS-nél, aki a big data-ra és az elemzésekre összpontosít. Segít ügyfeleinek és partnereinek rendkívül optimalizált, méretezhető és biztonságos megoldások kidolgozásában; modernizálják építészetüket; és áttelepítik a nagy adatforgalmat az AWS-re.

- SEO által támogatott tartalom és PR terjesztés. Erősödjön még ma.

- Platoblockchain. Web3 metaverzum intelligencia. Felerősített tudás. Hozzáférés itt.

- Forrás: https://aws.amazon.com/blogs/big-data/amazon-emr-serverless-supports-larger-worker-sizes-to-run-more-compute-and-memory-intensive-workloads/

- 1

- 10

- 100

- 11

- 2%

- 7

- 70

- 9

- 95%

- a

- Rólunk

- át

- Akció

- ellen

- összesítés

- Minden termék

- elkülönített

- kiosztás

- lehetővé téve

- lehetővé teszi, hogy

- amazon

- Amazon EMR

- összeg

- elemzés

- analitika

- és a

- bejelent

- bárhol

- Apache

- Apache Spark

- API-k

- Alkalmazás

- alkalmazások

- Alkalmazása

- csatolja

- Automatikus

- automatikusan

- elérhető

- elkerülése érdekében

- AWS

- Sávszélesség

- alapján

- mert

- hogy

- benchmark

- előnyös

- haszon

- Előnyök

- BEST

- Jobb

- Nagy

- Big adatok

- Blokk

- Blocks

- fellendítése

- szűk

- épít

- cache

- Kapacitás

- eset

- esetek

- okozott

- Változások

- változó

- A pop-art design, négy időzóna kijelzése egyszerre és méretének arányai azok az érvek, amelyek a NeXtime Time Zones-t kiváló választássá teszik. Válassza a

- közel

- Fürt

- kód

- gyűjt

- gyűjtemény

- Oszlopok

- Közös

- általában

- képest

- veszélyeztetése

- számítás

- Kiszámít

- Configuration

- konfigurációk

- Fontolja

- következetes

- kontextus

- megfelel

- Költség

- tudott

- teremt

- létrehozása

- Ügyfelek

- DAG

- dátum

- adatkészletek

- alapértelmezett

- meghatározott

- Fok

- bizonyítani

- Érzékelés

- Határozzuk meg

- különbség

- különböző

- megvitatni

- terjesztés

- Nem

- ne

- le-

- gépkocsivezető

- alatt

- dinamikus

- minden

- lehetővé teszi

- ösztönzése

- elég

- hibák

- különösen

- Eter (ETH)

- Még

- Minden

- példa

- példák

- csere

- Feltételek

- izgatott

- kivégez

- várható

- drága

- kiterjedt

- tényezők

- Sikertelen

- nem sikerül

- messze

- gyorsabb

- megvalósítható

- Elhozták

- kevés

- filé

- Fájlok

- megfelelő

- rögzített

- összpontosítás

- következő

- következik

- KERET

- keretek

- csalás

- csalások felderítése

- ból ből

- teljesen

- funkciók

- kap

- fél

- fogantyú

- tekintettel

- segít

- segít

- <p></p>

- nagyon

- történelem

- Kaptár

- azonban

- HTML

- HTTPS

- hatalmas

- Hatás

- javul

- javított

- javulás

- fejlesztések

- in

- képtelenség

- Jövedelem

- Bejövő

- Növelje

- <p></p>

- info

- információ

- bemenet

- helyette

- részt

- IT

- iterációk

- Munka

- Állások

- csatlakozik

- Tart

- nagy

- nagyobb

- legnagyobb

- indít

- vezet

- vezetékek

- tanult

- szint

- LIMIT

- helyi

- helyileg

- néz

- keres

- Gyártás

- kezelése

- maximális

- intézkedés

- Találkozik

- Memory design

- Metrics

- vándorol

- jegyzőkönyv

- Mód

- korszerűsítésére

- ellenőrzés

- több

- a legtöbb

- MS

- többszörös

- Szükség

- igények

- hálózat

- Zaj

- normális

- szám

- szerez

- ajánlat

- felajánlás

- Ajánlatok

- ONE

- nyílt forráskódú

- működés

- Művelet

- optimalizált

- optimalizálása

- érdekében

- Más

- átfogó

- partner

- partnerek

- Csúcs

- teljesít

- teljesítmény

- Előadja

- Plató

- Platón adatintelligencia

- PlatoData

- népesség

- lehetséges

- állás

- potenciális

- potenciálisan

- korábban

- folyamat

- Folyamatok

- feldolgozás

- Termékek

- Termelés

- ad

- hányados

- Olvass

- ajánlott

- nyilvántartások

- csökkenteni

- régiók

- felszabaduló

- megmaradó

- távoli

- kért

- követelmények

- megköveteli,

- fenntartott

- forrás

- Tudástár

- Kritika

- futás

- futás

- azonos

- Megtakarítás

- skálázható

- Skála

- Mérleg

- skálázás

- forgatókönyv

- forgatókönyvek

- Második

- másodperc

- Rész

- biztonság

- idősebb

- vagy szerver

- Szerverek

- készlet

- beállítás

- számos

- megosztott

- mutatott

- Műsorok

- keverés

- jelentős

- jelentősen

- hasonló

- Hasonlóképpen

- egyetlen

- Méret

- méretek

- ferdeség

- kicsi

- kisebb

- So

- eddig

- Megoldások

- néhány

- Hely

- Szikra

- szakember

- SQL

- Színpad

- állapota

- tárolás

- tárolni

- stratégiák

- sikeresen

- ilyen

- hirtelen

- elegendő

- megfelelő

- Támogatja

- túlfeszültség

- fogékony

- táblázat

- Vesz

- tart

- bevétel

- Feladat

- feladatok

- feltételek

- teszt

- tesztek

- A

- azok

- ebből adódóan

- áteresztőképesség

- Dobás

- idő

- alkalommal

- nak nek

- szerszám

- felső

- Végösszeg

- vágány

- Átalakítás

- transzformációk

- FORDULAT

- típusok

- jellemzően

- ui

- mögöttes

- példátlan

- Használat

- használ

- hasznosított

- érték

- kötet

- kötetek

- ami

- míg

- széles

- lesz

- nélkül

- munkás

- dolgozók

- ír

- A te

- zephyrnet