Gambar oleh Penulis

XAI adalah kecerdasan buatan yang memungkinkan manusia untuk memahami hasil dan proses pengambilan keputusan dari model atau sistem.

Penjelasan pra-pemodelan

AI yang dapat dijelaskan dimulai dengan data yang dapat dijelaskan dan rekayasa fitur yang jelas dan dapat ditafsirkan.

Penjelasan Pemodelan

Saat memilih model untuk masalah tertentu, umumnya yang terbaik adalah menggunakan model yang paling dapat diinterpretasikan yang masih memberikan hasil prediksi yang baik.

Penjelasan pasca-model

Ini termasuk teknik seperti perturbasi, di mana pengaruh perubahan satu variabel pada keluaran model dianalisis seperti nilai SHAP setelah pelatihan.

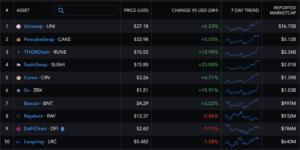

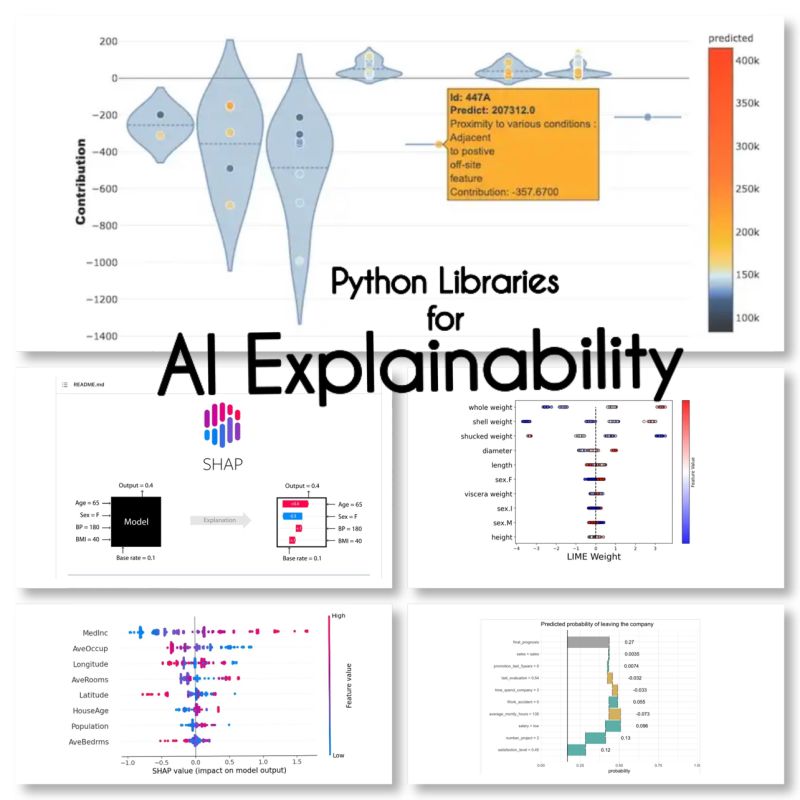

Saya menemukan 10 pustaka Python ini untuk penjelasan AI:

SHAP (Penjelasan Aditif SHapley)

SHAP adalah model agnostik dan bekerja dengan memecah kontribusi setiap fitur dan memberikan skor ke setiap fitur.

LIME (Penjelasan Model-agnostik yang Dapat Diinterpretasikan Secara Lokal)

LIME adalah metode agnostik model lain yang bekerja dengan memperkirakan perilaku model secara lokal di sekitar prediksi tertentu.

ELi5

Eli5 adalah perpustakaan untuk men-debug dan menjelaskan pengklasifikasi. Ini memberikan skor kepentingan fitur, serta "kode alasan" untuk scikit-learn, Keras, xgboost, LightGBM, CatBoost.

Shapas

Shapash adalah pustaka Python yang bertujuan untuk membuat pembelajaran mesin dapat ditafsirkan dan dimengerti oleh semua orang. Shapash menyediakan beberapa jenis visualisasi dengan label eksplisit.

jangkar

Jangkar adalah metode untuk menghasilkan aturan yang dapat diinterpretasikan manusia yang dapat digunakan untuk menjelaskan prediksi model pembelajaran mesin.

XAI (AI yang dapat dijelaskan)

XAI adalah pustaka untuk menjelaskan dan memvisualisasikan prediksi model pembelajaran mesin termasuk skor kepentingan fitur.

Kerusakan

BreakDown adalah alat yang dapat digunakan untuk menjelaskan prediksi model linier. Ini bekerja dengan menguraikan output model menjadi kontribusi dari setiap fitur input.

menafsirkan-teks

interpret-text adalah perpustakaan untuk menjelaskan prediksi model pemrosesan bahasa alami.

iml (Pembelajaran Mesin yang Dapat Diartikan)

iml saat ini berisi antarmuka dan kode IO dari proyek Shap, dan berpotensi melakukan hal yang sama untuk proyek Lime.

aix360 (Kejelasan AI 360)

aix360 menyertakan seperangkat algoritme komprehensif yang mencakup berbagai dimensi

OmniXAI

OmniXAI (singkatan dari Omni eXplainable AI), mengatasi beberapa masalah dalam menafsirkan penilaian yang dihasilkan oleh model pembelajaran mesin dalam praktiknya.

Apakah saya lupa perpustakaan?

sumber

Maryam Miradi adalah Pimpinan AI dan Ilmu Data dengan gelar PhD dalam Pembelajaran Mesin dan Pembelajaran Mendalam, khusus dalam NLP dan Visi Komputer. Dia memiliki pengalaman lebih dari 15 tahun dalam menciptakan solusi AI yang sukses dengan rekam jejak dalam memberikan lebih dari 40 proyek yang sukses. Dia telah bekerja untuk 12 organisasi berbeda di berbagai industri, termasuk Mendeteksi Kejahatan Keuangan, Energi, Perbankan, Ritel, E-niaga, dan Pemerintah.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Sumber: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- alamat

- Setelah

- AI

- bertujuan

- algoritma

- memungkinkan

- dan

- Lain

- sekitar

- buatan

- kecerdasan buatan

- Perbankan

- TERBAIK

- Melanggar

- mengubah

- memilih

- jelas

- kode

- luas

- komputer

- Visi Komputer

- mengandung

- kontribusi

- menutupi

- membuat

- Kejahatan

- Sekarang

- data

- ilmu data

- Pengambilan Keputusan

- keputusan

- mendalam

- belajar mendalam

- mengantarkan

- berbeda

- turun

- e-commerce

- setiap

- efek

- energi

- Teknik

- semua orang

- pengalaman

- Menjelaskan

- Dapat dijelaskan

- AI yang bisa dijelaskan

- menjelaskan

- Fitur

- keuangan

- kejahatan keuangan

- terlupakan

- ditemukan

- dari

- umumnya

- menghasilkan

- baik

- Pemerintah

- HTTPS

- Manusia

- pentingnya

- in

- termasuk

- Termasuk

- industri

- memasukkan

- Intelijen

- Antarmuka

- IT

- penilaian

- KDnugget

- keras

- Label

- bahasa

- memimpin

- pengetahuan

- perpustakaan

- Perpustakaan

- Kapur

- lokal

- lokal

- mesin

- Mesin belajar

- membuat

- metode

- model

- model

- paling

- Alam

- Bahasa Alami

- Pengolahan Bahasa alami

- nLP

- Omni

- Organisasi

- tertentu

- plato

- Kecerdasan Data Plato

- Data Plato

- berpotensi

- praktek

- ramalan

- Prediksi

- Masalah

- masalah

- proses

- pengolahan

- Diproduksi

- proyek

- memprojeksikan

- menyediakan

- Ular sanca

- alasan

- catatan

- Hasil

- eceran

- aturan

- sama

- Ilmu

- scikit-belajar

- set

- beberapa

- Pendek

- tunggal

- Solusi

- terspesialisasi

- tertentu

- dimulai

- Masih

- sukses

- seperti itu

- sistem

- teknik

- Grafik

- untuk

- alat

- jalur

- Pelatihan

- jenis

- memahami

- dimengerti

- menggunakan

- Nilai - Nilai

- variasi

- penglihatan

- visualisasi

- yang

- akan

- bekerja

- bekerja

- XGBoost

- tahun

- Anda

- zephyrnet.dll