Pada November 2022, kami mengumumkan yang dapat digunakan pelanggan AWS untuk menghasilkan gambar dari teks Difusi Stabil model dalam Mulai Lompatan Amazon SageMaker. Difusi Stabil adalah model pembelajaran mendalam yang memungkinkan Anda menghasilkan gambar yang realistis, berkualitas tinggi, dan karya seni yang memukau hanya dalam beberapa detik. Meskipun membuat gambar yang mengesankan dapat digunakan dalam industri mulai dari seni hingga NFT dan seterusnya, hari ini kami juga berharap AI dapat dipersonalisasi. Hari ini, kami mengumumkan bahwa Anda dapat mempersonalisasi model pembuatan gambar untuk kasus penggunaan Anda dengan menyempurnakannya pada kumpulan data khusus di Mulai Lompatan Amazon SageMaker. Ini dapat berguna saat membuat karya seni, logo, desain khusus, NFT, dan sebagainya, atau hal-hal menyenangkan seperti membuat gambar AI khusus untuk hewan peliharaan atau avatar Anda sendiri.

Dalam posting ini, kami memberikan ikhtisar tentang cara menyempurnakan model Difusi Stabil dengan dua cara: secara terprogram melalui API JumpStart tersedia di SDK Python SageMaker, dan antarmuka pengguna (UI) JumpStart di Studio Amazon SageMaker. Kami juga membahas cara membuat pilihan desain termasuk kualitas set data, ukuran set data pelatihan, pilihan nilai hyperparameter, dan penerapan ke beberapa set data. Terakhir, kami membahas lebih dari 80 model fine-tuned yang tersedia untuk umum dengan berbagai bahasa input dan gaya yang baru saja ditambahkan di JumpStart.

Difusi Stabil dan pembelajaran transfer

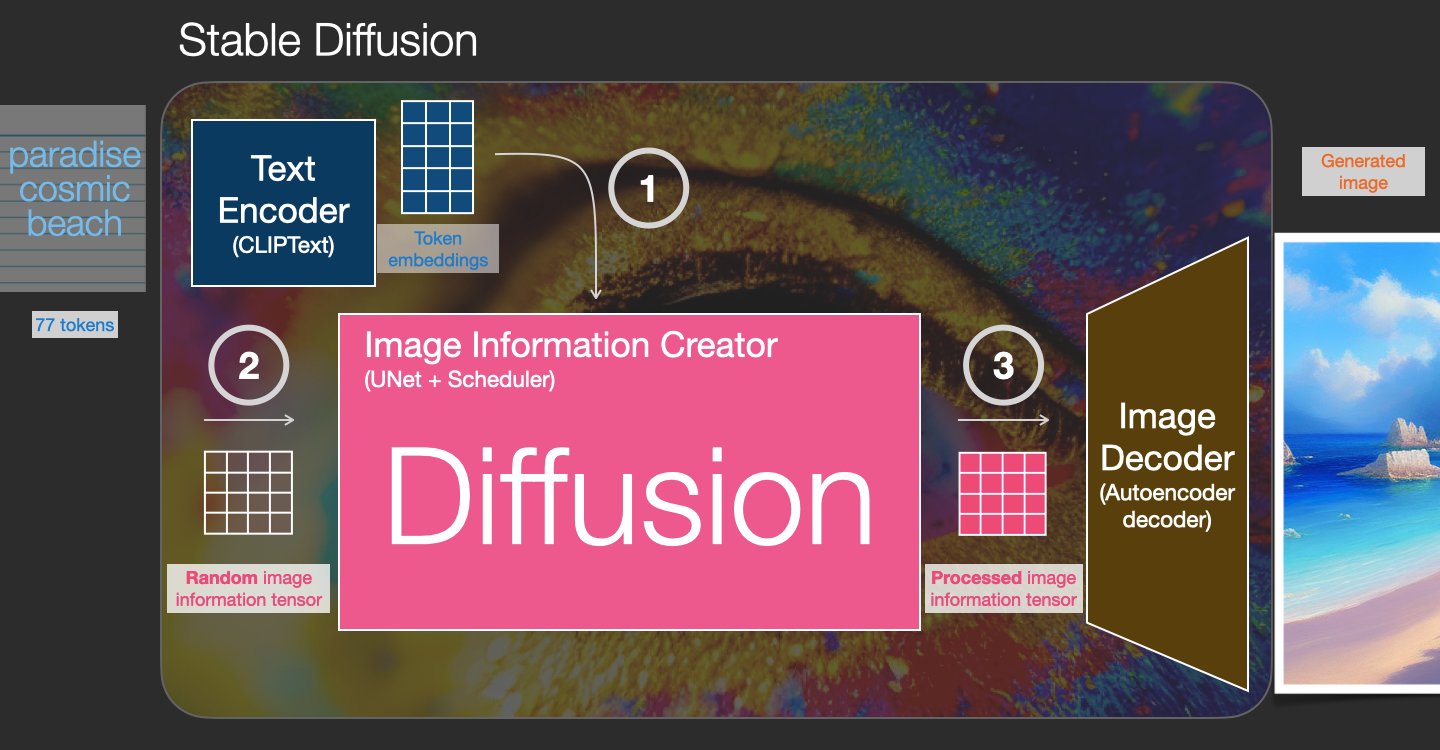

Difusi Stabil adalah model teks-ke-gambar yang memungkinkan Anda membuat gambar fotorealistik hanya dari perintah teks. Model difusi berlatih dengan belajar menghilangkan noise yang ditambahkan ke gambar nyata. Proses de-noise ini menghasilkan gambar yang realistis. Model ini juga dapat menghasilkan gambar dari teks saja dengan mengkondisikan proses pembangkitan pada teks. Misalnya, Difusi Stabil adalah difusi laten di mana model belajar mengenali bentuk dalam gambar noise murni dan secara bertahap memfokuskan bentuk ini jika bentuknya cocok dengan kata-kata dalam teks input. Teks pertama-tama harus disematkan ke dalam ruang laten menggunakan model bahasa. Kemudian, serangkaian operasi penambahan derau dan penghilangan derau dilakukan di ruang laten dengan arsitektur U-Net. Akhirnya, output de-noise didekodekan ke dalam ruang piksel.

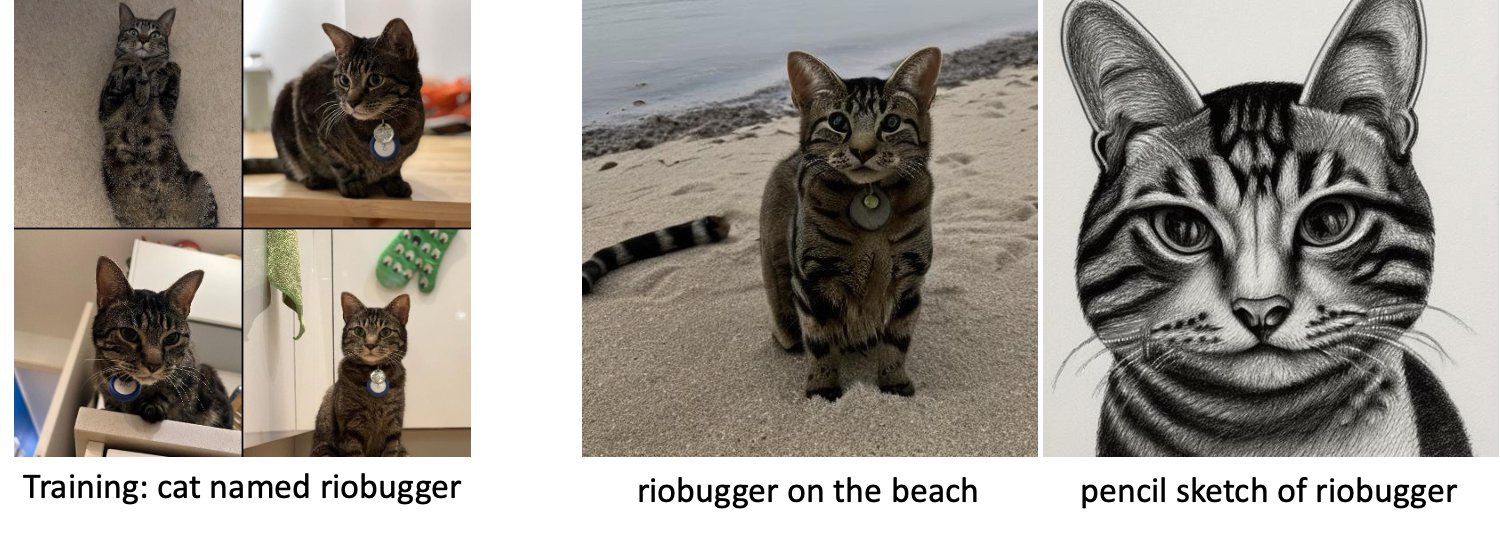

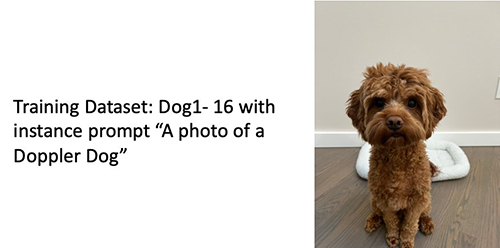

Dalam pembelajaran mesin (ML), kemampuan untuk mentransfer pengetahuan yang dipelajari dalam satu domain ke domain lain disebut belajar transfer. Anda dapat menggunakan pembelajaran transfer untuk menghasilkan model yang akurat pada kumpulan data Anda yang lebih kecil, dengan biaya pelatihan yang jauh lebih rendah daripada biaya pelatihan model aslinya. Dengan pembelajaran transfer, Anda dapat menyempurnakan model difusi stabil pada kumpulan data Anda sendiri hanya dengan lima gambar. Misalnya, di sebelah kiri adalah gambar latih seekor anjing bernama Doppler yang digunakan untuk menyempurnakan model, di tengah dan kanan adalah gambar yang dihasilkan oleh model yang disetel halus ketika diminta untuk memprediksi gambar Doppler di pantai dan sketsa pensil.

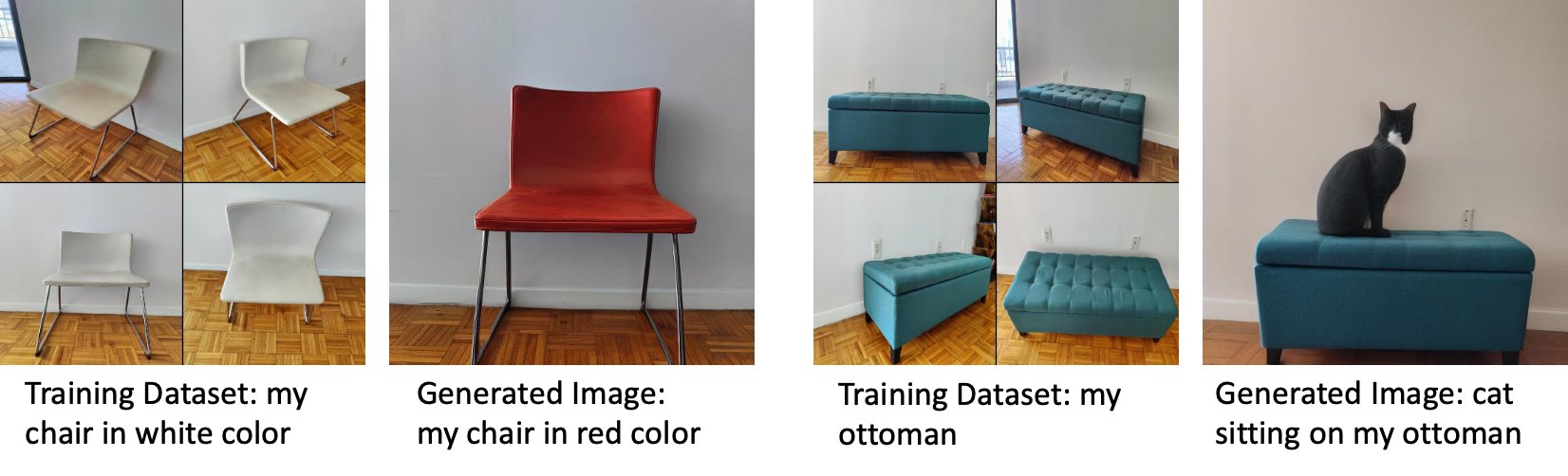

Di sebelah kiri adalah gambar kursi putih yang digunakan untuk menyempurnakan model dan gambar kursi berwarna merah yang dihasilkan oleh model yang telah disempurnakan. Di sebelah kanan adalah gambar ottoman yang digunakan untuk menyempurnakan model dan gambar kucing duduk di ottoman.

Menyempurnakan model besar seperti Stable Diffusion biasanya mengharuskan Anda menyediakan skrip pelatihan. Ada sejumlah masalah, termasuk masalah kehabisan memori, masalah ukuran muatan, dan banyak lagi. Selain itu, Anda harus menjalankan pengujian end-to-end untuk memastikan bahwa skrip, model, dan instance yang diinginkan bekerja sama secara efisien. JumpStart menyederhanakan proses ini dengan menyediakan skrip siap pakai yang telah diuji dengan kuat. Skrip fine-tuning JumpStart untuk model Difusi Stabil dibuat berdasarkan skrip fine-tuning dari bilik mimpi. Anda dapat mengakses skrip ini dengan satu klik melalui Studio UI atau dengan sangat sedikit baris kode melalui API JumpStart.

Perhatikan bahwa dengan menggunakan model Difusi Stabil, Anda menyetujui Lisensi CreativeML Open RAIL++-M.

Gunakan JumpStart secara terprogram dengan SageMaker SDK

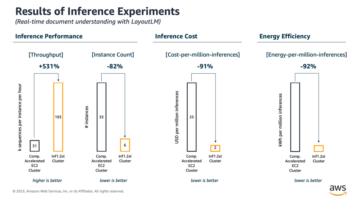

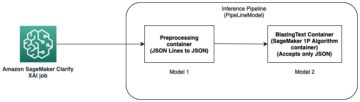

Bagian ini menjelaskan cara melatih dan menerapkan model dengan SDK Python SageMaker. Kami memilih model terlatih yang sesuai di JumpStart, melatih model ini dengan tugas pelatihan SageMaker, dan menerapkan model terlatih ke titik akhir SageMaker. Selain itu, kami menjalankan inferensi pada titik akhir yang diterapkan, semuanya menggunakan SageMaker Python SDK. Contoh berikut berisi cuplikan kode. Untuk kode lengkap dengan semua langkah dalam demo ini, lihat Pengantar JumpStart – Teks ke Gambar contoh buku catatan.

Latih dan sempurnakan model Difusi Stabil

Setiap model diidentifikasi oleh yang unik model_id. Kode berikut menunjukkan cara menyempurnakan model dasar Difusi Stabil 2.1 yang diidentifikasi oleh model_id model-txt2img-stabilityai-stable-diffusion-v2-1-base pada set data pelatihan khusus. Untuk daftar lengkap model_id nilai-nilai dan model mana yang dapat disesuaikan, lihat Algoritma bawaan dengan Tabel Model yang telah dilatih sebelumnya. Untuk setiap model_id, untuk meluncurkan pekerjaan pelatihan SageMaker melalui Penilai kelas SageMaker Python SDK, Anda perlu mengambil URI gambar Docker, URI skrip pelatihan, dan URI model terlatih melalui fungsi utilitas yang disediakan di SageMaker. URI skrip pelatihan berisi semua kode yang diperlukan untuk pemrosesan data, memuat model yang telah dilatih sebelumnya, pelatihan model, dan menyimpan model yang dilatih untuk inferensi. URI model terlatih berisi definisi arsitektur model terlatih dan parameter model. URI model terlatih khusus untuk model tertentu. Tarbal model pra-terlatih telah diunduh sebelumnya dari Hugging Face dan disimpan dengan tanda tangan model yang sesuai Layanan Penyimpanan Sederhana Amazon (Amazon S3), sehingga tugas pelatihan berjalan dalam isolasi jaringan. Lihat kode berikut:

Dengan artefak pelatihan khusus model ini, Anda dapat membuat objek dari Penilai kelas:

Kumpulan data pelatihan

Berikut ini adalah instruksi untuk bagaimana data pelatihan harus diformat:

- Memasukkan – Direktori yang berisi gambar instance,

dataset_info.json, dengan konfigurasi sebagai berikut:- Gambar mungkin dalam format .png, .jpg, atau .jpeg

- Grafik

dataset_info.jsonfile harus dalam format{'instance_prompt':<<instance_prompt>>}

- Keluaran – Model terlatih yang dapat digunakan untuk inferensi

Jalur S3 akan terlihat seperti s3://bucket_name/input_directory/. Perhatikan jejaknya / Dibutuhkan.

Berikut adalah contoh format data pelatihan:

Untuk petunjuk tentang cara memformat data saat menggunakan preservasi sebelumnya, lihat bagian ini Preservasi Sebelumnya di posting ini.

Kami menyediakan kumpulan data gambar kucing default. Ini terdiri dari delapan gambar (gambar contoh yang sesuai dengan permintaan contoh) dari satu kucing tanpa gambar kelas. Itu dapat diunduh dari GitHub. Jika menggunakan dataset default, coba prompt "foto kucing riobugger" sambil melakukan inferensi di notebook demo.

Lisensi: MIT.

Hyperparameter

Selanjutnya, untuk mentransfer pembelajaran pada kumpulan data khusus Anda, Anda mungkin perlu mengubah nilai default dari hyperparameter pelatihan. Anda dapat mengambil kamus Python dari hyperparameter ini dengan nilai defaultnya dengan memanggil hyperparameters.retrieve_default, perbarui sesuai kebutuhan, lalu teruskan ke kelas Estimator. Lihat kode berikut:

Hyperparameter berikut didukung oleh algoritme penyempurnaan:

- dengan_prior_preservation – Tandai untuk menambahkan kerugian pelestarian sebelumnya. Pelestarian sebelumnya adalah pengatur yang menghindari overfitting. (Pilihan:

[“True”,“False”], bawaan:“False”.) - nomor_kelas_gambar – Gambar kelas minimum untuk kehilangan preservasi sebelumnya. Jika

with_prior_preservation = Truedan tidak ada cukup gambar yang sudah adaclass_data_dir, gambar tambahan akan diambil sampelnyaclass_prompt. (Nilai: bilangan bulat positif, default: 100.) - Zaman – Jumlah lintasan yang diambil algoritme fine-tuning melalui dataset pelatihan. (Nilai: bilangan bulat positif, default: 20.)

- Langkah_maks – Jumlah total langkah-langkah pelatihan yang harus dilakukan. Jika tidak

None, menimpa zaman. (Nilai:“None”atau string integer, default:“None”.) - Ukuran batch –: Jumlah contoh pelatihan yang dikerjakan sebelum bobot model diperbarui. Sama dengan ukuran batch selama pembuatan gambar kelas jika

with_prior_preservation = True. (Nilai: bilangan bulat positif, default: 1.) - tingkat_belajar – Tingkat di mana bobot model diperbarui setelah mengerjakan setiap kumpulan contoh pelatihan. (Nilai: float positif, default: 2e-06.)

- berat_kerugian_sebelumnya – Berat kehilangan preservasi sebelumnya. (Nilai: float positif, default: 1.0.)

- center_crop – Apakah akan memotong gambar sebelum mengubah ukuran ke resolusi yang diinginkan. (Pilihan:

[“True”/“False”], bawaan:“False”.) - lr_penjadwal – Jenis penjadwal laju pembelajaran. (Pilihan:

["linear", "cosine", "cosine_with_restarts", "polynomial", "constant", "constant_with_warmup"], bawaan:"constant".) Untuk informasi lebih lanjut, lihat Penjadwal Tingkat Pembelajaran. - adam_weight_decay – Peluruhan bobot untuk diterapkan (jika bukan nol) ke semua lapisan kecuali semua bias dan

LayerNormbobot masukAdamWpengoptimal. (Nilai: float, default: 1e-2.) - adam_beta1 – Hyperparameter beta1 (tingkat peluruhan eksponensial untuk perkiraan momen pertama) untuk

AdamWpengoptimal. (Nilai: float, default: 0.9.) - adam_beta2 – Hyperparameter beta2 (tingkat peluruhan eksponensial untuk perkiraan momen pertama) untuk

AdamWpengoptimal. (Nilai: float, default: 0.999.) - adam_epsilon - The

epsilonhiperparameter untukAdamWpengoptimal. Biasanya diatur ke nilai kecil untuk menghindari pembagian dengan 0. (Nilai: float, default: 1e-8.) - gradien_akumulasi_langkah – Jumlah langkah pembaruan untuk diakumulasikan sebelum melakukan langkah mundur/perbarui. (Nilai: bilangan bulat, default: 1.)

- max_grad_norm – Norma gradien maksimum (untuk kliping gradien). (Nilai: float, default: 1.0.)

- benih – Perbaiki keadaan acak untuk mencapai hasil yang dapat direproduksi dalam pelatihan. (Nilai: bilangan bulat, default: 0.)

Terapkan model yang terlatih dengan baik

Setelah pelatihan model selesai, Anda dapat langsung men-deploy model ke endpoint real-time yang persisten. Kami mengambil URI Gambar Docker dan URI skrip yang diperlukan dan menerapkan modelnya. Lihat kode berikut:

Di sebelah kiri adalah gambar pelatihan kucing bernama riobugger yang digunakan untuk menyempurnakan model (kecuali parameter default max_steps = 400). Di tengah dan kanan adalah gambar yang dihasilkan oleh model yang telah disempurnakan saat diminta memprediksi gambar riobugger di pantai dan sketsa pensil.

Untuk detail selengkapnya tentang inferensi, termasuk parameter yang didukung, format respons, dan sebagainya, lihat Hasilkan gambar dari teks dengan model difusi stabil di Amazon SageMaker JumpStart.

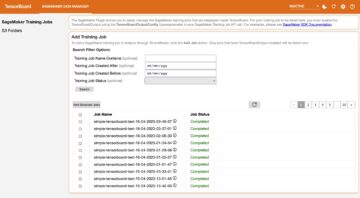

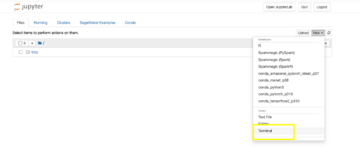

Akses JumpStart melalui UI Studio

Di bagian ini, kami mendemonstrasikan cara melatih dan menerapkan model JumpStart melalui UI Studio. Video berikut menunjukkan cara menemukan model Difusi Stabil pra-pelatihan di JumpStart, melatihnya, lalu menerapkannya. Halaman model berisi informasi berharga tentang model dan cara menggunakannya. Setelah mengonfigurasi instans pelatihan SageMaker, pilih Pelatihan VE. Setelah model dilatih, Anda dapat menerapkan model yang dilatih dengan memilih Menyebarkan. Setelah titik akhir dalam tahap "in service", siap untuk menanggapi permintaan inferensi.

Untuk mempercepat waktu inferensi, JumpStart menyediakan contoh notebook yang menunjukkan cara menjalankan inferensi pada titik akhir yang baru dibuat. Untuk mengakses buku catatan di Studio, pilih Buka Buku Catatan dalam Gunakan Endpoint dari Studio bagian dari halaman titik akhir model.

JumpStart juga menyediakan notebook sederhana yang dapat Anda gunakan untuk menyempurnakan model difusi stabil dan menerapkan model penyempurnaan yang dihasilkan. Anda dapat menggunakannya untuk menghasilkan gambar menyenangkan dari anjing Anda. Untuk mengakses buku catatan, cari "Hasilkan gambar Anjing Anda yang Menyenangkan" di bilah pencarian JumpStart. Untuk menjalankan notebook, Anda dapat menggunakan sedikitnya lima gambar pelatihan dan mengunggahnya ke folder studio lokal. Jika Anda memiliki lebih dari lima gambar, Anda juga dapat mengunggahnya. Notebook mengunggah gambar pelatihan ke S3, melatih model pada set data Anda, dan menerapkan model yang dihasilkan. Pelatihan mungkin memakan waktu 20 menit untuk selesai. Anda dapat mengubah jumlah langkah untuk mempercepat pelatihan. Notebook menyediakan beberapa contoh perintah untuk mencoba dengan model yang diterapkan, tetapi Anda dapat mencoba perintah apa pun yang Anda suka. Anda juga dapat mengadaptasi notebook untuk membuat avatar diri Anda atau hewan peliharaan Anda. Misalnya, alih-alih anjing Anda, Anda dapat mengunggah gambar kucing Anda pada langkah pertama dan kemudian mengubah perintah dari anjing menjadi kucing dan model tersebut akan menghasilkan gambar kucing Anda.

Pertimbangan penyesuaian

Model Training Stable Diffusion cenderung overfit dengan cepat. Untuk mendapatkan gambar berkualitas baik, kita harus menemukan keseimbangan yang baik antara hyperparameter pelatihan yang tersedia seperti jumlah langkah pelatihan dan kecepatan pembelajaran. Pada bagian ini, kami menunjukkan beberapa hasil eksperimen dan memberikan panduan tentang cara mengatur parameter tersebut.

Rekomendasi

Pertimbangkan rekomendasi berikut:

- Mulailah dengan kualitas gambar pelatihan yang baik (4–20). Jika melatih wajah manusia, Anda mungkin memerlukan lebih banyak gambar.

- Latih 200–400 langkah saat melatih anjing atau kucing dan subjek non-manusia lainnya. Jika berlatih dengan wajah manusia, Anda mungkin memerlukan lebih banyak langkah. Jika overfitting terjadi, kurangi njumlah langkah. Jika terjadi ketidaksesuaian (model yang disetel halus tidak dapat menghasilkan gambar subjek target), tingkatkan jumlah langkah.

- Jika berlatih pada wajah non-manusia, Anda dapat mengaturnya

with_prior_preservation = Falsekarena tidak terlalu mempengaruhi kinerja. Di wajah manusia, Anda mungkin perlu mengaturwith_prior_preservation=True. - Jika pengaturan

with_prior_preservation=True, gunakan jenis instans ml.g5.2xlarge. - Saat melatih beberapa subjek secara berurutan, jika subjeknya sangat mirip (misalnya, semua anjing), model mempertahankan subjek terakhir dan melupakan subjek sebelumnya. Jika subjeknya berbeda (misalnya, pertama seekor kucing kemudian seekor anjing), model mempertahankan kedua subjek tersebut.

- Sebaiknya gunakan laju pembelajaran rendah dan tingkatkan jumlah langkah secara bertahap hingga hasilnya memuaskan.

Kumpulan data pelatihan

Kualitas model yang disempurnakan secara langsung dipengaruhi oleh kualitas gambar pelatihan. Karena itu, Anda perlu mengumpulkan gambar berkualitas tinggi untuk mendapatkan hasil yang bagus. Gambar buram atau beresolusi rendah akan memengaruhi kualitas model yang disetel dengan baik. Perhatikan parameter tambahan berikut:

- Jumlah gambar pelatihan – Anda dapat menyempurnakan model hanya pada empat gambar pelatihan. Kami bereksperimen dengan kumpulan data pelatihan berukuran paling sedikit 4 gambar dan sebanyak 16 gambar. Dalam kedua kasus tersebut, fine-tuning dapat mengadaptasi model ke subjek.

- Format kumpulan data – Kami menguji algoritme penyempurnaan pada gambar dengan format .png, .jpg, dan .jpeg. Format lain juga dapat berfungsi.

- Resolusi gambar – Gambar pelatihan dapat berupa resolusi apa pun. Algoritme fine-tuning akan mengubah ukuran semua gambar latihan sebelum memulai fine-tuning. Karena itu, jika Anda ingin memiliki kontrol lebih atas pemangkasan dan pengubahan ukuran gambar pelatihan, sebaiknya ubah sendiri ukuran gambar ke resolusi dasar model (dalam contoh ini, 512×512 piksel).

Pengaturan percobaan

Dalam percobaan di posting ini, saat menyempurnakan kami menggunakan nilai default dari hyperparameter kecuali ditentukan. Selanjutnya, kami menggunakan salah satu dari empat kumpulan data:

- Anjing1-8 – Anjing 1 dengan 8 gambar

- Anjing1-16 – Anjing 1 dengan 16 gambar

- Anjing2-4 – Anjing 2 dengan empat gambar

- Kucing-8 – Kucing dengan 8 gambar

Untuk mengurangi kekacauan, kami hanya menampilkan satu gambar representatif dari kumpulan data di setiap bagian bersama dengan nama kumpulan data. Anda dapat menemukan set pelatihan lengkap di bagian ini Kumpulan Data Eksperimen di posting ini.

overfitting

Model Difusi Stabil cenderung overfit saat menyempurnakan beberapa gambar. Oleh karena itu, Anda perlu memilih parameter seperti epochs, max_epochs, dan kecepatan belajar dengan hati-hati. Pada bagian ini, kami menggunakan dataset Dog1-16.

Untuk mengevaluasi kinerja model, kami mengevaluasi model yang disesuaikan untuk empat tugas:

- Bisakah model yang disetel dengan baik menghasilkan gambar subjek (anjing Doppler) dalam pengaturan yang sama seperti yang dilatih?

- Observasi – Ya itu bisa. Perlu diperhatikan bahwa performa model meningkat dengan jumlah langkah pelatihan.

- Bisakah model yang disetel dengan baik menghasilkan gambar subjek dalam pengaturan yang berbeda dari yang dilatih? Misalnya, dapatkah menghasilkan gambar Doppler di pantai?

- Observasi – Ya itu bisa. Perlu diperhatikan bahwa performa model meningkat dengan jumlah langkah pelatihan hingga titik tertentu. Namun, jika model dilatih terlalu lama, kinerja model menurun karena model cenderung overfit.

- Bisakah model yang disetel dengan baik menghasilkan gambar kelas yang dimiliki oleh subjek pelatihan? Misalnya, dapatkah ini menghasilkan gambar anjing generik?

- Observasi – Saat kami menambah jumlah langkah pelatihan, model mulai menyesuaikan diri. Akibatnya, ia melupakan kelas generik seekor anjing dan hanya akan menghasilkan gambar yang terkait dengan subjeknya.

- Bisakah model yang disetel dengan baik menghasilkan gambar kelas atau subjek yang tidak ada dalam dataset pelatihan? Misalnya, dapatkah ini menghasilkan gambar kucing?

- Observasi – Saat kami menambah jumlah langkah pelatihan, model mulai menyesuaikan diri. Akibatnya, itu hanya akan menghasilkan gambar yang terkait dengan subjek, terlepas dari kelas yang ditentukan.

Kami menyempurnakan model untuk sejumlah langkah yang berbeda (dengan menyetel max_steps hyperparameters) dan untuk setiap model yang disempurnakan, kami menghasilkan gambar pada masing-masing dari empat petunjuk berikut (ditunjukkan dalam contoh berikut dari kiri ke kanan:

- “Foto anjing Doppler”

- “Foto anjing Doppler di pantai”

- “Foto anjing”

- “Foto kucing”

Gambar berikut berasal dari model yang dilatih dengan 50 langkah.

Model berikut dilatih dengan 100 langkah.

Kami melatih model berikut dengan 200 langkah.

Gambar berikut berasal dari model yang dilatih dengan 400 langkah.

Terakhir, gambar berikut adalah hasil dari 800 langkah.

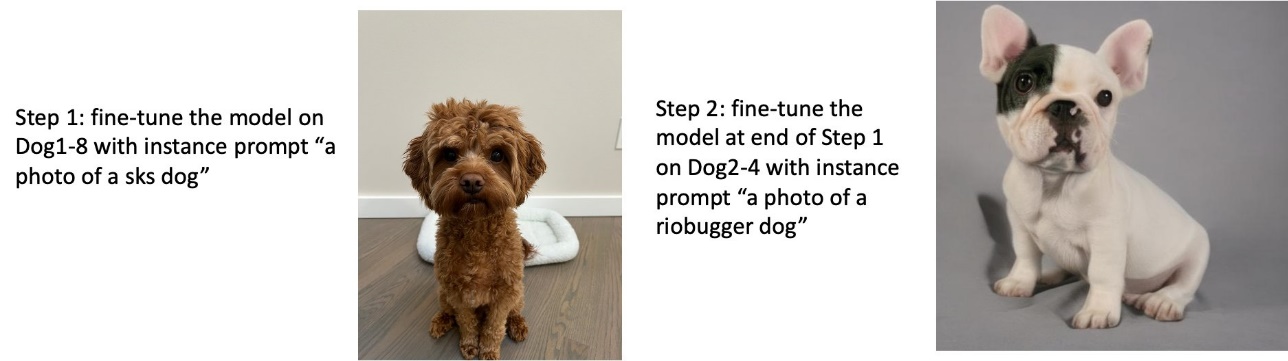

Latih beberapa set data

Saat menyempurnakan, Anda mungkin ingin menyempurnakan beberapa subjek dan membuat model yang telah disempurnakan dapat menghasilkan gambar dari semua subjek. Sayangnya, JumpStart saat ini terbatas pada pelatihan satu subjek. Anda tidak dapat menyempurnakan model pada beberapa subjek sekaligus. Selanjutnya, menyempurnakan model untuk subjek yang berbeda secara berurutan menghasilkan model yang melupakan subjek pertama jika subjeknya serupa.

Kami mempertimbangkan eksperimen berikut di bagian ini:

- Sempurnakan model untuk Subjek A.

- Sempurnakan model yang dihasilkan dari Langkah 1 untuk Subjek B.

- Hasilkan gambar Subjek A dan Subjek B menggunakan model output dari Langkah 2.

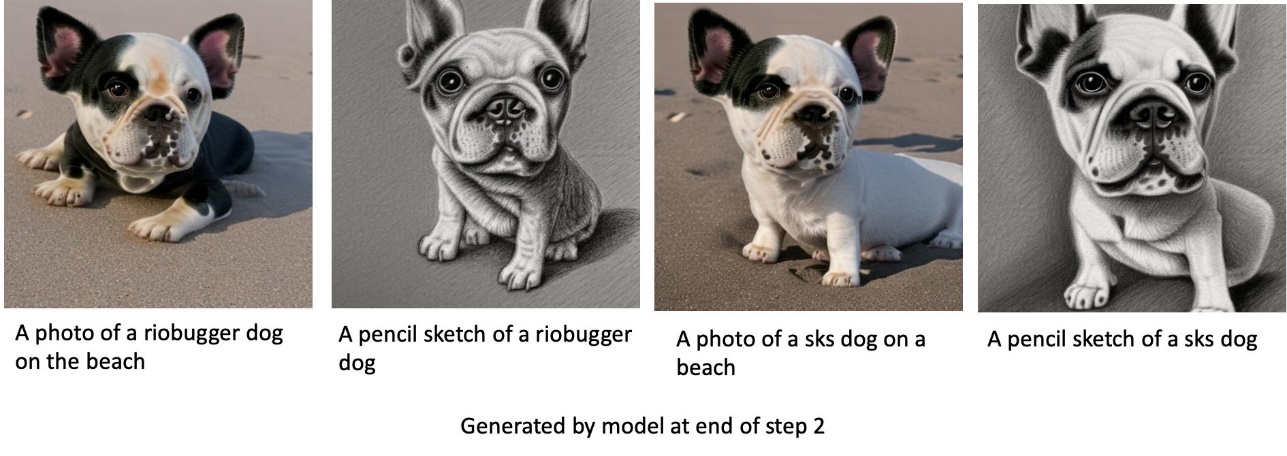

Dalam percobaan berikut, kami mengamati bahwa:

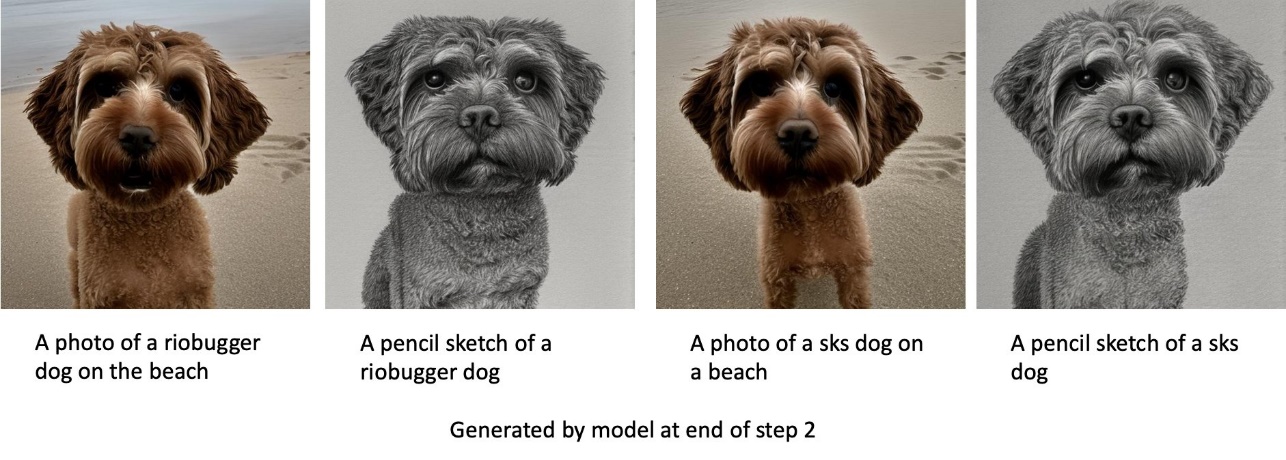

- Jika A adalah anjing 1 dan B adalah anjing 2, maka semua gambar yang dihasilkan pada Langkah 3 menyerupai anjing 2

- Jika A adalah anjing 2 dan B adalah anjing 1, maka semua gambar yang dihasilkan pada Langkah 3 menyerupai anjing 1

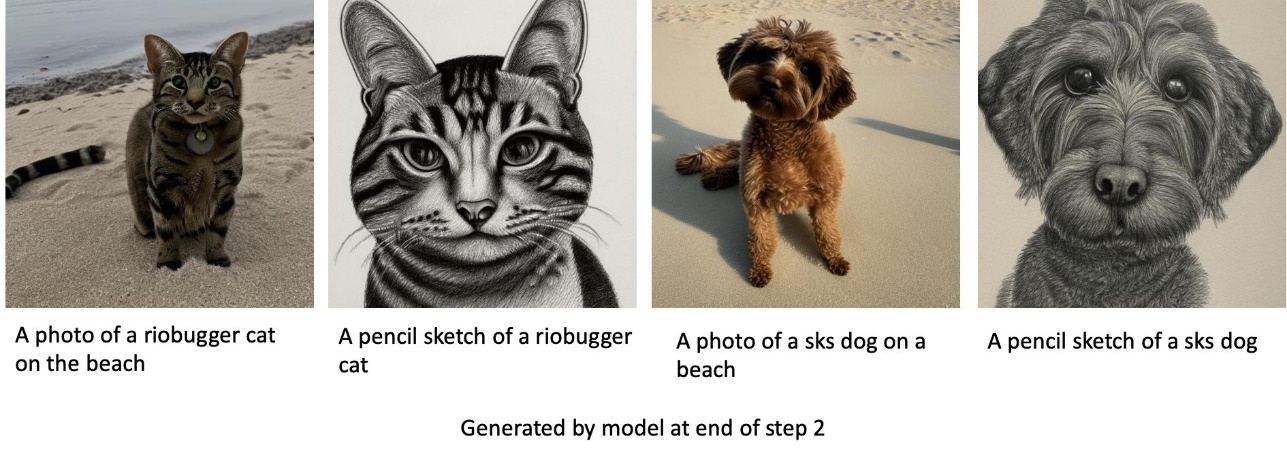

- Jika A adalah anjing 1 dan B adalah kucing, maka gambar yang dihasilkan dengan prompt anjing akan menyerupai anjing 1 dan gambar yang dihasilkan dengan prompt kucing akan menyerupai kucing

Latih anjing 1 dan kemudian anjing 2

Pada Langkah 1, kami menyempurnakan model untuk 200 langkah pada delapan gambar anjing 1. Pada Langkah 2, kami menyempurnakan model lebih lanjut untuk 200 langkah pada empat gambar anjing 2.

Berikut ini adalah gambar yang dihasilkan oleh model yang disempurnakan di akhir Langkah 2 untuk petunjuk yang berbeda.

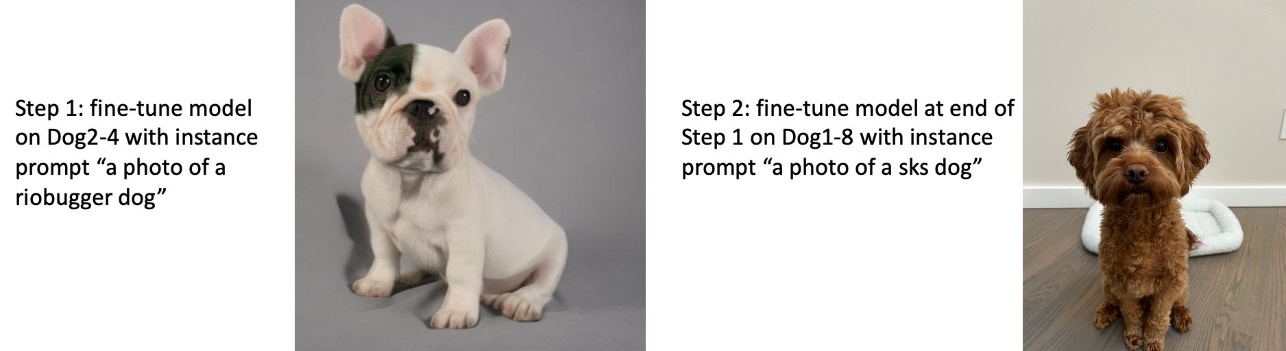

Latih anjing 2 dan kemudian anjing 1

Pada Langkah 1, kami menyempurnakan model untuk 200 langkah pada empat gambar anjing 2. Pada Langkah 2, kami menyempurnakan model lebih lanjut untuk 200 langkah pada delapan gambar anjing 1.

Berikut ini adalah gambar yang dihasilkan oleh model yang disempurnakan pada akhir Langkah 2 dengan petunjuk yang berbeda.

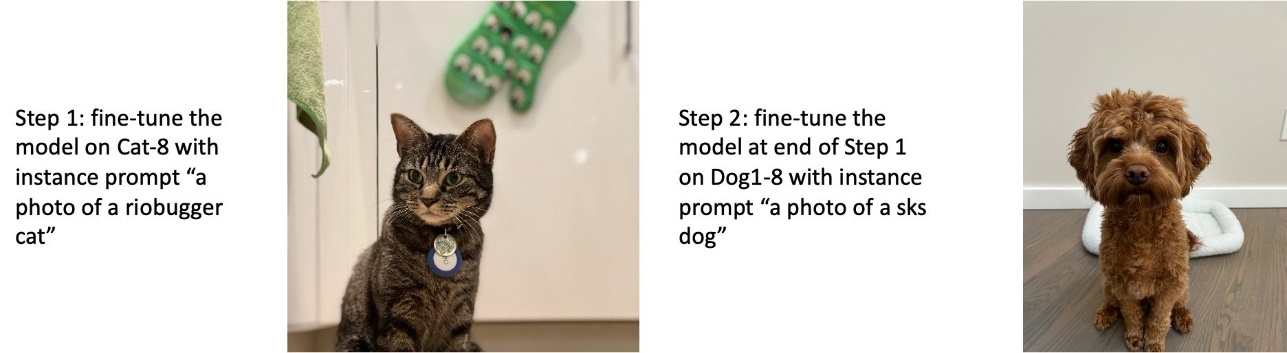

Latih anjing dan kucing

Pada Langkah 1, kami menyempurnakan model untuk 200 langkah pada delapan gambar kucing. Kemudian kami menyempurnakan model lebih lanjut untuk 200 langkah pada delapan gambar anjing 1.

Berikut ini adalah gambar yang dihasilkan oleh model fine-tuning di akhir Langkah 2. Gambar dengan prompt terkait kucing terlihat seperti kucing di Langkah 1 fine-tuning, dan gambar dengan prompt terkait anjing terlihat seperti anjing di Langkah 2 dari fine-tuning.

Preservasi sebelumnya

Pelestarian sebelumnya adalah teknik yang menggunakan gambar tambahan dari kelas yang sama yang kami coba latih. Misalnya, jika data pelatihan terdiri dari gambar anjing tertentu, dengan preservasi sebelumnya, kami menggabungkan gambar kelas anjing generik. Mencoba untuk menghindari overfitting dengan menampilkan gambar anjing yang berbeda saat melatih anjing tertentu. Tag yang menunjukkan anjing tertentu yang ada di prompt instance tidak ada di prompt kelas. Misalnya, prompt contoh mungkin "foto kucing riobugger" dan prompt kelas mungkin "foto kucing". Anda dapat mengaktifkan preservasi sebelumnya dengan menyetel hyperparameter with_prior_preservation = True. Jika pengaturan with_prior_preservation = True, Anda harus menyertakan class_prompt in dataset_info.json dan dapat menyertakan gambar kelas apa pun yang tersedia untuk Anda. Berikut format dataset training saat setting with_prior_preservation = True:

- Memasukkan – Direktori yang berisi gambar instance,

dataset_info.jsondan (opsional) direktoriclass_data_dir. Perhatikan hal berikut:- Gambar boleh dalam format .png, .jpg, .jpeg.

- Grafik

dataset_info.jsonfile harus dalam format{'instance_prompt':<<instance_prompt>>,'class_prompt':<<class_prompt>>}. - Grafik

class_data_dirdirektori harus memiliki gambar kelas. Jikaclass_data_dirtidak ada atau tidak ada cukup gambar yang sudah adaclass_data_dir, gambar tambahan akan diambil sampelnyaclass_prompt.

Untuk kumpulan data seperti kucing dan anjing, preservasi sebelumnya tidak berdampak signifikan pada performa model yang disetel dengan baik dan oleh karena itu dapat dihindari. Namun, saat melatih wajah, ini perlu. Untuk informasi lebih lanjut, lihat Melatih Difusi Stabil dengan Dreambooth menggunakan Diffuser.

Jenis instance

Penyempurnaan model Difusi Stabil memerlukan komputasi yang dipercepat yang disediakan oleh instans yang didukung GPU. Kami melakukan percobaan penyempurnaan dengan instans ml.g4dn.2xlarge (memori CUDA 16 GB, 1 GPU) dan ml.g5.2xlarge (memori CUDA 24 GB, 1 GPU). Persyaratan memori lebih tinggi saat membuat gambar kelas. Oleh karena itu, jika pengaturan with_prior_preservation=True, gunakan jenis instans ml.g5.2xlarge, karena pelatihan mengalami masalah CUDA kehabisan memori pada instans ml.g4dn.2xlarge. Skrip fine-tuning JumpStart saat ini menggunakan GPU tunggal dan karenanya, fine-tuning pada instans multi-GPU tidak akan menghasilkan peningkatan performa. Untuk informasi selengkapnya tentang berbagai jenis instans, lihat Jenis Instans Amazon EC2.

Keterbatasan dan bias

Meskipun Stable Diffusion memiliki kinerja yang mengesankan dalam menghasilkan gambar, ia mengalami beberapa keterbatasan dan bias. Ini termasuk tetapi tidak terbatas pada:

- Model mungkin tidak menghasilkan wajah atau anggota tubuh yang akurat karena data pelatihan tidak menyertakan gambar yang memadai dengan fitur ini

- Model dilatih di Kumpulan data LAION-5B, yang memiliki konten khusus dewasa dan mungkin tidak sesuai untuk penggunaan produk tanpa pertimbangan lebih lanjut

- Model mungkin tidak bekerja dengan baik dengan bahasa non-Inggris karena model dilatih pada teks bahasa Inggris

- Model tidak dapat menghasilkan teks yang bagus di dalam gambar

Untuk informasi lebih lanjut tentang keterbatasan dan bias, lihat Kartu Model Difusi Stabil v2-1-base. Keterbatasan untuk model pra-pelatihan ini juga dapat diterapkan pada model yang disetel dengan baik.

Membersihkan

Setelah Anda selesai menjalankan notebook, pastikan untuk menghapus semua sumber daya yang dibuat dalam proses untuk memastikan penagihan dihentikan. Kode untuk membersihkan titik akhir disediakan di terkait Pengantar JumpStart – Teks ke Gambar contoh buku catatan.

Model fine-tuned tersedia untuk umum di JumpStart

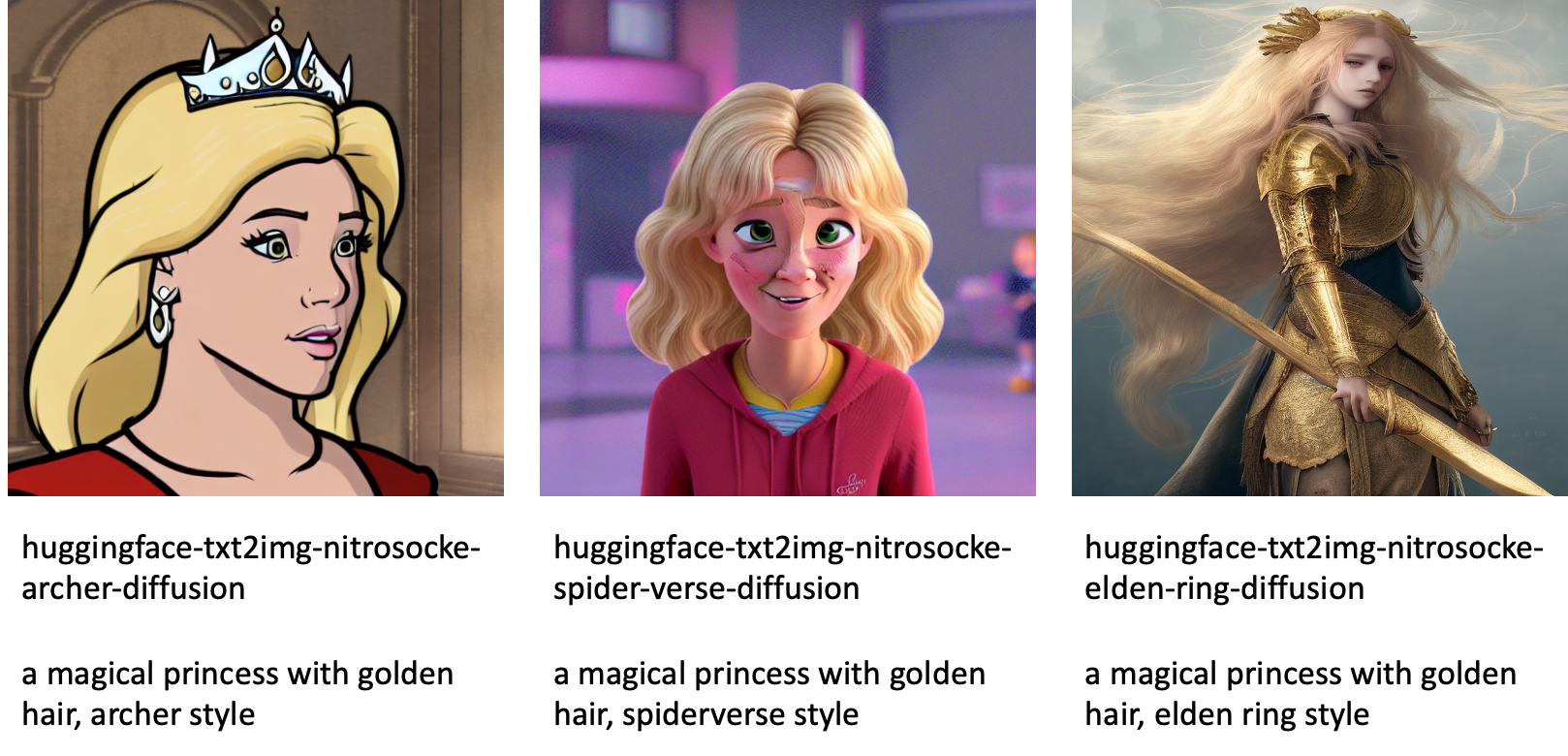

Meskipun model Difusi Stabil dirilis oleh StabilitasAI memiliki kinerja yang mengesankan, mereka memiliki keterbatasan dalam hal bahasa atau domain yang dilatihnya. Misalnya, model Difusi Stabil dilatih pada teks bahasa Inggris, tetapi Anda mungkin perlu membuat gambar dari teks non-Inggris. Alternatifnya, model Difusi Stabil dilatih untuk menghasilkan gambar fotorealistik, tetapi Anda mungkin perlu membuat gambar animasi atau artistik.

JumpStart menyediakan lebih dari 80 model yang tersedia untuk umum dengan berbagai bahasa dan tema. Model ini sering kali merupakan versi yang disempurnakan dari model Difusi Stabil yang dirilis oleh StabilityAI. Jika kasus penggunaan Anda cocok dengan salah satu model yang telah disempurnakan, Anda tidak perlu mengumpulkan set data Anda sendiri dan menyempurnakannya. Anda cukup menerapkan salah satu model ini melalui UI Studio atau menggunakan API JumpStart yang mudah digunakan. Untuk menerapkan model Difusi Stabil pra-pelatihan di JumpStart, lihat Hasilkan gambar dari teks dengan model difusi stabil di Amazon SageMaker JumpStart.

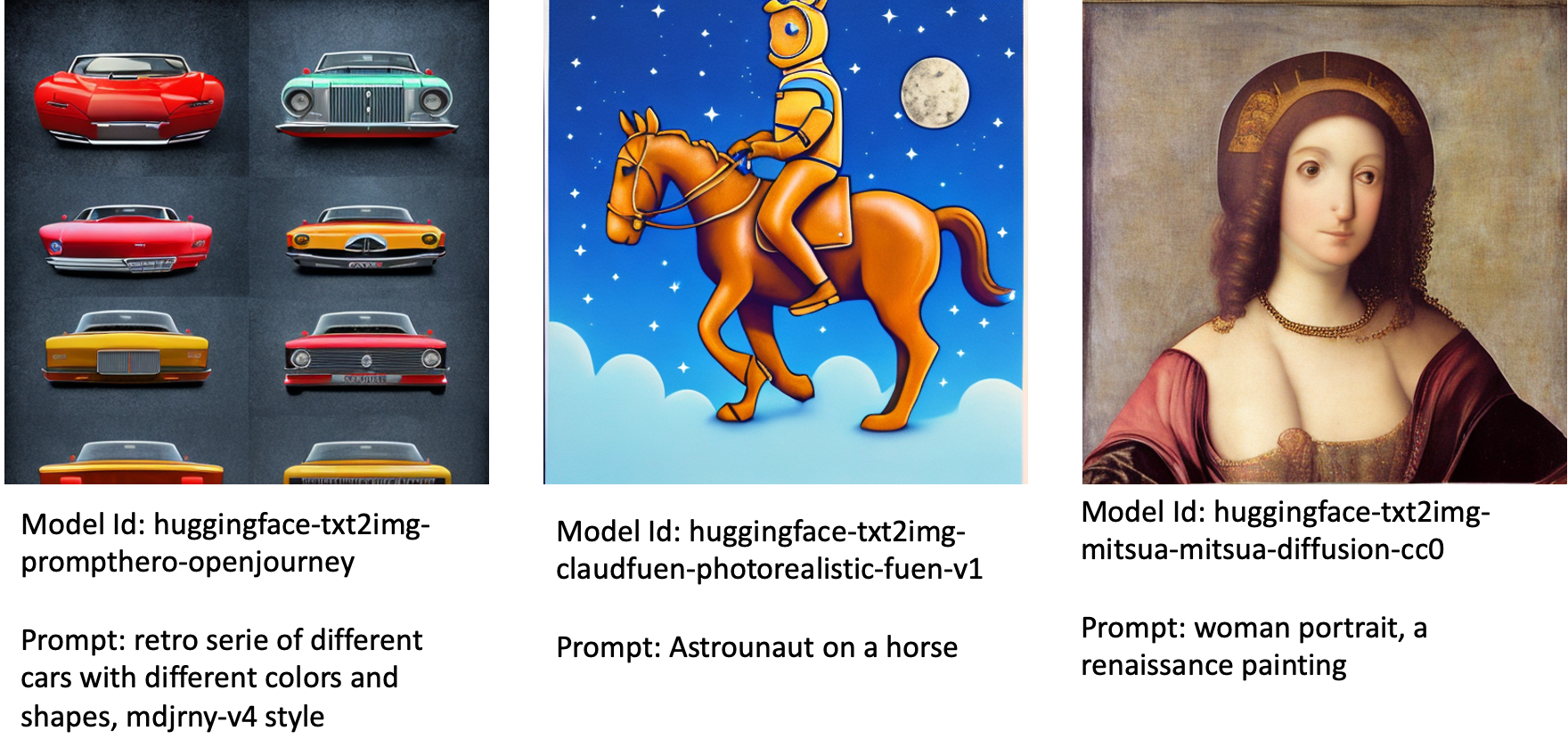

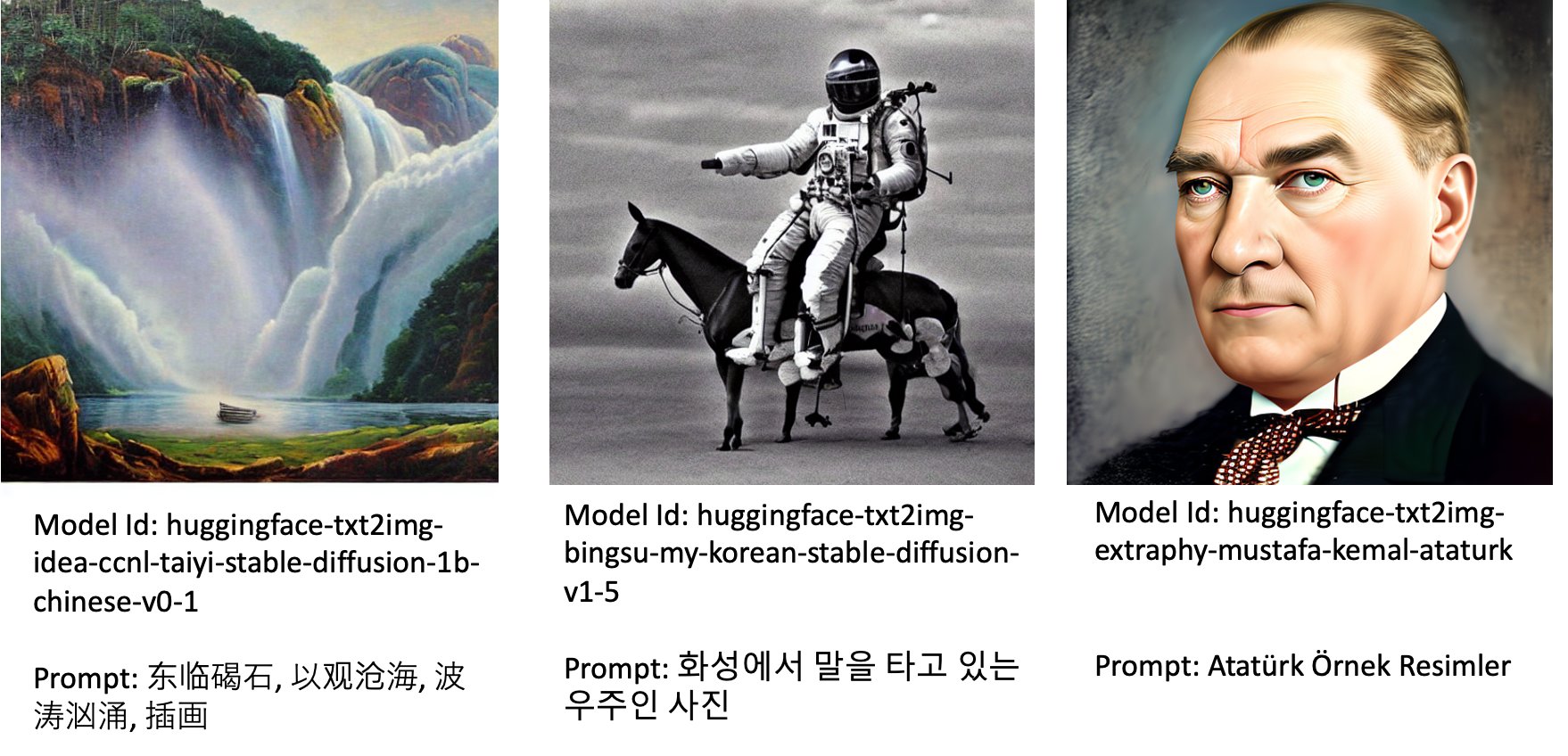

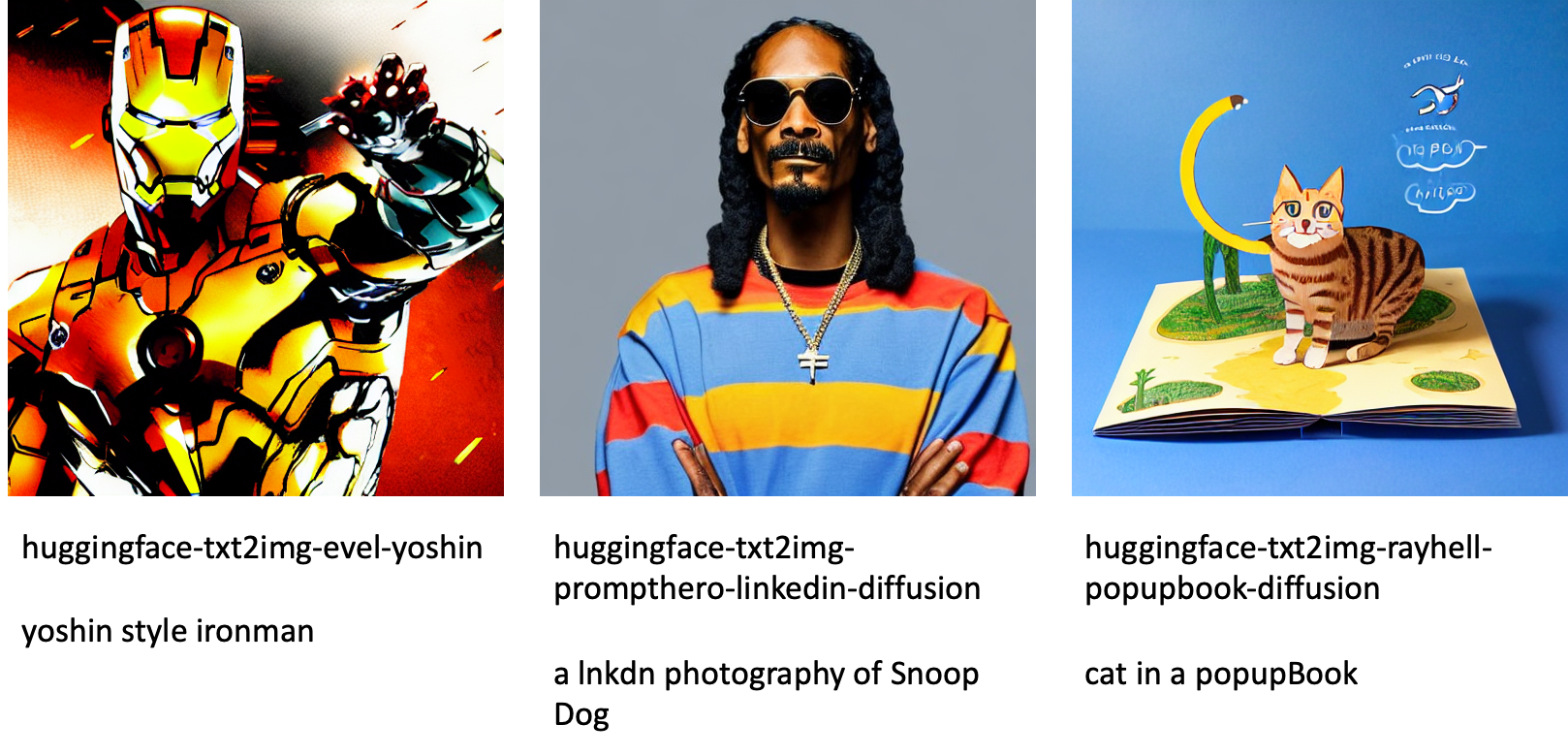

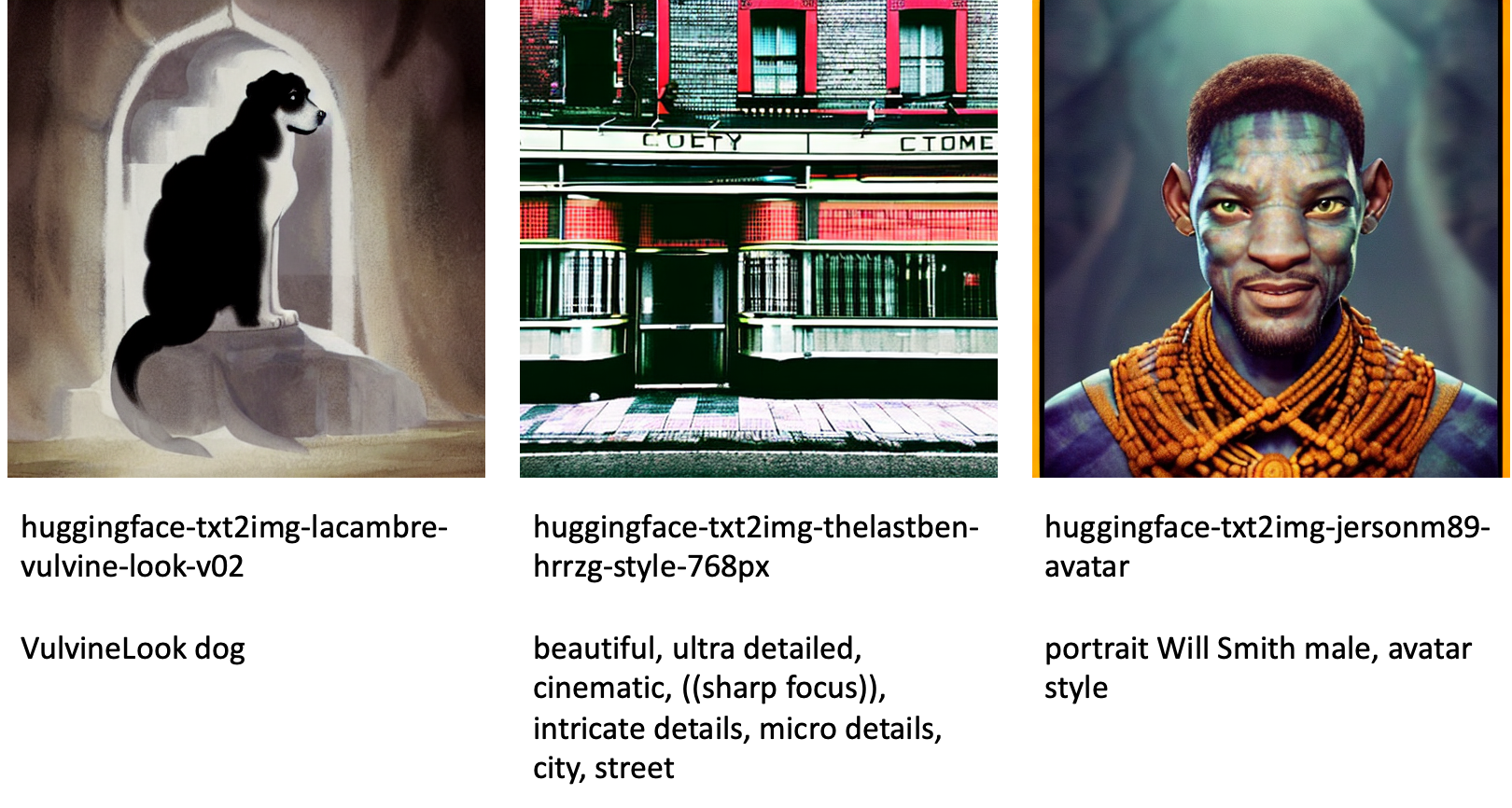

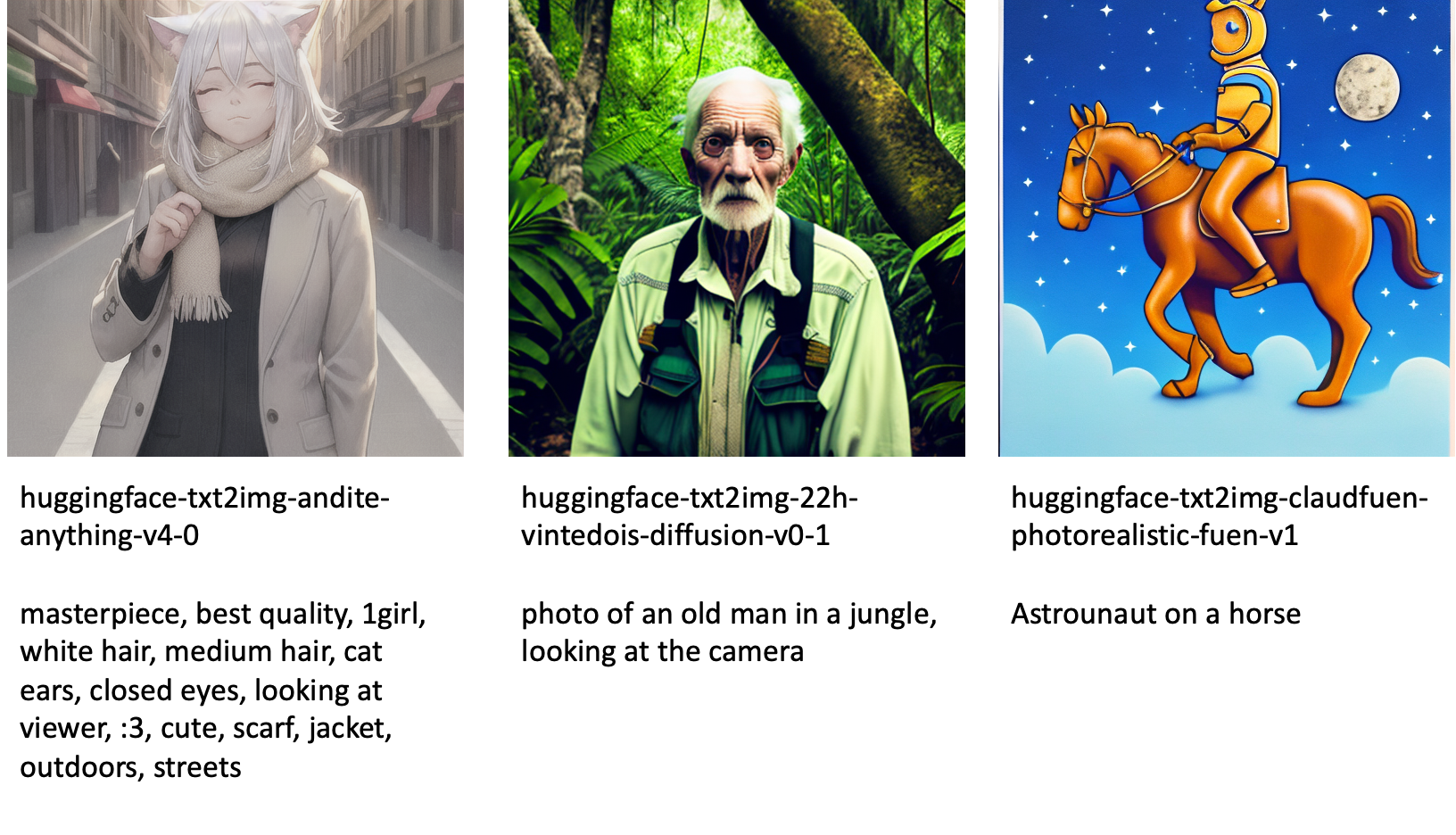

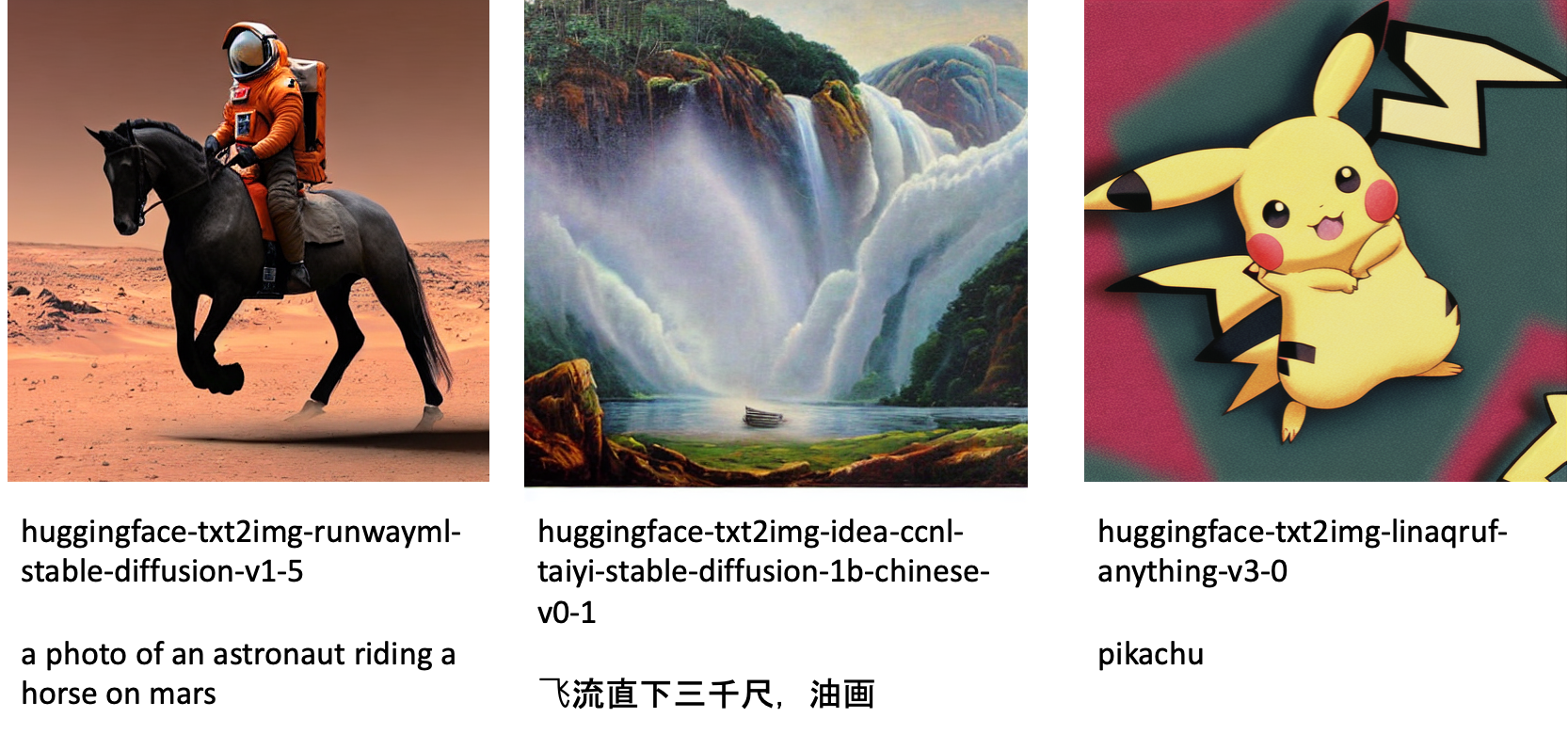

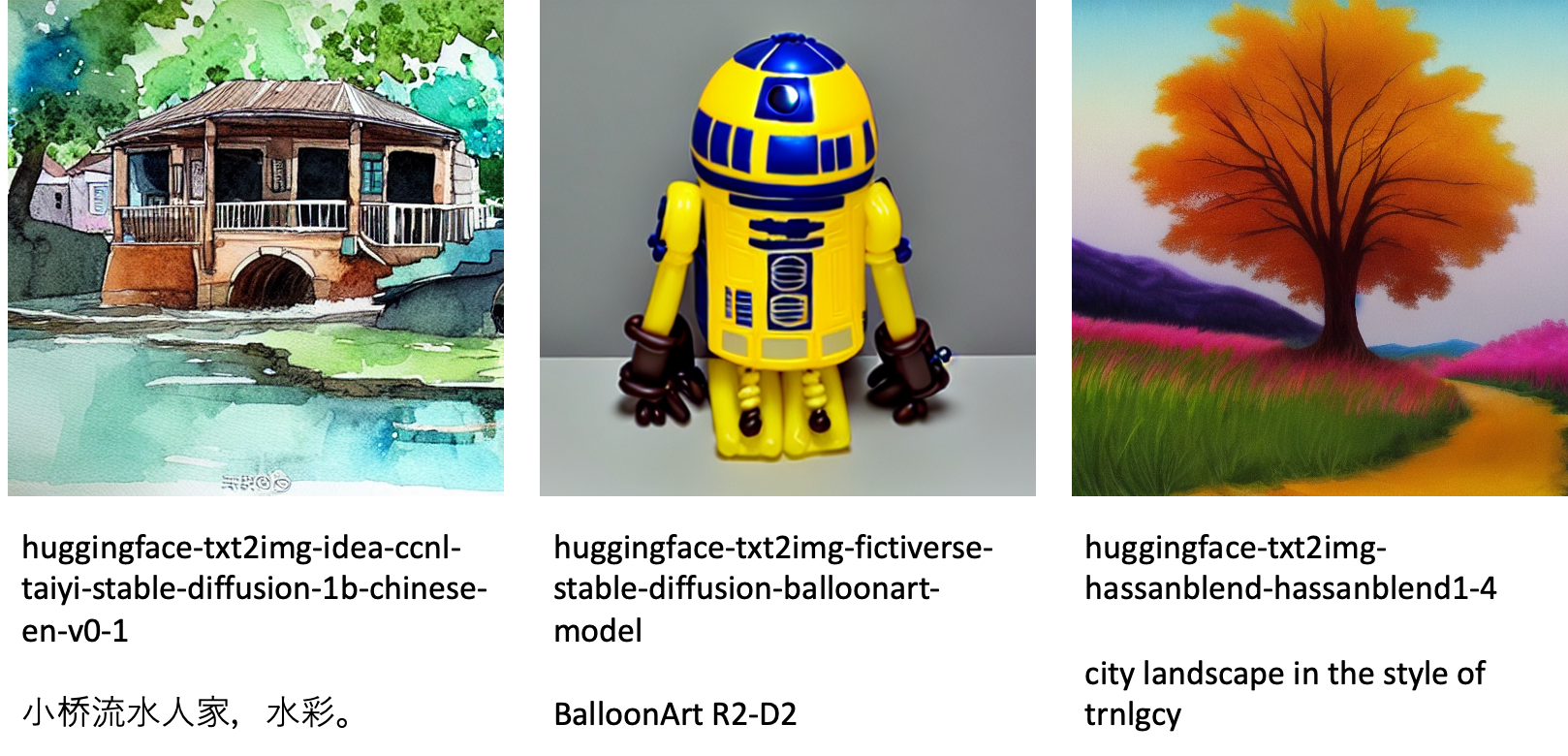

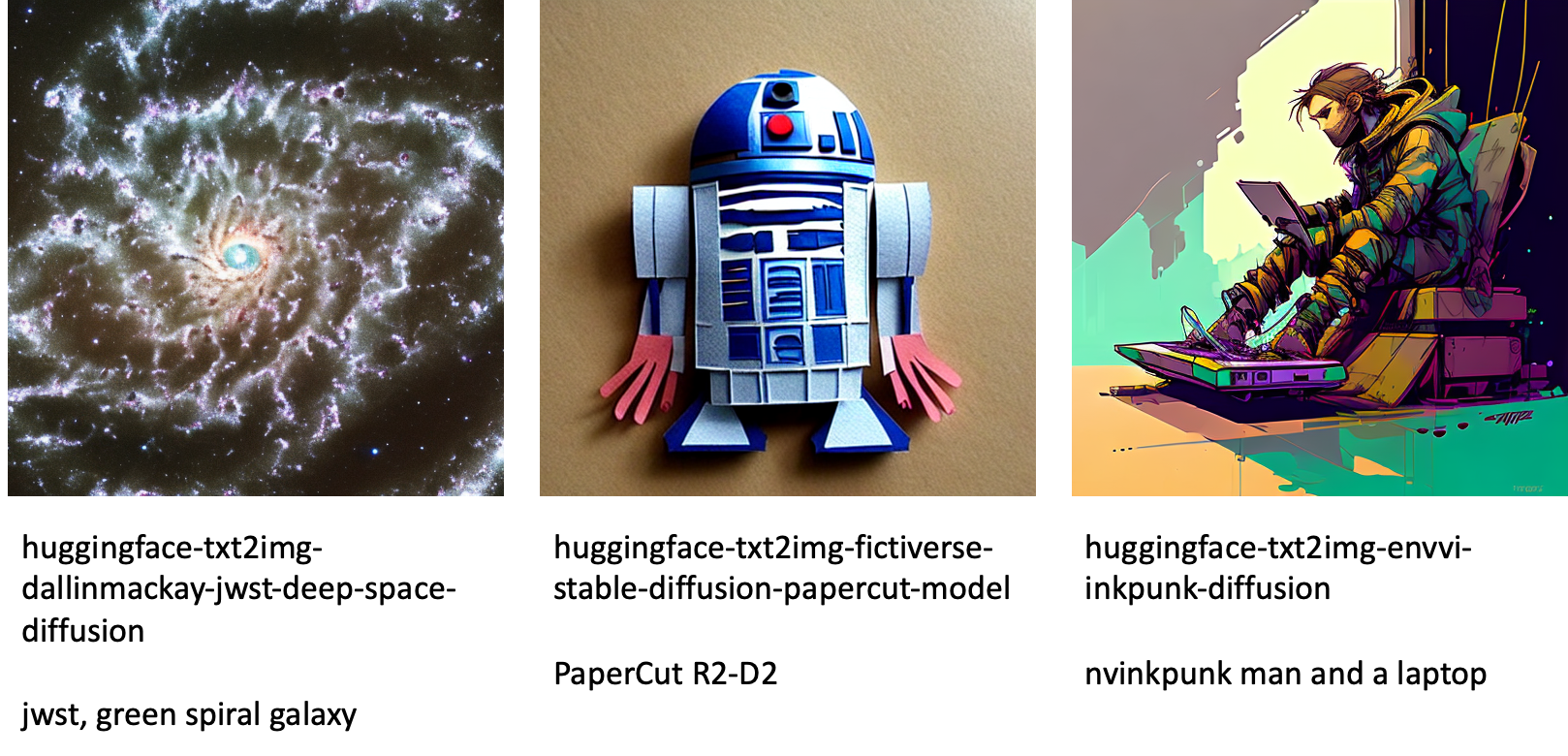

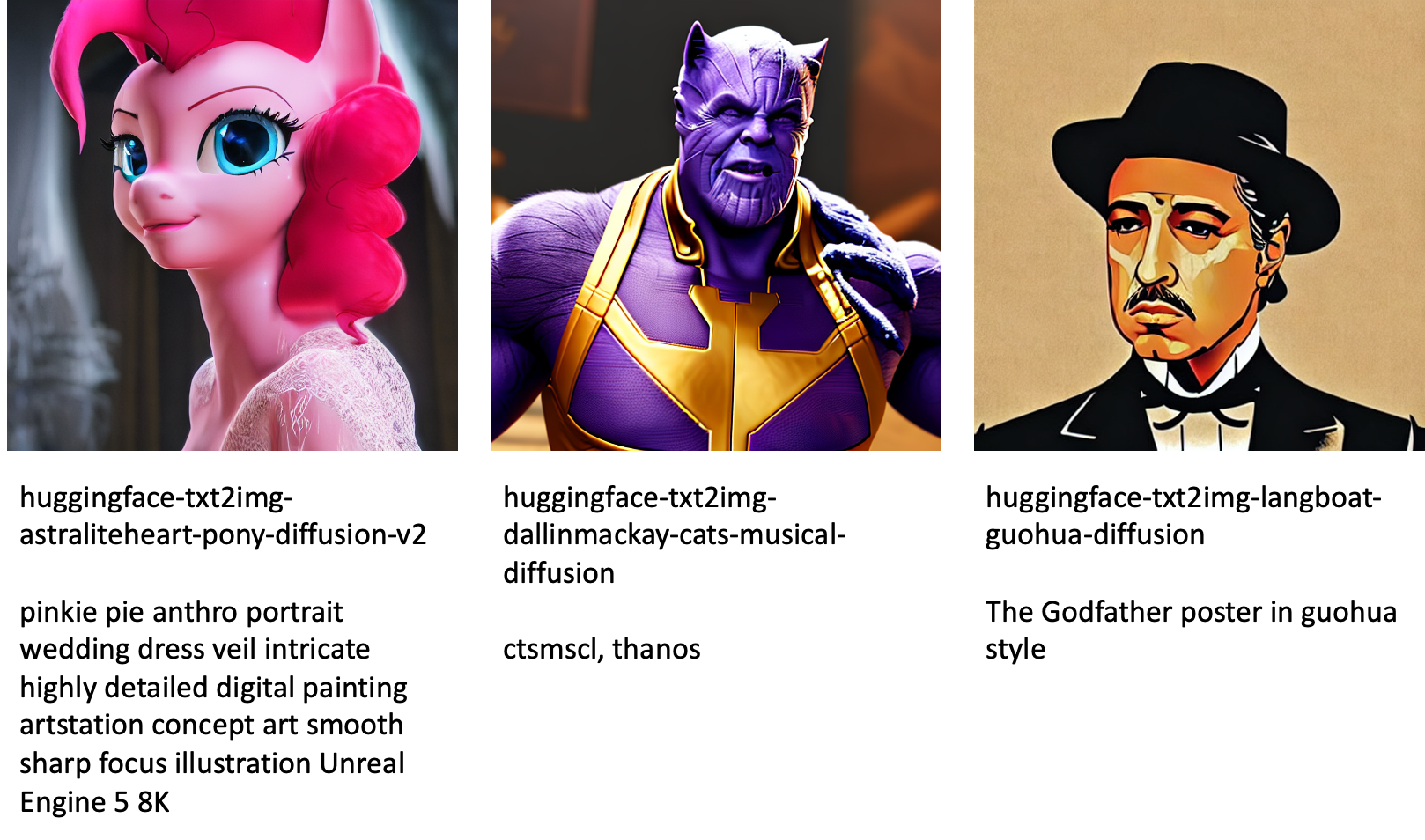

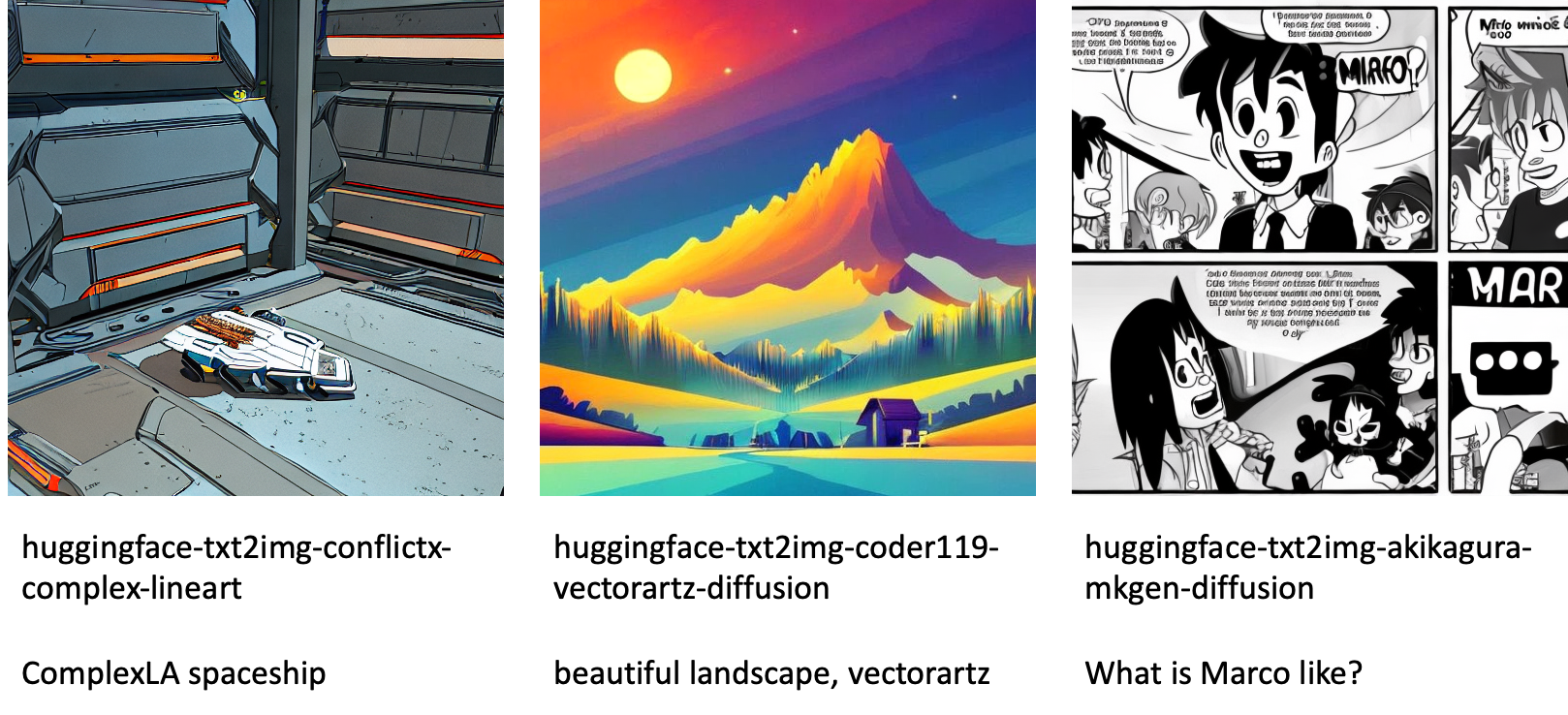

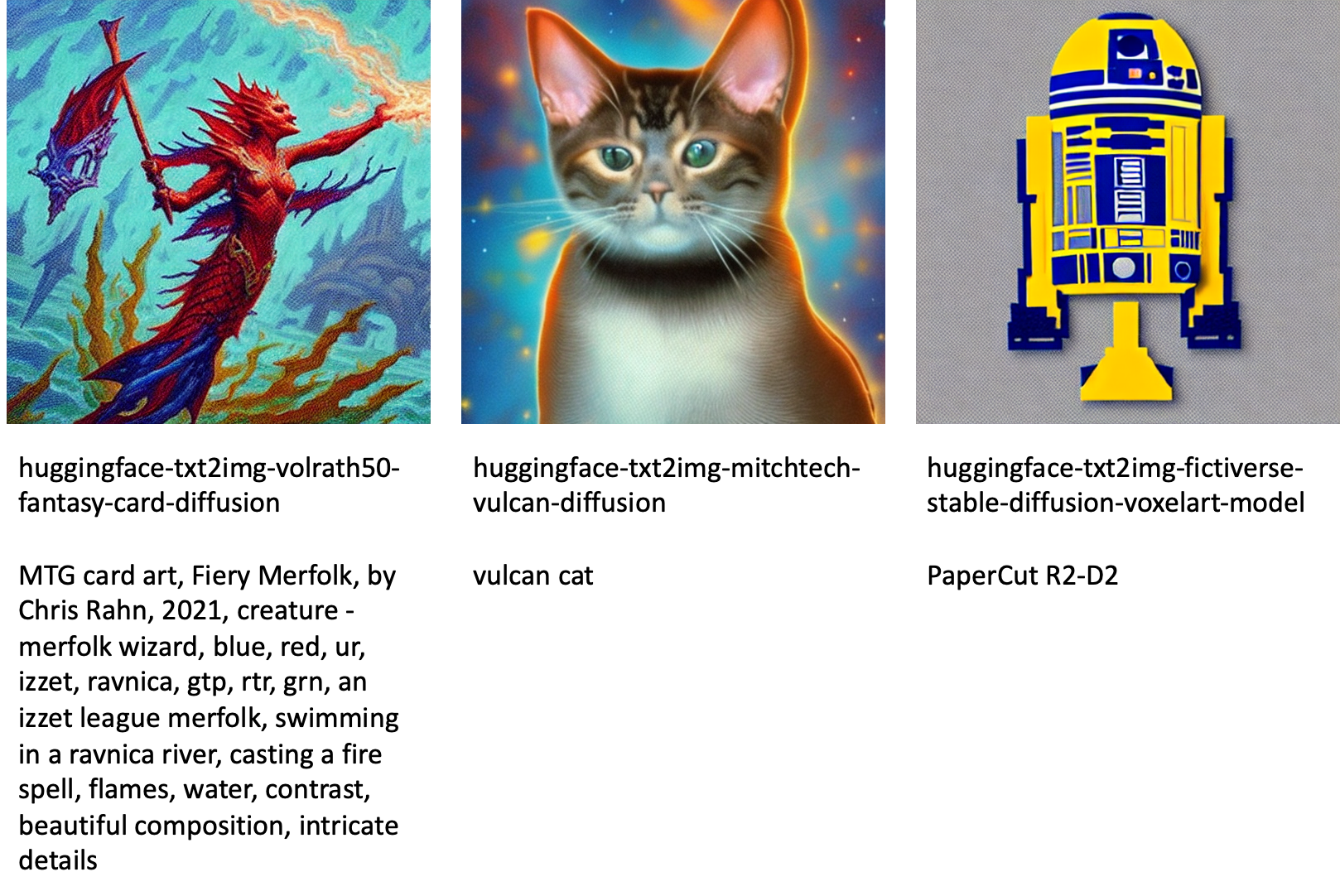

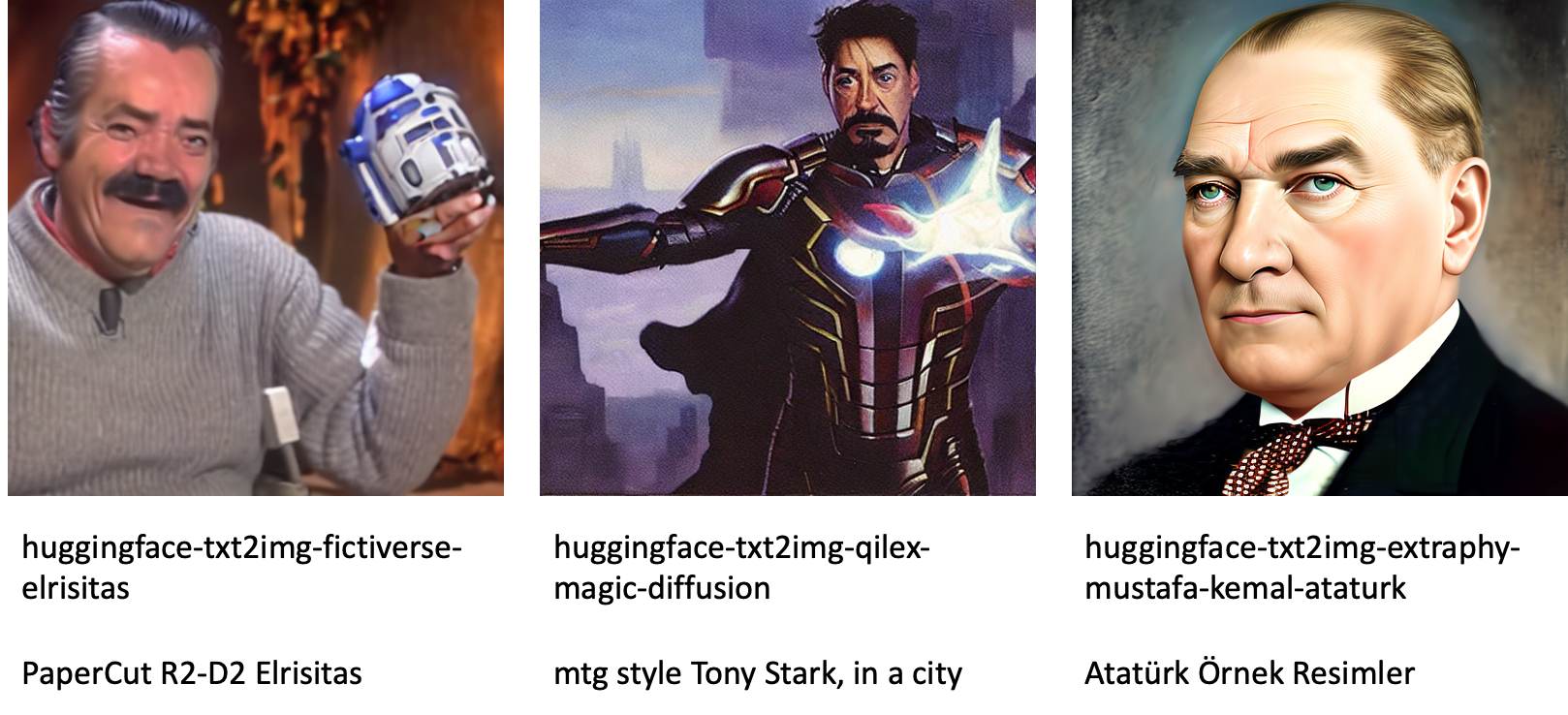

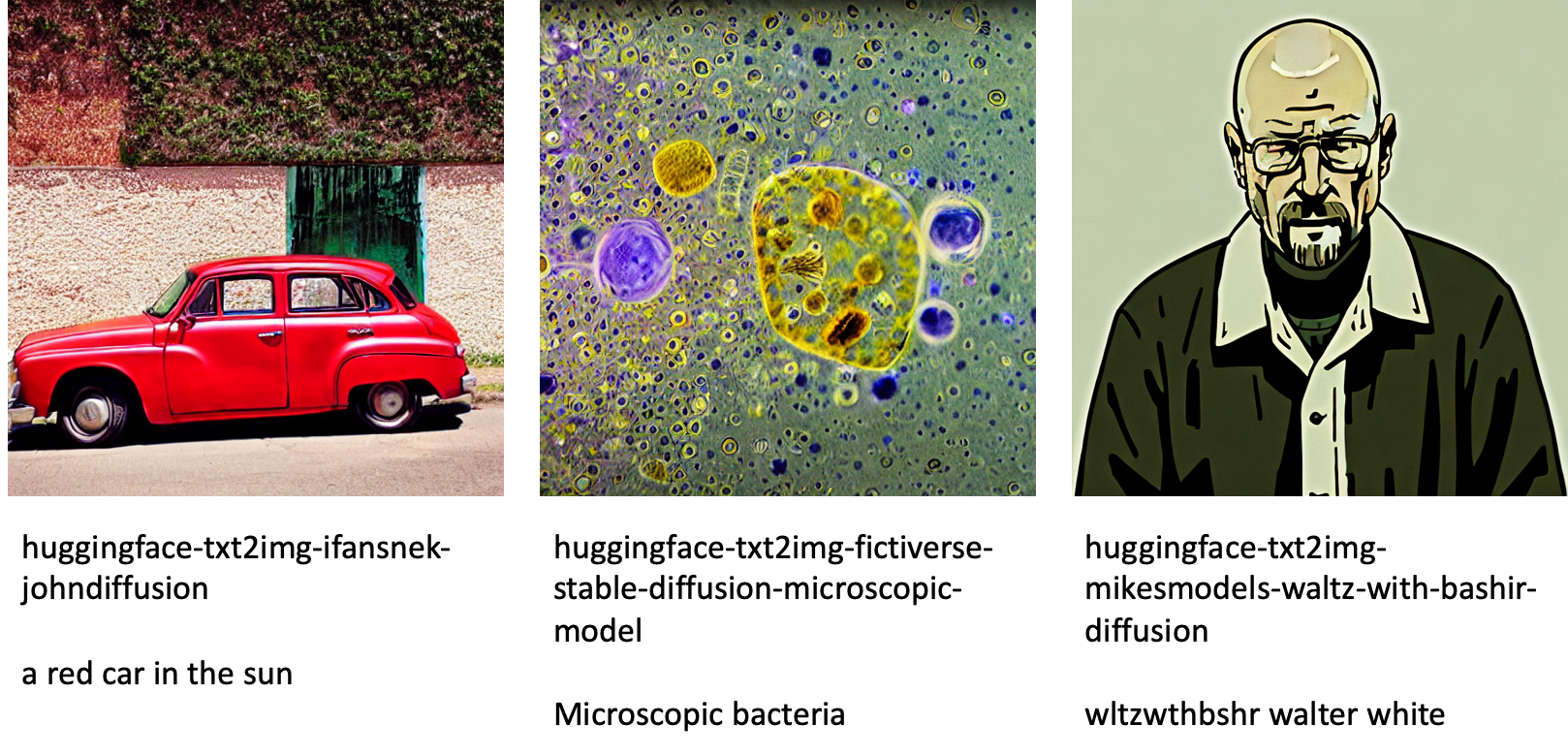

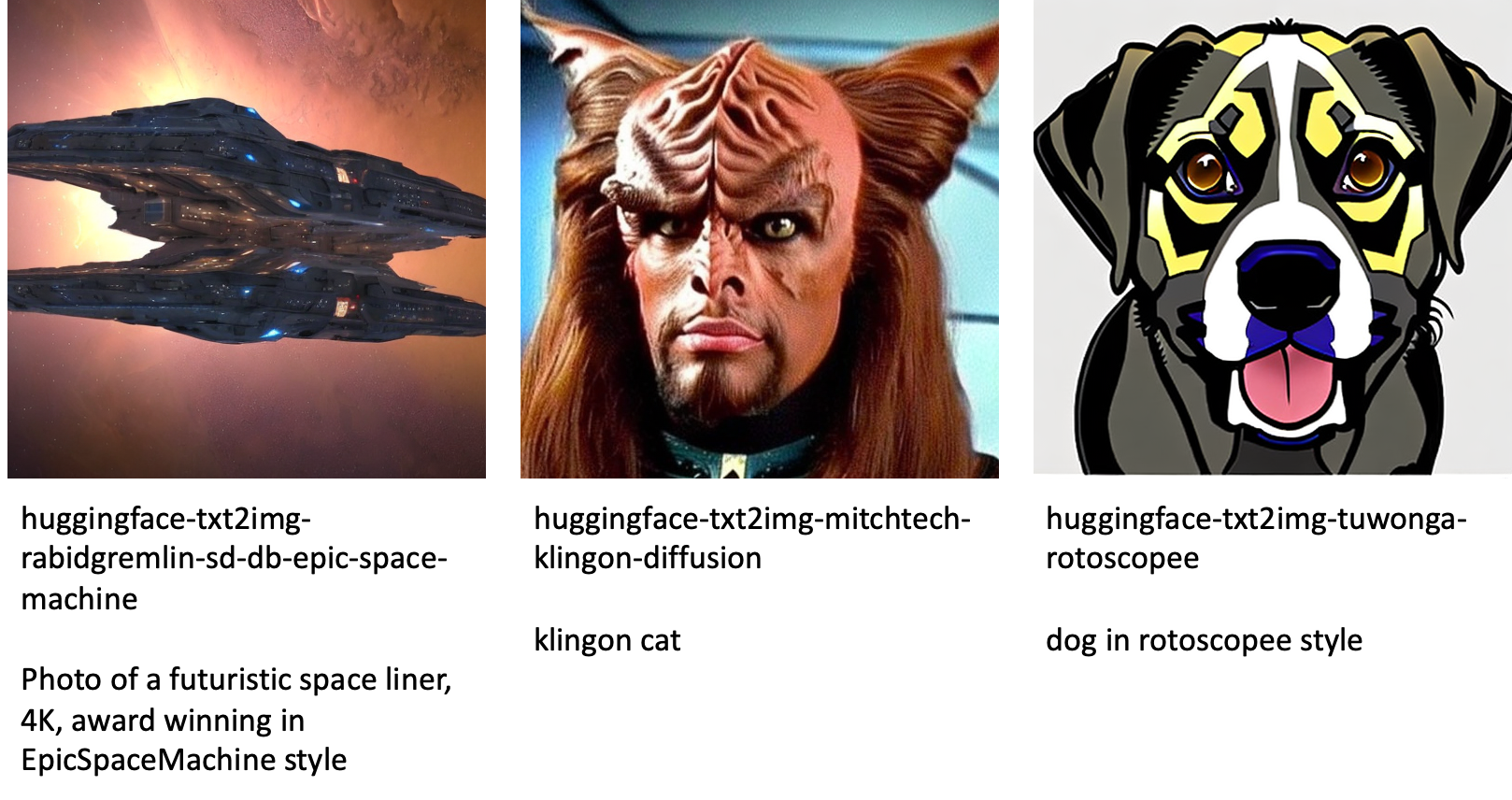

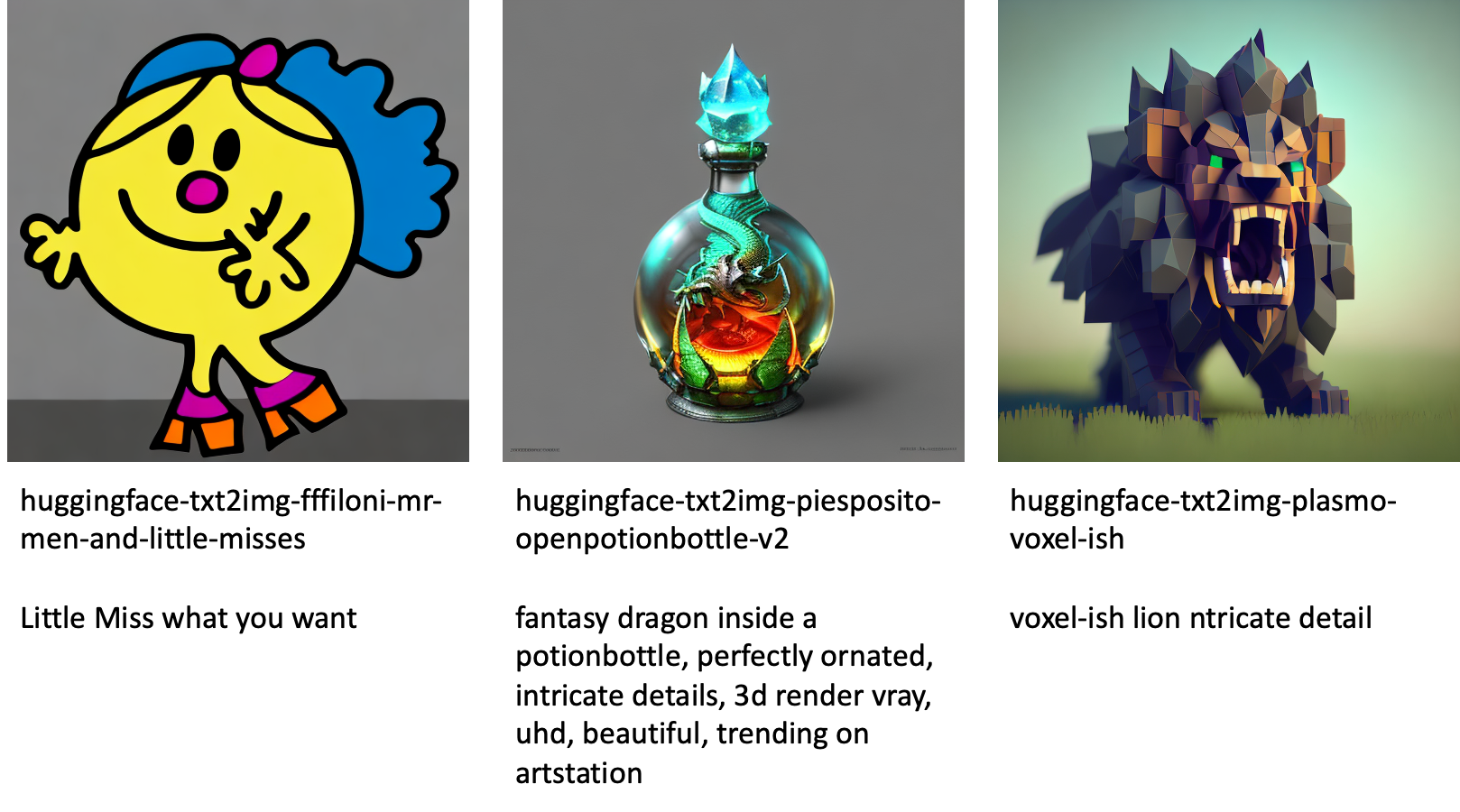

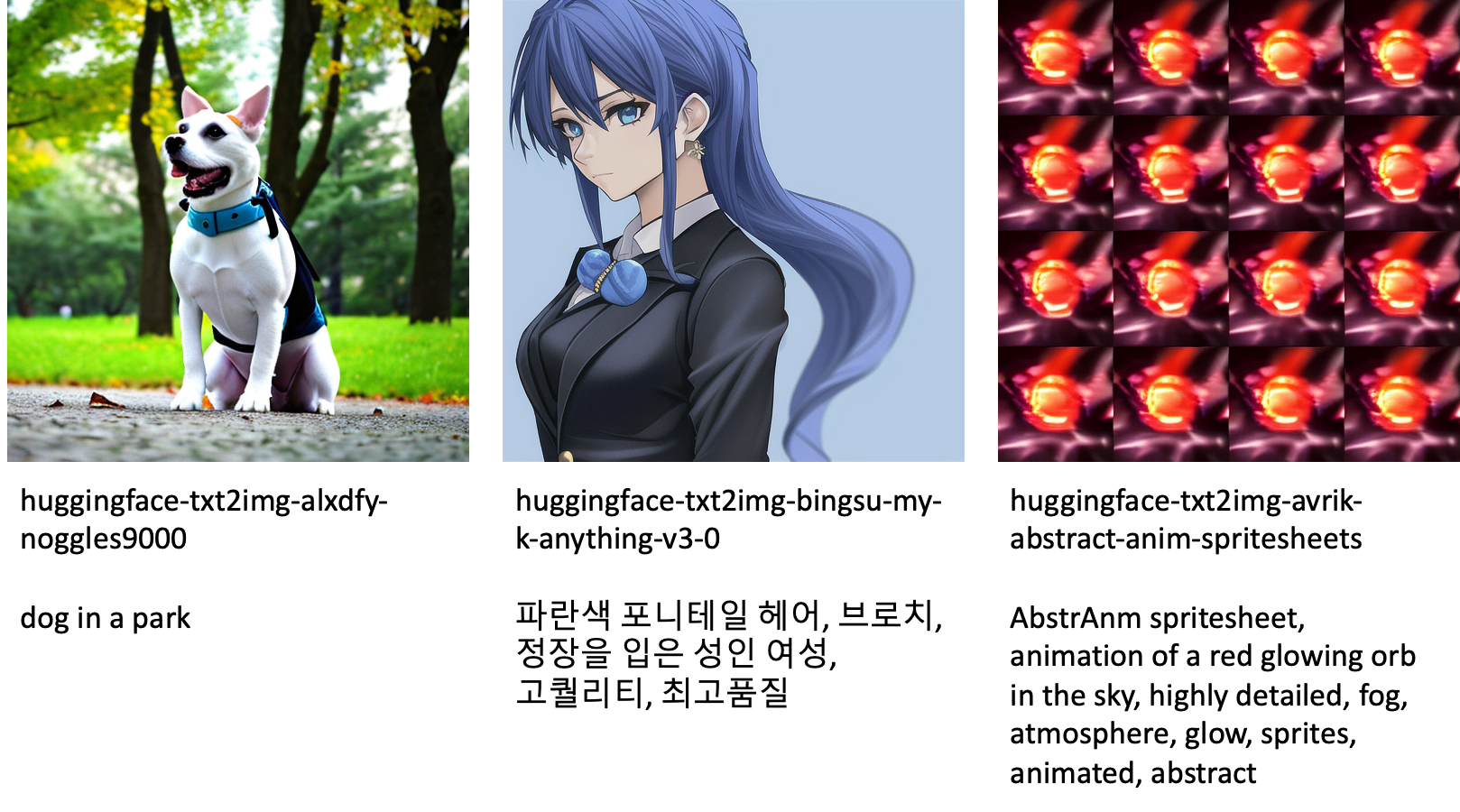

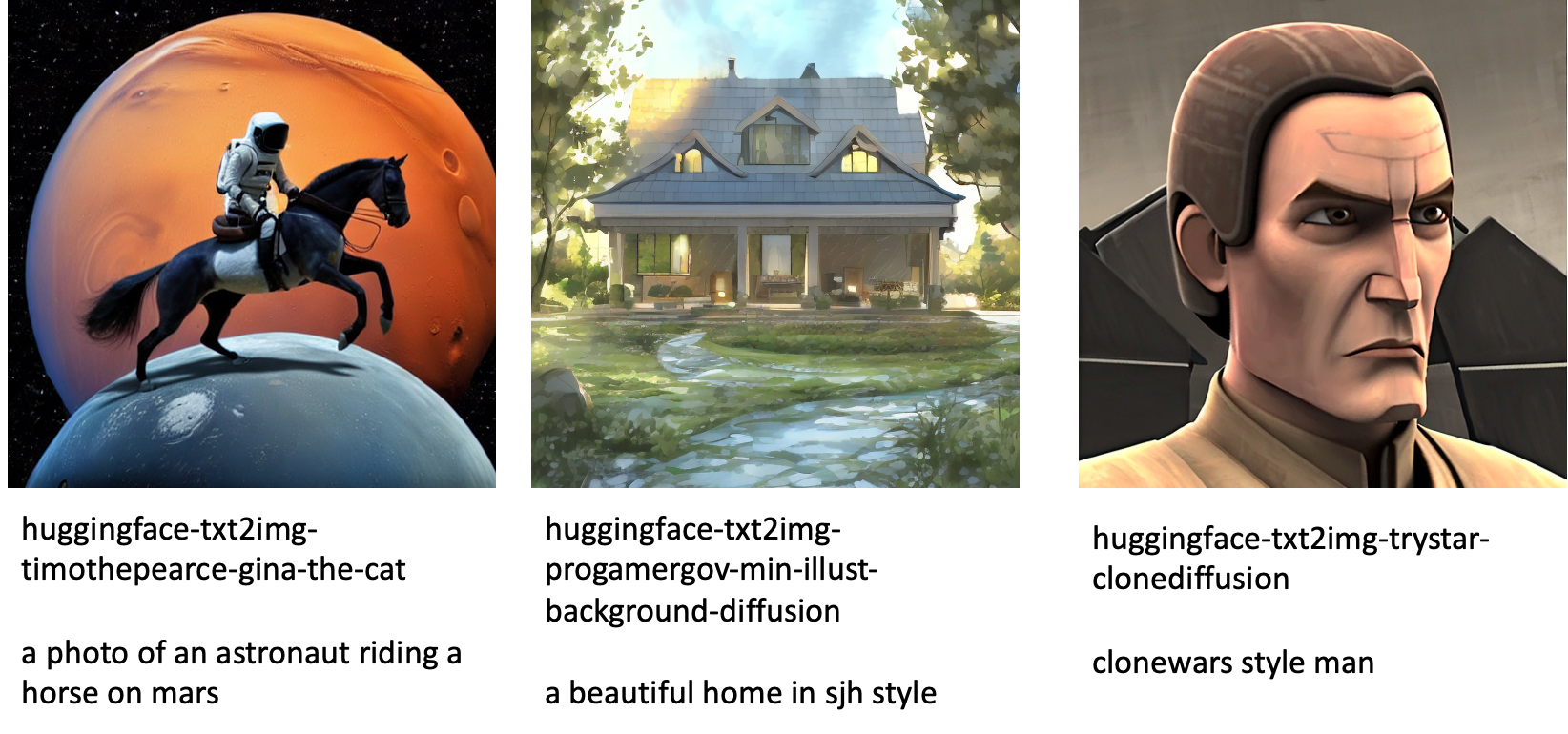

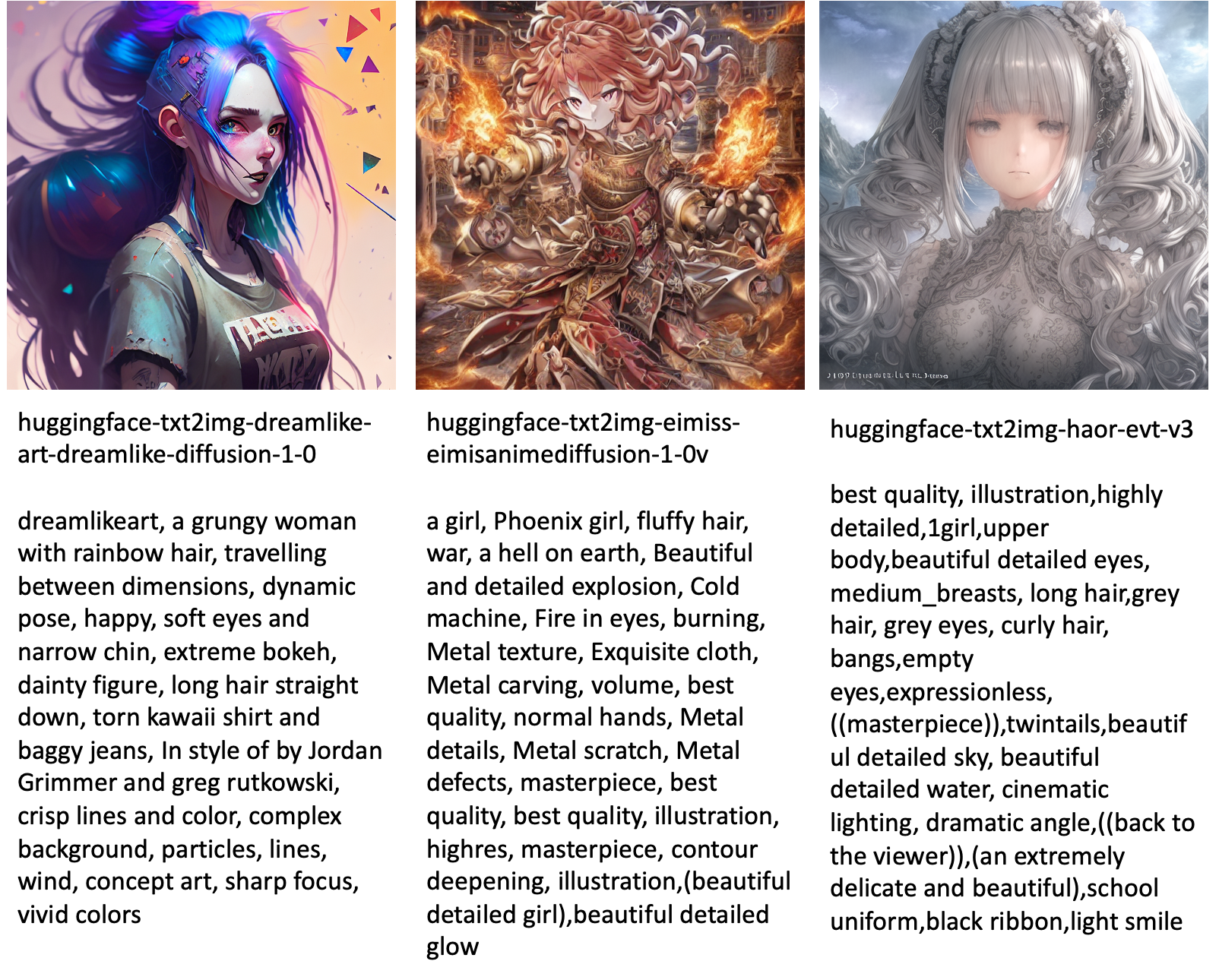

Berikut adalah beberapa contoh gambar yang dihasilkan oleh berbagai model yang tersedia di JumpStart.

Perhatikan bahwa model ini tidak disetel dengan baik menggunakan skrip JumpStart atau skrip DreamBooth. Anda dapat mengunduh daftar lengkap model fine-tuned yang tersedia untuk umum dengan petunjuk contoh dari di sini.

Untuk lebih banyak contoh gambar yang dihasilkan dari model ini, silakan lihat bagian Open Sourced Model yang disempurnakan di Lampiran.

Kesimpulan

Dalam posting ini, kami menunjukkan cara menyempurnakan model Difusi Stabil untuk teks-ke-gambar dan kemudian menerapkannya menggunakan JumpStart. Selain itu, kami membahas beberapa pertimbangan yang harus Anda buat saat menyempurnakan model dan bagaimana hal itu dapat memengaruhi performa model yang disempurnakan. Kami juga membahas lebih dari 80 model fine-tuned siap pakai yang tersedia di JumpStart. Kami menunjukkan cuplikan kode di pos ini—untuk kode lengkap dengan semua langkah dalam demo ini, lihat Pengantar JumpStart – Teks ke Gambar contoh buku catatan. Cobalah solusinya sendiri dan kirimkan komentar Anda kepada kami.

Untuk mempelajari lebih lanjut tentang model dan penyempurnaan DreamBooth, lihat sumber daya berikut:

Untuk mempelajari lebih lanjut tentang JumpStart, lihat posting blog berikut:

Tentang Penulis

Dr Vivek Madan adalah Ilmuwan Terapan dengan tim JumpStart Amazon SageMaker. Dia mendapatkan gelar PhD dari University of Illinois di Urbana-Champaign dan merupakan Peneliti Pasca Doktoral di Georgia Tech. Dia adalah peneliti aktif dalam pembelajaran mesin dan desain algoritma dan telah menerbitkan makalah di konferensi EMNLP, ICLR, COLT, FOCS, dan SODA.

Dr Vivek Madan adalah Ilmuwan Terapan dengan tim JumpStart Amazon SageMaker. Dia mendapatkan gelar PhD dari University of Illinois di Urbana-Champaign dan merupakan Peneliti Pasca Doktoral di Georgia Tech. Dia adalah peneliti aktif dalam pembelajaran mesin dan desain algoritma dan telah menerbitkan makalah di konferensi EMNLP, ICLR, COLT, FOCS, dan SODA.

Heiko Hotzo adalah Arsitek Solusi Senior untuk AI & Pembelajaran Mesin dengan fokus khusus pada pemrosesan bahasa alami (NLP), model bahasa besar (LLM), dan AI generatif. Sebelum peran ini, dia adalah Kepala Ilmu Data untuk Layanan Pelanggan UE Amazon. Heiko membantu pelanggan kami sukses dalam perjalanan AI/ML mereka di AWS dan telah bekerja dengan organisasi di banyak industri, termasuk asuransi, layanan keuangan, media dan hiburan, perawatan kesehatan, utilitas, dan manufaktur. Di waktu senggangnya, Heiko sering bepergian.

Heiko Hotzo adalah Arsitek Solusi Senior untuk AI & Pembelajaran Mesin dengan fokus khusus pada pemrosesan bahasa alami (NLP), model bahasa besar (LLM), dan AI generatif. Sebelum peran ini, dia adalah Kepala Ilmu Data untuk Layanan Pelanggan UE Amazon. Heiko membantu pelanggan kami sukses dalam perjalanan AI/ML mereka di AWS dan telah bekerja dengan organisasi di banyak industri, termasuk asuransi, layanan keuangan, media dan hiburan, perawatan kesehatan, utilitas, dan manufaktur. Di waktu senggangnya, Heiko sering bepergian.

Lampiran: Kumpulan data percobaan

Bagian ini berisi dataset yang digunakan dalam percobaan di posting ini.

Anjing1-8

Anjing1-16

Anjing2-4

Anjing3-8

Lampiran: Model yang Disempurnakan Bersumber Terbuka

Berikut adalah beberapa contoh gambar yang dihasilkan oleh berbagai model yang tersedia di JumpStart. Setiap gambar diberi judul a model_id dimulai dengan awalan huggingface-txt2img- diikuti dengan prompt yang digunakan untuk menghasilkan gambar di baris berikutnya.

- Konten Bertenaga SEO & Distribusi PR. Dapatkan Amplifikasi Hari Ini.

- Platoblockchain. Intelijen Metaverse Web3. Pengetahuan Diperkuat. Akses Di Sini.

- Sumber: https://aws.amazon.com/blogs/machine-learning/fine-tune-text-to-image-stable-diffusion-models-with-amazon-sagemaker-jumpstart/

- 1

- 100

- 11

- 2022

- 9

- a

- kemampuan

- Sanggup

- Tentang Kami

- mempercepat

- dipercepat

- mengakses

- Mengumpulkan

- tepat

- Mencapai

- aktif

- menyesuaikan

- menambahkan

- tambahan

- Tambahan

- Dewasa

- Setelah

- AI

- AI & Pembelajaran Mesin

- AI / ML

- algoritma

- algoritma

- Semua

- memungkinkan

- sendirian

- sudah

- Meskipun

- Amazon

- Amazon SageMaker

- Mulai Lompatan Amazon SageMaker

- dan

- Mengumumkan

- Lain

- Lebah

- terapan

- Mendaftar

- sesuai

- arsitektur

- Seni

- artistik

- terkait

- secara otomatis

- tersedia

- Avatar

- menghindari

- dihindari

- AWS

- Saldo

- bar

- mendasarkan

- Pantai

- karena

- sebelum

- makhluk

- antara

- Luar

- prasangka

- penagihan

- Blog

- Posting blog

- Membawa

- membangun

- bernama

- panggilan

- hati-hati

- membawa

- kasus

- kasus

- KUCING

- Kucing

- tertentu

- Kursi

- perubahan

- memeriksa

- pilihan

- pilihan

- Pilih

- memilih

- kelas

- berantakan

- kode

- mengumpulkan

- komentar

- komputasi

- konferensi

- konfigurasi

- Mempertimbangkan

- pertimbangan

- konstan

- membangun

- Wadah

- mengandung

- Konten

- kontrol

- Sesuai

- Biaya

- membuat

- dibuat

- membuat

- tanaman

- Sekarang

- adat

- pelanggan

- Layanan Pelanggan

- pelanggan

- data

- pengolahan data

- ilmu data

- kumpulan data

- mendalam

- belajar mendalam

- Default

- Demo

- mendemonstrasikan

- menyebarkan

- dikerahkan

- Mendesain

- desain

- rincian

- berbeda

- Difusi

- langsung

- membahas

- dibahas

- Divisi

- Buruh pelabuhan

- Wadah Docker

- Tidak

- Anjing

- Anjing

- melakukan

- domain

- Dont

- Download

- selama

- setiap

- mudah digunakan

- efisien

- tertanam

- aktif

- memungkinkan

- ujung ke ujung

- Titik akhir

- Inggris

- cukup

- memastikan

- Menghibur

- masuk

- zaman

- perkiraan

- dll

- Eter (ETH)

- EU

- mengevaluasi

- contoh

- contoh

- Kecuali

- menjalankan

- mengharapkan

- eksperimen

- eksponensial

- Menghadapi

- wajah

- beberapa

- File

- File

- Akhirnya

- keuangan

- jasa keuangan

- Menemukan

- menyelesaikan

- Pertama

- cocok

- Memperbaiki

- Mengapung

- Fokus

- diikuti

- berikut

- format

- dari

- penuh

- kesenangan

- fungsi

- lebih lanjut

- Selanjutnya

- Mendapatkan

- menghasilkan

- dihasilkan

- menghasilkan

- menghasilkan

- generasi

- generatif

- AI generatif

- Georgia

- mendapatkan

- GitHub

- baik

- GPU

- bertahap

- Penanganan

- Terjadi

- kepala

- kesehatan

- membantu

- berkualitas tinggi

- lebih tinggi

- tuan rumah

- Seterpercayaapakah Olymp Trade? Kesimpulan

- How To

- Namun

- HTML

- HTTPS

- manusia

- ICLR

- diidentifikasi

- Illinois

- gambar

- generasi gambar

- gambar

- Dampak

- dampak

- mengimpor

- impresif

- in

- memasukkan

- termasuk

- Termasuk

- menggabungkan

- Meningkatkan

- Meningkatkan

- meningkatkan

- industri

- informasi

- memasukkan

- contoh

- sebagai gantinya

- instruksi

- asuransi

- Antarmuka

- terlibat

- isolasi

- isu

- masalah

- IT

- Pekerjaan

- perjalanan

- json

- Menjaga

- pengetahuan

- bahasa

- Bahasa

- besar

- Terakhir

- jalankan

- lapisan

- BELAJAR

- belajar

- pengetahuan

- keterbatasan

- Terbatas

- baris

- baris

- Daftar

- sedikit

- pemuatan

- lokal

- Panjang

- melihat

- terlihat seperti

- lepas

- Rendah

- mesin

- Mesin belajar

- membuat

- cara

- manual

- pabrik

- banyak

- Cocok

- maksimum

- Media

- Memori

- Tengah

- mungkin

- keberatan

- minimum

- hilang

- ML

- model

- model

- saat

- lebih

- beberapa

- nama

- Bernama

- Alam

- Bahasa Alami

- Pengolahan Bahasa alami

- perlu

- Perlu

- dibutuhkan

- jaringan

- berikutnya

- NFT

- nLP

- Kebisingan

- buku catatan

- November

- jumlah

- obyek

- mengamati

- ONE

- Buka

- Operasi

- urutan

- organisasi

- asli

- Lainnya

- ikhtisar

- sendiri

- dokumen

- parameter

- tertentu

- melewati

- Lewat

- path

- melakukan

- prestasi

- melakukan

- Personalisasi

- Hewan Peliharaan

- Fotorealistik

- pixel

- plato

- Kecerdasan Data Plato

- Data Plato

- silahkan

- Titik

- positif

- mungkin

- Pos

- Posts

- meramalkan

- menyajikan

- sebelumnya

- Sebelumnya

- proses

- pengolahan

- menghasilkan

- Produk

- secara bertahap

- memberikan

- disediakan

- menyediakan

- menyediakan

- di depan umum

- diterbitkan

- Ular sanca

- kualitas

- segera

- acak

- mulai

- Penilaian

- siap

- nyata

- real-time

- realistis

- baru-baru ini

- mengenali

- sarankan

- rekomendasi

- Merah

- menurunkan

- Bagaimanapun juga

- terkait

- dirilis

- pemindahan

- menghapus

- wakil

- permintaan

- membutuhkan

- wajib

- kebutuhan

- membutuhkan

- peneliti

- Resolusi

- Sumber

- Menanggapi

- tanggapan

- mengakibatkan

- dihasilkan

- Hasil

- Peran

- Run

- berjalan

- pembuat bijak

- Tersebut

- sama

- penghematan

- Ilmu

- ilmuwan

- script

- SDK

- Pencarian

- detik

- Bagian

- senior

- Seri

- layanan

- Layanan

- set

- pengaturan

- beberapa

- bentuk

- harus

- Menunjukkan

- ditunjukkan

- Pertunjukkan

- signifikan

- mirip

- Sederhana

- hanya

- tunggal

- Duduk

- Ukuran

- kecil

- lebih kecil

- So

- larutan

- Solusi

- beberapa

- Space

- khusus

- tertentu

- ditentukan

- kecepatan

- stabil

- Tahap

- Mulai

- dimulai

- Negara

- Langkah

- Tangga

- terhenti

- penyimpanan

- studio

- subyek

- sukses

- seperti itu

- Menderita

- cukup

- mendukung

- Didukung

- Mendukung

- MENANDAI

- Mengambil

- Dibutuhkan

- target

- tugas

- tim

- tech

- istilah

- tes

- Grafik

- mereka

- karena itu

- Melalui

- waktu

- untuk

- hari ini

- bersama

- terlalu

- Total

- Pelatihan VE

- terlatih

- Pelatihan

- kereta

- transfer

- perjalanan

- jenis

- ui

- unik

- universitas

- Memperbarui

- diperbarui

- Pembaruan

- URI

- us

- menggunakan

- gunakan case

- Pengguna

- User Interface

- biasanya

- keperluan

- kegunaan

- memanfaatkan

- Berharga

- Informasi Berharga

- nilai

- Nilai - Nilai

- berbagai

- Video

- cara

- berat

- apakah

- yang

- sementara

- putih

- akan

- dalam

- tanpa

- kata

- Kerja

- bekerja sama

- bekerja

- kerja

- bernilai

- Menghasilkan

- Anda

- diri

- zephyrnet.dll

- nol