Hukum Goodhart terkenal mengatakan: "Ketika ukuran menjadi target, itu berhenti menjadi ukuran yang baik." Meskipun berasal dari ekonomi, itu adalah sesuatu yang harus kita hadapi di OpenAI ketika mencari cara untuk mengoptimalkan tujuan yang sulit atau mahal untuk diukur. Seringkali perlu untuk memperkenalkan beberapa tujuan proxy itu lebih mudah atau lebih murah untuk diukur, tetapi ketika kita melakukan ini, kita perlu berhati-hati untuk tidak terlalu mengoptimalkannya.

Misalnya, sebagai bagian dari pekerjaan kami untuk meluruskan model seperti GPT-3 dengan niat dan nilai manusia, kami ingin mengoptimalkan hal-hal seperti "Bagaimana" bermanfaat apakah ini tanggapan?”, atau “Bagaimana akurat secara faktual apakah ini klaim?”. Ini adalah tujuan kompleks yang mengharuskan manusia untuk memeriksa semuanya dengan cermat. Untuk alasan ini, kami melatih model untuk memprediksi preferensi manusia ini, yang dikenal sebagai model hadiah, dan gunakan prediksi model hadiah sebagai tujuan proxy. Tapi penting untuk melacak seberapa baik tujuan sebenarnya sedang dioptimalkan.

Dalam posting ini kita akan melihat beberapa matematika di balik bagaimana kita melakukan ini. Kami akan fokus pada pengaturan yang sangat bersih untuk dianalisis, di mana kami memiliki akses ke tujuan yang sebenarnya. Dalam praktiknya, bahkan preferensi manusia dapat gagal untuk mengukur apa yang benar-benar kami pedulikan, tetapi kami mengesampingkan masalah itu dalam posting ini.

Sampling $n$ terbaik

Ada banyak cara di mana seseorang dapat mengoptimalkan tujuan proxy, tetapi mungkin yang paling sederhana adalah sampel terbaik dari $n$, juga dikenal sebagai pengambilan sampel penolakan or peringkat ulang. Kami hanya mengambil sampel $n$ kali dan mengambil yang mendapat skor tertinggi sesuai dengan tujuan proxy.

Meskipun metode ini sangat sederhana, sebenarnya dapat bersaing dengan teknik yang lebih maju seperti pembelajaran penguatan, meskipun dengan biaya komputasi waktu inferensi yang lebih banyak. Misalnya, di WebGPT, model best-of-$64$ kami mengungguli model pembelajaran penguatan kami, mungkin sebagian karena model best-of-$64$ dapat menjelajahi lebih banyak situs web. Bahkan menerapkan best-of-$4 memberikan dorongan signifikan pada preferensi manusia.

Selain itu, pengambilan sampel best-of-$n$ memiliki kinerja yang andal dan mudah untuk dianalisis secara matematis, sehingga cocok untuk studi empiris tentang hukum Goodhart dan fenomena terkait.

Matematika dari pengambilan sampel $n$ terbaik

Mari kita pelajari best-of-$n$ sampling secara lebih formal. Misalkan kita memiliki beberapa ruang sampel $S$ (seperti himpunan pasangan pertanyaan-jawaban yang mungkin), beberapa distribusi probabilitas $P$ lebih dari $S$, tujuan yang benar (atau "hadiah") $R_{teks{true}}:Stomathbb R$, dan tujuan proxy $R_{teks{proxy}}:Stomathbb R$. Katakanlah kita entah bagaimana mengoptimalkan $R_{text{proxy}}$ dan dengan demikian memperoleh beberapa distribusi baru $P^prima$. Kemudian:

- Ekspektasi $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primerright)right]$ mengukur seberapa baik kita telah mengoptimalkan tujuan yang sebenarnya.

- Grafik Divergensi KL $D_{text{KL}}left(P^primeparallel Pright)$ mengukur seberapa banyak pengoptimalan yang telah kita lakukan. Misalnya, jika $P^prime$ diperoleh dengan mengambil sampel pertama dari $P$ yang terletak pada beberapa subset $S^primesubseteq S$, maka divergensi KL ini hanyalah probabilitas log negatif bahwa sampel dari $P$ terletak di $S^prime$.

Ternyata dalam kasus best-of-$n$ sampling, kedua kuantitas ini dapat diestimasi secara efisien dengan menggunakan sampel dari $P$.

Kita lihat dulu ekspektasinya. Pendekatan naif adalah dengan menggunakan penaksir Monte Carlo: jalankan sampling terbaik berkali-kali, ukur tujuan sebenarnya pada sampel tersebut, dan rata-ratakan hasilnya. Namun, ada penaksir yang lebih baik. Jika kita memiliki $Ngeq n$ sampel dari $P$ secara keseluruhan, maka kita dapat mempertimbangkan secara bersamaan setiap subset yang mungkin dari sampel ukuran $n$ ini, bobot setiap sampel dengan jumlah subset yang terbaik menurut tujuan proksi, dan kemudian ambil skor tujuan benar rata-rata tertimbang. Bobot ini hanyalah koefisien binomial $binom{k-1}{n-1}$, di mana $k$ adalah peringkat sampel di bawah tujuan proxy, dari $1$ (terburuk) hingga $N$ (terbaik). Selain menggunakan sampel secara lebih efisien, ini juga memungkinkan kita untuk menggunakan kembali sampel untuk nilai $n$ yang berbeda.

Adapun divergensi KL, yang mengejutkan, ini ternyata memiliki formula yang tepat yang bekerja untuk distribusi probabilitas kontinu $P$ (yaitu, selama $P$ tidak memiliki massa titik). Orang mungkin dengan naif menebak bahwa jawabannya adalah $log n$, karena best-of-$n$ melakukan sesuatu seperti mengambil $frac 1n$ teratas dari distribusi, dan ini kira-kira benar: jawaban yang tepat adalah $log n-frac{n-1}n$.

Bersama-sama, estimator ini memungkinkan kita untuk dengan mudah menganalisis bagaimana tujuan sebenarnya bervariasi dengan jumlah optimasi yang diterapkan pada tujuan proxy.

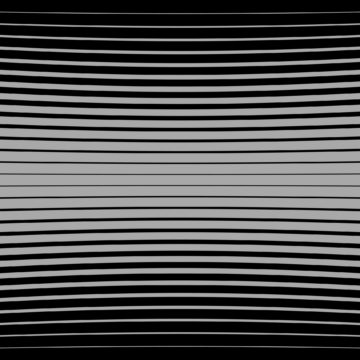

Berikut adalah contoh kehidupan nyata dari WebGPT:

Performa terbaik $n$ untuk WebGPT 175B

Performa terbaik $n$ untuk WebGPT, dengan area berbayang yang mewakili kesalahan standar $pm 1$, dan sumbu KL mengikuti skala akar kuadrat. Di sini, distribusi asli ($P$) diberikan oleh model 175B yang dilatih menggunakan kloning perilaku, tujuan proxy yang digunakan untuk menghitung best-of-$n$ ($R_{text{proxy}}$) diberikan oleh pelatihan model hadiah, dan kami mempertimbangkan tiga tujuan yang diduga "benar" ($R_{teks{benar}}$): model hadiah pelatihan itu sendiri, model hadiah validasi yang dilatih pada data yang ditahan, dan preferensi manusia yang sebenarnya. Tidak ada terlalu banyak optimasi tujuan proxy, tetapi kami berharap akan ada di KL yang lebih tinggi.

Lebih dari sekadar sampel $n$ terbaik

Keterbatasan utama dari best-of-$n$ sampling adalah bahwa divergensi KL tumbuh secara logaritmik dengan $n$, sehingga hanya cocok untuk menerapkan sejumlah kecil optimasi.

Untuk menerapkan lebih banyak pengoptimalan, kami biasanya menggunakan pembelajaran penguatan. Dalam pengaturan yang telah kita pelajari sejauh ini, seperti peringkasan, kami biasanya dapat mencapai KL sekitar 10 nat menggunakan pembelajaran penguatan sebelum tujuan sebenarnya mulai berkurang karena hukum Goodhart. Kami harus mengambil $n$ menjadi sekitar 60,000 untuk mencapai KL ini menggunakan terbaik-dari-$n$, dan kami berharap dapat mencapai KL yang jauh lebih besar dari ini dengan perbaikan pada model penghargaan dan praktik pembelajaran penguatan kami.

Namun, tidak semua nat sama. Secara empiris, untuk anggaran KL kecil, best-of-$n$ lebih baik mengoptimalkan proksi dan tujuan sebenarnya daripada pembelajaran penguatan. Secara intuitif, best-of-$n$ adalah pendekatan "brute force", membuatnya lebih efisien secara informasi-teori daripada pembelajaran penguatan, tetapi kurang efisien secara komputasi di KL besar.

Kami secara aktif mempelajari properti penskalaan tujuan proxy sebagai bagian dari pekerjaan kami untuk meluruskan model kami dengan niat dan nilai manusia. Jika Anda ingin membantu kami dalam penelitian ini, kami mempekerjakan!

- AI

- ai seni

- generator seni ai

- punya robot

- kecerdasan buatan

- sertifikasi kecerdasan buatan

- kecerdasan buatan dalam perbankan

- robot kecerdasan buatan

- robot kecerdasan buatan

- perangkat lunak kecerdasan buatan

- blockchain

- konferensi blockchain

- kecerdasan

- kecerdasan buatan percakapan

- konferensi kripto

- dall's

- belajar mendalam

- google itu

- Mesin belajar

- OpenAI

- plato

- plato ai

- Kecerdasan Data Plato

- Permainan Plato

- Data Plato

- permainan plato

- penelitian

- skala ai

- sintaksis

- zephyrnet.dll