AI dan komputer konvensional adalah pasangan yang dibuat di neraka.

Alasan utamanya adalah bagaimana chip perangkat keras saat ini disiapkan. Berdasarkan arsitektur Von Neumann tradisional, chip mengisolasi penyimpanan memori dari prosesor utamanya. Setiap perhitungan adalah perjalanan Senin pagi yang mengerikan, dengan chip yang terus-menerus memindahkan data ke sana kemari dari setiap kompartemen, membentuk "dinding memori. "

Jika Anda pernah terjebak macet, Anda tahu frustrasinya: butuh waktu dan energi yang terbuang. Ketika algoritma AI menjadi semakin kompleks, masalahnya menjadi semakin buruk.

Jadi mengapa tidak merancang chip berdasarkan otak, potensi pasangan sempurna untuk jaringan saraf dalam?

Masukkan chip komputasi dalam memori, atau CIM. Sesuai dengan namanya, chip ini menghitung dan menyimpan memori di situs yang sama. Lupakan perjalanan; chip adalah alternatif kerja-dari-rumah yang sangat efisien, mengatasi masalah kemacetan lalu lintas data dan menjanjikan efisiensi yang lebih tinggi dan konsumsi energi yang lebih rendah.

Atau begitulah teorinya. Sebagian besar chip CIM yang menjalankan algoritme AI hanya berfokus pada desain chip, menampilkan kemampuannya menggunakan simulasi chip daripada menjalankan tugas pada perangkat keras yang lengkap. Chip tersebut juga berjuang untuk menyesuaikan diri dengan beberapa tugas AI yang berbeda—pengenalan gambar, persepsi suara—membatasi integrasinya ke dalam smartphone atau perangkat sehari-hari lainnya.

Bulan ini, sebuah pelajaran in Alam upgrade CIM dari bawah ke atas. Daripada hanya berfokus pada desain chip, tim internasional—dipimpin oleh pakar perangkat keras neuromorfik Dr. HS Philip Wong di Stanford dan Dr. Gert Cauwenberghs di UC San Diego—mengoptimalkan seluruh penyiapan, mulai dari teknologi hingga arsitektur hingga algoritme yang mengkalibrasi perangkat keras .

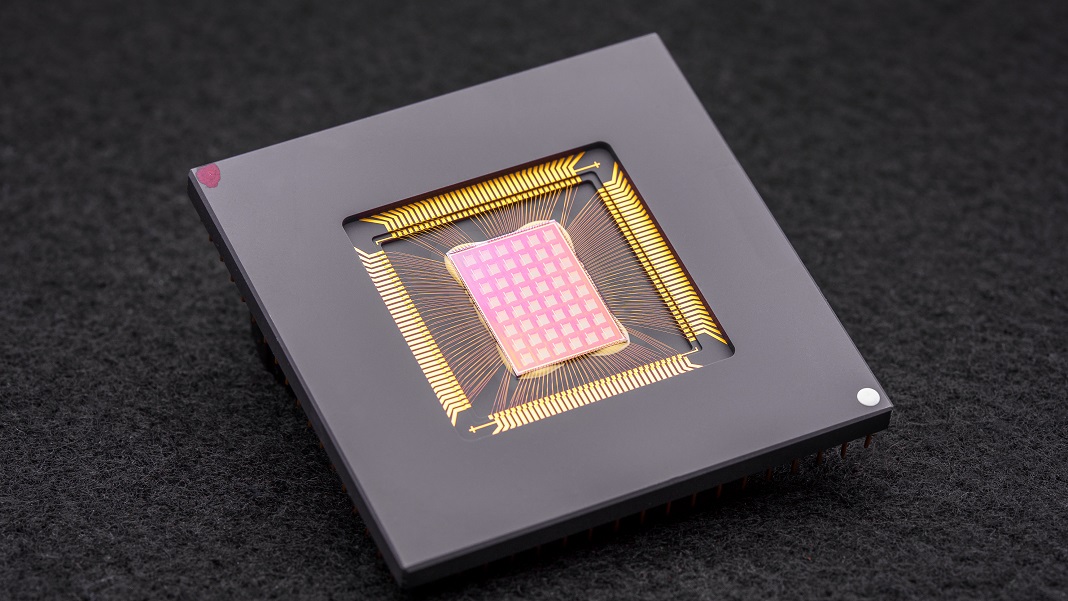

Chip NeuRRAM yang dihasilkan adalah raksasa komputasi neuromorfik yang kuat dengan 48 inti paralel dan 3 juta sel memori. Sangat serbaguna, chip ini menangani banyak tugas standar AI—seperti membaca angka tulisan tangan, mengidentifikasi mobil dan objek lain dalam gambar, dan mendekode rekaman suara—dengan akurasi lebih dari 84 persen.

Meskipun tingkat keberhasilannya mungkin tampak biasa-biasa saja, ia menyaingi chip digital yang ada tetapi secara dramatis menghemat energi. Bagi penulis, ini selangkah lebih dekat untuk membawa AI langsung ke perangkat kami daripada perlu mengirimkan data ke cloud untuk komputasi.

“Melakukan perhitungan tersebut pada chip alih-alih mengirim informasi ke dan dari cloud dapat memungkinkan AI yang lebih cepat, lebih aman, lebih murah, dan lebih skalabel di masa depan, dan memberi lebih banyak orang akses ke kekuatan AI,” tersebut Wong

Inspirasi Saraf

Chip khusus AI sekarang adalah selusin sepeser pun yang menakjubkan. Dari Tensor Processing Unit (TPU) Google dan arsitektur superkomputer Tesla Dojo hingga Baidu dan Amazon, raksasa teknologi menginvestasikan jutaan dolar dalam demam emas chip AI untuk membangun prosesor yang mendukung algoritme pembelajaran mendalam yang semakin canggih. Beberapa bahkan memanfaatkan pembelajaran mesin untuk merancang arsitektur chip disesuaikan untuk perangkat lunak AI, membawa balapan lingkaran penuh.

Satu konsep yang sangat menarik datang langsung dari otak. Saat data melewati neuron kita, mereka "menyambung" ke jaringan melalui "dok" fisik yang disebut sinapsis. Struktur ini, duduk di atas cabang saraf seperti jamur kecil, adalah multitasker: keduanya menghitung dan menyimpan data melalui perubahan komposisi proteinnya.

Dengan kata lain, neuron, tidak seperti komputer klasik, tidak perlu memindahkan data dari memori ke CPU. Ini memberi otak keunggulannya dibandingkan perangkat digital: sangat hemat energi dan melakukan banyak perhitungan secara bersamaan, semuanya dikemas dalam jeli seberat tiga pon yang dimasukkan ke dalam tengkorak.

Mengapa tidak menciptakan kembali aspek otak?

Enter komputasi neuromorfik. Salah satu peretasan adalah menggunakan RRAM, atau perangkat memori akses acak resistif (juga dijuluki 'memristor'). RRAM menyimpan memori bahkan saat terputus dari daya dengan mengubah resistansi perangkat kerasnya. Mirip dengan sinapsis, komponen ini dapat dikemas ke dalam susunan padat di area kecil, menciptakan sirkuit yang mampu melakukan perhitungan yang sangat kompleks tanpa massal. Ketika dikombinasikan dengan CMOS, proses fabrikasi untuk membangun sirkuit di mikroprosesor dan chip kami saat ini, duo menjadi lebih kuat untuk menjalankan algoritma pembelajaran mendalam.

Tapi itu datang dengan biaya. “Komputasi analog yang sangat paralel dalam arsitektur RRAM-CIM menghadirkan efisiensi yang unggul, tetapi membuatnya sulit untuk mewujudkan tingkat fleksibilitas fungsional dan akurasi komputasi yang sama seperti di sirkuit digital,” kata para penulis.

jin pengoptimalan

Studi baru menyelidiki setiap bagian dari chip RRAM-CIM, mendesain ulang untuk penggunaan praktis.

Ini dimulai dengan teknologi. NeuRRAM membanggakan 48 core yang menghitung secara paralel, dengan perangkat RRAM yang secara fisik terjalin ke dalam sirkuit CMOS. Seperti neuron, setiap inti dapat dimatikan satu per satu saat tidak digunakan, menghemat energi saat memorinya disimpan di RRAM.

Sel RRAM ini—ketiga jutanya—terhubung sehingga data dapat ditransfer ke dua arah. Ini adalah desain yang penting, memungkinkan chip untuk secara fleksibel beradaptasi dengan berbagai jenis algoritma AI, para penulis menjelaskan. Misalnya, satu jenis jaring saraf dalam, CNN (jaringan saraf convolutional), sangat hebat dalam penglihatan komputer, tetapi membutuhkan data untuk mengalir dalam satu arah. Sebaliknya, LSTM, sejenis jaring saraf dalam yang sering digunakan untuk pengenalan audio, memproses data secara berulang untuk mencocokkan sinyal dengan waktu. Seperti sinapsis, chip mengkodekan seberapa kuat satu "neuron" RRAM terhubung ke yang lain.

Arsitektur ini memungkinkan untuk menyempurnakan aliran data untuk meminimalkan kemacetan lalu lintas. Seperti memperluas lalu lintas satu jalur ke multi-jalur, chip dapat menduplikasi "memori" jaringan saat ini dari sebagian besar masalah komputasi intensif, sehingga beberapa inti menganalisis masalah secara bersamaan.

Sentuhan terakhir pada chip CIM sebelumnya adalah jembatan yang lebih kuat antara komputasi seperti otak—seringkali analog—dan pemrosesan digital. Di sini, chip menggunakan sirkuit neuron yang dapat dengan mudah mengubah komputasi analog menjadi sinyal digital. Ini adalah langkah maju dari pengaturan "haus kekuasaan dan haus area" sebelumnya, para penulis menjelaskan.

Pengoptimalan berhasil. Dengan menguji teori mereka, tim tersebut membuat chip NeuRRAM dan mengembangkan algoritme untuk memprogram perangkat keras untuk algoritme yang berbeda—seperti Play Station 5 yang menjalankan game yang berbeda.

Dalam banyak tes benchmark, chip tampil seperti seorang juara. Menjalankan CNN tujuh lapis pada chip, NeuRRAM memiliki tingkat kesalahan kurang dari satu persen dalam mengenali digit tulisan tangan menggunakan database MNIST yang populer.

Itu juga unggul dalam tugas-tugas yang lebih sulit. Memuat jaring saraf dalam populer lainnya, LSTM, chip tersebut kira-kira 85 persen benar ketika ditantang dengan pengenalan perintah ucapan Google. Dengan hanya menggunakan delapan inti, chip—yang menjalankan arsitektur AI lain—mampu memulihkan gambar yang bising, mengurangi kesalahan hingga sekitar 70 persen.

Terus?

Satu kata: energi.

Sebagian besar algoritma AI adalah babi energi total. NeuRRAM beroperasi dengan setengah biaya energi dari chip RRAM-CIM canggih sebelumnya, yang selanjutnya menerjemahkan janji penghematan energi dengan komputasi neuromorfik menjadi kenyataan.

Tetapi yang menonjol dari penelitian ini adalah strateginya. Terlalu sering ketika merancang chip, para ilmuwan perlu menyeimbangkan efisiensi, keserbagunaan, dan akurasi untuk banyak tugas—metrik yang sering bertentangan satu sama lain. Masalahnya menjadi lebih sulit ketika semua komputasi dilakukan langsung pada perangkat keras. NeuRRAM menunjukkan bahwa mungkin untuk melawan semua binatang sekaligus.

Strategi yang digunakan di sini dapat digunakan untuk mengoptimalkan perangkat komputasi neuromorfik lainnya seperti teknologi memori perubahan fases, kata penulis.

Untuk saat ini, NeuRRAM adalah bukti konsep, yang menunjukkan bahwa chip fisik—bukan simulasinya—berfungsi sebagaimana mestinya. Tetapi ada ruang untuk perbaikan, termasuk penskalaan RRAM lebih lanjut dan mengecilkan ukurannya hingga suatu hari nanti berpotensi masuk ke dalam ponsel kami.

“Mungkin hari ini digunakan untuk melakukan tugas-tugas AI sederhana seperti pencarian kata kunci atau deteksi manusia, tetapi besok dapat memungkinkan pengalaman pengguna yang sama sekali berbeda. Bayangkan analitik video real-time dikombinasikan dengan pengenalan suara semua dalam perangkat kecil,” tersebut penulis studi Dr. Weier Wan. “Sebagai peneliti dan insinyur, ambisi saya adalah membawa inovasi penelitian dari laboratorium ke dalam penggunaan praktis.”

Gambar Kredit: David Baillot/Universitas California San Diego