Stiamo rilasciando un'analisi che mostra che dal 2012 la quantità di calcolo necessaria per addestrare una rete neurale alle stesse prestazioni su ImageNet la classificazione è diminuita di un fattore pari a 2 ogni 16 mesi. Rispetto al 2012, ora sono necessarie 44 volte meno risorse di calcolo per addestrare una rete neurale al livello di AlexNet (al contrario, la legge di Moore comporterebbe un miglioramento dei costi di 11 volte in questo periodo). I nostri risultati suggeriscono che per le attività di intelligenza artificiale con elevati livelli di investimenti recenti, il progresso algoritmico ha prodotto maggiori guadagni rispetto all’efficienza dell’hardware classico.

Il miglioramento algoritmico è un fattore chiave che guida il progresso dell’intelligenza artificiale. È importante cercare misure che facciano luce sul progresso algoritmico complessivo, anche se è più difficile che misurare tali tendenze nel calcolo.

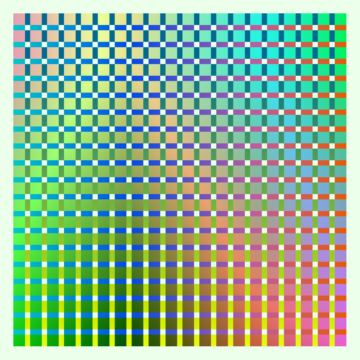

44 volte in meno di elaborazione necessaria per ottenere le prestazioni di AlexNet 7 anni dopo

Quantità totale di elaborazione in teraflop/s-giorni utilizzata per addestrare le prestazioni al livello di AlexNet. I punti di calcolo più bassi in un dato momento sono mostrati in blu, tutti i punti misurati sono mostrati in grigio.

Misurare l'efficienza

L’efficienza algoritmica può essere definita come la riduzione del calcolo necessario per addestrare una capacità specifica. L'efficienza è il modo principale con cui misuriamo il progresso algoritmico sui classici problemi dell'informatica come l'ordinamento. I guadagni di efficienza su problemi tradizionali come l’ordinamento sono più semplici da misurare rispetto al machine learning perché hanno una misura più chiara della difficoltà del compito. Tuttavia, possiamo applicare la lente dell’efficienza all’apprendimento automatico mantenendo costanti le prestazioni. Le tendenze di efficienza possono essere confrontate tra settori come il sequenziamento del DNA (raddoppio ogni 10 mesi), energia solare (raddoppio in 6 anni) e densità dei transistor (raddoppio a 2 anni).

Per la nostra analisi, abbiamo sfruttato principalmente le reimplementazioni open source per misurare i progressi sulla performance a livello di AlexNet su un lungo orizzonte. Abbiamo riscontrato un tasso simile di miglioramento dell'efficienza dell'addestramento per le prestazioni di livello ResNet-50 su ImageNet (tempo di raddoppio di 17 mesi). Abbiamo riscontrato tassi di miglioramento più rapidi in tempi più brevi in Translation, Go e Dota 2:

- All'interno della traduzione, il Transformer superato seq2seq prestazioni nella traduzione dall'inglese al francese su WMT'14 con 61 volte in meno di calcolo di addestramento 3 anni dopo.

- Stimiamo AlphaZero ci sono voluti 8 volte meno calcoli per arrivare ad AlphaGoZero prestazioni di livello 1 anno dopo.

- OpenAI Five Rerun ha richiesto un calcolo di training 5 volte inferiore per superare OpenAI Five (che hanno battuto i campioni del mondo, OG) 3 mesi dopo.

Può essere utile pensare che il calcolo nel 2012 non sia uguale al calcolo nel 2019 in un modo simile a quello in cui i dollari devono essere adeguati all’inflazione nel tempo. Una quantità fissa di calcolo potrebbe realizzare di più nel 2019 che nel 2012. Un modo di pensare a questo è che alcuni tipi di ricerca sull’intelligenza artificiale progrediscono in due fasi, simili al modello di sviluppo “tick tock” visto nei semiconduttori; le nuove funzionalità (il “tick”) richiedono in genere una notevole quantità di spese di elaborazione per essere ottenute, quindi le versioni perfezionate di tali funzionalità (il “tock”) diventano molto più efficienti da implementare grazie ai miglioramenti dei processi.

L’aumento dell’efficienza algoritmica consente ai ricercatori di eseguire più esperimenti interessanti in una determinata quantità di tempo e denaro. Oltre a essere una misura del progresso complessivo, i guadagni di efficienza algoritmica accelerano la futura ricerca sull’intelligenza artificiale in un modo che è in qualche modo analogo a una maggiore capacità di calcolo.

Altre misure del progresso dell’IA

Oltre all’efficienza, molte altre misure fanno luce sul progresso algoritmico complessivo nell’intelligenza artificiale. Costo della formazione in dollari è correlato, ma meno strettamente focalizzato sul progresso algoritmico perché è influenzato anche dal miglioramento dell'hardware sottostante, dell'utilizzo dell'hardware e dell'infrastruttura cloud. L'efficienza del campione è fondamentale quando ci troviamo in un regime di dati bassi, come nel caso di molte attività di interesse. La possibilità di addestrare i modelli più velocemente accelera anche la ricerca e può essere pensato come una misura della parallelizzabilità delle capacità di apprendimento di interesse. Troviamo anche aumenti nell'efficienza di inferenza in termini di tempo GPU, parametri, e fallimenti significativi, ma soprattutto a causa delle loro implicazioni economiche piuttosto che del loro effetto sui futuri progressi della ricerca. Shufflenet hanno ottenuto prestazioni di livello AlexNet con un aumento dell'efficienza di inferenza di 18 volte in 5 anni (tempo di raddoppio di 15 mesi), il che suggerisce che l'efficienza dell'addestramento e l'efficienza dell'inferenza potrebbero migliorare a ritmi simili. La creazione di set di dati/ambienti/benchmark è un metodo potente per rendere più misurabili le capacità specifiche dell’intelligenza artificiale di interesse.

Limitazioni primarie

- Disponiamo solo di un numero limitato di punti dati sull'efficienza algoritmica su alcune attività. Non è chiaro fino a che punto le tendenze di efficienza che abbiamo osservato si generalizzino ad altri compiti dell’intelligenza artificiale. La misurazione sistematica potrebbe chiarire se esiste un algoritmo equivalente alla Legge di Moore nel campo dell'intelligenza artificiale e, se esiste, chiarirne la natura. Riteniamo che questa sia una questione aperta molto interessante. Sospettiamo che sia più probabile osservare tassi simili di progresso in termini di efficienza su compiti simili. Per compiti simili intendiamo compiti all'interno di questi sottodomini dell'intelligenza artificiale, su cui il campo concorda sul fatto che abbiamo visto progressi sostanziali e che hanno livelli di investimento comparabili (tempo di calcolo e/o ricercatore).

- Anche se crediamo che AlexNet abbia rappresentato molti progressi, questa analisi non tenta di quantificare tali progressi. Più in generale, la prima volta che viene creata una capacità, le scoperte algoritmiche potrebbero aver ridotto le risorse richieste da totalmente irrealizzabili a semplicemente elevate. Riteniamo che le nuove capacità rappresentino generalmente una quota maggiore del progresso concettuale complessivo rispetto agli aumenti di efficienza osservati del tipo mostrato qui.

- Questa analisi si concentra sul costo finale della formazione per un modello ottimizzato piuttosto che sui costi di sviluppo totali. Alcuni miglioramenti algoritmici semplificano l'addestramento di un modello rendendo molto più ampio lo spazio degli iperparametri che verranno addestrati in modo stabile e otterranno buone prestazioni finali. D'altro canto, le ricerche sull'architettura aumentano il divario tra il costo finale della formazione e i costi totali della formazione.

- Non speculiamo sul grado in cui prevediamo che le tendenze di efficienza si estrapoleranno nel tempo, ci limitiamo a presentare i nostri risultati e a discutere le implicazioni se le tendenze persistono.

Politica di misurazione e intelligenza artificiale

Noi crediamo che il processo decisionale relativo all’intelligenza artificiale migliorerà concentrandosi maggiormente sulla misurazione e sulla valutazione dei sistemi di intelligenza artificiale, sia in termini di attributi tecnici che di impatto sociale. Riteniamo che tali iniziative di misurazione possano far luce su importanti questioni politiche; la nostra intelligenza artificiale e il nostro calcolo L’analisi suggerisce che i politici dovrebbero aumentare i finanziamenti per le risorse informatiche per il mondo accademico, in modo che la ricerca accademica possa replicare, riprodurre ed estendere la ricerca industriale. Questa analisi dell’efficienza suggerisce che i politici potrebbero sviluppare intuizioni accurate sui costi di implementazione delle capacità di intelligenza artificiale – e su come questi costi cambieranno nel tempo – valutando più da vicino il tasso di miglioramento dell’efficienza dei sistemi di intelligenza artificiale.

Monitorare l’efficienza in futuro

Se il calcolo su larga scala continua a essere importante per raggiungere prestazioni complessive allo stato dell’arte (SOTA) in settori come il linguaggio e i giochi, allora è importante impegnarsi per misurare i notevoli progressi ottenuti con quantità minori di calcolo (contributi spesso forniti da istituzioni accademiche). I modelli che raggiungono lo stato dell’arte dell’efficienza della formazione su capacità significative sono candidati promettenti per l’incremento e il potenziale raggiungimento delle massime prestazioni complessive. Inoltre, capire i miglioramenti dell’efficienza algoritmica è semplice poiché sono solo una parte particolarmente significativa delle curve di apprendimento generate da tutti gli esperimenti.

Riteniamo inoltre che misurare le tendenze a lungo termine dei SOTA sull’efficienza aiuterà a dipingere un quadro quantitativo del progresso algoritmico complessivo. Osserviamo che i miglioramenti in termini di efficienza hardware e algoritmica sono moltiplicativi e possono essere su una scala simile su orizzonti significativi, il che suggerisce che un buon modello di progresso dell’IA dovrebbe integrare le misure di entrambi.

I nostri risultati suggeriscono che per le attività di intelligenza artificiale con elevati livelli di investimento (tempo del ricercatore e/o calcolo) l’efficienza algoritmica potrebbe superare i guadagni derivanti dall’efficienza dell’hardware (Legge di Moore). La Legge di Moore è stata coniata nel 1965 quando i circuiti integrati avevano solo 64 transistor (6 raddoppiamenti) e estrapolandola ingenuamente è stata prevista la previsione di personal computer e smartphone (un iPhone 11 ha 8.5 miliardi di transistor). Se osservassimo decenni di miglioramento esponenziale nell’efficienza algoritmica dell’intelligenza artificiale, a cosa potrebbe portare? Non ne siamo sicuri. Il fatto che questi risultati ci facciano porre questa domanda è per noi un modesto aggiornamento verso un futuro con potenti servizi e tecnologie di intelligenza artificiale.

Per tutti questi motivi, inizieremo a monitorare pubblicamente i SOTA sull'efficienza. Inizieremo con i benchmark sull'efficienza della visione e della traduzione (ImageNet e WMT14) e prenderemo in considerazione l'aggiunta di ulteriori benchmark nel tempo. Riteniamo che esistano SOTA di efficienza su questi parametri di cui non siamo a conoscenza e incoraggiamo la comunità di ricerca a farlo inviali qui (daremo credito agli autori e ai collaboratori originali).

Leader del settore, politici, economisti e potenziali ricercatori stanno tutti cercando di comprendere meglio i progressi dell’intelligenza artificiale e decidere quanta attenzione dovrebbero investire e dove indirizzarla. Gli sforzi di misurazione possono aiutare a radicare tali decisioni. Se sei interessato a questo tipo di lavoro, considerare l'applicazione per lavorare nel team Foresight o Policy di OpenAI!