Commento Finora negli Stati Uniti si sono verificate più di 250 sparatorie di massa quest'anno e i sostenitori dell'IA pensano di avere la soluzione. Non il controllo delle armi, ma una tecnologia migliore, non sorprende.

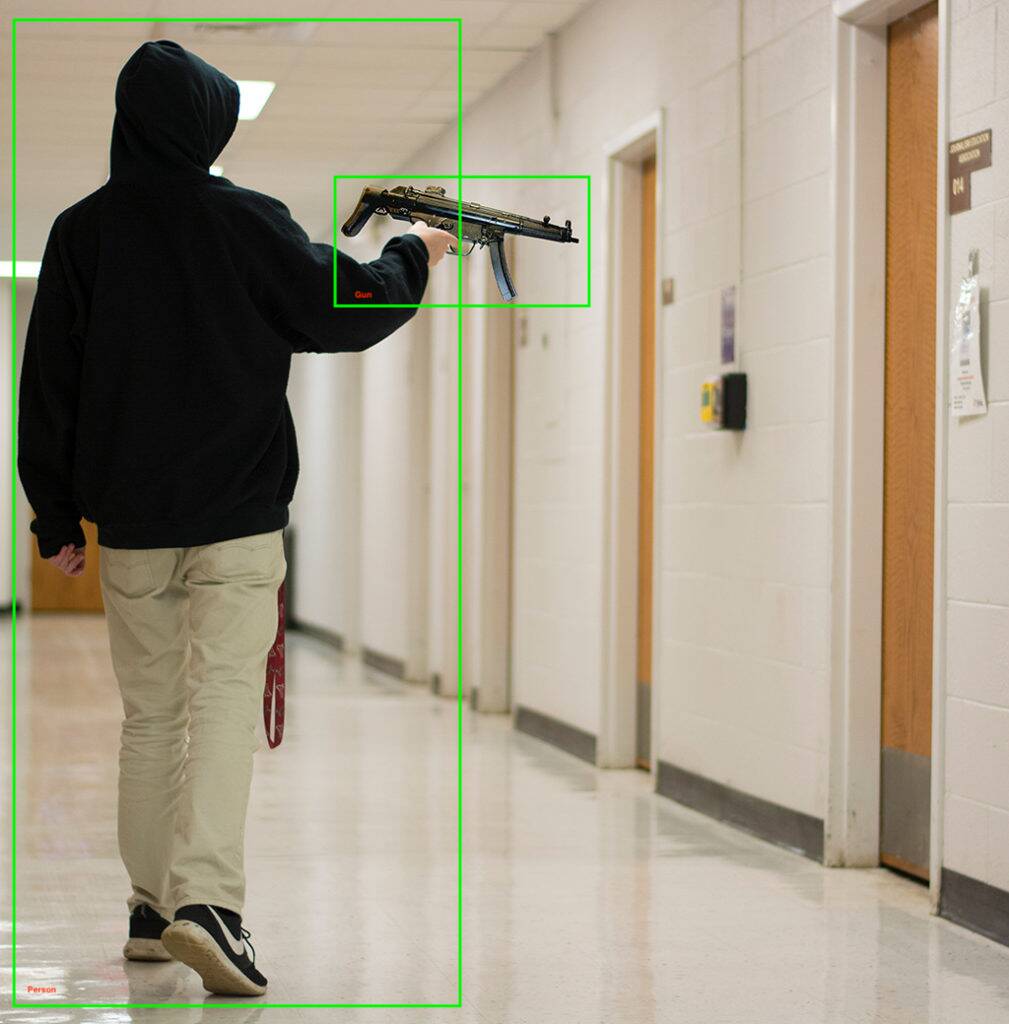

Martedì, la società di apprendimento automatico Kogniz ha annunciato che stava aggiungendo un dispositivo pronto per la distribuzione modello di rilevamento della pistola alla sua piattaforma di visione artificiale. Il sistema, ci viene detto, può rilevare le armi viste dalle telecamere di sicurezza e inviare notifiche a chi è a rischio, avvisando la polizia, chiudendo edifici ed eseguendo altre attività di sicurezza.

Oltre a individuare le armi da fuoco, Kogniz usa i suoi altri moduli di visione artificiale per notare comportamenti insoliti, come bambini che corrono lungo i corridoi o qualcuno che si arrampica attraverso una finestra, il che potrebbe indicare un tiratore attivo.

Se ti stai chiedendo quale sia il tasso di falsi positivi o di errore del codice, Kogniz afferma che ha una "IA multi-pass" e "un team addestrato di verificatori umani" che controlla i risultati del suo software di rilevamento. O accogli con favore quel livello extra di conferma, o lo vedi come una tecnologia che potenzialmente ricade sugli esseri umani proprio quando i computer sono più necessari.

"[La nostra soluzione è] rendere notevolmente più facile per aziende, agenzie governative, scuole e ospedali prepararsi e quindi contribuire a ridurre i danni causati da un evento sparatutto attivo", ha affermato Daniel Putterman, CEO di Kogniz.

Kogniz non è la prima azienda di computer vision ad entrare nel gioco del riconoscimento delle armi: esiste un considerevole elenco di aziende che implementano tecnologie simili e alcune, come ZeroEyes, sono specializzate solo nel rilevamento di armi da fuoco.

"Distribuendo la loro attenzione su più offerte, gli sviluppatori sono meno in grado di fornire il miglior servizio di rilevamento delle armi", ha affermato ZeroEyes in un post sul blog. La tecnologia di ZeroEyes è stata implementata nelle scuole di 14 stati, tra cui Liceo di Oxford nella metropolitana di Detroit, dove un tiratore di 15 anni ha ucciso quattro persone e ne ha ferite sette l'anno scorso.

Altri fornitori, come Defendry, che dispone di una suite di sicurezza che include un'app per pulsanti antipanico, sensori audio per spari, droni di primo intervento e intelligenza artificiale per il rilevamento delle armi; e Omnilert – sono in questo mercato in crescita deprimente. Altre società nel campo del rilevamento delle armi con intelligenza artificiale includono Arcarith, Athena Securities e Scylla.

C'è davvero abbastanza tempo?

Nel 2019, la risposta della polizia a una sparatoria di massa a Dayton, Ohio, è stata di soli 32 secondi, durante i quali sono morte nove persone. Anche una sparatoria del 2021 in una struttura della FedEx di Indianapolis che ha ucciso nove persone è finita prima che arrivassero i poliziotti, anche se lo hanno fatto in pochi minuti.

Entrambi questi casi sollevano la questione se il rilevamento delle armi con intelligenza artificiale possa ridurre i tempi di risposta abbastanza da salvare vite umane. Soprattutto se gli agenti sono troppo spaventati o scelgono di non rispondere effettivamente, come nell'omicidio di massa di Uvalde.

Sono stati proposti diversi altri metodi di prevenzione delle sparatorie di massa basati sull'intelligenza artificiale, come pistole intelligenti che non sparerà se rilevano un bersaglio umano. Altri hanno proposto di addestrare IA sui dati di sparatorie passate, acquisti locali di armi e dati socioeconomici per trovare tendenze indicative di una sparatoria pianificata, oltre a scansionare i social media per indicatori simili.

C'è anche Pregiudizio AI, un problema ben documentato che anche set di dati diversi e formazione equilibrata non riesco a risolvere. Prendi un dispiegamento nel 2020 di una tecnologia di riconoscimento facciale e di armi in un distretto scolastico di New York: le e-mail tra il distretto scolastico e l'azienda che ha implementato il sistema mostrano comunemente preoccupazioni al riguardo errata identificazione cose, come manici di scopa per pistole.

Parlando con la pubblicazione dello Utah Deseret News, Jay Stanley, analista politico senior dell'ACLU disse era preoccupato che i sistemi di visione artificiale potessero portare a un mondo "in cui le persone evitano di fare qualcosa di semplice come saltare giù per un marciapiede per paura di far scattare rilevatori di anomalie e di essere interrogati dalla polizia".

Tuttavia, un possibile uso dell'IA potrebbe essere più promettente: un 2018 studio del Cincinnati Children's Hospital Medical Center ha rilevato che l'analisi dell'IA delle sessioni terapeutiche concordava con le valutazioni del pericolo di psichiatri e consulenti il 91% delle volte. L'aggiunta di dati demografici e socioeconomici ha solo migliorato i risultati nell'identificazione dei giovani a rischio di commettere atti violenti.

Con così tante potenziali complicazioni, l'apprendimento automatico è davvero pronto a prevenire gli omicidi di massa?

La violenza armata è la assassino numero uno di bambini e adolescenti in America, uccidendo in media 12 giovani vite e ferendone altre 32 ogni giorno. L'intelligenza artificiale può aiutare, ma senza affrontare le sue carenze, forse sono necessari anche approcci meno tecnologici. Un'assistenza sanitaria mentale più forte e più ampiamente disponibile potrebbe essere un buon inizio.

All'inizio di questo mese, il presidente Biden detto per, tra le altre cose, un divieto di armi d'assalto, controlli in background estesi e limiti alla capacità del caricatore, che ha definito "misure razionali e di buon senso". ®

- AI

- oh arte

- generatore d'arte

- un robot

- intelligenza artificiale

- certificazione di intelligenza artificiale

- intelligenza artificiale nel settore bancario

- robot di intelligenza artificiale

- robot di intelligenza artificiale

- software di intelligenza artificiale

- blockchain

- conferenza blockchain ai

- geniale

- intelligenza artificiale conversazionale

- criptoconferenza ai

- dall's

- apprendimento profondo

- google ai

- machine learning

- Platone

- platone ai

- Platone Data Intelligence

- Gioco di Platone

- PlatoneDati

- gioco di plato

- scala ai

- sintassi

- Il registro

- zefiro