L'IA e i computer convenzionali sono una partita fatta all'inferno.

Il motivo principale è come sono attualmente impostati i chip hardware. Basato sulla tradizionale architettura Von Neumann, il chip isola la memoria dai suoi processori principali. Ogni calcolo è un pendolarismo da incubo del lunedì mattina, con il chip che sposta costantemente i dati avanti e indietro da ogni scompartimento, formando un famigerato "muro di memoria. "

Se sei mai stato bloccato nel traffico, conosci la frustrazione: ci vuole tempo ed energia sprecata. Man mano che gli algoritmi di intelligenza artificiale diventano sempre più complessi, il problema peggiora sempre più.

Allora perché non progettare un chip basato sul cervello, un potenziale abbinamento perfetto per le reti neurali profonde?

Immettere i chip di calcolo in memoria o CIM. Fedeli al loro nome, questi chip calcolano e immagazzinano memoria nello stesso sito. Dimentica il pendolarismo; i chip sono alternative di lavoro da casa altamente efficienti, che eliminano il problema del collo di bottiglia del traffico dati e promettono una maggiore efficienza e un minor consumo di energia.

O almeno così va la teoria. La maggior parte dei chip CIM che eseguono algoritmi di intelligenza artificiale si sono concentrati esclusivamente sulla progettazione del chip, mostrando le proprie capacità utilizzando simulazioni del chip piuttosto che eseguire attività su hardware a tutti gli effetti. I chip faticano anche ad adattarsi a molteplici attività di intelligenza artificiale (riconoscimento delle immagini, percezione della voce) limitando la loro integrazione negli smartphone o altri dispositivi di uso quotidiano.

Questo mese, uno studio in Natura CIM aggiornato da zero. Invece di concentrarsi esclusivamente sulla progettazione del chip, il team internazionale, guidato dagli esperti di hardware neuromorfico Dr. HS Philip Wong a Stanford e dal Dr. Gert Cauwenberghs a UC San Diego, ha ottimizzato l'intera configurazione, dalla tecnologia all'architettura, agli algoritmi che calibrano l'hardware .

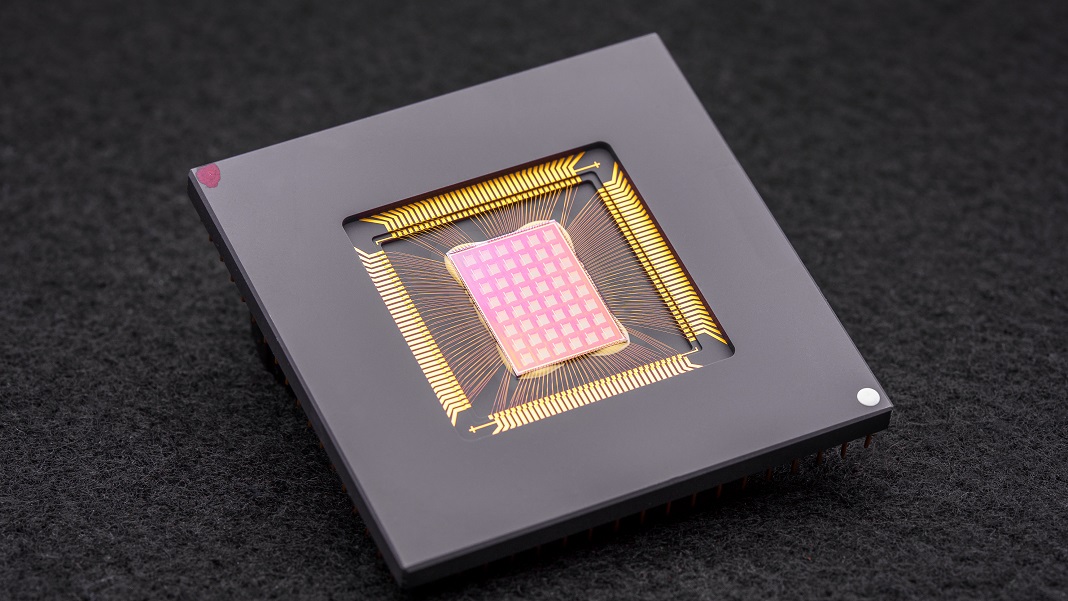

Il chip NeuRRAM risultante è un potente colosso informatico neuromorfico con 48 core paralleli e 3 milioni di celle di memoria. Estremamente versatile, il chip ha affrontato molteplici attività standard di intelligenza artificiale, come la lettura di numeri scritti a mano, l'identificazione di automobili e altri oggetti nelle immagini e la decodifica di registrazioni vocali, con una precisione superiore all'84%.

Sebbene il tasso di successo possa sembrare mediocre, rivaleggia con i chip digitali esistenti ma consente di risparmiare notevolmente energia. Per gli autori, è un passo avanti verso l'introduzione dell'IA direttamente sui nostri dispositivi, piuttosto che la necessità di trasferire i dati nel cloud per il calcolo.

"Avere questi calcoli eseguiti sul chip invece di inviare informazioni da e verso il cloud potrebbe consentire un'IA più veloce, più sicura, più economica e più scalabile in futuro e consentire a più persone di accedere alla potenza dell'IA", disse Wong.

Ispirazione neurale

Chip specifici per l'IA sono ormai una dozzina di dieci centesimi sorprendenti. Dalla Tensor Processing Unit (TPU) di Google e dall'architettura del supercomputer Dojo di Tesla a Baidu e Amazon, i giganti della tecnologia stanno investendo milioni nella corsa all'oro dei chip AI per costruire processori che supportino algoritmi di deep learning sempre più sofisticati. Alcuni anche attingere all'apprendimento automatico per progettare architetture di chip su misura per il software AI, portando la gara al punto di partenza.

Un concetto particolarmente intrigante arriva direttamente dal cervello. Quando i dati passano attraverso i nostri neuroni, si "cablano" in reti attraverso "dock" fisici chiamati sinapsi. Queste strutture, che si trovano in cima a rami neurali come piccoli funghi, sono multitasking: calcolano e archiviano i dati attraverso i cambiamenti nella loro composizione proteica.

In altre parole, i neuroni, a differenza dei computer classici, non hanno bisogno di trasferire i dati dalla memoria alle CPU. Questo dà al cervello il suo vantaggio rispetto ai dispositivi digitali: è altamente efficiente dal punto di vista energetico ed esegue più calcoli contemporaneamente, il tutto racchiuso in una gelatina di tre libbre infilata all'interno del cranio.

Perché non ricreare aspetti del cervello?

entrare calcolo neuromorfico. Un trucco consisteva nell'utilizzare RRAM o dispositivi di memoria ad accesso casuale resistivi (chiamati anche "memristori"). Le RRAM immagazzinano memoria anche quando vengono interrotte dall'alimentazione modificando la resistenza del loro hardware. Simile alle sinapsi, questi componenti possono essere impacchettati in densi array su un'area minuscola, creando circuiti capaci di calcoli altamente complessi senza ingombro. Se combinato con CMOS, un processo di fabbricazione per la costruzione di circuiti nei nostri attuali microprocessori e chip, il duo diventa ancora più potente per l'esecuzione di algoritmi di deep learning.

Ma ha un costo. "Il calcolo analogico altamente parallelo all'interno dell'architettura RRAM-CIM offre un'efficienza superiore, ma rende difficile realizzare lo stesso livello di flessibilità funzionale e accuratezza computazionale dei circuiti digitali", hanno affermato gli autori.

Genio dell'ottimizzazione

Il nuovo studio ha approfondito ogni parte di un chip RRAM-CIM, riprogettandolo per un uso pratico.

Si parte dalla tecnologia. NeuRRAM vanta 48 core che calcolano in parallelo, con dispositivi RRAM intrecciati fisicamente nei circuiti CMOS. Come un neurone, ogni core può essere spento individualmente quando non è in uso, preservando l'energia mentre la sua memoria è immagazzinata nella RRAM.

Queste celle RRAM, tutte e tre milioni, sono collegate in modo che i dati possano essere trasferiti in entrambe le direzioni. È un design cruciale, che consente al chip di adattarsi in modo flessibile a diversi tipi di algoritmi di intelligenza artificiale, hanno spiegato gli autori. Ad esempio, un tipo di rete neurale profonda, la CNN (convolutional neural network), è particolarmente efficace nella visione artificiale, ma ha bisogno che i dati fluiscano in un'unica direzione. Al contrario, gli LSTM, un tipo di rete neurale profonda spesso utilizzata per il riconoscimento audio, elabora periodicamente i dati per far corrispondere i segnali con il tempo. Come le sinapsi, il chip codifica la forza con cui un "neurone" RRAM si connette a un altro.

Questa architettura ha consentito di ottimizzare il flusso di dati per ridurre al minimo gli ingorghi. Come l'espansione del traffico a corsia singola su più corsie, il chip potrebbe duplicare l'attuale "memoria" di una rete dai problemi più complessi dal punto di vista computazionale, in modo che più core analizzino il problema contemporaneamente.

Un ultimo ritocco ai precedenti chip CIM è stato un ponte più forte tra l'elaborazione simile al cervello, spesso analogica, e l'elaborazione digitale. Qui, il chip utilizza un circuito neuronale che può convertire facilmente il calcolo analogico in segnali digitali. È un passo avanti rispetto alle precedenti configurazioni "affamate di potere e affamate di area", hanno spiegato gli autori.

Le ottimizzazioni hanno funzionato. Mettendo alla prova la loro teoria, il team ha prodotto il chip NeuRRAM e sviluppato algoritmi per programmare l'hardware per algoritmi diversi, come Play Station 5 che esegue giochi diversi.

In una moltitudine di test benchmark, il chip si è comportato come un campione. Eseguendo una CNN a sette livelli sul chip, NeuRRAM ha avuto un tasso di errore inferiore all'uno per cento nel riconoscere le cifre scritte a mano utilizzando il popolare database MNIST.

Eccelleva anche nei compiti più difficili. Caricando un'altra popolare rete neurale profonda, LSTM, il chip era corretto all'incirca all'85% quando è stato sfidato con il riconoscimento dei comandi vocali di Google. Utilizzando solo otto core, il chip, in esecuzione su un'altra architettura di intelligenza artificiale, è stato in grado di recuperare immagini rumorose, riducendo gli errori di circa il 70%.

Così che cosa?

Una parola: energia.

La maggior parte degli algoritmi di intelligenza artificiale sono maiali di energia totale. NeuRRAM operava a metà del costo energetico dei precedenti chip RRAM-CIM all'avanguardia, traducendo ulteriormente in realtà la promessa di risparmio energetico con il calcolo neuromorfico.

Ma il punto di forza dello studio è la sua strategia. Troppo spesso durante la progettazione di chip, gli scienziati devono bilanciare efficienza, versatilità e precisione per più attività, metriche che spesso sono in contrasto tra loro. Il problema diventa ancora più difficile quando tutte le operazioni di elaborazione vengono eseguite direttamente sull'hardware. NeuRRAM ha dimostrato che è possibile combattere tutte le bestie contemporaneamente.

La strategia utilizzata qui può essere utilizzata per ottimizzare altri dispositivi informatici neuromorfici come tecnologia di memoria a cambiamento di fases, hanno detto gli autori.

Per ora, NeuRRAM è una prova di concetto, che mostra che un chip fisico, piuttosto che una sua simulazione, funziona come previsto. Ma c'è spazio per miglioramenti, incluso l'ulteriore ridimensionamento delle RRAM e la riduzione delle sue dimensioni a un giorno potenzialmente adatte ai nostri telefoni.

"Forse oggi viene utilizzato per eseguire semplici attività di intelligenza artificiale come l'individuazione di parole chiave o il rilevamento di esseri umani, ma domani potrebbe consentire un'esperienza utente completamente diversa. Immagina l'analisi video in tempo reale combinata con il riconoscimento vocale all'interno di un minuscolo dispositivo", disse autore dello studio Dr. Weier Wan. "Come ricercatore e ingegnere, la mia ambizione è portare le innovazioni della ricerca dai laboratori all'uso pratico".

Immagine di credito: David Baillot/Università della California San Diego