החוק של גודרט המפורסם אומר: "כאשר מידה הופכת למטרה, היא מפסיקה להיות מידה טובה." למרות שמקורו בכלכלה, זה משהו שאנחנו צריכים להתמודד איתו ב-OpenAI כשאנחנו מבינים איך לייעל יעדים שקשה או יקר למדידה. לעתים קרובות יש צורך להציג כמה מטרת פרוקסי קל יותר או זול יותר למדוד, אבל כשאנחנו עושים את זה, אנחנו צריכים להיזהר לא לייעל את זה יותר מדי.

למשל, כחלק מהעבודה שלנו ל ליישר מודלים כמו GPT-3 עם כוונה וערכים אנושיים, נרצה לייעל דברים כמו "איך מועיל זו תגובה?", או "איך מדויק עובדתית האם זו טענה?". אלו מטרות מורכבות שדורשות מבני אדם לבדוק את הדברים בקפידה. מסיבה זו, אנו מאמנים מודל לחזות העדפות אנושיות אלו, המכונה א מודל תגמול, והשתמש בתחזיות של מודל התגמול כיעד פרוקסי. אבל חשוב לעקוב אחר מידת האופטימיזציה של המטרה האמיתית.

בפוסט זה נסתכל על כמה מהמתמטיקה שמאחורי האופן בו אנו עושים זאת. נתמקד בסביבה נקייה במיוחד לניתוח, שבה יש לנו גישה אל המטרה האמיתית. בפועל, אפילו העדפות אנושיות יכולות לא למדוד מה באמת אכפת לנו, אבל אנחנו מניחים את הנושא הזה בצד בפוסט הזה.

הדגימה הטובה מ-$n$

ישנן דרכים רבות שבהן ניתן לייעל את מטרת ה-proxy, אבל אולי הפשוטה ביותר היא הדגימה הטובה מ-$n$, ידוע גם כ דגימת דחייה or דירוג מחדש. אנחנו פשוט דוגמים $n$ פעמים ולוקחים את זה שמקבל את הציון הגבוה ביותר בהתאם ליעד ה-proxy.

למרות ששיטה זו היא פשוטה מאוד, היא למעשה יכולה להיות תחרותית עם טכניקות מתקדמות יותר כגון לימוד חיזוק, אם כי במחיר של יותר חישוב זמן מסקנות. לדוגמה, ב WebGPT, המודל הטוב מ-$64$ שלנו עלה על מודל למידת החיזוק שלנו, אולי בין השאר בגלל שהמודל הטוב מ-$64$ זכה לגלוש באתרים רבים נוספים. אפילו יישום הטוב מ-$4$ סיפק דחיפה משמעותית להעדפות אנושיות.

בנוסף, הדגימה הטובה מ-$n$ היא בעלת ביצועים אמינים והיא פשוטה לניתוח מתמטית, מה שהופך אותה למתאימה היטב למחקרים אמפיריים של חוק גודהארט ותופעות קשורות.

המתמטיקה של הדגימה הטובה מ-$n$

בואו נלמד את הדגימה הטובה מ-$n$ בצורה יותר פורמלית. נניח שיש לנו מרחב מדגם $S$ (כגון קבוצת זוגות השאלות-תשובות האפשריות), התפלגות הסתברות כלשהי $P$ על $S$, מטרה אמיתית (או "פרס") $R_{text{true}}:Stomathbb R$, ומטרת פרוקסי $R_{text{proxy}}:Stomathbb R$. נניח שאנו עושים איכשהו אופטימיזציה של $R_{text{proxy}}$ ובכך משיגים הפצה חדשה כלשהי $P^prime$. לאחר מכן:

- הציפייה $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$ מודדת עד כמה ביצענו אופטימיזציה של המטרה האמיתית.

- אל האני סטיות KL $D_{text{KL}}left(P^primeparallel Pright)$ מודד כמה אופטימיזציה עשינו. לדוגמה, אם $P^prime$ מתקבל על ידי לקיחת המדגם הראשון מ-$P$ שנמצא בתת-קבוצה כלשהי $S^primesubseteq S$, אז סטיית ה-KL הזו היא רק ההסתברות היומית השלילית לכך שמדגם מ-$P$ נמצא ב-$S^prime$.

מסתבר שבמקרה של דגימת best-of-$n$, ניתן להעריך ביעילות את שתי הכמויות הללו באמצעות דגימות מ-$P$.

בואו נסתכל תחילה על הציפייה. הגישה הנאיבית היא להשתמש באומדן של מונטה קרלו: הפעל את הדגימה הטובה ביותר מ-$n$ פעמים רבות, מדוד את המטרה האמיתית בדגימות הללו, וממוצע התוצאות. עם זאת, יש אומדן טוב יותר. אם יש לנו $Ngeq n$ דוגמאות מ-$P$ בסך הכל, אז נוכל לשקול בו זמנית כל תת-קבוצה אפשרית מתוך דגימות אלה בגודל $n$, שקלו כל דגימה במספר קבוצות המשנה שלגביהן היא הטובה ביותר לפי יעד ה-proxy, ולאחר מכן קח את הציון האובייקטיבי האמיתי המשוקלל הממוצע. משקל זה הוא רק המקדם הבינומי $binom{k-1}{n-1}$, כאשר $k$ הוא הדירוג של המדגם תחת יעד ה-proxy, מ-$1$ (הגרוע ביותר) ועד $N$ (הטוב ביותר). בנוסף לשימוש בדוגמאות בצורה יעילה יותר, זה גם מאפשר לנו לעשות שימוש חוזר בדגימות עבור ערכים שונים של $n$.

באשר לסטייה KL, באופן מפתיע, מסתבר שיש לה נוסחה מדויקת שעובדת עבור כל התפלגות הסתברות רציפה $P$ (כלומר, כל עוד ל-$P$ אין מסות נקודתיות). אפשר לנחש בתמימות שהתשובה היא $log n$, מכיוון שה-best-of-$n$ עושה משהו כמו לקחת את $frac 1n$ העליון של ההפצה, וזה בערך נכון: התשובה המדויקת היא $log n-frac{n-1}n$.

יחד, אומדנים אלה מאפשרים לנו לנתח בקלות כיצד המטרה האמיתית משתנה עם כמות האופטימיזציה המוחלת על יעד ה-proxy.

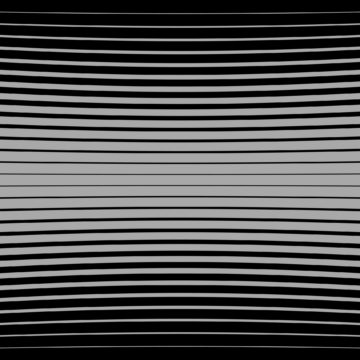

הנה דוגמה מהחיים האמיתיים מ WebGPT:

הביצועים הטובים ביותר מ-$n$ עבור WebGPT 175B

הביצועים הטובים ביותר של $n$ עבור WebGPT, עם אזורים מוצללים המייצגים שגיאת תקן של $pm 1$, וציר KL עוקב אחר סולם שורש ריבועי. כאן, ההפצה המקורית ($P$) ניתנת על ידי מודל 175B שאומן באמצעות שיבוט התנהגות, מטרת ה-proxy המשמשת לחישוב הטוב מ-$n$ ($R_{text{proxy}}$) ניתנת על ידי ההדרכה מודל תגמול, ואנו מתייחסים לשלוש יעדים "אמיתיים" לכאורה ($R_{text{true}}$): מודל תגמול האימון עצמו, מודל תגמול אימות שהוכשר על סמך נתונים מוחזקים והעדפות אנושיות בפועל. אין הרבה אופטימיזציה יתר של יעד ה-proxy, אבל היינו מצפים שתהיה ב-KL גבוהות יותר.

מעבר לדגימה הטובה ביותר של $n$

המגבלה העיקרית של דגימת best-of-$n$ היא שהדיברגנציה KL גדלה לוגריתמית עם $n$, כך שהיא מתאימה רק להחלת כמות קטנה של אופטימיזציה.

כדי ליישם יותר אופטימיזציה, אנו משתמשים בדרך כלל בלימוד חיזוק. במסגרות שלמדנו עד כה, כגון סיכום, בדרך כלל הצלחנו להגיע ל-KL של בערך 10 נטיות שימוש בלימוד חיזוק לפני שהמטרה האמיתית מתחילה לרדת עקב חוק גודהארט. נצטרך לקחת $n$ כדי להיות בסביבות 60,000 כדי להגיע ל-KL הזה באמצעות הטוב מ-$n$, ואנחנו מקווים שנוכל להגיע ל-KLs הרבה יותר גדול מזה עם שיפורים במודלים שלנו לתגמולים ולמידת חיזוק.

עם זאת, לא כל הנאטים שווים. מבחינה אמפירית, עבור תקציבים קטנים של KL, best-of-$n$ מייעל טוב יותר הן את הפרוקסי והן את היעדים האמיתיים מאשר למידה חיזוקית. באופן אינטואיטיבי, ה-best-of-$n$ היא גישת "הכוח האכזרי", מה שהופך אותה ליעילה יותר מבחינה תיאורטית מאשר למידת חיזוק, אך פחות יעילה מבחינה חישובית ב-KLs גדולות.

אנו לומדים באופן פעיל את מאפייני קנה המידה של יעדי פרוקסי כחלק מהעבודה שלנו ליישר המודלים שלנו עם כוונה וערכים אנושיים. אם תרצה לעזור לנו במחקר הזה, אנחנו שכירה!

- AI

- איי אמנות

- מחולל אמנות ai

- איי רובוט

- בינה מלאכותית

- הסמכת בינה מלאכותית

- בינה מלאכותית בבנקאות

- רובוט בינה מלאכותית

- רובוטים של בינה מלאכותית

- תוכנת בינה מלאכותית

- blockchain

- blockchain conference ai

- קוינגניוס

- בינה מלאכותית של שיחה

- קריפטו כנס ai

- של דאל

- למידה עמוקה

- גוגל איי

- למידת מכונה

- OpenAI

- אפלטון

- plato ai

- מודיעין אפלטון

- משחק אפלטון

- אפלטון נתונים

- פלטוגיימינג

- מחקר

- סולם ai

- תחביר

- זפירנט