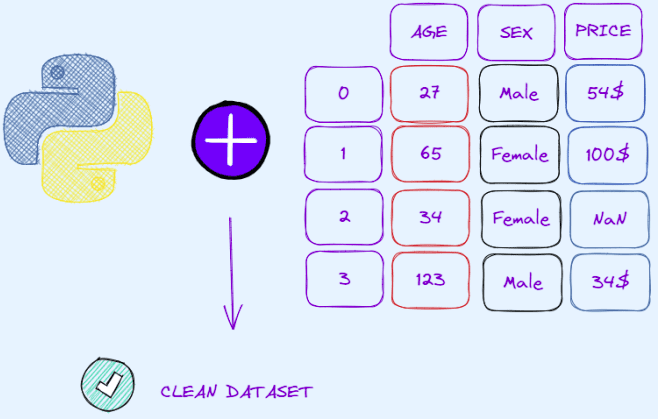

データ クリーニングは、データ サイエンス プロジェクトにおいて非常に重要かつ重要なステップです。 マシン モデルの成功は、データをどのように前処理するかにかかっています。 データセットの前処理を過小評価してスキップすると、モデルはうまく機能せず、期待どおりに機能しない理由を理解するために多くの時間を無駄にします。

最近、私は自分のデータ サイエンス活動をスピードアップするためにチート シート、特にデータ クリーニングの基本をまとめたチート シートを作成し始めました。 この投稿と カンニングペーパー、データ サイエンス プロジェクトの前処理ステップを特徴付ける XNUMX つの異なる側面を紹介します。

このチートシートでは、欠落データの検出と処理、重複の処理と重複の解決策の発見、異常値の検出、カテゴリ特徴のラベル エンコーディングとワンホット エンコーディングから、MinMax 正規化や標準正規化などの変換に進みます。 さらに、このガイドでは、プロットを表示するために、最も人気のある XNUMX つの Python ライブラリ、Pandas、Scikit-Learn、および Seaborn によって提供されるメソッドを活用します。

これらの python トリックを学習すると、データセットから可能な限り多くの情報を抽出するのに役立ちます。その結果、クリーンで前処理された入力から学習することで、機械学習モデルのパフォーマンスが向上します。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- Platoblockchain。 Web3メタバースインテリジェンス。 知識の増幅。 こちらからアクセスしてください。

- 情報源: https://www.kdnuggets.com/2023/02/data-cleaning-python-cheat-sheet.html?utm_source=rss&utm_medium=rss&utm_campaign=data-cleaning-with-python-cheat-sheet

- a

- できる

- 活動

- &

- 側面

- の基礎

- 始まった

- より良いです

- 特徴づけます

- クリーニング

- その結果

- 作ります

- 重大な

- データ

- データサイエンス

- 取引

- 依存

- 検出

- 異なります

- 表示

- そうではありません

- 複製

- 期待する

- エクスプロイト

- エキス

- 特徴

- 発見

- から

- Go

- 行く

- ガイド

- ハンドリング

- 助けます

- 認定条件

- HTTPS

- 重要

- in

- 情報

- IT

- KDナゲット

- ラベル

- 学習

- ライブラリ

- 失う

- たくさん

- 機械

- 機械学習

- メソッド

- 行方不明

- 他には?

- 最も

- 一番人気

- パンダ

- 特定の

- 実行する

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- 人気

- 可能

- ポスト

- プロジェクト

- 提供

- Python

- 科学

- scikit-学ぶ

- 海生まれ

- 検索

- 表示する

- ソリューション

- スピード

- 標準

- 手順

- ステップ

- 成功

- そのような

- 概要

- 基礎

- 三

- 時間

- 〜へ

- 変換

- トリック

- わかる

- 意志

- 仕事

- でしょう

- あなたの

- ゼファーネット

より多くの KDナゲット

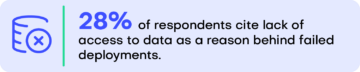

ほとんどの企業ではデータ アクセスが著しく不足しており、71% が合成データが役立つと信じています – KDnuggets

ソースノード: 2174106

タイムスタンプ: 2023 年 7 月 17 日

トップストーリー、26月1日〜XNUMX月XNUMX日:GitHubコパイロットオープンソースの代替案。 なぜ、どのように「生産データサイエンス」を学ぶ必要がありますか?

ソースノード: 997661

タイムスタンプ: 2021 年 8 月 2 日