19月XNUMX日の週th, Linley Group は、Spring Processor Conference 2021 を開催しました。Linley Group は、優れたカンファレンスを開催することで定評があります。 そして今年の春季カンファレンスも例外ではありませんでした。 さまざまな企業から、業界で行われている最新の研究開発作業について聴衆に最新情報を提供する、非常に有益な講演が多数ありました。 プレゼンテーションは 5 つの異なる主題に分類されていました。 主題は、エッジ AI、組み込み SoC 設計、スケーリング AI トレーニング、AI SoC 設計、AI および XNUMXG のネットワーク インフラストラクチャ、エッジ AI ソフトウェア、信号処理、効率的な AI 推論でした。

テクノロジーとしての人工知能 (AI) は、近年多くの注目と投資を集めています。 このカンファレンスでは、AI に関連する主題カテゴリの数にそれが確かに反映されていました。 AI というより広いカテゴリの中で、エッジ AI はプレゼンテーションで不当なシェアを占める主題であり、それは当然のことでした。 エッジ コンピューティングは、IoT、5G、その他の低遅延要件のアプリケーションによって急速に成長しています。

Edge AI カテゴリ内のプレゼンテーションの XNUMX つは次のタイトルでした 「RISC-V ベクトル拡張機能を強化して、ML ワークロードのパフォーマンスを高速化します。」 この講演は、SiFive, Inc. のエンジニアリングおよび製品担当社長である Chris Lattner によって行われました。Chris は、SiFive の RISC-V ベクトル拡張ベースのソリューションが AI 駆動のアプリケーションに最適である理由を強く主張しました。 以下は私の見解です。

市場の要件:

エッジ コンピューティングの市場が急速に成長するにつれて、これらのアプリケーションのパフォーマンスと電力の要件もますます厳しくなっています。 これらのアプリケーションの多くは AI 駆動型であり、機械学習 (ML) ワークロードのカテゴリに分類されます。 また、AI の導入により、処理要件は汎用コンピューティングではなくデータ操作に向けられています。 深層学習は ML モデルの基礎となり、大規模なデータ配列の処理を伴います。 ML モデルが急速に進化しているため、理想的なソリューションは、パフォーマンス、パワー、新しい ML モデルの組み込みの容易さ、および結果として生じるハードウェアおよび/またはソフトウェアの変更の範囲を最適化するソリューションです。

RISC-V ベクトルの利点:

RISC-V アーキテクチャをもたらしたこの取り組みの背後にある元々の動機は実験です。 ムーアの法則の減速が予想されるにもかかわらず、より優れたパフォーマンスを生み出すチップ設計を開発する実験を行っています。 RISC-V は、使用する命令セット拡張を選択できる特定のチップをカスタマイズできるという考えに基づいて構築されています。 ベクトル拡張により、固定長のベクトルを処理する関数を使用して、任意の長さのベクトルを処理できます。 ベクトル処理により、ハードウェアがより多くの ALU やその他の機能ユニットの形でアップグレードされるときに、既存のソフトウェアを再コンパイルせずに実行できるようになります。 確立されたハードウェア ベースとコンパイラ テクノロジなどのサポート エコシステムの点で、大きな進歩が見られました。

RISC-V は、カスタム拡張機能を通じて特定のドメインまたはアプリケーション向けに最適化できます。 オープン標準の命令セット アーキテクチャである RISC-V ユーザーは、チップ設計のニーズに合わせてサプライヤーを柔軟に選択できます。

SiFive の提供物:

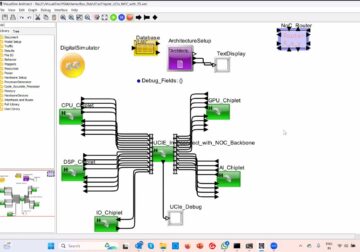

SiFive は、さまざまなニューラル ネットワーク モデルの実行を高速化するための新しいベクトル拡張機能を追加することで、RISC-V ベクトルの利点を強化しました。 図 1 を参照して、RISC-V の基本ベクトル拡張機能のみを使用した場合と比較して、SiFive のアドオン拡張機能を使用するとどのような速度向上が得られるかを示します。 同社の Intelligence X280 ソリューションは、顧客が最適化された Edge AI アプリケーションを簡単に実装できるようにする、マルチコア対応の RISC-V Vector ソリューション (ハードウェアおよびソフトウェア) です。 このソリューションは、データセンター アプリケーションの実装にも使用できます。

図1:

SiFive の利点:

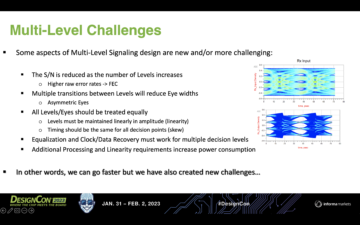

- SiFive の Intelligence X280 ソリューションは、機械学習用の TensorFlow および TensorFlow Lite オープンソース プラットフォームを完全にサポートしています (図 2 を参照)

- SiFive は、他のアーキテクチャに基づく顧客の既存のコードを RISC-V Vector アーキテクチャに移行する簡単な方法を提供します。 たとえば、SiFive は ARM Neon コードを RISC-V V アセンブリ コードに変換できます。

- SiFive を使用すると、顧客は RISC-V 実装にカスタム拡張機能を追加することができます。

- SiFive は、OpenFive ビジネスユニットを通じてカスタムチップ実装サービスを拡張し、ドメイン固有のシリコンニーズに対応します

図2:

概要

一言で言えば、SiFive の顧客は、アプリケーションに Edge AI ワークロードが含まれるか、従来のデータセンター タイプのワークロードが含まれるかに関係なく、アプリケーションを簡単かつ迅速に実装できます。 ML ワークロードのパフォーマンスを高速化するための SiFive ソリューションのメリットに興味がある場合は、登録して聞くことをお勧めします。 クリスの話全体 そして、SiFive のさまざまな製品を製品開発に活用する方法について話し合います。

- 2021

- 5G

- アドオン

- 養子縁組

- 利点

- AI

- AIの採用

- AIトレーニング

- 申し込み

- 4月

- 建築

- ARM

- 聴衆

- ビジネス

- チップ

- チップ

- コード

- 企業

- コンピューティング

- 講演

- 会議

- Customers

- データ

- データセンター

- 深い学習

- 設計

- 開発する

- 開発

- ドリブン

- エコシステム

- エッジ(Edge)

- エッジコンピューティング

- エンジニアリング

- 実行

- エクステンション

- 顔

- スピーディー

- フィギュア

- フィット

- 柔軟性

- フォーム

- フル

- 素晴らしい

- グループ

- 成長

- 成長性

- Hardware

- HTTPS

- アイデア

- (株)

- 産業を変えます

- インフラ

- イニシアチブ

- インテリジェンス

- 投資

- IOT

- IT

- 大

- 最新の

- 法律

- 学習

- 活用します

- 機械学習

- 操作

- 市場

- 事態

- ML

- Neon

- ネットワーク

- ニューラル

- ニューラルネットワーク

- 提供すること

- オファリング

- 開いた

- その他

- パフォーマンス

- プラットフォーム

- 電力

- プレゼンテーション

- 社長

- プロダクト

- 製品

- 要件

- 研究

- 研究開発

- ラン

- スケーリング

- サービス

- セッションに

- シェアする

- So

- ソフトウェア

- ソリューション

- 春

- サポート

- サポート

- トーク

- テクノロジー

- テクノロジー

- テンソルフロー

- イニシアチブ

- トレーニング

- us

- users

- 週間

- 以内

- 仕事

- 年

- 産出