著者による画像

XAI は、人間がモデルまたはシステムの結果と意思決定プロセスを理解できるようにする人工知能です。

モデリング前の説明可能性

説明可能な AI は、説明可能なデータと、明確で解釈可能な特徴エンジニアリングから始まります。

モデリングの説明可能性

特定の問題に対してモデルを選択するときは、一般的に、良好な予測結果が得られる最も解釈しやすいモデルを使用するのが最善です。

モデル後の説明可能性

これには、トレーニング後の SHAP 値など、モデルの出力に対する単一変数の変更の影響が分析される摂動などの手法が含まれます。

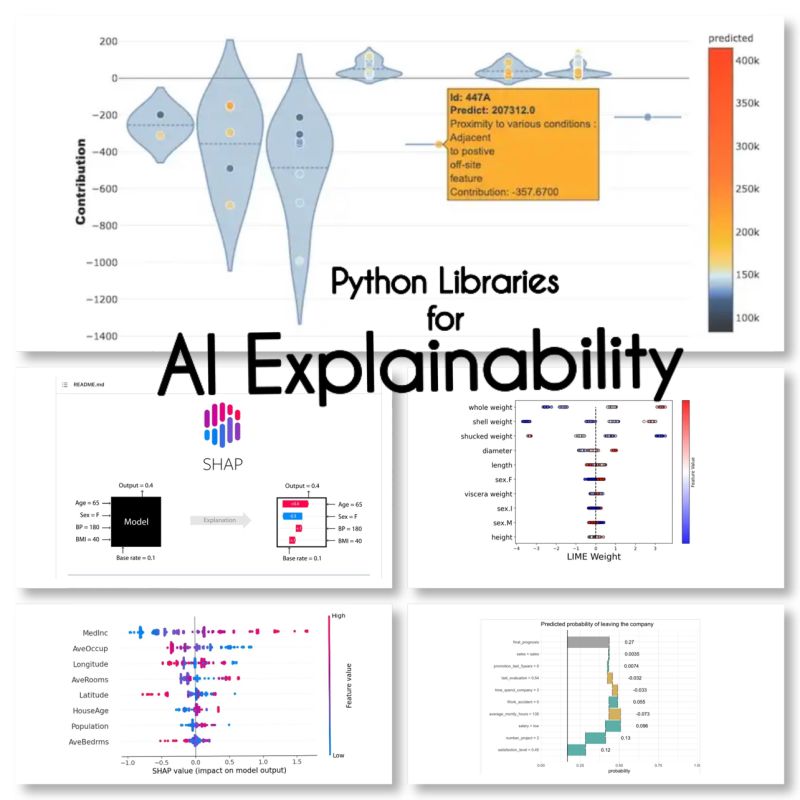

AI の説明可能性のために、次の 10 個の Python ライブラリを見つけました。

SHAP (SHApley Additive exPlanations)

SHAP はモデルにとらわれず、各機能の寄与を分類し、各機能にスコアを割り当てることによって機能します。

LIME (ローカルで解釈可能なモデルに依存しない説明)

LIME は、モデルの動作を特定の予測の周囲で局所的に近似することによって機能する、モデルに依存しないもう XNUMX つの方法です。

ELi5

Eli5 は、分類器をデバッグおよび説明するためのライブラリです。 機能の重要度スコアと、scikit-learn、Keras、xgboost、LightGBM、CatBoost の「理由コード」を提供します。

シャプシュ

Shapash は、機械学習を誰にとっても解釈可能で理解しやすいものにすることを目的とした Python ライブラリです。 Shapash は、明示的なラベルを使用していくつかのタイプの視覚化を提供します。

アンカー

アンカーは、機械学習モデルの予測を説明するために使用できる、人間が解釈できるルールを生成する方法です。

XAI(説明可能なAI)

XAI は、特徴重要度スコアを含む機械学習モデルの予測を説明および視覚化するためのライブラリです。

壊す

BreakDown は、線形モデルの予測を説明するために使用できるツールです。 モデルの出力を各入力機能の寄与に分解することによって機能します。

解釈テキスト

interpret-text は、自然言語処理モデルの予測を説明するためのライブラリです。

iml (解釈可能な機械学習)

iml には現在、Shap プロジェクトのインターフェイスと IO コードが含まれており、Lime プロジェクトでも同じことが行われる可能性があります。

aix360 (AI 説明可能性 360)

aix360 には、さまざまな次元をカバーする包括的な一連のアルゴリズムが含まれています

オムニザイ

OmniXAI (Omni eXplainable AI の略) は、実際に機械学習モデルによって生成された判断を解釈する際のいくつかの問題に対処します。

ライブラリを忘れましたか?

ソース

マリアム・ミラディ 機械学習と深層学習の博士号を取得した AI とデータ サイエンスのリーダーであり、NLP とコンピューター ビジョンを専門としています。 彼女は、成功した AI ソリューションを作成して 15 年以上の経験があり、40 以上の成功したプロジェクトを提供した実績があります。 彼女は、金融犯罪の検出、エネルギー、銀行、小売、電子商取引、政府など、さまざまな業界の 12 の異なる組織で働いてきました。

- SEO を活用したコンテンツと PR 配信。 今日増幅されます。

- Platoblockchain。 Web3メタバースインテリジェンス。 知識の増幅。 こちらからアクセスしてください。

- 情報源: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- アドレス

- 後

- AI

- 目指して

- アルゴリズム

- ことができます

- および

- 別の

- 周りに

- 人工の

- 人工知能

- バンキング

- BEST

- 破壊

- 変化

- 選択する

- クリア

- コード

- 包括的な

- コンピュータ

- Computer Vision

- 含まれています

- 貢献

- カバー

- 作成

- 犯罪

- 現在

- データ

- データサイエンス

- 意思決定

- 決定

- 深いです

- 深い学習

- 配信する

- 異なります

- ダウン

- eコマース

- 各

- 効果

- エネルギー

- エンジニアリング

- 誰も

- 体験

- 説明する

- 説明可能

- 説明可能なAI

- 説明

- 特徴

- ファイナンシャル

- 金融犯罪

- 忘れ

- 発見

- から

- 一般に

- 生成

- 良い

- 政府・公共機関

- HTTPS

- 人間

- 重要性

- in

- 含ま

- 含めて

- 産業

- インテリジェンス

- インタフェース

- IT

- 判断

- KDナゲット

- keras

- ラベル

- 言語

- つながる

- 学習

- ライブラリ

- 図書館

- ライム

- ローカル

- 局部的に

- 機械

- 機械学習

- make

- 方法

- モデル

- 最も

- ナチュラル

- 自然言語

- 自然言語処理

- NLP

- オムニ

- 組織的な

- 特定の

- プラトン

- プラトンデータインテリジェンス

- プラトデータ

- :

- 練習

- 予測

- 予測

- 問題

- 問題

- ラボレーション

- 処理

- 生産された

- プロジェクト

- プロジェクト(実績作品)

- は、大阪で

- Python

- 理由

- 記録

- 結果

- 小売

- ルール

- 同じ

- 科学

- scikit-学ぶ

- セッションに

- いくつかの

- ショート

- ソリューション

- 特化した

- 特定の

- 開始

- まだ

- 成功した

- そのような

- テクニック

- 〜へ

- ツール

- 追跡する

- トレーニング

- わかる

- 理解できる

- つかいます

- 価値観

- 多様

- ビジョン

- 可視化

- which

- 意志

- 働いていました

- 作品

- XGブースト

- 年

- あなたの

- ゼファーネット