AI と従来のコンピューターは、地獄のような組み合わせです。

主な理由は、ハードウェア チップが現在どのようにセットアップされているかです。 従来のフォン ノイマン アーキテクチャに基づいて、チップはメイン プロセッサからメモリ ストレージを分離します。 各計算は悪夢のような月曜日の朝の通勤であり、チップは各コンパートメントから絶えずデータを行き来し、悪名高い「メモリウォールに設立された地域オフィスに加えて、さらにローカルカスタマーサポートを提供できるようになります。」

交通渋滞に巻き込まれたことがある人なら、フラストレーションを知っているでしょう。時間とエネルギーの浪費です。 AI アルゴリズムがますます複雑になるにつれて、問題はますます悪化します。

では、ディープ ニューラル ネットワークに完全に適合する可能性のある、脳に基づいたチップを設計してみませんか?

コンピューティング イン メモリ (CIM) チップの登場です。 その名の通り、これらのチップはメモリの計算と保存を同じサイトで行います。 通勤を忘れて。 このチップは非常に効率的な在宅勤務の代替手段であり、データ トラフィックのボトルネックの問題を解消し、効率の向上とエネルギー消費の削減を約束します。

または理論も同様です。 AI アルゴリズムを実行するほとんどの CIM チップは、完全なハードウェアでタスクを実行するのではなく、チップのシミュレーションを使用してその機能を示す、チップ設計のみに焦点を当てています。 また、チップは複数の異なる AI タスク (画像認識、音声認識) に適応するのに苦労しており、スマートフォンやその他の日常的なデバイスへの統合が制限されています。

今月、 調査 in 自然 CIM をゼロからアップグレードしました。 ニューロモルフィック ハードウェアの専門家であるスタンフォード大学の HS Philip Wong 博士とカリフォルニア大学サンディエゴ校の Gert Cauwenberghs 博士が率いる国際チームは、チップの設計だけに集中するのではなく、テクノロジからアーキテクチャ、ハードウェアを調整するアルゴリズムまで、セットアップ全体を最適化しました。 .

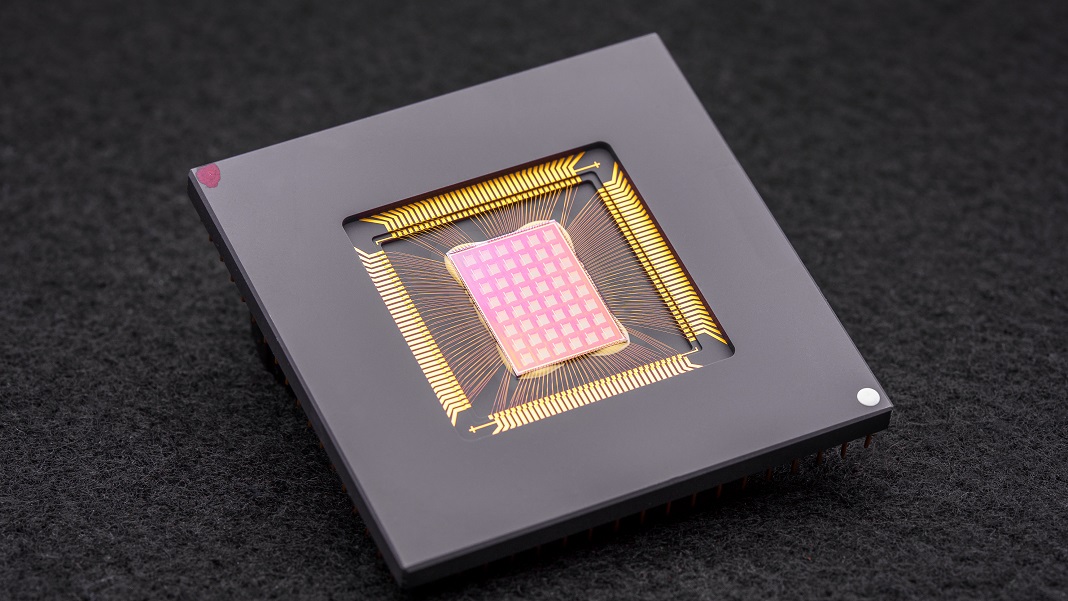

結果として得られる NeuRRAM チップは、48 個の並列コアと 3 万個のメモリ セルを備えた強力なニューロモーフィック コンピューティングの巨人です。 非常に汎用性の高いこのチップは、手書きの数字の読み取り、画像内の車やその他の物体の識別、音声録音の解読など、複数の AI 標準タスクに 84% 以上の精度で取り組みました。

成功率は平凡に見えるかもしれませんが、既存のデジタル チップに匹敵しますが、劇的にエネルギーを節約します。 著者にとっては、計算のためにクラウドにデータを移動する必要がなくなり、AI をデバイスに直接もたらすことに一歩近づいたと言えます。

「クラウドとの間で情報を送受信する代わりに、これらの計算をチップ上で行うことで、より高速、より安全、安価でスケーラブルな AI が将来に向けて実現し、より多くの人々が AI パワーにアクセスできるようになる可能性があります。」 と ウォン

ニューラルインスピレーション

AI専用チップ 今では驚くほどの XNUMX セント硬貨です。 Google の Tensor Processing Unit (TPU) や Tesla の Dojo スーパーコンピューター アーキテクチャから、Baidu や Amazon に至るまで、ハイテク大手は AI チップのゴールド ラッシュに何百万ドルも投資して、ますます洗練されたディープ ラーニング アルゴリズムをサポートするプロセッサを構築しています。 いくつかさえ 機械学習を利用してチップ アーキテクチャを設計する AIソフトウェア向けに調整され、レースを一周させます。

特に興味深い概念の XNUMX つは、脳から直接もたらされます。 データがニューロンを通過すると、シナプスと呼ばれる物理的な「ドック」を介してネットワークに「配線」されます。 小さなキノコのように神経枝の上にあるこれらの構造は、マルチタスカーです。それらは、タンパク質組成の変化を通じて計算とデータの保存の両方を行います。

つまり、ニューロンは、従来のコンピューターとは異なり、メモリから CPU にデータをやり取りする必要がありません。 これにより、脳はデジタル デバイスよりも有利になります。エネルギー効率が高く、複数の計算を同時に実行し、そのすべてが頭蓋骨の中に詰められた XNUMX ポンドのゼリーに詰め込まれています。

脳の側面を再現してみませんか?

入力します ニューロモルフィックコンピューティング. XNUMX つのハックは、RRAM、または抵抗性ランダム アクセス メモリ デバイス (「メモリスタ」とも呼ばれます) を使用することでした。 RRAM は、ハードウェアの抵抗を変更することにより、電源を切ってもメモリを保存します。 シナプスと同様に、これらのコンポーネントを小さな領域に密集した配列に詰め込むことができ、かさばらずに非常に複雑な計算が可能な回路を作成できます。 現在のマイクロプロセッサとチップで回路を構築するための製造プロセスであるCMOSと組み合わせると、デュオ さらにパワフルになる 深層学習アルゴリズムを実行するため。

しかし、それには代償が伴います。 「RRAM-CIM アーキテクチャ内の高並列アナログ計算は優れた効率をもたらしますが、デジタル回路と同じレベルの機能的柔軟性と計算精度を実現することは困難です」と著者は述べています。

最適化魔神

新しい研究では、RRAM-CIM チップのあらゆる部分を掘り下げ、実用化のために再設計しました。

それはテクノロジーから始まります。 NeuRRAM は、CMOS 回路に物理的に織り込まれた RRAM デバイスを使用して、並列計算を行う 48 個のコアを誇っています。 ニューロンのように、使用していないときは各コアを個別にオフにすることができ、そのメモリが RRAM に保存されている間、エネルギーを節約します。

これらの RRAM セル (XNUMX 万個すべて) はリンクされているため、データは双方向に転送できます。 これは重要な設計であり、チップが複数の異なるタイプの AI アルゴリズムに柔軟に適応することを可能にします、と著者は説明しました。 たとえば、深層ニューラル ネットワークの XNUMX つである CNN (畳み込みニューラル ネットワーク) は、コンピューター ビジョンに特に優れていますが、データが一方向に流れる必要があります。 対照的に、音声認識によく使用されるディープ ニューラル ネットワークの一種である LSTM は、データを繰り返し処理して信号を時間と一致させます。 シナプスと同様に、チップは RRAM の「ニューロン」が別のニューロンにどれだけ強く接続するかをエンコードします。

このアーキテクチャにより、データ フローを微調整して交通渋滞を最小限に抑えることが可能になりました。 シングルレーンのトラフィックをマルチレーンに拡張するのと同じように、このチップはネットワークの現在の「メモリ」を計算負荷の高い問題から複製し、複数のコアが問題を同時に分析できるようにします。

以前の CIM チップへの最後の修正は、脳のような計算 (多くの場合アナログ) とデジタル処理の間のより強力な橋渡しでした。 ここで、チップは、アナログ計算をデジタル信号に簡単に変換できるニューロン回路を使用しています。 これは、以前の「電力と面積を必要とする」セットアップからのステップアップであると、著者は説明しています。

最適化はうまくいきました。 彼らの理論をテストして、チームは NeuRRAM チップを製造し、さまざまなゲームを実行する Play Station 5 など、さまざまなアルゴリズム用にハードウェアをプログラムするアルゴリズムを開発しました。

多数のベンチマーク テストで、このチップはチャンピオンのように機能しました。 チップ上で XNUMX 層の CNN を実行する NeuRRAM は、一般的な MNIST データベースを使用して手書き数字を認識する際のエラー率が XNUMX% 未満でした。

また、より困難なタスクにも優れていました。 別の一般的なディープ ニューラル ネットワークである LSTM をロードすると、チップは Google の音声コマンド認識に挑戦したとき、約 85% 正確でした。 さらに別の AI アーキテクチャ上で動作するこのチップは、わずか 70 コアを使用してノイズの多い画像を復元し、エラーを約 XNUMX% 削減しました。

だから何?

一言:エネルギー。

ほとんどの AI アルゴリズムはエネルギーを大量に消費します。 NeuRRAM は、以前の最先端の RRAM-CIM チップの半分のエネルギー コストで動作し、ニューロモーフィック コンピューティングによるエネルギー節約の約束をさらに現実のものにしました。

しかし、この研究の傑出した点はその戦略です。 科学者は、チップを設計する際に、複数のタスクの効率、汎用性、および精度のバランスを取る必要があることがよくあります。 すべての計算がハードウェア上で直接行われると、問題はさらに難しくなります。 NeuRRAM は、一度にすべての獣と戦うことが可能であることを示しました。

ここで使用される戦略は、次のような他のニューロモーフィック コンピューティング デバイスを最適化するために使用できます。 相変化メモリ技術s、著者は言った。

今のところ、NeuRRAM は概念実証であり、シミュレーションではなく物理チップが意図したとおりに機能することを示しています。 しかし、RRAM をさらにスケーリングし、そのサイズを XNUMX 日で携帯電話に収まるように縮小するなど、改善の余地があります。

「今日は、キーワードの発見や人間の検出などの単純な AI タスクを実行するために使用されているかもしれませんが、明日はまったく異なるユーザー エクスペリエンスを可能にする可能性があります。 リアルタイムのビデオ分析と音声認識をすべて小さなデバイス内で組み合わせることを想像してみてください。」 と 研究著者 Dr. Weier Wan. 「研究者およびエンジニアとしての私の野心は、研究室からの研究革新を実用化することです。」

画像のクレジット: David Bailot/カリフォルニア大学サンディエゴ校