굿 하트의 법칙 "측정값이 목표가 되면 더 이상 좋은 측정값이 아닙니다."라는 유명한 말이 있습니다. 원래는 경제학에서 나왔지만 측정하기 어렵거나 비용이 많이 드는 목표를 최적화하는 방법을 알아낼 때 OpenAI에서 씨름해야 하는 부분입니다. 몇 가지를 소개해야 하는 경우가 많습니다. 대리 목적 측정하기가 더 쉽거나 저렴하지만 이렇게 할 때 너무 많이 최적화하지 않도록 주의해야 합니다.

예를 들어, 일직선으로하다 인간의 의도와 가치를 지닌 GPT-3과 같은 모델에서 "어떻게 도움이 이것은 응답입니까?" 또는 "어떻게 사실적으로 정확한 이것이 주장입니까?” 이것은 인간이 사물을 주의 깊게 확인해야 하는 복잡한 목표입니다. 이러한 이유로 우리는 이러한 인간의 선호도를 예측하는 모델을 훈련합니다. 보상 모델, 보상 모델의 예측을 프록시 목표로 사용합니다. 그러나 실제 목표가 얼마나 잘 최적화되고 있는지 추적하는 것이 중요합니다.

이 포스트에서 우리는 우리가 이것을 하는 방법 이면에 있는 수학의 일부를 살펴볼 것입니다. 우리는 진정한 목표에 접근할 수 있는 분석하기에 특히 깨끗한 설정에 초점을 맞출 것입니다. 실제로 인간의 선호도 우리가 진정으로 관심을 갖는 것을 측정하는 데 실패할 수 있지만 이 게시물에서는 그 문제를 제쳐두고 있습니다.

$n$의 최고 샘플링

프록시 목표를 최적화할 수 있는 방법은 여러 가지가 있지만 가장 간단한 방법은 최고의 $n$ 샘플링, 또한 ~으로 알려진 거부 샘플링 or 순위 재지정. 우리는 단순히 $n$ 번 샘플링하고 프록시 목표에 따라 가장 높은 점수를 받은 것을 선택합니다.

이 방법은 매우 간단하지만 실제로는 추론 시간 계산 비용이 더 많이 들기는 하지만 실제로 강화 학습과 같은 고급 기술과 경쟁할 수 있습니다. 예를 들어, 웹GPT, $64$ 중 최고 모델이 강화 학습 모델을 능가했습니다. 아마도 부분적으로는 $64$ 중 최고 모델이 더 많은 웹사이트를 탐색해야 했기 때문일 것입니다. 4달러 중 최고를 적용하더라도 인간의 선호도가 크게 향상되었습니다.

또한, $n$ 중 최고 샘플링은 신뢰할 수 있는 성능을 가지며 수학적으로 분석하기 간단하므로 Goodhart의 법칙 및 관련 현상에 대한 경험적 연구에 매우 적합합니다.

$n$ 중 최고 샘플링의 수학

$n$의 베스트 샘플링을 좀 더 공식적으로 연구해 보겠습니다. 어떤 샘플 공간 $S$(가능한 질문-대답 쌍의 집합과 같은), 어떤 확률 분포 $P$가 있다고 가정합니다. $S$, 진정한 목표(또는 "보상") $R_{text{true}}:Stomathbb R$, 및 대리 목적 $R_{텍스트{프록시}}:Stomathbb R$. 어떻게든 $R_{text{proxy}}$를 최적화하여 새로운 배포판을 얻는다고 가정해 보겠습니다. $P^프라임$. 다음 :

- 기대값 $mathbb E_{x^primesim P^prime}left[R_{text{true}}left(x^primeright)right]$는 실제 목표를 얼마나 잘 최적화했는지 측정합니다.

- XNUMXD덴탈의 KL 발산 $D_{text{KL}}left(P^primeparallel Pright)$는 얼마나 많은 최적화를 수행했는지 측정합니다. 예를 들어, $P^prime$가 일부 하위 집합에 있는 $P$에서 첫 번째 샘플을 취하여 얻은 경우 $S^primesubseteq S$, 그러면 이 KL 발산은 $P$의 샘플이 $S^prime$에 있는 음의 로그 확률입니다.

$n$의 베스트 샘플링의 경우 $P$의 샘플을 사용하여 이 두 수량을 모두 효율적으로 추정할 수 있습니다.

먼저 기대치를 살펴보자. 순진한 접근 방식은 Monte Carlo 추정기를 사용하는 것입니다. $n$ 중 최고 샘플링을 여러 번 실행하고 해당 샘플에서 실제 목표를 측정하고 결과를 평균화합니다. 그러나 더 나은 추정기가 있습니다. 전체 $P$의 $Ngeq n$ 샘플이 있는 경우 동시에 고려할 수 있습니다. 가능한 모든 하위 집합 $n$ 크기의 이러한 샘플 중 프록시 목표에 따라 가장 좋은 하위 집합 수로 각 샘플에 가중치를 부여한 다음 가중 평균 실제 목표 점수를 취합니다. 이 가중치는 이항 계수일 뿐입니다. $binom{k-1}{n-1}$, 여기서 $k$는 $1$(최악)에서 $N$(최상)까지 프록시 목표 아래의 샘플 순위입니다. 샘플을 보다 효율적으로 사용할 수 있을 뿐만 아니라 $n$의 다른 값에 대해 샘플을 재사용할 수도 있습니다.

KL 발산의 경우 놀랍게도 이것은 모든 연속 확률 분포 $P$에 대해 작동하는 정확한 공식을 갖는 것으로 밝혀졌습니다(즉, $P$에 점 질량이 없는 한). 답은 순진하게 추측할 수 있습니다. $로그 n$, $n$의 최고는 분포의 상위 $frac 1n$를 가져오는 것과 같은 일을 하기 때문에 대략적으로 정확합니다. 정확한 대답은 다음과 같습니다. $log n-frac{n-1}n$.

이러한 추정기를 함께 사용하면 실제 목표가 프록시 목표에 적용된 최적화의 양에 따라 어떻게 달라지는지 쉽게 분석할 수 있습니다.

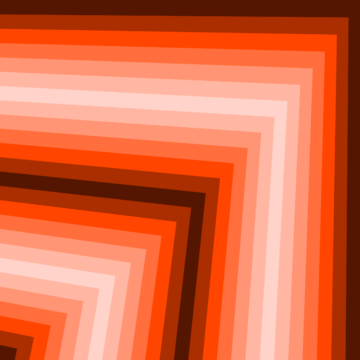

다음은 실제 사례입니다. 웹GPT:

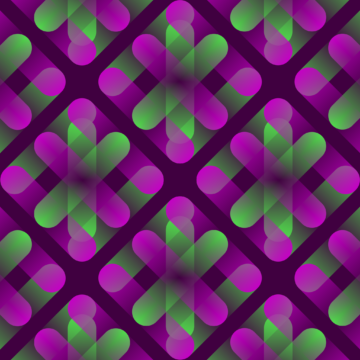

WebGPT 175B를 위한 $n$의 최고 성능

$pm 1$ 표준 오차를 나타내는 음영 영역과 제곱근 척도를 따르는 KL 축이 있는 WebGPT에 대한 $n$의 최고 성능. 여기에서 원래 분포($P$)는 행동 복제를 사용하여 훈련된 175B 모델에 의해 제공되며, $n$ 중 최고($R_{text{proxy}}$)를 계산하는 데 사용되는 프록시 목표는 훈련에 의해 제공됩니다. 보상 모델, 그리고 우리는 세 가지 추정되는 "진정한" 목표($R_{text{true}}$)를 고려합니다: 훈련 보상 모델 자체, 보류된 데이터에 대해 훈련된 검증 보상 모델, 실제 인간 선호. 프록시 목표의 과도한 최적화는 많지 않지만 더 높은 KL에서 있을 것으로 예상됩니다.

$n$의 최고 샘플링 이상

$n$ 중 최고 샘플링의 주요 제한 사항은 KL 발산이 $n$과 함께 대수적으로 증가하므로 소량의 최적화를 적용하는 데에만 적합하다는 것입니다.

더 많은 최적화를 적용하기 위해 일반적으로 강화 학습을 사용합니다. 지금까지 연구한 설정에서 요약, 우리는 일반적으로 약 10의 KL에 도달할 수 있었습니다. 나츠 Goodhart의 법칙으로 인해 실제 목표가 감소하기 시작하기 전에 강화 학습을 사용합니다. 다음을 사용하여 이 KL에 도달하려면 약 60,000달러를 지불해야 합니다. 최고의 $n$, 보상 모델링 및 강화 학습 방식을 개선하여 이보다 훨씬 더 큰 KL에 도달할 수 있기를 바랍니다.

그러나 모든 nat가 동일하지는 않습니다. 경험적으로 작은 KL 예산의 경우 $n$의 최선은 강화 학습보다 프록시와 실제 목표를 더 잘 최적화합니다. 직관적으로 n$의 최선은 "무차별 대입" 접근 방식으로 강화 학습보다 정보 이론상 더 효율적이지만 대규모 KL에서는 계산 효율성이 떨어집니다.

우리는 작업의 일환으로 프록시 목표의 확장 속성을 적극적으로 연구하고 있습니다. 일직선으로하다 인간의 의도와 가치를 지닌 우리의 모델. 이 연구에 도움이 되셨다면 채용!