Afbeelding door auteur

XAI is kunstmatige intelligentie waarmee mensen de resultaten en besluitvormingsprocessen van het model of systeem kunnen begrijpen.

Pre-modellering Explainability

Explainable AI begint met verklaarbare data en duidelijke, interpreteerbare feature engineering.

Modellering van uitlegbaarheid

Bij het kiezen van een model voor een bepaald probleem is het over het algemeen het beste om het meest interpreteerbare model te gebruiken dat nog steeds goede voorspellende resultaten oplevert.

Uitlegbaarheid na het model

Dit omvat technieken zoals perturbatie, waarbij het effect van het veranderen van een enkele variabele op de uitvoer van het model wordt geanalyseerd, zoals SHAP-waarden voor na de training.

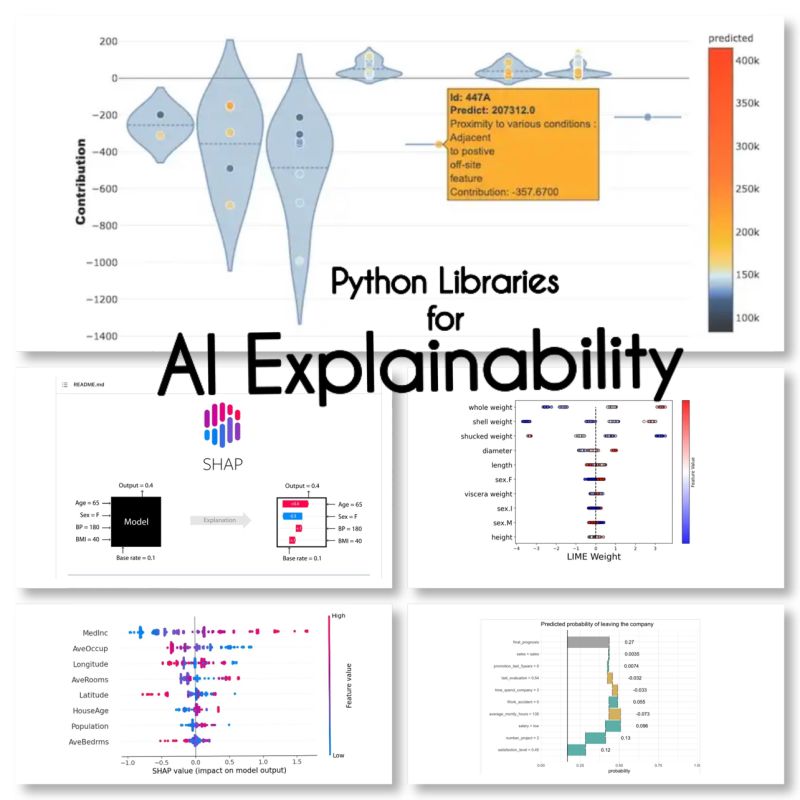

Ik vond deze 10 Python-bibliotheken voor de uitlegbaarheid van AI:

SHAP (uitleg over SHapley-additieven)

SHAP is een model-agnostisch model en werkt door de bijdrage van elke functie op te splitsen en een score toe te kennen aan elke functie.

LIME (lokaal interpreteerbare model-agnostische verklaringen)

LIME is een andere model-agnostische methode die werkt door het gedrag van het model lokaal te benaderen rond een specifieke voorspelling.

ELi5

Eli5 is een bibliotheek voor het debuggen en uitleggen van classifiers. Het biedt functie-belangrijkheidsscores, evenals "redencodes" voor scikit-learn, Keras, xgboost, LightGBM, CatBoost.

Sjapas

Shapash is een Python-bibliotheek die tot doel heeft machine learning voor iedereen interpreteerbaar en begrijpelijk te maken. Shapash biedt verschillende soorten visualisaties met expliciete labels.

Ankers

Anchors is een methode voor het genereren van door mensen interpreteerbare regels die kunnen worden gebruikt om de voorspellingen van een machine learning-model uit te leggen.

XAI (verklaarbare AI)

XAI is een bibliotheek voor het uitleggen en visualiseren van de voorspellingen van machine learning-modellen, inclusief belangrijkheidsscores.

Afbreken

BreakDown is een tool die gebruikt kan worden om de voorspellingen van lineaire modellen te verklaren. Het werkt door de uitvoer van het model te ontleden in de bijdrage van elk invoerkenmerk.

interpreteren-tekst

interpret-text is een bibliotheek voor het verklaren van de voorspellingen van natuurlijke taalverwerkingsmodellen.

iml (interpretabel machinaal leren)

iml bevat momenteel de interface en IO-code van het Shap-project en zal mogelijk hetzelfde doen voor het Lime-project.

aix360 (AI Uitlegbaarheid 360)

aix360 bevat een uitgebreide set algoritmen die verschillende dimensies dekken

OmniXAI

OmniXAI (afkorting van Omni eXplainable AI), pakt verschillende problemen aan met het interpreteren van oordelen die worden geproduceerd door machine learning-modellen in de praktijk.

Ben ik nog bibliotheken vergeten?

bronnen

Maryam Miradi is een AI en Data Science Lead met een PhD in Machine Learning en Deep learning, gespecialiseerd in NLP en Computer Vision. Ze heeft meer dan 15 jaar ervaring met het creëren van succesvolle AI-oplossingen en heeft meer dan 40 succesvolle projecten opgeleverd. Ze heeft voor 12 verschillende organisaties in verschillende sectoren gewerkt, waaronder Detecting Financial Crime, Energy, Banking, Retail, E-commerce en Government.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- adressen

- Na

- AI

- wil

- algoritmen

- toestaat

- en

- Nog een

- rond

- kunstmatig

- kunstmatige intelligentie

- Bankieren

- BEST

- Breaking

- veranderende

- het kiezen van

- duidelijk

- code

- uitgebreid

- computer

- Computer visie

- bevat

- bijdrage

- deksel

- Wij creëren

- Misdrijf

- Op dit moment

- gegevens

- data science

- Besluitvorming

- beslissingen

- deep

- diepgaand leren

- het leveren van

- anders

- beneden

- e-commerce

- elk

- effect

- energie-niveau

- Engineering

- iedereen

- ervaring

- Verklaren

- Uitlegbaarheid

- Uitleg over AI

- uitleggen

- Kenmerk

- financieel

- financiële misdaad

- vergeten

- gevonden

- oppompen van

- algemeen

- het genereren van

- goed

- Overheid

- HTTPS

- Mensen

- belang

- in

- omvat

- Inclusief

- industrieën

- invoer

- Intelligentie

- Interface

- IT

- oordelen

- KDnuggets

- Keras

- labels

- taal

- leiden

- leren

- bibliotheken

- Bibliotheek

- Limoen

- lokaal

- plaatselijk

- machine

- machine learning

- maken

- methode

- model

- modellen

- meest

- Naturel

- Natuurlijke taal

- Natural Language Processing

- nlp

- Omni

- Organisaties

- bijzonder

- Plato

- Plato gegevensintelligentie

- PlatoData

- mogelijk

- praktijk

- voorspelling

- Voorspellingen

- probleem

- problemen

- processen

- verwerking

- geproduceerd

- project

- projecten

- biedt

- Python

- reden

- record

- Resultaten

- <HR>Retail

- reglement

- dezelfde

- Wetenschap

- scikit-leren

- reeks

- verscheidene

- Bermuda's

- single

- Oplossingen

- gespecialiseerde

- specifiek

- starts

- Still

- geslaagd

- dergelijk

- system

- technieken

- De

- naar

- tools

- spoor

- Trainingen

- types

- begrijpen

- begrijpelijk

- .

- Values

- variëteit

- visie

- visualisatie

- welke

- wil

- werkte

- Bedrijven

- XGBoost

- jaar

- Your

- zephyrnet