Begrijpen hoe het brein ruimtelijke informatie organiseert en toegang heeft - waar we zijn, wat er om de hoek is, hoe er te komen - blijft een prachtige uitdaging. Het proces omvat het oproepen van een heel netwerk van herinneringen en opgeslagen ruimtelijke gegevens van tientallen miljarden neuronen, elk verbonden met duizenden andere. Neurowetenschappers hebben belangrijke elementen geïdentificeerd zoals: rastercellen, neuronen die locaties in kaart brengen. Maar dieper gaan zal lastig zijn: het is niet zo dat onderzoekers plakjes menselijke grijze materie kunnen verwijderen en bestuderen om te zien hoe locatiegebaseerde herinneringen aan beelden, geluiden en geuren door elkaar stromen en met elkaar in contact komen.

Kunstmatige intelligentie biedt een andere manier om binnen te komen. Jarenlang hebben neurowetenschappers vele soorten neurale netwerken gebruikt - de motoren die de meeste deep learning-toepassingen aandrijven - om het afvuren van neuronen in de hersenen te modelleren. In recent werk hebben onderzoekers aangetoond dat de hippocampus, een hersenstructuur die cruciaal is voor het geheugen, in feite een speciaal soort neuraal netwerk is, bekend als een transformator, in vermomming. Hun nieuwe model volgt ruimtelijke informatie op een manier die parallel loopt met de innerlijke werking van de hersenen. Ze hebben opmerkelijk succes gezien.

"Het feit dat we weten dat deze modellen van de hersenen equivalent zijn aan de transformator, betekent dat onze modellen veel beter presteren en gemakkelijker te trainen zijn," zei James Whittington, een cognitief neurowetenschapper die zijn tijd verdeelt tussen Stanford University en het laboratorium van Tim Behrens aan de Universiteit van Oxford.

Studies door Whittington en anderen wijzen erop dat transformatoren het vermogen van neurale netwerkmodellen om de soorten berekeningen die worden uitgevoerd door rastercellen en andere delen van de hersenen, aanzienlijk kunnen verbeteren. Dergelijke modellen zouden ons begrip kunnen vergroten van hoe kunstmatige neurale netwerken werken en, nog waarschijnlijker, hoe berekeningen in de hersenen worden uitgevoerd, zei Whittington.

"We proberen de hersenen niet opnieuw te creëren", zei David Ha, een computerwetenschapper bij Google Brain die ook werkt aan transformatormodellen. "Maar kunnen we een mechanisme creëren dat kan doen wat de hersenen doen?"

Transformers verscheen vijf jaar geleden voor het eerst als een nieuwe manier voor AI om taal te verwerken. Ze zijn de geheime saus in die headline-grijpende zin-aanvullende programma's zoals BERT en GPT-3, dat overtuigende songteksten kan genereren, Shakespeare-sonnetten kan componeren en zich kan voordoen als vertegenwoordigers van de klantenservice.

Transformers werken met behulp van een mechanisme dat zelfaandacht wordt genoemd, waarbij elke invoer - een woord, een pixel, een getal in een reeks - altijd is verbonden met elke andere invoer. (Andere neurale netwerken verbinden ingangen alleen met bepaalde andere ingangen.) Maar hoewel transformatoren zijn ontworpen voor taaltaken, hebben ze sindsdien uitgeblonken in andere taken, zoals het classificeren van afbeeldingen - en nu, het modelleren van de hersenen.

In 2020 heeft een groep onder leiding van Sepp Hochreiter, een computerwetenschapper aan de Johannes Kepler University Linz in Oostenrijk, gebruikte een transformator om een krachtig, al lang bestaand model voor het ophalen van herinneringen, een Hopfield-netwerk genaamd, opnieuw te ontwikkelen. Deze netwerken werden 40 jaar geleden voor het eerst geïntroduceerd door de natuurkundige John Hopfield van Princeton. Ze volgen een algemene regel: neuronen die tegelijkertijd actief zijn, bouwen sterke verbindingen met elkaar op.

Hochreiter en zijn medewerkers merkten op dat onderzoekers op zoek waren naar betere modellen voor het ophalen van herinneringen, en zagen een verband tussen hoe Hopfield-netwerken herinneringen ophalen en hoe transformatoren aandacht uitoefenen. Ze hebben het Hopfield-netwerk geüpgraded en er in wezen een transformator van gemaakt. Door die verandering kon het model meer herinneringen opslaan en ophalen vanwege effectievere verbindingen, zei Whittington. Hopfield zelf bewees samen met Dmitry Krotov van het MIT-IBM Watson AI Lab dat een op transformatoren gebaseerd Hopfield-netwerk biologisch aannemelijk was.

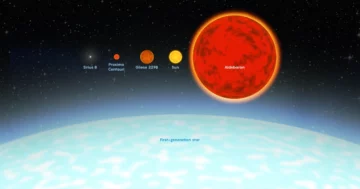

Vervolgens eerder dit jaar, Whittington en Behrens hielpen de benadering van Hochreiter verder aan te passen door de transformator zo aan te passen dat herinneringen niet als een lineaire reeks werden behandeld - zoals een reeks woorden in een zin - maar ze codeerde als coördinaten in hoger-dimensionale ruimtes. Die 'draai', zoals de onderzoekers het noemden, verbeterde de prestaties van het model op neurowetenschappelijke taken verder. Ze toonden ook aan dat het model wiskundig equivalent was aan modellen van de rastercelvuurpatronen die neurowetenschappers zien in fMRI-scans.

"Grid-cellen hebben zo'n opwindende, mooie, regelmatige structuur en met opvallende patronen die waarschijnlijk niet willekeurig zullen verschijnen", zegt Caswell Barry, een neurowetenschapper aan het University College London. Het nieuwe werk liet zien hoe transformatoren precies die patronen repliceren die in de hippocampus worden waargenomen. "Ze erkenden dat een transformator kan achterhalen waar hij is gebaseerd op eerdere toestanden en hoe hij wordt verplaatst, en op een manier die is afgestemd op traditionele modellen van rastercellen."

Ander recent werk suggereert dat transformatoren ons begrip van andere hersenfuncties ook zouden kunnen vergroten. Vorig jaar, Martin Schrimpf, een computationele neurowetenschapper aan het Massachusetts Institute of Technology, analyseerde 43 verschillende neurale netmodellen om te zien hoe goed ze metingen van menselijke neurale activiteit voorspelden, zoals gerapporteerd door fMRI en elektrocorticografie. Transformers, ontdekte hij, zijn de huidige toonaangevende, state-of-the-art neurale netwerken, die bijna alle variaties in de beeldvorming voorspellen.

En Ha, samen met collega-computerwetenschapper Yujin Tang, heeft onlangs een model ontworpen dat opzettelijk grote hoeveelheden gegevens door een transformator kan sturen op een willekeurige, ongeordende manier, waarbij wordt nagebootst hoe het menselijk lichaam zintuiglijke waarnemingen naar de hersenen verzendt. Hun transformator kon, net als onze hersenen, met succes een ongeordende informatiestroom aan.

"Neurale netten zijn bedraad om een bepaalde invoer te accepteren", zei Tang. Maar in het echte leven veranderen datasets vaak snel en kan de meeste AI zich niet aanpassen. “We wilden experimenteren met een architectuur die zich heel snel kon aanpassen.”

Ondanks deze tekenen van vooruitgang beschouwt Behrens transformatoren als slechts een stap in de richting van een nauwkeurig model van de hersenen - niet het einde van de zoektocht. 'Ik moet hier een sceptische neurowetenschapper zijn,' zei hij. "Ik denk niet dat transformatoren uiteindelijk zullen zijn hoe we bijvoorbeeld over taal in de hersenen denken, ook al hebben ze het beste huidige model van zinnen."

“Is dit de meest efficiënte basis om voorspellingen te doen over waar ik ben en wat ik hierna zal zien? Als ik eerlijk ben, is het te vroeg om te zeggen', zei Barry.

Ook Schrimpf merkte op dat zelfs de best presterende transformatoren beperkt zijn, goed werken voor bijvoorbeeld woorden en korte zinnen, maar niet voor grotere taaltaken zoals het vertellen van verhalen.

"Mijn gevoel is dat deze architectuur, deze transformator, je in de juiste ruimte plaatst om de structuur van de hersenen te begrijpen, en kan worden verbeterd met training", zei Schrimpf. "Dit is een goede richting, maar het veld is supercomplex."