Als het gaat om hersencomputers, is timing alles. Het is hoe neuronen zich in circuits aansluiten. Het is de manier waarop deze circuits zeer complexe gegevens verwerken, wat leidt tot acties die leven of dood kunnen betekenen. Het is de manier waarop onze hersenen in een fractie van een seconde beslissingen kunnen nemen, zelfs als ze met geheel nieuwe omstandigheden worden geconfronteerd. En dat doen we zonder de hersenen te beschadigen door het omvangrijke energieverbruik.

Om het anders te formuleren: de hersenen vormen een uitstekend voorbeeld van een uiterst krachtige computer om na te bootsen – en computerwetenschappers en -ingenieurs hebben de eerste stappen gezet om dit te doen. Het vakgebied van neuromorfisch computergebruik probeert de architectuur en het gegevensverwerkingsvermogen van de hersenen te herscheppen met nieuwe hardwarechips en software-algoritmen. Het kan een weg naar de waarheid zijn kunstmatige intelligentie.

Maar één cruciaal element ontbreekt. De meeste algoritmen die neuromorfe chips aandrijven, geven alleen om de bijdrage van elk kunstmatig neuron, dat wil zeggen, hoe sterk ze met elkaar verbonden zijn, ook wel ‘synaptisch gewicht’ genoemd. Wat ontbreekt – maar toch neerkomt op de innerlijke werking van onze hersenen – is timing.

Deze maand voegde een team verbonden aan het Human Brain Project, het vlaggenschip van de Europese Unie op het gebied van de big data-neurowetenschappen, hieraan toe het element tijd naar een neuromorf algoritme. De resultaten werden vervolgens geïmplementeerd op fysieke hardware: de HersenschaalS-2 neuromorfisch platform – en tegenover de modernste GPU’s en conventionele neuromorfe oplossingen.

“Vergeleken met de abstracte neurale netwerken die worden gebruikt bij deep learning, blijven de meer biologische archetypen … nog steeds achter in termen van prestaties en schaalbaarheid” vanwege hun inherente complexiteit, aldus de auteurs.

In verschillende tests vergeleek het algoritme “gunstig, in termen van nauwkeurigheid, latentie en energie-efficiëntie” met een standaard benchmarktest, zei Dr. Charlotte Frenkel van de Universiteit van Zürich en ETH Zürich in Zwitserland, die niet bij het onderzoek betrokken was. Door een temporele component toe te voegen aan neuromorfisch computergebruik kunnen we een nieuw tijdperk van uiterst efficiënte AI inluiden, dat zich verplaatst van statische gegevenstaken (bijvoorbeeld beeldherkenning) naar taken die de tijd beter inkapselen. Denk aan video's, biosignalen of spraak van brein naar computer.

Volgens hoofdauteur Dr. Mihai Petrovici gaat het potentieel beide kanten op. “Ons werk is niet alleen interessant voor neuromorfisch computergebruik en biologisch geïnspireerde hardware. Het erkent ook de vraag … om zogenaamde deep learning-benaderingen over te dragen naar de neurowetenschappen en daardoor de geheimen van het menselijk brein verder te onthullen”, zegt hij. zei.

Laten we over Spikes praten

Aan de basis van het nieuwe algoritme ligt een fundamenteel principe in hersencomputers: pieken.

Laten we eens kijken naar een zeer geabstraheerd neuron. Het lijkt op een tootsie-rol, met een bolvormig middengedeelte geflankeerd door twee naar buiten reikende wikkels. De ene kant is de input: een ingewikkelde boom die signalen ontvangt van een eerder neuron. De andere is de output, waarbij signalen naar andere neuronen worden gestuurd met behulp van belachtige schepen gevuld met chemicaliën, die op hun beurt een elektrische reactie aan de ontvangende kant veroorzaken.

Hier is de crux: om deze hele reeks te laten plaatsvinden, moet het neuron ‘pieken’. Als, en alleen als, het neuron een voldoende hoog inputniveau ontvangt – een mooi ingebouwd mechanisme voor ruisonderdrukking – zal het bolvormige deel een piek genereren die door de uitgangskanalen loopt om het volgende neuron te waarschuwen.

Maar neuronen gebruiken niet slechts één piek om informatie over te brengen. Integendeel, ze pieken in een tijdsreeks. Zie het als Morsecode: de timing van een elektrische uitbarsting bevat een schat aan gegevens. Het is de basis voor de bedrading van neuronen in circuits en hiërarchieën, waardoor zeer energie-efficiënte verwerking mogelijk is.

Dus waarom zouden we niet dezelfde strategie volgen voor neuromorfe computers?

Een Spartaanse hersenachtige chip

In plaats van de pieken van een enkel kunstneuron in kaart te brengen – een enorme taak – concentreerde het team zich op één enkele maatstaf: hoe lang het duurt voordat een neuron vuurt.

Het idee achter de ‘time-to-first-spike’-code is eenvoudig: hoe langer het duurt voordat een neuron piekt, hoe lager het activiteitsniveau ervan. Vergeleken met het tellen van pieken is het een uiterst schaarse manier om de activiteit van een neuron te coderen, maar het heeft voordelen. Omdat alleen de latentie tot de eerste keer dat een neuron opfleurt, wordt gebruikt om de activering te coderen, wordt de reactiesnelheid van het neuron vastgelegd zonder een computer met te veel datapunten te overweldigen. Met andere woorden: het is snel, energiezuinig en gemakkelijk.

Het team codeerde het algoritme vervolgens op een neuromorfe chip: de HersenschaalS-2, dat grofweg eenvoudige ‘neuronen’ binnen zijn structuur emuleert, maar draait ruim 1,000 keer sneller dan onze biologische hersenen. Het platform beschikt over meer dan 500 fysieke kunstmatige neuronen, die elk 256 inputs kunnen ontvangen via configureerbare synapsen, waar biologische neuronen informatie uitwisselen, verwerken en opslaan.

De opzet is hybride. “Leren” wordt bereikt op een chip die het tijdsafhankelijke algoritme implementeert. Elke update van het neurale circuit – dat wil zeggen: hoe sterk het ene neuron met het andere verbonden is – wordt echter bereikt via een extern werkstation, iets dat ‘in-the-loop training’ wordt genoemd.

In een eerste test werd het algoritme uitgedaagd met de ‘Yin-Yang’-taak, waarbij het algoritme verschillende gebieden in het traditionele oosterse symbool moet ontleden. Het algoritme blonk uit, met een nauwkeurigheid van gemiddeld 95 procent.

Het team daagde vervolgens de opstelling uit met een klassieke deep learning-taak:MNIST, een dataset van handgeschreven cijfers die een revolutie teweegbracht in de computervisie. Het algoritme blonk opnieuw uit, met een nauwkeurigheid van bijna 97 procent. Nog indrukwekkender was dat het BrainScaleS-2-systeem minder dan een seconde nodig had om 10,000 testmonsters te classificeren, met een extreem laag relatief energieverbruik.

Door deze resultaten in context te plaatsen, vergeleek het team vervolgens de prestaties van BrainScaleS-2 – gewapend met het nieuwe algoritme – met commerciële en andere neuromorfe platforms. Nemen Spinnaker, een enorme, parallel gedistribueerde architectuur die ook neuraal computergebruik en pieken nabootst. Het nieuwe algoritme was meer dan 100 keer sneller bij beeldherkenning, terwijl het slechts een fractie van de stroom verbruikte die SpinNNaker verbruikt. Soortgelijke resultaten werden gezien met True North, de neuromorfe chip van IBM.

Wat nu?

De twee meest waardevolle computerfuncties van de hersenen – energie-efficiëntie en parallelle verwerking – vormen nu een grote inspiratiebron voor de volgende generatie computerchips. Het doel? Bouw machines die net zo flexibel en adaptief zijn als onze eigen hersenen, terwijl ze slechts een fractie van de energie gebruiken die nodig is voor onze huidige op silicium gebaseerde chips.

Maar vergeleken met deep learning, dat afhankelijk is van kunstmatige neurale netwerken, zijn biologisch plausibele netwerken weggekwijnd. Een deel hiervan, legde Frenkel uit, is de moeilijkheid om deze circuits door middel van leren te ‘updaten’. Met BrainScaleS-2 en een vleugje timinggegevens is het nu echter mogelijk.

Tegelijkertijd geeft het hebben van een “externe” arbiter voor het bijwerken van synaptische verbindingen het hele systeem wat tijd om te ademen. Neuromorfe hardware, vergelijkbaar met de rommeligheid van onze hersenberekeningen, is bezaaid met mismatches en fouten. Met de chip en een externe scheidsrechter kan het hele systeem leren zich aan deze variabiliteit aan te passen, en uiteindelijk de eigenaardigheden ervan compenseren – of zelfs exploiteren – voor sneller en flexibeler leren.

Voor Frenkel ligt de kracht van het algoritme in zijn schaarsheid. De hersenen, zo legde ze uit, worden aangedreven door schaarse codes die “de snelle reactietijden zouden kunnen verklaren… zoals voor visuele verwerking.” In plaats van hele hersengebieden te activeren, zijn er slechts een paar neurale netwerken nodig, zoals over lege snelwegen zoeven in plaats van vast te zitten in het spitsuur.

Ondanks zijn kracht kent het algoritme nog steeds haperingen. Het heeft moeite met het interpreteren van statische gegevens, hoewel het uitblinkt in tijdreeksen, bijvoorbeeld spraak of biosignalen. Maar voor Frenkel is dit het begin van een nieuw raamwerk: belangrijke informatie kan worden gecodeerd met een flexibele maar eenvoudige metriek, en gegeneraliseerd om de op hersenen en AI gebaseerde gegevensverwerking te verrijken met een fractie van de traditionele energiekosten.

“[Het]…kan een belangrijke opstap zijn voor het uitbreiden van neuromorfe hardware om eindelijk een concurrentievoordeel ten opzichte van conventionele neurale netwerkbenaderingen aan te tonen,” zei ze.

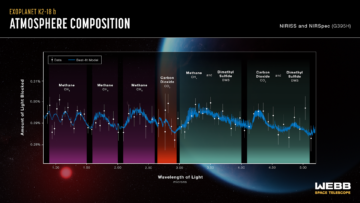

Image Credit: Classificatie van datapunten in de Yin-Yang-dataset, door Göltz en Kriener et al. (Heidelberg / Bern)

- 000

- 100

- Voordeel

- AI

- algoritme

- algoritmen

- Het toestaan

- architectuur

- kunstmatige neurale netwerken

- auteurs

- criterium

- Big data

- hersenen

- bouw

- verzorging

- kanalen

- chemicaliën

- spaander

- chips

- code

- commercieel

- bestanddeel

- Computer visie

- computers

- computergebruik

- aansluitingen

- consumptie

- Kosten

- Credits

- Actueel

- gegevens

- gegevensverwerking

- diepgaand leren

- Vraag

- oostelijk

- doeltreffendheid

- energie-niveau

- Ingenieurs

- ETH

- ETH Zurich

- Nederlands

- SNELLE

- Tot slot

- Brand

- Voornaam*

- eerste keer

- Achtergrond

- GPU's

- Hardware

- Hoge

- snelwegen

- Hoe

- HTTPS

- Hybride

- IBM

- idee

- beeld

- Beeldherkenning

- informatie

- betrokken zijn

- IT

- leiden

- leidend

- LEARN

- leren

- Niveau

- lang

- Machines

- beweegt

- netwerk

- netwerken

- Neural

- neuraal netwerk

- neurale netwerken

- Neurowetenschap leerprogramma

- Geluid

- noorden

- nummers

- Overige

- prestatie

- Fysiek

- platform

- platforms

- energie

- project

- reactie

- antwoord

- Resultaten

- Rollen

- haast

- wetenschappers

- schepen

- Eenvoudig

- So

- Software

- Oplossingen

- begin

- shop

- Strategie

- Studie

- Zwitserland

- system

- proef

- testen

- niet de tijd of

- verkeer

- Trainingen

- universiteit-

- updates

- Video's

- visie

- Rijkdom

- WIE

- Wikipedia

- Draad

- woorden

- Mijn werk

- Zurich