AI en conventionele computers zijn een match made in hell.

De belangrijkste reden is hoe hardwarechips momenteel zijn ingesteld. Gebaseerd op de traditionele Von Neumann-architectuur, isoleert de chip de geheugenopslag van de hoofdprocessors. Elke berekening is een nachtmerrie op maandagochtend, waarbij de chip constant gegevens heen en weer pendelt vanuit elk compartiment, wat een beruchte "geheugen muur. '

Als je ooit in het verkeer hebt gestaan, ken je de frustratie: het kost tijd en verspilde energie. Naarmate AI-algoritmen steeds complexer worden, wordt het probleem steeds erger.

Dus waarom geen chip ontwerpen op basis van de hersenen, een potentiële perfecte match voor diepe neurale netwerken?

Voer compute-in-memory of CIM-chips in. Trouw aan hun naam, deze chips berekenen en slaan geheugen op dezelfde site op. Vergeet woon-werkverkeer; de chips zijn zeer efficiënte thuiswerkalternatieven, die het knelpunt van het dataverkeer wegnemen en een hogere efficiëntie en een lager energieverbruik beloven.

Of zo gaat de theorie. De meeste CIM-chips met AI-algoritmen hebben zich uitsluitend gericht op chipontwerp en demonstreren hun mogelijkheden met behulp van simulaties van de chip in plaats van taken op volwaardige hardware uit te voeren. De chips hebben ook moeite om zich aan te passen aan meerdere verschillende AI-taken - beeldherkenning, spraakperceptie - waardoor hun integratie in smartphones of andere alledaagse apparaten wordt beperkt.

Deze maand, Een studie in NATUUR geüpgraded CIM van de grond af. In plaats van zich alleen te concentreren op het ontwerp van de chip, optimaliseerde het internationale team - onder leiding van neuromorfische hardware-experts Dr. HS Philip Wong van Stanford en Dr. Gert Cauwenberghs van UC San Diego - de hele installatie, van technologie tot architectuur tot algoritmen die de hardware kalibreren .

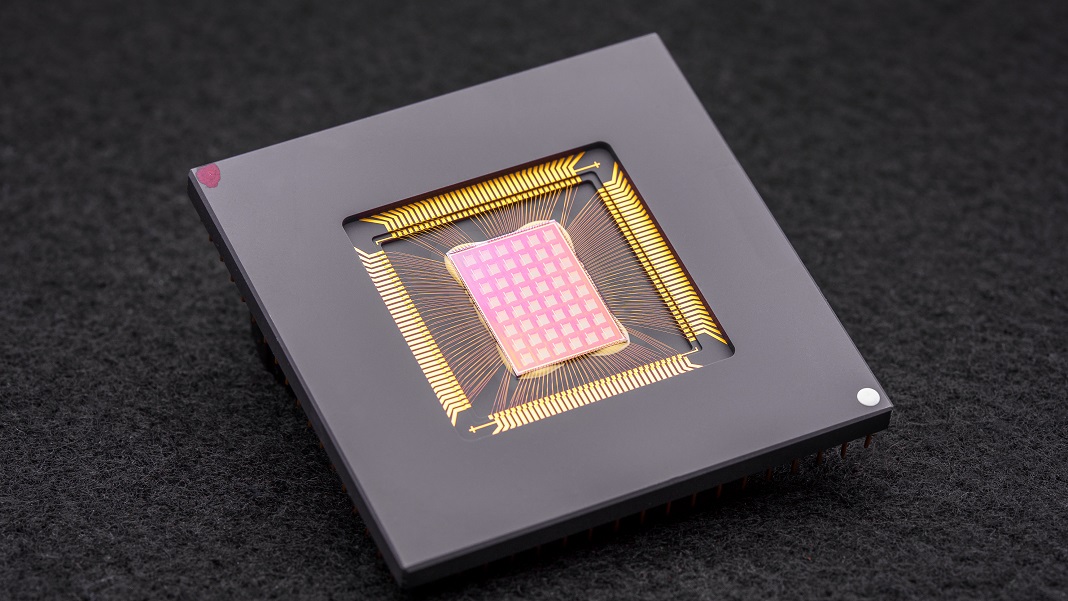

De resulterende NeuRRAM-chip is een krachtige neuromorfe rekenkolos met 48 parallelle kernen en 3 miljoen geheugencellen. De zeer veelzijdige chip kon meerdere standaard AI-taken aan, zoals het lezen van handgeschreven nummers, het identificeren van auto's en andere objecten in afbeeldingen en het decoderen van spraakopnamen, met een nauwkeurigheid van meer dan 84 procent.

Hoewel het slagingspercentage middelmatig lijkt, concurreert het met bestaande digitale chips, maar bespaart het enorm veel energie. Voor de auteurs is het een stap dichter bij het rechtstreeks naar onze apparaten brengen van AI in plaats van gegevens naar de cloud te hoeven pendelen voor berekening.

"Als die berekeningen op de chip worden uitgevoerd in plaats van informatie van en naar de cloud te sturen, kan AI in de toekomst sneller, veiliger, goedkoper en beter schaalbaar worden en krijgen meer mensen toegang tot AI-kracht." zei Wong.

Neurale inspiratie

AI-specifieke chips zijn nu een verbazingwekkende dertien in een dozijn. Van Google's Tensor Processing Unit (TPU) en Tesla's Dojo-supercomputerarchitectuur tot Baidu en Amazon, technische giganten investeren miljoenen in de goudkoorts van AI-chips om processors te bouwen die steeds geavanceerdere deep learning-algoritmen ondersteunen. sommige zelfs maak gebruik van machine learning om chiparchitecturen te ontwerpen op maat gemaakt voor AI-software, waardoor de race rond is.

Een bijzonder intrigerend concept komt rechtstreeks uit de hersenen. Terwijl gegevens door onze neuronen gaan, "verbinden" ze zich met netwerken via fysieke "docks" die synapsen worden genoemd. Deze structuren, die als kleine paddenstoelen bovenop neurale takken zitten, zijn multitaskers: ze berekenen en slaan gegevens op door veranderingen in hun eiwitsamenstelling.

Met andere woorden, neuronen hoeven, in tegenstelling tot klassieke computers, geen gegevens van het geheugen naar de CPU's te transporteren. Dit geeft het brein zijn voordeel ten opzichte van digitale apparaten: het is zeer energiezuinig en voert meerdere berekeningen tegelijk uit, allemaal verpakt in een gelei van drie pond die in de schedel is gevuld.

Waarom geen aspecten van de hersenen recreëren?

Enter neuromorfe computers. Een hack was het gebruik van RRAM's, of resistive random-access memory devices (ook wel 'memristors' genoemd). RRAM's slaan geheugen op, zelfs wanneer ze worden uitgeschakeld door de weerstand van hun hardware te veranderen. Net als bij synapsen, kunnen deze componenten worden verpakt in dichte arrays op een klein gebied, waardoor circuits ontstaan die in staat zijn tot zeer complexe berekeningen zonder bulk. In combinatie met CMOS, een fabricageproces voor het bouwen van circuits in onze huidige microprocessors en chips, vormt het duo wordt nog krachtiger voor het uitvoeren van deep learning-algoritmen.

Maar het heeft een prijs. "De zeer parallelle analoge berekening binnen de RRAM-CIM-architectuur zorgt voor superieure efficiëntie, maar maakt het een uitdaging om hetzelfde niveau van functionele flexibiliteit en rekennauwkeurigheid te realiseren als in digitale circuits", aldus de auteurs.

Optimalisatie Genie

De nieuwe studie verdiepte zich in elk onderdeel van een RRAM-CIM-chip en herontworpen voor praktisch gebruik.

Het begint met technologie. NeuRRAM beschikt over 48 cores die parallel rekenen, met RRAM-apparaten fysiek verweven in CMOS-circuits. Net als een neuron kan elke kern afzonderlijk worden uitgeschakeld wanneer deze niet in gebruik is, waardoor energie wordt bespaard terwijl het geheugen wordt opgeslagen op het RRAM.

Deze RRAM-cellen - alle drie miljoen - zijn gekoppeld zodat gegevens in beide richtingen kunnen worden overgedragen. Het is een cruciaal ontwerp, waardoor de chip zich flexibel kan aanpassen aan meerdere verschillende soorten AI-algoritmen, legden de auteurs uit. Eén type diep neuraal netwerk, CNN (convolutioneel neuraal netwerk), is bijvoorbeeld bijzonder goed in computervisie, maar heeft gegevens nodig om in één richting te stromen. Daarentegen verwerken LSTM's, een soort diep neuraal netwerk dat vaak wordt gebruikt voor audioherkenning, herhaaldelijk gegevens om signalen met de tijd te matchen. Net als synapsen codeert de chip hoe sterk het ene RRAM-"neuron" met het andere verbindt.

Deze architectuur maakte het mogelijk om de datastroom te finetunen om files te minimaliseren. Net als het uitbreiden van single-lane-verkeer naar multi-lane, kan de chip het huidige "geheugen" van een netwerk dupliceren van de meeste rekenintensieve problemen, zodat meerdere kernen het probleem tegelijkertijd analyseren.

Een laatste aanpassing aan eerdere CIM-chips was een sterkere brug tussen hersenachtige berekeningen - vaak analoge - en digitale verwerking. Hier gebruikt de chip een neuroncircuit dat analoge berekeningen gemakkelijk kan omzetten in digitale signalen. Het is een stap hoger dan eerdere "power-hongerige en gebied-hongerige" opstellingen, legden de auteurs uit.

De optimalisaties zijn gelukt. Om hun theorie op de proef te stellen, vervaardigde het team de NeuRRAM-chip en ontwikkelde het algoritmen om de hardware te programmeren voor verschillende algoritmen, zoals Play Station 5 met verschillende games.

In een groot aantal benchmarktests presteerde de chip als een kampioen. Met een zevenlaags CNN op de chip, had NeuRRAM minder dan een procent foutenpercentage bij het herkennen van handgeschreven cijfers met behulp van de populaire MNIST-database.

Het blonk ook uit op moeilijkere taken. Bij het laden van een ander populair diep neuraal netwerk, LSTM, was de chip ongeveer 85 procent correct toen hij werd uitgedaagd met Google-spraakopdrachtherkenning. Met slechts acht cores kon de chip, die op nog een andere AI-architectuur draait, beelden met ruis herstellen, waardoor fouten met ongeveer 70 procent werden verminderd.

En dan?

Eén woord: energie.

De meeste AI-algoritmen zijn totale energievreters. NeuRRAM werkte met de helft van de energiekosten van eerdere state-of-the-art RRAM-CIM-chips, waardoor de belofte van energiebesparing met neuromorfisch computergebruik verder wordt omgezet in realiteit.

Maar het opvallende van de studie is de strategie. Bij het ontwerpen van chips moeten wetenschappers maar al te vaak een balans vinden tussen efficiëntie, veelzijdigheid en nauwkeurigheid voor meerdere taken - statistieken die vaak op gespannen voet met elkaar staan. Het probleem wordt nog moeilijker wanneer al het computergebruik rechtstreeks op de hardware wordt gedaan. NeuRRAM liet zien dat het mogelijk is om tegen alle beesten tegelijk te vechten.

De hier gebruikte strategie kan worden gebruikt om andere neuromorfe computerapparatuur te optimaliseren, zoals: phase-change geheugentechnologies, zeiden de auteurs.

Voorlopig is NeuRRAM een proof-of-concept, wat aantoont dat een fysieke chip - in plaats van een simulatie ervan - werkt zoals bedoeld. Maar er is ruimte voor verbetering, waaronder het verder schalen van RRAM's en het verkleinen van de omvang tot het op een dag mogelijk in onze telefoons past.

“Misschien wordt het vandaag gebruikt om eenvoudige AI-taken uit te voeren, zoals het spotten van trefwoorden of menselijke detectie, maar morgen kan het een heel andere gebruikerservaring mogelijk maken. Stelt u zich eens realtime video-analyse in combinatie met spraakherkenning voor, allemaal binnen een klein apparaat”, zei studie auteur Dr. Weier Wan. “Als onderzoeker en ingenieur heb ik de ambitie om onderzoeksinnovaties uit labs in de praktijk te brengen.”

Krediet van het beeld: David Baillot/Universiteit van Californië in San Diego