Bruce Warrington via Unsplash

De reden waarom machine learning-modellen in het algemeen slimmer worden, is vanwege hun afhankelijkheid van het gebruik van gelabelde gegevens om onderscheid te maken tussen twee vergelijkbare objecten.

Zonder deze gelabelde datasets zult u echter grote obstakels tegenkomen bij het creëren van het meest effectieve en betrouwbare machine learning-model. Gelabelde datasets tijdens de trainingsfase van een model zijn belangrijk.

Diep leren wordt veel gebruikt om taken zoals computervisie op te lossen met behulp van begeleid leren. Maar zoals met veel dingen in het leven, komt het met beperkingen. Gesuperviseerde classificatie vereist een hoge kwantiteit en kwaliteit van gelabelde trainingsgegevens om een robuust model te produceren. Dit betekent dat het classificerende model niet overweg kan met ongeziene klassen.

En we weten allemaal hoeveel rekenkracht, herscholing, tijd en geld er nodig is om een deep learning-model te trainen.

Maar kan een model nog onderscheid maken tussen twee objecten zonder gebruik te maken van trainingsgegevens? Ja, dat heet zero-shot learning. Zero-shot learning is het vermogen van een model om een taak te voltooien zonder trainingsvoorbeelden te hebben ontvangen of gebruikt.

Mensen zijn van nature in staat tot zero-shot leren zonder er veel moeite voor te hoeven doen. Onze hersenen slaan al woordenboeken op en stellen ons in staat om objecten te differentiëren door naar hun fysieke eigenschappen te kijken vanwege onze huidige kennisbasis. We kunnen deze kennisbank gebruiken om de overeenkomsten en verschillen tussen objecten te zien en de link ertussen te vinden.

Laten we bijvoorbeeld zeggen dat we proberen een classificatiemodel op diersoorten te bouwen. Volgens OnzeWereldInData, waren er 2.13 miljoen soorten berekend in 2021. Als we dus het meest effectieve classificatiemodel voor diersoorten willen maken, hebben we 2.13 miljoen verschillende klassen nodig. Er zullen ook veel gegevens nodig zijn. Gegevens van hoge kwantiteit en kwaliteit zijn moeilijk te vinden.

Dus hoe lost zero-shot learning dit probleem op?

Omdat zero-shot learning niet vereist dat het model de trainingsgegevens heeft geleerd en hoe klassen moeten worden geclassificeerd, kunnen we minder vertrouwen op de behoefte van het model aan gelabelde gegevens.

Het volgende is waar uw gegevens uit moeten bestaan om door te gaan met zero-shot learning.

Klassen gezien

Deze bestaat uit de gegevensklassen die eerder zijn gebruikt om een model te trainen.

Ongeziene klassen

Dit bestaat uit de gegevensklassen die NIET zijn gebruikt om een model te trainen en het nieuwe zero-shot leermodel zal worden gegeneraliseerd.

Hulpinformatie

Omdat de gegevens in de ongeziene klassen niet zijn gelabeld, heeft zero-shot learning aanvullende informatie nodig om te leren en correlaties, links en eigenschappen te vinden. Dit kan zijn in de vorm van woordinbeddingen, beschrijvingen en semantische informatie.

Zero-shot leermethoden

Zero-shot learning wordt meestal gebruikt in:

- Op classificatie gebaseerde methoden

- Op instanties gebaseerde methoden

stages

Zero-shot learning wordt gebruikt om modellen te bouwen voor klassen die niet trainen met behulp van gelabelde gegevens, daarom zijn deze twee fasen vereist:

1. Opleiding

De trainingsfase is het proces van de leermethode waarbij wordt geprobeerd zoveel mogelijk kennis over de kwaliteiten van de gegevens vast te leggen. We kunnen dit zien als de leerfase.

2. Gevolgtrekking

Tijdens de inferentiefase wordt alle geleerde kennis uit de trainingsfase toegepast en gebruikt om voorbeelden te classificeren in een nieuwe reeks klassen. We kunnen dit zien als de fase van het maken van voorspellingen.

Hoe werkt het?

De kennis van de geziene klassen wordt overgedragen aan de ongeziene klassen in een hoog-dimensionale vectorruimte; dit wordt semantische ruimte genoemd. Bij beeldclassificatie ondergaat de semantische ruimte samen met het beeld bijvoorbeeld twee stappen:

1. Gezamenlijke inbeddingsruimte

Hier worden de semantische vectoren en de vectoren van het visuele kenmerk naar geprojecteerd.

2. Hoogste gelijkenis

Dit is waar functies worden vergeleken met die van een ongeziene klasse.

Laten we, om het proces met de twee fasen (training en inferentie) te helpen begrijpen, ze toepassen bij het gebruik van beeldclassificatie.

Trainingen

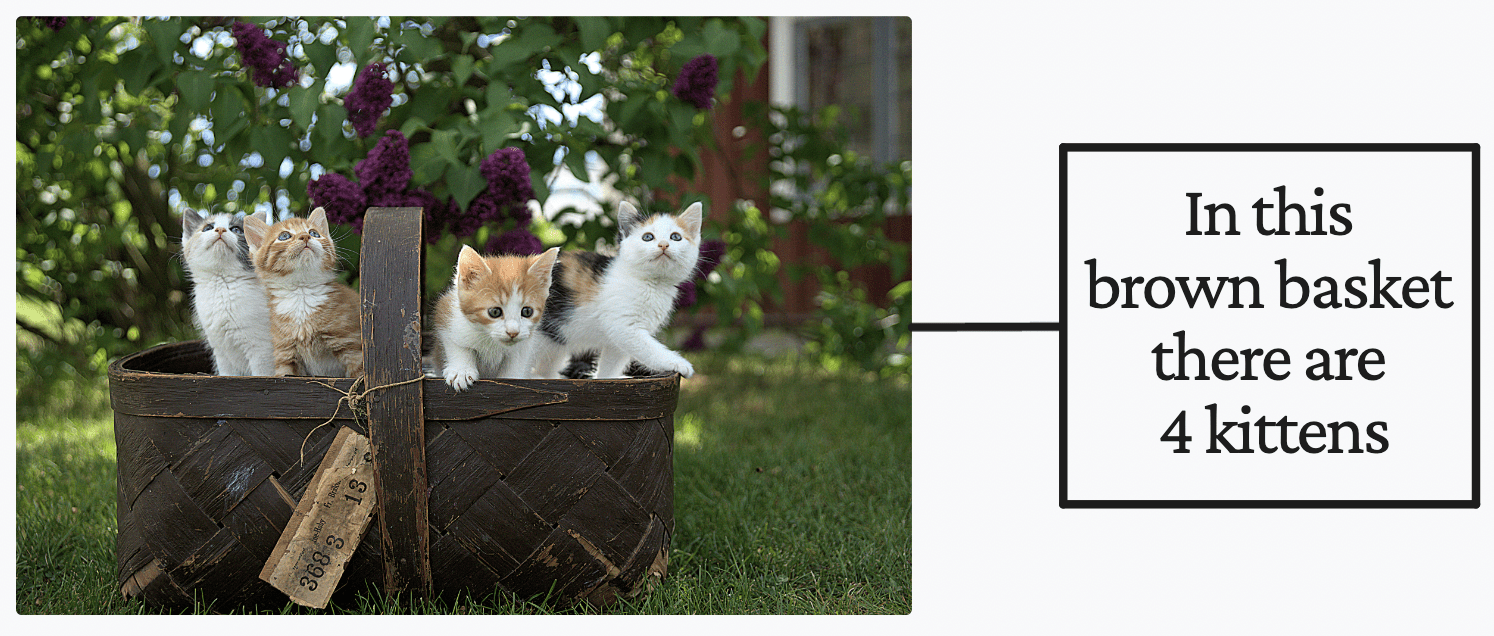

Jari Hytonen via Unsplash

Als je als mens de tekst rechts in de afbeelding hierboven zou lezen, zou je er meteen vanuit gaan dat er 4 kittens in een bruine mand zitten. Maar laten we zeggen dat je geen idee hebt wat een 'kitten' is. Je gaat ervan uit dat er een bruine mand is met daarin 4 dingen, die 'kittens' worden genoemd. Zodra u meer afbeeldingen tegenkomt die iets bevatten dat op een 'kitten' lijkt, kunt u een 'kitten' onderscheiden van andere dieren.

Dit is wat er gebeurt als je gebruikt Contrastieve Taal-Beeld Voortraining (CLIP) van OpenAI voor zero-shot learning in beeldclassificatie. Het staat bekend als hulpinformatie.

U denkt misschien: 'nou, dat zijn gewoon gelabelde gegevens'. Ik begrijp waarom je dat zou denken, maar dat zijn ze niet. Hulpinformatie is geen label van de gegevens, het is een vorm van supervisie om het model te helpen leren tijdens de trainingsfase.

Wanneer een zero-shot leermodel voldoende beeld-tekstparen ziet, zal het in staat zijn om zinnen te onderscheiden en te begrijpen en hoe ze correleren met bepaalde patronen in de afbeeldingen. Met behulp van de CLIP-techniek 'contrastief leren' heeft het zero-shot leermodel een goede kennisbasis kunnen opbouwen om voorspellingen te kunnen doen over classificatietaken.

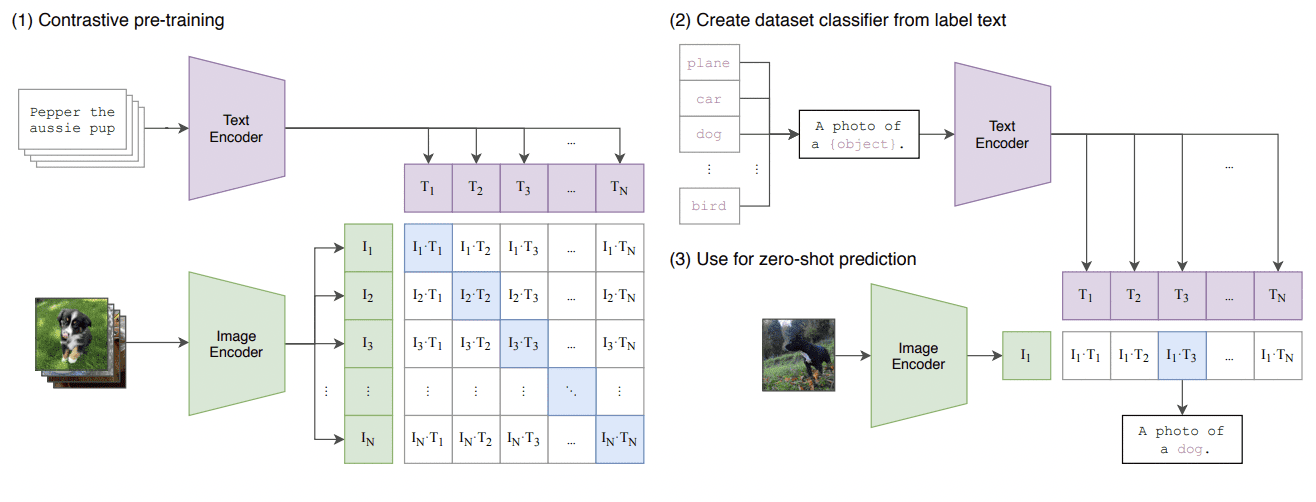

Dit is een samenvatting van de CLIP-benadering waarbij ze een beeld-encoder en een tekst-encoder samen trainen om de juiste combinaties van een reeks (beeld, tekst) trainingsvoorbeelden te voorspellen. Zie de afbeelding hieronder:

Overdraagbare visuele modellen leren van natuurlijke taalsupervisie

Gevolgtrekking

Zodra het model de trainingsfase heeft doorlopen, heeft het een goede kennisbasis van beeld-tekstkoppeling en kan het nu worden gebruikt om voorspellingen te doen. Maar voordat we kunnen beginnen met het doen van voorspellingen, moeten we de classificatietaak instellen door een lijst te maken met alle mogelijke labels die het model zou kunnen uitvoeren.

Als we bijvoorbeeld vasthouden aan de beeldclassificatietaak over diersoorten, hebben we een lijst nodig van alle diersoorten. Elk van deze labels wordt gecodeerd, T? naar T? met behulp van de vooraf getrainde tekst-encoder die plaatsvond in de trainingsfase.

Zodra de labels zijn gecodeerd, kunnen we afbeeldingen invoeren via de vooraf getrainde afbeeldingsencoder. We zullen de afstandsmetrische cosinusovereenkomst gebruiken om de overeenkomsten tussen de beeldcodering en elke tekstlabelcodering te berekenen.

De classificatie van de afbeelding gebeurt op basis van het label met de grootste gelijkenis met de afbeelding. En dat is hoe zero-shot learning wordt bereikt, met name in beeldclassificatie.

Schaarste aan gegevens

Zoals eerder vermeld, zijn gegevens van hoge kwantiteit en kwaliteit moeilijk te verkrijgen. In tegenstelling tot mensen die al over het zero-shot leervermogen beschikken, hebben machines input-gelabelde gegevens nodig om te leren en zich vervolgens aan te passen aan variaties die van nature kunnen optreden.

Als we kijken naar het voorbeeld van de diersoort, dat waren er zo veel. En aangezien het aantal categorieën in verschillende domeinen blijft groeien, zal het veel werk vergen om het verzamelen van geannoteerde gegevens bij te houden.

Hierdoor is zero-shot learning voor ons waardevoller geworden. Steeds meer onderzoekers zijn geïnteresseerd in automatische attribuutherkenning om het gebrek aan beschikbare data te compenseren.

Gegevensetikettering

Een ander voordeel van zero-shot learning zijn de eigenschappen voor het labelen van gegevens. Het labelen van gegevens kan arbeidsintensief en erg vervelend zijn en kan daardoor leiden tot fouten tijdens het proces. Voor het labelen van gegevens zijn experts nodig, zoals medische professionals die werken aan een biomedische dataset, wat erg duur en tijdrovend is.

Zero-shot learning wordt steeds populairder vanwege de bovengenoemde beperkingen van data. Er zijn een paar artikelen die ik u zou aanraden te lezen als u geïnteresseerd bent in de mogelijkheden ervan:

Nisha Arja is een datawetenschapper en freelance technisch schrijver. Ze is vooral geïnteresseerd in het geven van loopbaanadvies op het gebied van Data Science of tutorials en op theorie gebaseerde kennis rond Data Science. Ze wil ook de verschillende manieren onderzoeken waarop kunstmatige intelligentie de levensduur van de mens ten goede komt. Een scherpe leerling, die haar technische kennis en schrijfvaardigheid wil verbreden, terwijl ze anderen helpt te begeleiden.

- Door SEO aangedreven content en PR-distributie. Word vandaag nog versterkt.

- Platoblockchain. Web3 Metaverse Intelligentie. Kennis versterkt. Toegang hier.

- Bron: https://www.kdnuggets.com/2022/12/zeroshot-learning-explained.html?utm_source=rss&utm_medium=rss&utm_campaign=zero-shot-learning-explained

- 2021

- a

- capaciteiten

- vermogen

- in staat

- Over

- boven

- Volgens

- Accumuleren

- bereikt

- over

- aanpassen

- advies

- tegen

- Alles

- toestaat

- al

- bedragen

- en

- dier

- dieren

- toegepast

- Solliciteer

- nadering

- rond

- kunstmatig

- kunstmatige intelligentie

- Automatisch

- Beschikbaar

- baseren

- gebaseerde

- mand

- worden

- worden

- vaardigheden

- wezen

- onder

- voordeel

- tussen

- biomedische

- verbreden

- bouw

- berekend

- Dit betekent dat we onszelf en onze geliefden praktisch vergiftigen.

- Kan krijgen

- kan niet

- in staat

- vangen

- Carrière

- categorieën

- zeker

- klasse

- klassen

- classificatie

- classificeren

- Het verzamelen van

- hoe

- compleet

- rekenkracht

- Berekenen

- computer

- Computer visie

- blijft

- kon

- en je merk te creëren

- Wij creëren

- Actueel

- gegevens

- data science

- data scientist

- datasets

- deep

- diepgaand leren

- Afhankelijkheid

- verschillen

- anders

- onderscheiden

- afstand

- domeinen

- gedurende

- elk

- effectief

- inspanning

- fouten

- voorbeeld

- voorbeelden

- duur

- deskundigen

- uitgelegd

- Verken

- Kenmerk

- Voordelen

- weinig

- VIND DE PLEK DIE PERFECT VOOR JOU IS

- volgend

- formulier

- freelance

- oppompen van

- Algemeen

- krijgen

- goed

- beste

- Groeien

- gids

- handvat

- handen

- gebeurt

- Hard

- met

- hulp

- het helpen van

- Hoge

- hoogst

- zeer

- Hoe

- How To

- Echter

- HTTPS

- menselijk

- Mensen

- idee

- beeld

- Afbeeldingsclassificatie

- afbeeldingen

- belangrijk

- in

- informatie

- invoer

- Intelligentie

- geïnteresseerd

- IT

- Keen

- Houden

- blijven

- kennis

- bekend

- label

- etikettering

- labels

- Gebrek

- taal

- leiden

- LEARN

- geleerd

- leren

- Life

- beperkingen

- LINK

- links

- Lijst

- lang leven

- Kijk

- op zoek

- LOOKS

- lot

- machine

- machine learning

- Machines

- groot

- maken

- maken

- veel

- middel

- medisch

- vermeld

- methode

- methoden

- metriek

- macht

- miljoen

- model

- modellen

- geld

- meer

- meest

- Naturel

- Noodzaak

- New

- aantal

- objecten

- obstakels

- opgetreden

- EEN

- OpenAI

- bestellen

- Overige

- Overig

- pairing

- combinaties

- papieren

- vooral

- patronen

- fase

- zinnen

- Fysiek

- Plato

- Plato gegevensintelligentie

- PlatoData

- dan

- Populair

- mogelijk

- energie

- voorspellen

- Voorspellingen

- die eerder

- probleem

- produceren

- professionals

- geprojecteerde

- vastgoed

- het verstrekken van

- zetten

- kwaliteiten

- kwaliteit

- hoeveelheid

- Lees

- reden

- ontvangen

- erkenning

- adviseren

- vereisen

- vereist

- onderzoekers

- beperkingen

- robuust

- Wetenschap

- Wetenschapper

- op zoek naar

- ziet

- reeks

- gelijk

- overeenkomsten

- vaardigheden

- slimmer

- So

- OPLOSSEN

- iets

- Tussenruimte

- specifiek

- Stadium

- stadia

- Stappen

- plakken

- Still

- shop

- dergelijk

- voldoende

- OVERZICHT

- toezicht

- Nemen

- neemt

- Taak

- taken

- tech

- Technisch

- De

- hun

- daarom

- spullen

- het denken

- Door

- niet de tijd of

- tijdrovend

- naar

- samen

- Trainen

- Trainingen

- overgedragen

- betrouwbaar

- tutorials

- typisch

- begrijpen

- us

- .

- gebruikt

- waardevol

- via

- Bekijk

- visie

- manieren

- Wat

- welke

- Terwijl

- WIE

- wijd

- wil

- zonder

- Woord

- Mijn werk

- werkzaam

- zou

- schrijver

- het schrijven van

- Your

- zephyrnet

- Zero-shot leren