Introduksjon

Ettersom feltet for kunstig intelligens (AI) fortsetter å vokse og utvikle seg, blir det stadig viktigere for ambisiøse AI-utviklere å holde seg oppdatert med siste forskning og fremskritt. En av de beste måtene å gjøre dette på er å lese AI Papers for GenAI-utviklere, som gir verdifull innsikt i banebrytende teknikker og algoritmer. Denne artikkelen vil utforske 15 essensielle AI-artikler for GenAI-utviklere. Disse papirene dekker ulike emner, fra naturlig språkbehandling til datasyn. De vil forbedre din forståelse av AI og øke sjansene dine for å få din første jobb i dette spennende feltet.

Viktigheten av AI-papirer for GenAI-utviklere

AI Papers for GenAI-utviklere lar forskere og eksperter dele sine funn, metoder og gjennombrudd med det bredere samfunnet. Ved å lese disse papirene får du tilgang til de siste fremskrittene innen AI, slik at du kan holde deg i forkant og ta informerte beslutninger i arbeidet ditt. Dessuten gir AI Papers for GenAI-utviklere ofte detaljerte forklaringer av algoritmer og teknikker, noe som gir deg en dypere forståelse av hvordan de fungerer og hvordan de kan brukes på problemer i den virkelige verden.

Å lese AI Papers for GenAI-utviklere gir flere fordeler for ambisiøse AI-utviklere. For det første hjelper det deg å holde deg oppdatert med den siste forskningen og trendene på feltet. Denne kunnskapen er avgjørende når du søker på AI-relaterte jobber, da arbeidsgivere ofte ser etter kandidater som er kjent med de siste fremskritt. I tillegg lar lesing av AI-artikler deg utvide kunnskapen din og få en dypere forståelse av AI-konsepter og -metoder. Denne kunnskapen kan brukes på dine prosjekter og forskning, noe som gjør deg til en mer kompetent og dyktig AI-utvikler.

Innholdsfortegnelse

En oversikt: Essential AI Papers for GenAI-utviklere med lenker

Oppgave 1: Transformers: Attention is All You Need

Link: Les her

Papirsammendrag

Artikkelen introduserer Transformer, en ny nevrale nettverksarkitektur for sekvenstransduksjonsoppgaver, for eksempel maskinoversettelse. I motsetning til tradisjonelle modeller basert på tilbakevendende eller konvolusjonelle nevrale nettverk, er transformatoren utelukkende avhengig av oppmerksomhetsmekanismer, og eliminerer behovet for gjentakelse og konvolusjoner. Forfatterne hevder at denne arkitekturen tilbyr overlegen ytelse når det gjelder oversettelseskvalitet, økt parallelliserbarhet og redusert treningstid.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Oppmerksomhetsmekanisme

Transformatoren er bygget utelukkende på oppmerksomhetsmekanismer, slik at den kan fange opp globale avhengigheter mellom inngangs- og utgangssekvenser. Denne tilnærmingen gjør at modellen kan vurdere sammenhenger uten å være begrenset av avstanden mellom elementer i sekvensene.

- Parallellisering

En stor fordel med transformatorarkitekturen er dens økte parallelliserbarhet. Tradisjonelle tilbakevendende modeller lider av sekvensiell beregning, noe som gjør parallellisering utfordrende. Transformatorens design tillater mer effektiv parallell prosessering under trening, noe som reduserer treningstiden.

- Overlegen kvalitet og effektivitet

Artikkelen presenterer eksperimentelle resultater på maskinoversettelsesoppgaver, og viser at Transformer oppnår overlegen oversettelseskvalitet sammenlignet med eksisterende modeller. Den utkonkurrerer tidligere toppmoderne resultater, inkludert ensemblemodeller, med en betydelig margin. I tillegg oppnår transformatoren disse resultatene med betydelig mindre treningstid.

- Oversettelsesytelse

På WMT 2014 engelsk-til-tysk oversettelsesoppgave, oppnår den foreslåtte modellen en BLEU-score på 28.4, og overgår eksisterende beste resultater med over 2 BLEU. På engelsk-til-fransk-oppgaven etablerer modellen en ny enkeltmodell state-of-the-art BLEU-poengsum på 41.8 etter trening i bare 3.5 dager på åtte GPUer.

- Generalisering til andre oppgaverForfatterne demonstrerer at transformatorarkitekturen generaliserer godt til oppgaver utover maskinoversettelse. De bruker vellykket modellen til engelsk valgkrets-parsing, og viser dens tilpasningsevne til forskjellige sekvenstransduksjonsproblemer.

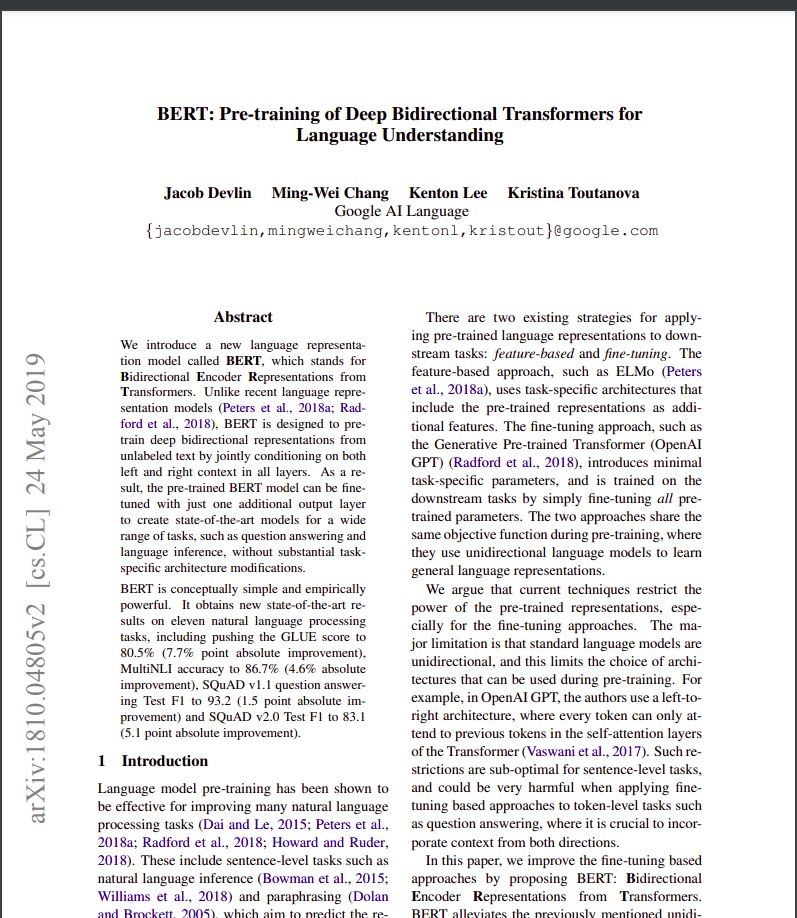

Oppgave 2: BERT: Foropplæring av dype toveis transformatorer for språkforståelse

Link: Les her

Papirsammendrag

Språkmodellforopplæring har vist seg effektiv for å forbedre ulike prosesseringsoppgaver for naturlig språk. Oppgaven skiller mellom funksjonsbaserte og finjusterende tilnærminger for å bruke forhåndstrente språkrepresentasjoner. BERT er introdusert for å adressere begrensninger i finjusteringstilnærminger, spesielt den ensrettede begrensningen til standardspråkmodeller. Artikkelen foreslår et "Masked Language Model" (MLM) føropplæringsmål, inspirert av Cloze-oppgaven, for å muliggjøre toveis representasjoner. En "neste setningsprediksjon"-oppgave brukes også til å forhåndstrene tekst-parrepresentasjoner.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Toveis pre-trening viktighet

Artikkelen understreker betydningen av toveis foropplæring for språkrepresentasjoner. I motsetning til tidligere modeller, bruker BERT maskerte språkmodeller for å muliggjøre dype toveisrepresentasjoner, som overgår enveis språkmodeller brukt av tidligere verk.

- Reduksjon i oppgavespesifikke arkitekturer

BERT demonstrerer at forhåndstrente representasjoner reduserer behovet for tungt konstruerte oppgavespesifikke arkitekturer. Det blir den første finjusteringsbaserte representasjonsmodellen som oppnår toppmoderne ytelse på tvers av et mangfold av oppgaver på setningsnivå og tokennivå, og overgår oppgavespesifikke arkitekturer.

- State-of-the-art fremskritt

BERT oppnår nye toppmoderne resultater på elleve naturlig språkbehandlingsoppgaver, som viser allsidigheten. Bemerkelsesverdige forbedringer inkluderer en betydelig økning i GLUE-poengsummen, MultiNLI-nøyaktighet og forbedringer i SQuAD v1.1 og v2.0 spørsmålssvarsoppgaver.

Du kan også lese: Finjustering av BERT med maskert språkmodellering

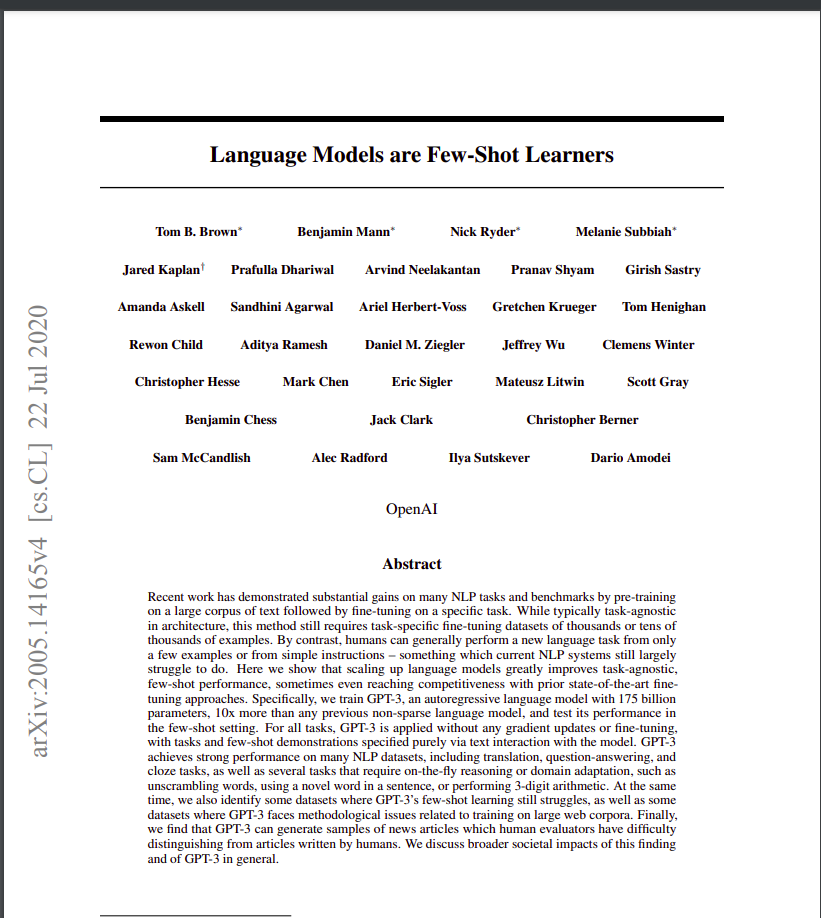

Oppgave 3: GPT: Språkmodeller er få-skudd-lærere

Link: Les her

Papirsammendrag

Oppgaven diskuterer forbedringene som oppnås i naturlig språkbehandling (NLP) oppgaver ved å skalere opp språkmodeller, med fokus på GPT-3 (Generative Pre-trained Transformer 3), en autoregressiv språkmodell med 175 milliarder parametere. Forfatterne fremhever det mens de er nylige NLP-modeller viser betydelige gevinster gjennom forhåndstrening og finjustering, krever de ofte oppgavespesifikke datasett med tusenvis av eksempler for finjustering. Derimot kan mennesker utføre nye språkoppgaver med få eksempler eller enkle instruksjoner.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Oppskalering forbedrer ytelsen til få skudd

Forfatterne demonstrerer at oppskalering av språkmodeller betydelig forbedrer oppgaveagnostisk ytelse med få skudd. GPT-3, med sin store parameterstørrelse, oppnår noen ganger konkurranseevne med toppmoderne finjusteringstilnærminger uten oppgavespesifikk finjustering eller gradientoppdateringer.

- Bred anvendelighet

GPT-3 viser sterk ytelse på tvers av ulike NLP-oppgaver, inkludert oversettelse, svar på spørsmål, lukkede oppgaver og oppgaver som krever resonnement underveis eller domenetilpasning. - Utfordringer og begrensninger

Mens GPT-3 viser bemerkelsesverdige få-skudds læringsevner, identifiserer forfatterne datasett der den sliter og fremhever metodiske problemer knyttet til opplæring på store nettkorpora. - Menneskelignende artikkelgenerering

GPT-3 kan generere nyhetsartikler som menneskelige evaluatorer synes er vanskelig å skille fra artikler skrevet av mennesker. - Samfunnspåvirkninger og bredere hensyn

Artikkelen diskuterer de bredere samfunnsmessige konsekvensene av GPT-3s evner, spesielt når det gjelder å generere menneskelignende tekst. Implikasjonene av dens ytelse i ulike oppgaver vurderes i form av praktiske anvendelser og potensielle utfordringer. - Begrensninger for gjeldende NLP-tilnærminger

Forfatterne fremhever begrensningene ved nåværende NLP-tilnærminger, spesielt deres avhengighet av oppgavespesifikke finjusteringsdatasett, som utgjør utfordringer som kravet om store merkede datasett og risikoen for overtilpasning til smale oppgavefordelinger. I tillegg oppstår det bekymringer angående generaliseringsevnen til disse modellene utenfor rammen av treningsdistribusjonen.

Artikkel 4: CNN: ImageNet-klassifisering med dype konvolusjonelle nevrale nettverk

Link: Les her

Papirsammendrag

Artikkelen beskriver utvikling og opplæring av et stort, dypt konvolusjonelt nevralt nettverk (CNN) for bildeklassifisering på ImageNet Large Scale Visual Recognition Challenge (ILSVRC) datasett. Modellen oppnår betydelige forbedringer i klassifiseringsnøyaktighet sammenlignet med tidligere avanserte metoder.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Modellarkitektur

Det nevrale nettverket som brukes i studien er en dyp CNN med 60 millioner parametere og 650,000 1000 nevroner. Den består av fem konvolusjonslag, noen etterfulgt av maks-pooling-lag, og tre fullt sammenkoblede lag med en endelig XNUMX-veis softmax for klassifisering.

- Treningsdata

Modellen er trent på et betydelig datasett med 1.2 millioner høyoppløselige bilder fra ImageNet ILSVRC-2010-konkurransen. Opplæringsprosessen innebærer å klassifisere bilder i 1000 forskjellige klasser.

- Ytelse

Modellen oppnår topp-1 og topp-5 feilrater på henholdsvis 37.5 % og 17.0 % på testdataene. Disse feilprosentene er betraktelig bedre enn den forrige state-of-the-art, noe som indikerer effektiviteten til den foreslåtte tilnærmingen.

- Forbedringer i overfitting

Artikkelen introduserer flere teknikker for å løse problemer med overtilpasning, inkludert ikke-mettende nevroner, effektiv GPU-implementering for raskere trening, og en regulariseringsmetode kalt "dropout" i fullt tilkoblede lag. - Beregningseffektivitet

Til tross for beregningskravene til å trene store CNN-er, bemerker papiret at nåværende GPUer og optimaliserte implementeringer gjør det mulig å trene slike modeller på høyoppløselige bilder.

- Bidrag

Artikkelen fremhever studiens bidrag, inkludert trening av et av de største konvolusjonelle nevrale nettverkene på ImageNet-datasett og oppnåelse av toppmoderne resultater i ILSVRC-konkurranser.

Du kan også lese: En omfattende veiledning for å lære konvolusjonelle nevrale nettverk

Paper 5: GATs: Graph Attention Networks

Link: Les her

Papirsammendrag

Artikkelen introduserer en oppmerksomhetsbasert arkitektur for nodeklassifisering i grafstrukturerte data, som viser dens effektivitet, allsidighet og konkurransedyktige ytelse på tvers av ulike benchmarks. Inkorporering av oppmerksomhetsmekanismer viser seg å være et kraftig verktøy for å håndtere vilkårlig strukturerte grafer.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Graph Attention Networks (GATs)GAT-er utnytter maskerte selvoppmerksomhetslag for å adressere begrensninger i tidligere metoder basert på grafviklinger. Arkitekturen lar noder overvåke nabolagets funksjoner, implisitt spesifisere forskjellige vekter til forskjellige noder uten å stole på kostbare matriseoperasjoner eller a priori kunnskap om grafstrukturen.

- Ta tak i spektralbaserte utfordringer

GAT-er løser samtidig flere utfordringer i spektralbaserte grafnevrale nettverk. Graph Attention Network (GAT)-utfordringer involverer romlig lokaliserte filtre, intense beregninger og ikke-romlig lokaliserte filtre. I tillegg er GAT-er avhengig av den Laplacian-egenbasis, noe som bidrar til deres anvendelighet på induktive og transduktive problemer.

- Ytelse på tvers av benchmarks

GAT-modeller oppnår eller matcher toppmoderne resultater på tvers av fire etablerte grafiske benchmarks: Cora, Citeseer og Pubmed sitasjonsnettverksdatasett, samt et protein-protein interaksjonsdatasett. Disse benchmarkene dekker både transduktive og induktive læringsscenarier, og viser allsidigheten til GAT-er.

- Sammenligning med tidligere tilnærminger

Artikkelen gir en omfattende oversikt over tidligere tilnærminger, inkludert rekursive nevrale nettverk, Graf Neural Networks (GNN), spektrale og ikke-spektrale metoder og oppmerksomhetsmekanismer. GAT-er inkluderer oppmerksomhetsmekanismer, noe som muliggjør effektiv parallellisering på tvers av node-nabo-par og applikasjon til noder med forskjellige grader.

- Effektivitet og anvendelighetGAT-er tilbyr en parallelliserbar, effektiv operasjon som kan brukes på grafiske noder med forskjellige grader ved å spesifisere vilkårlige vekter til naboer. Modellen gjelder direkte for induktive læringsproblemer, noe som gjør den egnet for oppgaver der den trenger å generalisere til helt usynlige grafer.

- Forhold til tidligere modeller

Forfatterne bemerker at GAT-er kan omformuleres som en spesiell forekomst av MoNet, dele likheter med relasjonsnettverk og koble til verk som bruker oppmerksomhetsoperasjoner i nabolaget. Den foreslåtte oppmerksomhetsmodellen sammenlignes med relaterte tilnærminger som Duan et al. (2017) og Denil et al. (2017).

Oppgave 6: ViT: Et bilde er verdt 16×16 ord: Transformers for bildegjenkjenning i skala

Link: Les her

Papirsammendrag

Artikkelen erkjenner dominansen til konvolusjonelle arkitekturer i datasyn til tross for suksessen til Transformer-arkitekturer i naturlig språkbehandling. Inspirert av transformatorers effektivitet og skalerbarhet i NLP, brukte forfatterne en standard transformator direkte på bilder med minimale modifikasjoner.

De introduserer Vision Transformer (ViT), hvor bilder er delt inn i patcher, og sekvensen av lineære innbygginger av disse patchene fungerer som input til transformatoren. Modellen er opplært i bildeklassifiseringsoppgaver på en veiledet måte. Til å begynne med, når det trenes på mellomstore datasett som ImageNet uten sterk regularisering, oppnår ViT nøyaktigheter litt under sammenlignbare ResNets.

Forfatterne avslører imidlertid at opplæring i stor skala er avgjørende for ViTs suksess, og overgår begrensningene som pålegges av fraværet av visse induktive skjevheter. Når den er forhåndsopplært på massive datasett, overgår ViT toppmoderne konvolusjonsnettverk på flere benchmarks, inkludert ImageNet, CIFAR-100 og VTAB. Artikkelen understreker virkningen av skalering for å oppnå bemerkelsesverdige resultater med Transformer-arkitekturer i datasyn.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Transformator i datasyn

Artikkelen utfordrer den rådende avhengigheten av konvolusjonelle nevrale nettverk (CNN) for datasynsoppgaver. Den viser at en ren transformator, når den brukes direkte på sekvenser av bildelapper, kan oppnå utmerket ytelse i bildeklassifiseringsoppgaver.

- Vision Transformer (ViT)

Forfatterne introduserer Vision Transformer (ViT), en modell som bruker selvoppmerksomhetsmekanismer som ligner på Transformers i NLP. ViT kan oppnå konkurransedyktige resultater på ulike bildegjenkjenningsreferanser, inkludert ImageNet, CIFAR-100 og VTAB.

- Foropplæring og overføringslæring

Oppgaven understreker viktigheten av å forhåndstrene på store datamengder, lik tilnærmingen i NLP, og deretter overføre de lærte representasjonene til spesifikke bildegjenkjenningsoppgaver. Når ViT er forhåndsopplært på massive datasett som ImageNet-21k eller JFT-300M, overgår det toppmoderne konvolusjonsnettverk på ulike benchmarks.

- BeregningseffektivitetViT oppnår bemerkelsesverdige resultater med vesentlig færre beregningsressurser under trening enn state-of-the-art konvolusjonelle nettverk. Denne effektiviteten er spesielt bemerkelsesverdig når modellen er forhåndstrent i stor skala.

- Skaleringseffekt

Oppgaven fremhever betydningen av skalering for å oppnå overlegen ytelse med Transformer-arkitekturer i datasyn. Storskala opplæring på datasett som inneholder millioner til hundrevis av millioner bilder hjelper ViT med å overvinne mangelen på noen induktive skjevheter som finnes i CNN.

Oppgave 7: AlphaFold2: Svært nøyaktig proteinstruktur med AlphaFold

Link: Les her

Papirsammendrag

Artikkelen "AlphaFold2: Meget nøyaktig proteinstruktur med AlphaFold" introduserer AlphaFold2, en dyp læringsmodell som nøyaktig forutsier proteinstrukturer. AlphaFold2 utnytter en ny oppmerksomhetsbasert arkitektur og oppnår et gjennombrudd innen proteinfolding.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- AlphaFold2 bruker et dypt nevralt nettverk med oppmerksomhetsmekanismer for å forutsi 3D-strukturen til proteiner fra deres aminosyresekvenser.

- Modellen ble trent på et stort datasett med kjente proteinstrukturer og oppnådde enestående nøyaktighet i den 14. Critical Assessment of Protein Structure Prediction (CASP14) proteinfoldingskonkurransen.

- AlphaFold2s nøyaktige spådommer kan potensielt revolusjonere medikamentoppdagelse, proteinteknikk og andre områder innen biokjemi.

Paper 8: GANs: Generative Adversarial Nets

Link: Les her

Papirsammendrag

Artikkelen tar for seg utfordringene med å trene dype generative modeller og introduserer en nyskapende tilnærming kalt motstandsnett. I dette rammeverket engasjerer generative og diskriminerende modeller et spill der den generative modellen tar sikte på å produsere prøver som ikke kan skilles fra ekte data. I motsetning til dette skiller den diskriminerende modellen mellom reelle og genererte prøver. Den motstridende opplæringsprosessen fører til en unik løsning, med den generative modellen som gjenoppretter datadistribusjonen.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Motstridende rammeverk

Forfatterne introduserer et kontradiktorisk rammeverk der to modeller trenes samtidig - en generativ modell (G) som fanger opp datafordelingen og en diskriminerende modell (D) som estimerer sannsynligheten for at et utvalg kom fra treningsdataene i stedet for den generative modellen.

- Minimax spillOpplæringsprosedyren innebærer å maksimere sannsynligheten for at den diskriminerende modellen gjør en feil. Dette rammeverket er formulert som et minimaks-spill for to spillere, der den generative modellen har som mål å generere prøver som ikke kan skilles fra ekte data, og den diskriminerende modellen har som mål å klassifisere om et utvalg er ekte eller generert riktig.

- Unik løsning

En unik løsning finnes i vilkårlige funksjoner for G og D, hvor G gjenoppretter treningsdatadistribusjonen og D er lik 1/2 overalt. Denne likevekten nås gjennom den kontradiktoriske treningsprosessen.

- Multilayer Perceptrons (MLP-er)Forfatterne demonstrerer at hele systemet kan trenes ved hjelp av tilbakepropagasjon når flerlags perseptroner representerer G og D. Dette eliminerer behovet for Markov-kjeder eller utrullede omtrentlige inferensnettverk under trening og generering av prøver.

- Ingen omtrentlig slutning

Det foreslåtte rammeverket unngår vanskelighetene med å tilnærme intraktable sannsynlighetsberegninger i maksimal sannsynlighetsestimering. Den overvinner også utfordringer med å utnytte fordelene med stykkevise lineære enheter i generativ kontekst.

Oppgave 9: Roberta: En robust optimert BERT-foropplæringstilnærming

Link: Les her

Papirsammendrag

Oppgaven tar for seg BERTs undertreningsproblem og introduserer RoBERTa, en optimalisert versjon som overgår BERTs ytelse. Endringene i RoBERTas opplæringsprosedyre og bruk av et nytt datasett (CC-NEWS) bidrar til toppmoderne resultater på flere naturlig språkbehandlingsoppgaver. Funnene understreker viktigheten av designvalg og treningsstrategier for effektiviteten av fortrening av språkmodeller. De frigitte ressursene, inkludert RobERTa-modellen og koden, bidrar til forskningsmiljøet.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- BERT Undertrening

Det finner forfatterne BERTI, en mye brukt språkmodell, var betydelig undertrent. Ved å nøye evaluere effekten av hyperparameterinnstilling og treningssettstørrelse, viser de at BERT kan forbedres for å matche eller overgå ytelsen til alle modeller publisert etter den.

- Forbedret treningsoppskrift (RoBERTa)

Forfatterne introduserer modifikasjoner til BERT-opplæringsprosedyren, og gir RobERTa. Disse endringene innebærer utvidede treningsperioder med større partier, eliminering av neste setningsprediksjonsmål, trening på lengre sekvenser og dynamisk maskeringsmønsterjusteringer for treningsdata.

- DatasettbidragOppgaven introduserer et nytt datasett kalt CC-NEWS, som i størrelse kan sammenlignes med andre privat brukte datasett. Inkludering av dette datasettet hjelper bedre med å kontrollere størrelseseffekter på treningssett og bidrar til forbedret ytelse på nedstrømsoppgaver.

- Ytelsesprestasjoner

RobERTa, med de foreslåtte modifikasjonene, oppnår toppmoderne resultater på ulike benchmark-oppgaver, inkludert GLUE, RACE og SQuAD. Den matcher eller overgår ytelsen til alle post-BERT-metoder på oppgaver som MNLI, QNLI, RTE, STS-B, SQuAD og RACE.

- Konkurranseevnen til Masked Language Model Pretraining

Artikkelen bekrefter på nytt at det maskerte språkmodellens foropplæringsmål, med de riktige designvalgene, er konkurransedyktig med andre nylig foreslåtte opplæringsmål.

- Utgitte ressurser

Forfatterne gir ut sin RoBERTa-modell, sammen med forhåndstrening og finjusteringskode implementert i PyTorch, noe som bidrar til reproduserbarheten og videre utforskning av funnene deres.

Les også: En skånsom introduksjon til ROBERTA

Paper 10: NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis

Link: Les her

Papirsammendrag

Optimalisering innebærer å minimere feilen mellom observerte bilder med kjente kamerastillinger og visningene gjengitt fra den kontinuerlige scenerepresentasjonen. Artikkelen tar for seg utfordringer knyttet til konvergens og effektivitet ved å introdusere posisjonell koding for å håndtere funksjoner med høyere frekvens og foreslå en hierarkisk samplingsprosedyre for å redusere antall spørringer som trengs for adekvat sampling.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Kontinuerlig scenerepresentasjon

Oppgaven presenterer en metode for å representere komplekse scener som 5D nevrale utstrålingsfelt ved bruk av grunnleggende flerlagsperseptronnettverk (MLP).

- Differensierbar gjengivelse

Den foreslåtte gjengivelsesprosedyren er basert på klassiske volumgjengivelsesteknikker, som muliggjør gradientbasert optimalisering ved bruk av standard RGB-bilder.

- Hierarkisk prøvetakingsstrategi

En hierarkisk samplingsstrategi er introdusert for å optimalisere MLP-kapasiteten mot områder med synlig sceneinnhold, og adressere konvergensproblemer.

- Posisjonell kodingVed å bruke posisjonell koding for å kartlegge inndata 5D-koordinater til et rom med høyere dimensjoner, muliggjør vellykket optimalisering av nevrale utstrålingsfelt for høyfrekvent sceneinnhold.

Den foreslåtte metoden overgår state-of-the-art syntese-tilnærminger, inkludert tilpasning av nevrale 3D-representasjoner og trening av dype konvolusjonelle nettverk. Denne artikkelen introduserer en kontinuerlig nevrale scenerepresentasjon for å gjengi høyoppløselige fotorealistiske nye visninger fra RGB-bilder i naturlige omgivelser, med ytterligere sammenligninger vist i tilleggsvideoen for å fremheve effektiviteten i håndtering av kompleks scenegeometri og utseende.

Oppgave 11: FunSearch: Matematiske oppdagelser fra programsøk med store språkmodeller

Link: Les her

Papirsammendrag

Artikkelen introduserer FunSearch, en ny tilnærming for å utnytte store språkmodeller (LLM) for å løse komplekse problemer, spesielt innen vitenskapelig oppdagelse. Den primære utfordringen som tas opp er forekomsten av konfabulasjoner (hallusinasjoner) i LLM-er, som fører til plausible, men feilaktige utsagn. FunSearch kombinerer en forhåndsutdannet LLM med en systematisk evaluator i en evolusjonær prosedyre for å overvinne denne begrensningen.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Problemløsning med LLM

Oppgaven tar for seg spørsmålet om LLM-er som konfabulerer eller unnlater å generere nye ideer og riktige løsninger for komplekse problemer. Den understreker viktigheten av å finne nye, verifiserbart riktige ideer, spesielt for matematiske og vitenskapelige utfordringer.

- Evolusjonær prosedyre – FunSearch

FunSearch kombinerer en forhåndsutdannet LLM med en evaluator i en evolusjonær prosess. Det utvikler iterativt programmer med lav poengsum til programmer med høy poengsum, og sikrer oppdagelsen av ny kunnskap. Prosessen innebærer best-shot prompting, utvikling av programskjeletter, opprettholdelse av programmangfold og asynkron skalering.

- Applikasjon til Extremal Combinatorics

Artikkelen demonstrerer effektiviteten til FunSearch på cap set-problemet i ekstrem kombinatorikk. FunSearch oppdager nye konstruksjoner av store sett, som overgår de mest kjente resultatene og gir den største forbedringen på 20 år til den asymptotiske nedre grensen.

- Algoritmisk problem – pakking av søppelbøtte på nett

FunSearch brukes på pakkingsproblemet på nett, noe som fører til oppdagelsen av nye algoritmer som overgår tradisjonelle på godt studerte interessefordelinger. De potensielle bruksområdene inkluderer forbedring av jobbplanleggingsalgoritmer.

- Programmer vs. løsningerFunSearch fokuserer på å generere programmer som beskriver hvordan man løser et problem i stedet for å sende ut løsninger direkte. Disse programmene har en tendens til å være mer tolkbare, forenkler interaksjoner med domeneeksperter og er lettere å distribuere enn andre typer beskrivelser, for eksempel nevrale nettverk.

- Tverrfaglig påvirkning

FunSearchs metodikk gjør det mulig å utforske et bredt spekter av problemer, noe som gjør det til en allsidig tilnærming med tverrfaglige applikasjoner. Artikkelen fremhever potensialet for å gjøre verifiserbare vitenskapelige funn ved å bruke LLM-er.

Paper 12: VAEs: Auto-Encoding Variational Bayes

Link: Les her

Papirsammendrag

Papiret "Auto-Encoding Variational Bayes" tar for seg utfordringen med effektiv inferens og læring i regisserte sannsynlighetsmodeller med kontinuerlige latente variabler, spesielt når de bakre distribusjonene er vanskelige å behandle og har å gjøre med store datasett. Forfatterne foreslår en stokastisk variasjonsinferens og læringsalgoritme som skalerer godt for store datasett og forblir anvendelig selv i intraktable posteriore distribusjoner.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Reparameterisering av variasjonell nedre grense

Oppgaven demonstrerer en reparametrisering av den variasjonelle nedre grensen, noe som resulterer i en nedre grenseestimator. Denne estimatoren kan optimaliseres ved å bruke standard stokastiske gradientmetoder, noe som gjør den beregningseffektiv.

- Effektiv bakre inferens for kontinuerlige latente variablerForfatterne foreslår Auto-Encoding VB (AEVB) algoritmen for datasett med kontinuerlige latente variabler per datapunkt. Denne algoritmen bruker Stochastic Gradient Variational Bayes (SGVB) estimator for å optimalisere en gjenkjennelsesmodell, som muliggjør effektiv omtrentlig bakre inferens gjennom forfedres prøvetaking. Denne tilnærmingen unngår dyre iterative slutningsskjemaer som Markov Chain Monte Carlo (MCMC) for hvert datapunkt.

- Teoretiske fordeler og eksperimentelle resultater

De teoretiske fordelene med den foreslåtte metoden gjenspeiles i de eksperimentelle resultatene. Artikkelen antyder at reparametriserings- og gjenkjennelsesmodellen fører til beregningseffektivitet og skalerbarhet, noe som gjør tilnærmingen anvendelig for store datasett og i situasjoner der baksiden er vanskelig å behandle.

Les også: Avduking av essensen av Stokastisk i maskinlæring

Oppgave 13: LANG KORTTIDSMINNE

Link: Les her

Papirsammendrag

Artikkelen tar for seg utfordringen med å lære å lagre informasjon over lengre tidsintervaller i tilbakevendende nevrale nettverk. Den introduserer en ny, effektiv gradientbasert metode kalt "Long Short-Term Memory" (LSTM), som overvinner utilstrekkelige og forfallende tilbakestrømningsproblemer. LSTM fremtvinger konstant feilflyt gjennom "konstante feilkaruseller" og bruker multiplikative portenheter for å kontrollere tilgang. Med lokal rom-tid kompleksitet (O(1) per tidstrinn og vekt), viser eksperimentelle resultater at LSTM utkonkurrerer eksisterende algoritmer når det gjelder læringshastighet og suksessrater, spesielt for oppgaver med lengre tidsforsinkelser.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Problemanalyse

Artikkelen gir en detaljert analyse av utfordringene knyttet til tilbakestrømning av feil i tilbakevendende nevrale nettverk, og fremhever problemene med feilsignaler som enten eksploderer eller forsvinner over tid.

- Introduksjon av LSTM

Forfatterne introduserer LSTM som en ny arkitektur designet for å løse problemene med forsvinnende og eksploderende feilsignaler. LSTM inkorporerer konstant feilflyt gjennom spesialiserte enheter og bruker multiplikative portenheter for å regulere tilgangen til denne feilflyten.

- Eksperimentelle resultater

Gjennom eksperimenter med kunstige data viser artikkelen at LSTM utkonkurrerer andre tilbakevendende nettverksalgoritmer, inkludert BPTT, RTRL, Recurrent cascade-korrelasjon, Elman-nett og Neural Sequence Chunking. LSTM viser raskere læring og høyere suksessrate, spesielt når det gjelder å løse komplekse oppgaver med lange tidsforsinkelser.

- Lokal i rom og tid

LSTM er beskrevet som en lokal arkitektur i rom og tid, med beregningskompleksitet per tidstrinn og vekt som O(1).

- Gyldighet

Den foreslåtte LSTM-arkitekturen løser effektivt komplekse, kunstige langtidsforsinkelsesoppgaver som ikke har blitt løst av tidligere tilbakevendende nettverksalgoritmer.

- Begrensninger og fordeler

Artikkelen diskuterer begrensningene og fordelene ved LSTM, og gir innsikt i den praktiske anvendeligheten til den foreslåtte arkitekturen.

Les også: Hva er LSTM? Introduksjon til langtidsminne

Oppgave 14: Lære overførbare visuelle modeller fra naturlig språktilsyn

Link: Les her

Papirsammendrag

Oppgaven utforsker trening av state-of-the-art datasynssystemer ved å lære direkte fra rå tekst om bilder i stedet for å stole på faste sett med forhåndsbestemte objektkategorier. Forfatterne foreslår en pre-treningsoppgave med å forutsi hvilken bildetekst som tilsvarer et gitt bilde, ved å bruke et datasett på 400 millioner (bilde, tekst) par samlet fra internett. Den resulterende modellen, CLIP (Contrastive Language-Image Pre-training), demonstrerer effektiv og skalerbar læring av bilderepresentasjoner. Etter forhåndstrening refererer naturlig språk til visuelle konsepter, noe som muliggjør nullskuddsoverføring til ulike nedstrømsoppgaver. CLIP er benchmarket på over 30 datasett med datasyn, og viser konkurransedyktig ytelse uten oppgavespesifikk opplæring.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

- Opplæring i naturlig språk for datasyn

Oppgaven utforsker bruk av naturlig språktilsyn for å trene datasynsmodeller i stedet for den tradisjonelle treningstilnærmingen på folkemerkede datasett som ImageNet.

- Oppgave før treningForfatterne foreslår en enkel oppgave før trening: å forutsi hvilken bildetekst som tilsvarer et gitt bilde. Denne oppgaven brukes til å lære toppmoderne bilderepresentasjoner fra bunnen av på et massivt datasett med 400 millioner (bilde, tekst) par samlet på nettet.

- Zero-Shot Transfer

Etter foropplæring bruker modellen naturlig språk for å referere til lærte visuelle konsepter eller beskrive nye. Dette muliggjør nullskuddsoverføring av modellen til nedstrømsoppgaver uten å kreve spesifikk datasettopplæring.

- Benchmarking på ulike oppgaver

Oppgaven evaluerer ytelsen til den foreslåtte tilnærmingen på over 30 forskjellige datasynsdatasett, som dekker oppgaver som OCR, handlingsgjenkjenning i videoer, geolokalisering og finkornet objektklassifisering.

- Konkurransedyktig ytelse

Modellen demonstrerer konkurransedyktig ytelse med fullt overvåkede grunnlinjer på ulike oppgaver, som ofte matcher eller overgår nøyaktigheten til modeller som er trent på oppgavespesifikke datasett uten ekstra datasettspesifikk opplæring.

- Skalerbarhetsstudie

Forfatterne studerer skalerbarheten til deres tilnærming ved å trene en serie på åtte modeller med ulike nivåer av beregningsressurser. Overføringsytelsen er funnet å være en jevnt forutsigbar funksjon av databehandling.

- Modell Robusthet

Artikkelen fremhever at CLIP-modeller med zero-shot er mer robuste enn overvåkede ImageNet-modeller med tilsvarende nøyaktighet, noe som antyder at zero-shot-evaluering av oppgaveagnostiske modeller gir et mer representativt mål på en modells kapasitet.

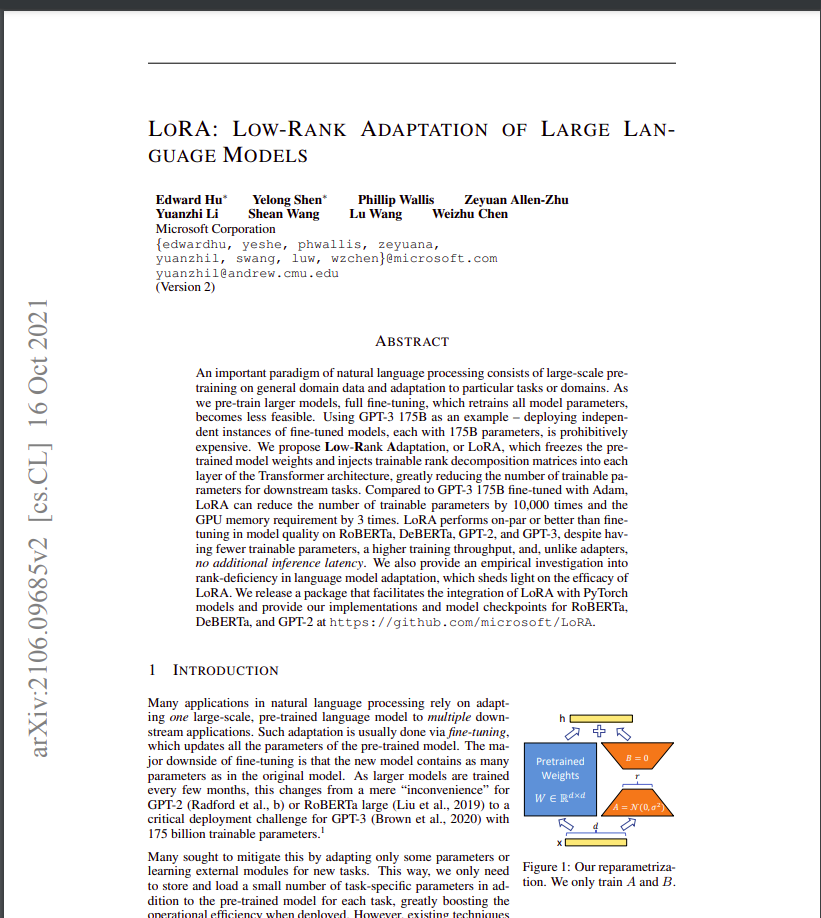

Oppgave 15: LORA: LAVRANK TILPASNING AV STORE SPRÅKMODELLER

Link: Les her

Papirsammendrag

Artikkelen foreslår LoRA som en effektiv metode for å tilpasse store ferdigtrente språkmodeller til spesifikke oppgaver, og adressere distribusjonsutfordringer knyttet til deres økende størrelse. Metoden reduserer betraktelig trenbare parametere og GPU-minnekrav, samtidig som den opprettholder eller forbedrer modellkvaliteten på tvers av ulike benchmarks. Åpen kildekode-implementeringen letter ytterligere innføringen av LoRA i praktiske applikasjoner.

Nøkkelinnsikt i AI Papers for GenAI-utviklere

1. Problemstilling

- Storskala fortrening etterfulgt av finjustering er en vanlig tilnærming i naturlig språkbehandling.

- Finjustering blir mindre mulig etter hvert som modellene vokser seg større, spesielt når du distribuerer modeller med massive parametere, for eksempel GPT-3 (175 milliarder parametere).

2. Foreslått løsning: lavrangstilpasning (LoRA)

- Artikkelen introduserer LoRA, en metode som fryser forhåndstrente modellvekter og introduserer trenbare rangnedbrytningsmatriser i hvert lag av transformatorarkitekturen.

- LoRA reduserer antallet trenbare parametere for nedstrømsoppgaver betydelig sammenlignet med full finjustering.

3. Fordeler med LoRA

- Parameterreduksjon: Sammenlignet med finjustering, kan LoRA redusere antall trenbare parametere med opptil 10,000 XNUMX ganger, noe som gjør den beregningsmessig mer effektiv.

- Minneeffektivitet: LoRA reduserer GPU-minnekravene med opptil 3 ganger sammenlignet med finjustering.

- Modellkvalitet: Til tross for at LoRA har færre trenbare parametere, yter den på nivå med eller bedre enn finjustering når det gjelder modellkvalitet på ulike modeller, inkludert RoBERTa, DeBERTa, GPT-2 og GPT-3.

4. Overvinne distribusjonsutfordringer

- Oppgaven tar for seg utfordringen med å distribuere modeller med mange parametere ved å introdusere LoRA, noe som muliggjør effektiv oppgavebytte uten å trene hele modellen på nytt.

5. Effektivitet og lav slutningsforsinkelse

- LoRA forenkler deling av en forhåndsopplært modell for å bygge flere LoRA-moduler for forskjellige oppgaver, redusere lagringskrav og oppgavebytte overhead.

- Trening gjøres mer effektiv, og senker maskinvarebarrieren for inngang med opptil 3 ganger ved bruk av adaptive optimizere.

6. Kompatibilitet og integrasjon

- LoRA er kompatibel med forskjellige tidligere metoder og kan kombineres med dem, for eksempel prefiksjustering.

- Den foreslåtte lineære designen tillater sammenslåing av trenbare matriser med frosne vekter under distribusjon, og introduserer ingen ekstra slutningsforsinkelse sammenlignet med fullt finjusterte modeller.

7. Empirisk undersøkelse

- Artikkelen inkluderer en empirisk undersøkelse av rangeringsmangel i språkmodelltilpasning, og gir innsikt i effektiviteten til LoRA-tilnærmingen.

8. Implementering av åpen kildekode

- Forfatterne gir en pakke som letter integrasjonen av LoRA med PyTorch-modeller og utgivelsesimplementeringer og modellsjekkpunkter for RoBERTa, DeBERTa og GPT-2.

Du kan også lese: Parametereffektiv finjustering av store språkmodeller med LoRA og QLoRA

konklusjonen

Avslutningsvis er å fordype seg i de 15 essensielle AI-papirene for GenAI-utviklere som er fremhevet i denne artikkelen, ikke bare en anbefaling, men et strategisk imperativ for enhver aspirerende utvikler. Disse AI-papirene tilbyr en omfattende reise gjennom det mangfoldige landskapet av kunstig intelligens, som spenner over kritiske domener som naturlig språkbehandling, datasyn og utover. Ved å fordype seg i innsikten og innovasjonene som presenteres i disse papirene, får utviklere en dyp forståelse av feltets banebrytende teknikker og algoritmer.

I slekt

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- PlatoData.Network Vertical Generative Ai. Styrk deg selv. Tilgang her.

- PlatoAiStream. Web3 Intelligence. Kunnskap forsterket. Tilgang her.

- PlatoESG. Karbon, CleanTech, Energi, Miljø, Solenergi, Avfallshåndtering. Tilgang her.

- PlatoHelse. Bioteknologisk og klinisk etterretning. Tilgang her.

- kilde: https://www.analyticsvidhya.com/blog/2024/01/essential-ai-papers-every-gen-ai-developer-must-read/

- : har

- :er

- :ikke

- :hvor

- $OPP

- 000

- 1

- 10

- 11

- 12

- 13

- 14

- 14.

- 15%

- 17

- 20

- 20 år

- 2014

- 2017

- 28

- 30

- 3d

- 400

- 41

- 60

- 7

- 8

- 9

- 913

- a

- evne

- Om oss

- AC

- adgang

- nøyaktighet

- nøyaktig

- nøyaktig

- Oppnå

- oppnådd

- oppnår

- oppnå

- tvers

- Handling

- tilpasningsdyktighet

- tilpasning

- tilpasse

- adaptive

- Ytterligere

- I tillegg

- adresse

- adressert

- adresser

- adressering

- justeringer

- Adopsjon

- fremskritt

- Fordel

- fordeler

- motstandere

- Etter

- fremover

- AI

- mål

- AL

- algoritme

- algoritmer

- Alle

- tillate

- tillate

- tillater

- langs

- også

- beløp

- an

- analyse

- og

- noen

- aktuelt

- Søknad

- søknader

- anvendt

- gjelder

- Påfør

- påføring

- tilnærming

- tilnærminger

- tilnærmet

- arkitektur

- ER

- områder

- argumentere

- oppstår

- Artikkel

- artikler

- kunstig

- kunstig intelligens

- Kunstig intelligens (AI)

- AS

- håper

- evaluering

- assosiert

- At

- delta

- oppmerksomhet

- forfattere

- barriere

- basert

- grunnleggende

- BE

- blir

- være

- under

- benchmark

- benchmarked

- benchmarks

- Fordeler

- BEST

- Bedre

- mellom

- Beyond

- skjevheter

- Milliarder

- BIN

- øke

- både

- bundet

- gjennombrudd

- gjennombrudd

- bredere

- Bygning

- bygget

- men

- by

- som heter

- kom

- rom

- CAN

- kandidater

- lokk

- evner

- evne

- Kapasitet

- fangst

- fanger

- nøye

- cascade

- kategorier

- viss

- kjede

- kjeder

- utfordre

- utfordringer

- utfordrende

- sjansene

- Endringer

- valg

- klasser

- klassifisering

- Klassifisere

- CNN

- kode

- samlet

- kombinert

- skurtreskerne

- Felles

- samfunnet

- sammenlign

- sammenlignet

- sammenligninger

- kompatibel

- kompetent

- konkurranse

- Konkurranser

- konkurranse

- konkurranseevne

- helt

- komplekse

- kompleksitet

- omfattende

- beregningen

- beregnings

- beregninger

- datamaskin

- Datamaskin syn

- databehandling

- konsepter

- bekymringer

- konklusjon

- Koble

- tilkoblet

- Vurder

- betraktelig

- ansett

- består

- konstant

- innhold

- konkurranse

- kontekst

- fortsetter

- kontinuerlig

- kontrast

- bidra

- bidrar

- medvirkende

- bidragene

- kontroll

- Konvergens

- convolutional nevralt nettverk

- korrigere

- riktig

- Korrelasjon

- tilsvarer

- kostbar

- dekke

- dekker

- kritisk

- avgjørende

- Gjeldende

- skjøger

- skjærekant

- dato

- datasett

- Dager

- håndtering

- avgjørelser

- avtar

- dyp

- dyp læring

- dype nevrale nettverk

- dypere

- krav

- demonstrere

- demonstrerer

- demonstrere

- avhenge

- avhengig

- utplassere

- utplasserings

- distribusjon

- beskrive

- beskrevet

- beskriver

- utforming

- designet

- Til tross for

- detaljert

- Utvikler

- utviklere

- utvikle

- forskjellig

- vanskelig

- vanskeligheter

- regissert

- direkte

- oppdager

- Funnet

- omtalt

- avstand

- skille

- Skiller

- distribusjon

- Distribusjoner

- diverse

- Mangfold

- do

- domene

- domener

- dominans

- medikament

- rusfunn

- under

- dynamisk

- E&T

- hver enkelt

- enklere

- Effektiv

- effektivt

- effektivitet

- effekter

- effekten

- effektivitet

- effektiv

- åtte

- enten

- elementer

- elleve

- eliminerer

- eliminere

- understreke

- legger vekt på

- arbeidsgivere

- anvender

- muliggjøre

- muliggjør

- muliggjør

- koding

- engasjere

- Ingeniørarbeid

- Engelsk

- forbedre

- forbedringer

- Forbedrer

- sikrer

- Hele

- fullstendig

- entry

- lik

- Equilibrium

- Tilsvarende

- feil

- spesielt

- essens

- avgjørende

- etablert

- etablerer

- estimater

- Eter (ETH)

- evaluere

- evaluering

- Selv

- overalt

- utvikle seg

- utvikler seg

- utvikling

- eksempler

- stige

- stiger

- utmerket

- spennende

- utstillinger

- eksisterende

- finnes

- Expand

- dyrt

- eksperimentell

- eksperimenter

- eksperter

- leting

- utforske

- utforsker

- Utforske

- utvidet

- forenkler

- tilrettelegging

- sviktende

- kjent

- raskere

- gjennomførbart

- Egenskaper

- Noen få

- færre

- felt

- Felt

- filtre

- slutt~~POS=TRUNC

- Finn

- finne

- funn

- Først

- for det første

- fitting

- fem

- fikset

- flyten

- fokuserer

- fokusering

- fulgt

- Til

- funnet

- fire

- Rammeverk

- Frekvens

- fra

- frossen

- fullt

- fullt

- funksjon

- funksjoner

- videre

- Gevinst

- inntjening

- spill

- Gans

- gate

- genai

- generere

- generert

- genererer

- generative

- generativ modell

- skånsom

- geometri

- gitt

- Giving

- Global

- GPU

- GPU

- graf

- grafiske nevrale nettverk

- grafer

- Grow

- håndtere

- Håndtering

- maskinvare

- å ha

- hjelper

- Høy

- Høy frekvens

- høy oppløsning

- høyere

- Uthev

- Fremhevet

- utheving

- striper

- svært

- Hvordan

- Hvordan

- HTTPS

- menneskelig

- Mennesker

- Hundrevis

- hundrevis av millioner

- Innstilling av hyperparameter

- Ideer

- identifisere

- bilde

- Bildeklassifisering

- Bildegjenkjenning

- IMAGEnet

- bilder

- Påvirkning

- Konsekvenser

- avgjørende

- gjennomføring

- implementeringer

- implementert

- implikasjoner

- betydning

- viktig

- pålagt

- forbedret

- forbedring

- forbedringer

- forbedrer

- bedre

- in

- inkludere

- inkluderer

- Inkludert

- innlemme

- inkorporerer

- Øke

- økt

- økende

- stadig

- indikerer

- informasjon

- informert

- i utgangspunktet

- innovasjoner

- innovative

- inngang

- innsikt

- inspirert

- f.eks

- i stedet

- instruksjoner

- utilstrekkelig

- integrering

- Intelligens

- intens

- interaksjon

- interaksjoner

- interesse

- Internet

- inn

- introdusere

- introdusert

- Introduserer

- innføre

- Introduksjon

- etterforskning

- involvere

- innebærer

- utstedelse

- saker

- IT

- DET ER

- Jobb

- Jobb

- reise

- jpg

- kunnskap

- kjent

- maling

- landing

- landskap

- Språk

- stor

- storskala

- større

- største

- Ventetid

- siste

- lag

- lag

- ledende

- Fører

- LÆRE

- lært

- læring

- mindre

- nivåer

- Leverage

- utnytter

- utnytte

- i likhet med

- sannsynligheten

- begrensning

- begrensninger

- Begrenset

- lokal

- Lang

- lang tid

- Se

- Lav

- lavere

- senking

- maskin

- maskinoversettelse

- laget

- opprettholde

- større

- gjøre

- Making

- måte

- mange

- kart

- Margin

- massive

- Match

- fyrstikker

- matchende

- matematiske

- Matrix

- max bredde

- maksimere

- maksimal

- måle

- mekanismer

- Minne

- bare

- sammenslåing

- metode

- metoder

- metodikk

- metoder

- millioner

- millioner

- minimal

- minimere

- feil

- modell

- modeller

- modifikasjoner

- Moduler

- mer

- mer effektivt

- Videre

- mest

- flere

- må

- Må lese

- smal

- Naturlig

- Naturlig språk

- Natural Language Processing

- Natur

- Trenger

- nødvendig

- behov

- Nerf

- Nets

- nettverk

- nettverk

- neural

- nevrale nettverket

- nevrale nettverk

- NeurIPS

- Nerveceller

- Ny

- nyheter

- neste

- nlp

- Nei.

- node

- noder

- bemerkelsesverdig

- note

- Merknader

- roman

- Antall

- objekt

- Målet

- mål

- observerte

- forekomst

- OCR

- of

- tilby

- Tilbud

- ofte

- on

- ONE

- seg

- på nett

- bare

- åpen kildekode

- drift

- Drift

- optimalisering

- Optimalisere

- optimalisert

- or

- Annen

- outperform

- bedre ytelse enn i

- utkonkurrerer

- produksjon

- utenfor

- enn

- Overcome

- overvinne

- oversikt

- pakke

- par

- pankaj

- Papir

- papirer

- Parallel

- parameter

- parametere

- Spesielt

- spesielt

- Patches

- Mønster

- for

- utføre

- ytelse

- utfører

- perioder

- Fotorealistisk

- plato

- Platon Data Intelligence

- PlatonData

- plausibel

- Point

- positur

- positurer

- potensiell

- potensielt

- kraftig

- Praktisk

- praktiske anvendelser

- forutsi

- Forutsigbar

- forutsi

- prediksjon

- Spådommer

- spår

- presentere

- presentert

- gaver

- rådende

- forrige

- primære

- Før

- sannsynlighet

- Problem

- problemer

- prosedyren

- prosess

- prosessering

- produsere

- dyp

- program

- programmer

- prosjekter

- foreslå

- foreslått

- foreslår

- foreslår

- Protein

- Proteiner

- utprøvd

- beviser

- gi

- gir

- gi

- publisert

- pytorch

- kvalitet

- spørsmål

- Race

- område

- rangerer

- priser

- heller

- Raw

- nådd

- Lese

- Lesning

- bekrefter på nytt

- ekte

- virkelige verden

- nylig

- nylig

- .

- anerkjennelse

- Anbefaling

- utvinne

- tilbakefall

- tilbakevendende

- rekursiv

- redusere

- Redusert

- reduserer

- redusere

- reduksjon

- referanse

- referanser

- reflektert

- om

- Regulere

- i slekt

- Relasjoner

- slipp

- utgitt

- avhengighet

- avhengig

- forblir

- bemerkelsesverdig

- gjengitt

- gjengivelse

- representere

- representasjon

- representant

- representerer

- krever

- behov

- Krav

- forskning

- forskning fellesskap

- forskere

- Ressurser

- resulterende

- Resultater

- omskolering

- avsløre

- Revolusjonere

- RGB

- ikke sant

- Risiko

- robust

- skalerbarhet

- skalerbar

- Skala

- vekter

- skalering

- scenarier

- scene

- Scener

- planlegging

- ordninger

- vitenskapelig

- Resultat

- skraper

- Søk

- dømme

- Sequence

- Serien

- serverer

- sett

- sett

- innstillinger

- flere

- Del

- deling

- kortsiktig

- Vis

- showcased

- utstillingsvindu

- viser

- Viser

- signaler

- betydning

- signifikant

- betydelig

- lignende

- likheter

- Enkelt

- samtidig

- situasjoner

- Størrelse

- dyktig

- problemfritt

- samfunnsmessig

- utelukkende

- løsning

- Solutions

- LØSE

- løser

- løse

- noen

- noen ganger

- Rom

- Plass og tid

- Spenning

- spesialisert

- spesifikk

- Spectral

- fart

- splittet

- Standard

- state-of-the-art

- uttalelser

- opphold

- Trinn

- lagring

- oppbevare

- Strategisk

- strategier

- Strategi

- sterk

- struktur

- strukturert

- strukturer

- kamper

- Studer

- betydelig

- i det vesentlige

- suksess

- vellykket

- vellykket

- slik

- lide

- foreslår

- egnet

- overlegen

- tilsyn

- overgår

- overgår

- SVG

- syntese

- system

- Systemer

- Oppgave

- oppgaver

- teknikker

- vilkår

- test

- tekst

- enn

- Det

- De

- Grafen

- deres

- Dem

- deretter

- teoretiske

- Disse

- de

- denne

- tusener

- tre

- Gjennom

- tid

- ganger

- til

- verktøy

- temaer

- mot

- tradisjonelle

- Tog

- trent

- Kurs

- overføre

- overførbar

- Overføre

- transformator

- transformers

- Oversettelse

- Oversettelseskvalitet

- Trender

- tuning

- tutorial

- to

- typer

- understreker

- forståelse

- unik

- lomper

- I motsetning til

- enestående

- oppdatert

- oppdateringer

- bruke

- brukt

- bruker

- ved hjelp av

- bruker

- v1

- Verdifull

- variabler

- ulike

- etterprøvbar

- allsidig

- allsidighet

- versjon

- video

- videoer

- Se

- visninger

- synlig

- syn

- synssystemer

- visuell

- Visuell gjenkjennelse

- volum

- vs

- var

- måter

- web

- vekt

- VI VIL

- når

- om

- hvilken

- mens

- bred

- Bred rekkevidde

- allment

- bredere

- Bredere fellesskap

- Wikipedia

- vil

- med

- innenfor

- uten

- ord

- Arbeid

- virker

- verdt

- skrevet

- år

- givende

- du

- Din

- zephyrnet