Bilde av forfatter

XAI er kunstig intelligens som lar mennesker forstå resultatene og beslutningsprosessene til modellen eller systemet.

Forklarbarhet før modellering

Forklarbar AI starter med forklarbare data og tydelig, tolkbar funksjonsteknikk.

Modelleringsforklaring

Når du velger en modell for et bestemt problem, er det generelt best å bruke den mest tolkbare modellen som likevel oppnår gode prediktive resultater.

Forklaring etter modell

Dette inkluderer teknikker som perturbasjon, hvor effekten av å endre en enkelt variabel på modellens utgang analyseres som SHAP-verdier for etter trening.

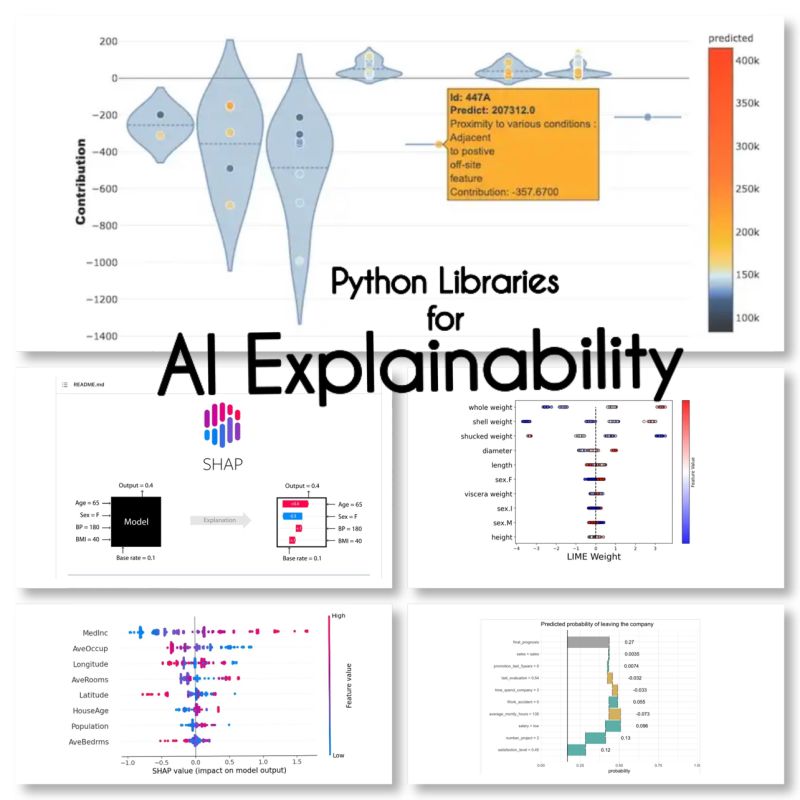

Jeg fant disse 10 Python-bibliotekene for AI-forklaring:

SHAP (SHapley Additive ExPlanations)

SHAP er en modellagnostiker og fungerer ved å bryte ned bidraget til hver funksjon og tilskrive en poengsum til hver funksjon.

LIME (lokale tolkbare modellagnostiske forklaringer)

LIME er en annen modellagnostisk metode som fungerer ved å tilnærme modellens oppførsel lokalt rundt en spesifikk prediksjon.

ELi5

Eli5 er et bibliotek for feilsøking og forklaring av klassifikatorer. Den gir funksjonsviktighetspoeng, så vel som "årsakskoder" for scikit-learn, Keras, xgboost, LightGBM, CatBoost.

Shapash

Shapash er et Python-bibliotek som har som mål å gjøre maskinlæring tolkbar og forståelig for alle. Shapash gir flere typer visualisering med eksplisitte etiketter.

Ankere

Anchors er en metode for å generere regler som kan tolkes av mennesker som kan brukes til å forklare spådommene til en maskinlæringsmodell.

XAI (forklarlig AI)

XAI er et bibliotek for å forklare og visualisere spådommene til maskinlæringsmodeller, inkludert funksjonsviktighetspoeng.

Sammenbrudd

BreakDown er et verktøy som kan brukes til å forklare spådommene til lineære modeller. Det fungerer ved å dekomponere modellens utdata til bidraget til hver inngangsfunksjon.

tolke-tekst

interpret-text er et bibliotek for å forklare spådommene til naturlige språkbehandlingsmodeller.

iml (tolkbar maskinlæring)

iml inneholder for øyeblikket grensesnittet og IO-koden fra Shap-prosjektet, og det vil potensielt også gjøre det samme for Lime-prosjektet.

aix360 (AI Explainability 360)

aix360 inkluderer et omfattende sett med algoritmer som dekker forskjellige dimensjoner

OmniXAI

OmniXAI (forkortelse for Omni eXplainable AI), tar opp flere problemer med å tolke dommer produsert av maskinlæringsmodeller i praksis.

Har jeg glemt noen biblioteker?

Kilder

Maryam Miradi er en AI og Data Science Lead med en PhD i maskinlæring og dyp læring, spesialisert i NLP og datasyn. Hun har 15+ års erfaring med å lage vellykkede AI-løsninger med en track record på å levere over 40 vellykkede prosjekter. Hun har jobbet for 12 forskjellige organisasjoner i en rekke bransjer, inkludert oppdagelse av finansiell kriminalitet, energi, bank, detaljhandel, e-handel og myndigheter.

- SEO-drevet innhold og PR-distribusjon. Bli forsterket i dag.

- Platoblokkkjede. Web3 Metaverse Intelligence. Kunnskap forsterket. Tilgang her.

- kilde: https://www.kdnuggets.com/2023/01/explainable-ai-10-python-libraries-demystifying-decisions.html?utm_source=rss&utm_medium=rss&utm_campaign=explainable-ai-10-python-libraries-for-demystifying-your-models-decisions

- 10

- a

- adresser

- Etter

- AI

- mål

- algoritmer

- tillater

- og

- En annen

- rundt

- kunstig

- kunstig intelligens

- Banking

- BEST

- Breaking

- endring

- velge

- fjerne

- kode

- omfattende

- datamaskin

- Datamaskin syn

- inneholder

- bidrag

- dekke

- Opprette

- Crime

- I dag

- dato

- datavitenskap

- Beslutningstaking

- avgjørelser

- dyp

- dyp læring

- levere

- forskjellig

- ned

- e-handel

- hver enkelt

- effekt

- energi

- Ingeniørarbeid

- alle

- erfaring

- Forklar

- Forklarbarhet

- Forklarbar AI

- forklare

- Trekk

- finansiell

- økonomisk kriminalitet

- glemt

- funnet

- fra

- generelt

- genererer

- god

- Regjeringen

- HTTPS

- Mennesker

- betydning

- in

- inkluderer

- Inkludert

- bransjer

- inngang

- Intelligens

- Interface

- IT

- dommer

- KDnuggets

- hard

- etiketter

- Språk

- føre

- læring

- bibliotekene

- Bibliotek

- Lime

- lokal

- lokalt

- maskin

- maskinlæring

- gjøre

- metode

- modell

- modeller

- mest

- Naturlig

- Naturlig språk

- Natural Language Processing

- nlp

- Omni

- organisasjoner

- Spesielt

- plato

- Platon Data Intelligence

- PlatonData

- potensielt

- praksis

- prediksjon

- Spådommer

- Problem

- problemer

- Prosesser

- prosessering

- produsert

- prosjekt

- prosjekter

- gir

- Python

- grunnen til

- rekord

- Resultater

- detaljhandel

- regler

- samme

- Vitenskap

- scikit lære

- sett

- flere

- Kort

- enkelt

- Solutions

- spesialisert

- spesifikk

- starter

- Still

- vellykket

- slik

- system

- teknikker

- De

- til

- verktøy

- spor

- Kurs

- typer

- forstå

- forståelig

- bruke

- Verdier

- variasjon

- syn

- visualisering

- hvilken

- vil

- arbeidet

- virker

- Xgboost

- år

- Din

- zephyrnet