Når det kommer til hjernedatabehandling, er timing alt. Det er hvordan nevroner kobles til kretsløp. Det er hvordan disse kretsene behandler svært komplekse data, som fører til handlinger som kan bety liv eller død. Det er hvordan hjernen vår kan ta avgjørelser på et splitsekund, selv når de står overfor helt nye omstendigheter. Og det gjør vi uten å steke hjernen av omfattende energiforbruk.

For å omformulere, er hjernen et utmerket eksempel på en ekstremt kraftig datamaskin å etterligne - og informatikere og ingeniører har tatt de første skritt mot å gjøre det. Feltet nevromorfisk databehandling ser ut til å gjenskape hjernens arkitektur og databehandlingsevner med nye maskinvarebrikker og programvarealgoritmer. Det kan være en vei mot sannhet kunstig intelligens.

Men ett avgjørende element mangler. De fleste algoritmer som driver nevromorfe brikker bryr seg bare om bidraget til hvert kunstig nevron - det vil si hvor sterkt de kobles til hverandre, kalt "synaptisk vekt." Det som mangler – men tilsvarer hjernens indre arbeid – er timing.

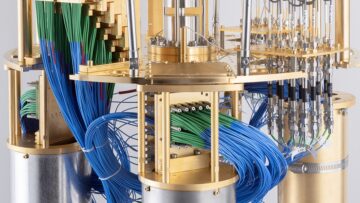

Denne måneden la et team tilknyttet Human Brain Project, EUs flaggskip big data nevrovitenskap, til elementet av tid til en nevromorf algoritme. Resultatene ble deretter implementert på fysisk maskinvare—den BrainScaleS-2 nevromorf plattform – og satt opp mot toppmoderne GPUer og konvensjonelle nevromorfe løsninger.

"Sammenlignet med de abstrakte nevrale nettverkene som brukes i dyp læring, henger de mer biologiske arketypene ... fortsatt etter når det gjelder ytelse og skalerbarhet" på grunn av deres iboende kompleksitet, sa forfatterne.

I flere tester sammenlignet algoritmen "gunstig, når det gjelder nøyaktighet, latens og energieffektivitet" på en standard benchmark-test, sa Dr. Charlotte Frenkel ved Universitetet i Zürich og ETH Zürich i Sveits, som ikke var involvert i studien. Ved å legge til en tidsmessig komponent i nevromorf databehandling, kan vi innlede en ny æra med svært effektiv AI som går fra statiske dataoppgaver – for eksempel bildegjenkjenning – til en som bedre innkapsler tid. Tenk på videoer, biosignaler eller hjerne-til-datamaskin-tale.

For hovedforfatteren Dr. Mihai Petrovici går potensialet begge veier. "Vårt arbeid er ikke bare interessant for nevromorf databehandling og biologisk inspirert maskinvare. Den anerkjenner også kravet … om å overføre såkalte dyplæringstilnærminger til nevrovitenskap og derved ytterligere avsløre hemmelighetene til den menneskelige hjernen,» sa.

La oss snakke pigger

I roten til den nye algoritmen ligger et grunnleggende prinsipp i hjernedatabehandling: pigger.

La oss ta en titt på et svært abstrahert nevron. Det er som en tutterull, med en bulformet midtseksjon flankert av to utadgående omslag. Den ene siden er inngangen - et intrikat tre som mottar signaler fra et tidligere nevron. Den andre er utgangen, sprengningssignaler til andre nevroner ved hjelp av boblelignende skip fylt med kjemikalier, som igjen utløser en elektrisk respons på mottakerenden.

Her er kjernen: for at hele denne sekvensen skal skje, må nevronet "spike". Hvis, og bare hvis, nevronet mottar et høyt nok inputnivå - en pent innebygd støyreduksjonsmekanisme - vil den bulbouse delen generere en pigg som beveger seg nedover utgangskanalene for å varsle neste nevron.

Men nevroner bruker ikke bare én pigg for å formidle informasjon. Snarere pigger de i en tidssekvens. Tenk på det som morsekode: tidspunktet for når et elektrisk utbrudd oppstår inneholder et vell av data. Det er grunnlaget for nevroner som kobles inn i kretsløp og hierarkier, og tillater svært energieffektiv prosessering.

Så hvorfor ikke ta i bruk samme strategi for nevromorfe datamaskiner?

En spartansk hjernelignende brikke

I stedet for å kartlegge en enkelt kunstig nevrons pigger - en herkulisk oppgave - gikk teamet inn på en enkelt metrikk: hvor lang tid det tar før en nevron avfyres.

Ideen bak "tid-til-første-spike"-koden er enkel: Jo lengre tid det tar et nevron å spike, jo lavere aktivitetsnivå. Sammenlignet med å telle topper, er det en ekstremt sparsom måte å kode en nevrons aktivitet på, men kommer med fordeler. Fordi bare ventetiden til første gang et nevron oppfrisker brukes til å kode aktivering, fanger det nevronets reaksjonsevne uten å overvelde en datamaskin med for mange datapunkter. Med andre ord, det er raskt, energieffektivt og enkelt.

Teamet kodet deretter algoritmen på en nevromorf brikke - den BrainScaleS-2, som omtrent emulerer enkle "nevroner" inne i strukturen, men kjører over 1,000 ganger raskere enn vår biologiske hjerne. Plattformen har over 500 fysiske kunstige nevroner, hver i stand til å motta 256 innganger gjennom konfigurerbare synapser, der biologiske nevroner bytter, behandler og lagrer informasjon.

Oppsettet er en hybrid. "Læring" oppnås på en brikke som implementerer den tidsavhengige algoritmen. Imidlertid oppnås eventuelle oppdateringer av den nevrale kretsen - det vil si hvor sterkt en nevron kobles til en annen - gjennom en ekstern arbeidsstasjon, noe som kalles "in-the-loop-trening."

I en første test ble algoritmen utfordret med oppgaven "Yin-Yang", som krever at algoritmen analyserer forskjellige områder i det tradisjonelle østlige symbolet. Algoritmen utmerket seg, med et gjennomsnitt på 95 prosent nøyaktighet.

Teamet utfordret deretter oppsettet med en klassisk dyp læringsoppgave—MNIST, et datasett med håndskrevne tall som revolusjonerte datasyn. Algoritmen utmerket seg igjen, med nesten 97 prosent nøyaktighet. Enda mer imponerende, BrainScaleS-2-systemet tok mindre enn ett sekund å klassifisere 10,000 XNUMX testprøver, med ekstremt lavt relativt energiforbruk.

Ved å sette disse resultatene i sammenheng, sammenlignet teamet deretter BrainScaleS-2s ytelse – bevæpnet med den nye algoritmen – med kommersielle og andre nevromorfe plattformer. Ta SpinNaker, en massiv, parallelt distribuert arkitektur som også etterligner nevral databehandling og pigger. Den nye algoritmen var over 100 ganger raskere ved bildegjenkjenning samtidig som den forbrukte bare en brøkdel av strømmen som SpiNNaker bruker. Lignende resultater ble sett med True North, den nevromorfe brikken fra IBM.

Hva Neste?

Hjernens to mest verdifulle datafunksjoner – energieffektivitet og parallell prosessering – inspirerer nå i stor grad neste generasjon databrikker. Målet? Bygg maskiner som er like fleksible og tilpasningsdyktige som våre egne hjerner, mens de bruker bare en brøkdel av energien som kreves for våre nåværende silisiumbaserte brikker.

Men sammenlignet med dyp læring, som er avhengig av kunstige nevrale nettverk, har biologisk plausible nettverk forsvunnet. En del av dette, forklarte Frenkel, er vanskeligheten med å "oppdatere" disse kretsene gjennom læring. Men med BrainScaleS-2 og et snev av tidsdata er det nå mulig.

Samtidig gir det å ha en "ekstern" voldgiftsdommer for å oppdatere synaptiske forbindelser hele systemet litt tid til å puste. Nevromorf maskinvare, som ligner på rotete i hjerneberegningen vår, er full av uoverensstemmelser og feil. Med brikken og en ekstern voldgiftsdommer kan hele systemet lære å tilpasse seg denne variasjonen, og til slutt kompensere for – eller til og med utnytte – dets særegenheter for raskere og mer fleksibel læring.

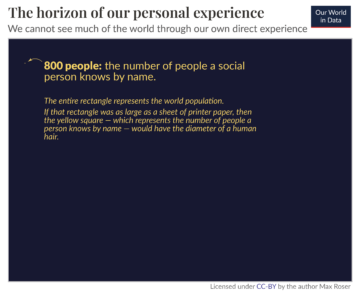

For Frenkel ligger algoritmens kraft i dens sparsomhet. Hjernen, forklarte hun, er drevet av sparsomme koder som "kan forklare de raske reaksjonstidene ... som for visuell prosessering." I stedet for å aktivere hele hjerneregioner, trengs bare noen få nevrale nettverk – som å suse nedover tomme motorveier i stedet for å sitte fast i rushtrafikken.

Til tross for sin kraft har algoritmen fortsatt hikke. Den sliter med å tolke statiske data, selv om den utmerker seg med tidssekvenser – for eksempel tale eller biosignaler. Men for Frenkel er det starten på et nytt rammeverk: viktig informasjon kan kodes med en fleksibel, men enkel metrikk, og generaliseres for å berike hjerne- og AI-basert databehandling med en brøkdel av de tradisjonelle energikostnadene.

"[Det]...kan være et viktig springbrett for å øke nevromorf maskinvare for å endelig demonstrere et konkurransefortrinn i forhold til konvensjonelle nevrale nettverkstilnærminger," sa hun.

Bildekreditt: Klassifisering av datapunkter i Yin-Yang-datasettet, av Göltz og Kriener et al. (Heidelberg / Bern)

- 000

- 100

- Fordel

- AI

- algoritme

- algoritmer

- tillate

- arkitektur

- kunstige nevrale nettverk

- forfattere

- benchmark

- Store data

- hjerner

- bygge

- hvilken

- kanaler

- kjemikalier

- chip

- chips

- kode

- kommersiell

- komponent

- Datamaskin syn

- datamaskiner

- databehandling

- Tilkoblinger

- forbruk

- Kostnader

- kreditt

- Gjeldende

- dato

- databehandling

- dyp læring

- Etterspørsel

- østlige

- effektivitet

- energi

- Ingeniører

- ETH

- ETH Zurich

- europeisk

- FAST

- Endelig

- Brann

- Først

- første gang

- Rammeverk

- GPU

- maskinvare

- Høy

- motorveier

- Hvordan

- HTTPS

- Hybrid

- IBM

- Tanken

- bilde

- Bildegjenkjenning

- informasjon

- involvert

- IT

- føre

- ledende

- LÆRE

- læring

- Nivå

- Lang

- maskiner

- trekk

- nettverk

- nettverk

- neural

- nevrale nettverket

- nevrale nettverk

- Neuroscience

- Bråk

- nord

- tall

- Annen

- ytelse

- fysisk

- plattform

- Plattformer

- makt

- prosjekt

- reaksjon

- svar

- Resultater

- Rull

- jag

- forskere

- skip

- Enkelt

- So

- Software

- Solutions

- Begynn

- oppbevare

- Strategi

- Studer

- sveits

- system

- test

- tester

- tid

- berøre

- trafikk

- Kurs

- universitet

- oppdateringer

- videoer

- syn

- Rikdom

- HVEM

- Wikipedia

- Metalltråd

- ord

- Arbeid

- Zürich