lekesirkel

Skaleringslover for læring av språkoverføring

Christina kim

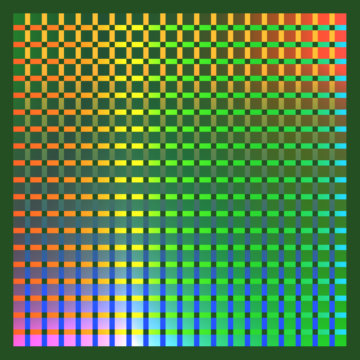

Tidligere var jeg grunnlegger av Sourceress, hvor jeg bygde infrastrukturen for maskinlæringsrørledningen vår og menneske-i-løkken-merkesystemet. Min bakgrunn er innen programvareutvikling og produksjon av maskinlæring. Bygget på OpenAIs nylige arbeid med skaleringslover, undersøker prosjektet mitt hvor mye trening på engelsk hjelper når du overfører på forskjellige språk, ettersom vi varierer modellstørrelse og datasettstørrelse. Jeg fant ut at a) forutdannede engelske modeller hjelper mest når du lærer tysk, deretter spansk og til slutt kinesisk og b) overføres fra engelsk til kinesisk, tysk og spansk skala, forutsigbart når det gjelder parametere, data og beregning.

Mitt råd til noen som begynner med dyplæringsforskning er å ta deg tid til å forstå innsikt fra grunnleggende artikler og huske at feltet fortsatt er relativt nytt. Det er mye rom for enkeltpersoner å ha en overdreven innvirkning.

lekesirkel

Tilbakemeldingsløkker i meningsmodellering

Danielle Ensign

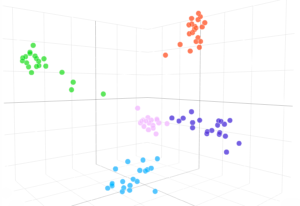

Jeg har bakgrunn fra programvareutvikling, AI Fairness og VR-spillutvikling. Jeg var interessert i Scholars-programmet som en måte å styrke forskningsferdighetene mine, lære av andre talentfulle mennesker i feltet og gå inn i bransjeforskning eller ingeniørstillinger. Prosjektet mitt er utforskende og undersøker tidligere arbeid med meningsmodellering fra konteksten av dyp læring. Ettersom disse modellene genererer mer og mer tekst, er det viktig å forstå hvilken innvirkning de vil ha på økosystemet til meninger og fremtidige modeller. I tillegg undersøkte jeg hva som skjer når modeller blir iterativt trent på utganger fra tidligere modeller.

Hvis du kan, kan du ta noen måneder på å jobbe nøye gjennom 2019 raskt. bra kurs (del 1 og 2), Andrew Ngs dype læringskurs om Coursera, David Silver RL-kursog Spinning Up i Deep RL. Hvis du ikke har bakgrunn i statistikk, vil det også være nyttig å bygge et mer solid fundament. Dette vil gi deg et forsprang i å lære å gjøre produktiv forskning ettersom du trenger å bruke mindre tid på å lære kjernekonseptene. I tillegg, hvis du ikke har gjort det ennå, kan du prøve å implementere noen papirer fra bunnen av i pytorch. Velg gamle papirer som har eksisterende implementeringer, slik at du kan referere til implementeringene hvis du blir sittende fast. Se om du kan forbedre papiret ved å bruke en idé fra et senere papir. Denne prosessen vil gi deg en bedre ide om hvordan DL-forskning er.

lekesirkel

Kontrastiv språkkoding

Ellie Kitanidis

Jeg er forsker med fysikkbakgrunn og fokus på mørk energi, mørk materie og storskala struktur i universet. For prosjektet mitt trente jeg en språkrepresentasjonsmodell ved hjelp av et rent kontrastivt mål. Jeg er interessert i generaliserbarheten og skalerbarheten til slike modeller sammenlignet med modeller som er trent med mer tradisjonelle språkmodelleringsmål. Jeg er også nysgjerrig på hvilke faktorer som påvirker ytelsen til kontrastive språkkodere. I denne samtalen presenterer jeg metodikken vår og noen foreløpige resultater.

Å navigere i en karriereendring under COVID-19 var skremmende, men dette programmet skapte det perfekte miljøet for meg å lære, få praktisk erfaring og orientere meg i feltet. Diskusjoner med mentoren min og andre på OpenAI utsatte meg for ekspertinnsikt og intuisjoner som ikke finnes i en lærebok. Det viktigste jeg oppdaget var imidlertid hvor mye jeg elsker å gjøre AI-forskning. Jeg planlegger å fortsette å utvide karrieren min i denne retningen.

lekesirkel

Storskala belønningsmodellering

Jonathan Ward

Jeg ble med på Scholars-programmet for å bygge datasystemer som bedre forstår hva folk virkelig setter pris på. Jeg bor i Washington, DC og i det siste har jeg virkelig hatt glede av å bygge fantastiske ting med K'nex. Mitt nylige arbeid på OpenAI har vist at belønningsmodeller trent på menneskelig tilbakemelding kan støtte forsterkningslæring. Prosjektet mitt viser at belønningsmodeller kan opplæres i storstilt strukturert tilbakemelding hentet fra nettsteder.

Mitt råd til folk som ønsker å bli med: lage open source-prosjekter! Finn den enkleste interessante ideen du kan tenke deg, og bygg den!

lekesirkel

Karakterisere testtid beregning på grafstrukturerte problemer

Kudzo Ahegbebu

Jeg er programvareingeniør med anvendt fysikk og romfart. Presentasjonen min utforsker generaliserbarheten av modeller som bruker testtidsberegning på en rekke domener, inkludert autoregressive transformatorer, dype likevektsmodeller og nevrale nettverk. I det spør jeg: Gitt begrensningene med et begrenset beregningsbudsjett for opplæring, kan små adaptive modeller i stedet utnytte testtid beregne for å overvinne ulempen med å ha et mindre antall lærbare parametere? Til slutt presenterer vi mekanismer som viser løfte om å redusere beregningskostnadene og forbedre ytelsen til nevrale nettverk.

Scholars-programmet har gitt meg tillit til å arbeide med nye veier med dyp læringsinteresse og forskning, samt et økt mål for kompetanse slik at jeg kan operere med større klarhet, effektivitet og etisk modenhet. Det har også gjenopprettet en latent forskningsinteresse som jeg håper å fortsette å gi næring til fremtiden.

lekesirkel

Bryter kontrastive modeller med SET-kortspillet

Legg Yeung

Jeg ble formelt utdannet som datavitenskapsmann og arkitekt, men jeg dreide karrieren min fordi AI har et mye høyere byrå for miljøet vårt enn konvensjonelle næringer, og det er mange interessante forskningsproblemer innen dette feltet. I prosjektet mitt utvidet jeg det velkjente kortspillet “SET” for å undersøke forholdet mellom vektors representasjonsdimensjon og oppgavesammensetning. Jeg fant ikke-kontrastive modeller av X-parametere for å løse spill som kontrastmodeller av 2X + -parametere ikke kan. Hva kan en kontrastmodell lære med vektorrepresentasjoner av størrelse 16/32/64/128/256/512? Og hva ikke?

Jeg kom til programmet med noen få interesser (resonnement, komposisjonalitet, multimodal). Mentoren min hjalp meg mye når det gjelder å krystallisere disse interessene til konkrete forskningsspørsmål og forslag. Vi utforsket flere retninger og fortsatte å itere til vi så noe lovende. Prosessen var intens, men leksjonene var verdt innsatsen.

lekesirkel

Ord til Bytes: Exploring Language Tokenizations

Sam Gbafa

Jeg ble tiltrukket av Scholar-programmet fordi jeg hadde sett noen av hva OpenAIs modeller kunne gjøre, og jeg ønsket å forstå hva som måtte til for å bygge og gjenta slike kraftige modeller. Å ha den dedikerte tiden til å utforske dyp læring med god mentorskap har vært transformerende i min evne til å forstå og bidra til feltet! Når jeg ikke jobber, driver jeg vanligvis med dingser eller søker adrenalin med venner. Prosjektet mitt utforsker avveiningene ved å bruke disse andre tokeniseringsskjemaene og hvordan disse forskjellige tokeniseringene skaleres. Jeg vurderer også en tilnærming til å lære seg sekvensens segmentering i stedet for å bruke en forhåndsdefinert.

Scholars-programmet ga meg muligheten til å utforske mange forskjellige ideer i ML og dyp læring, fra “klassiske” ting som CNN og RNN til forståelse av kompromissene med nyere transformatorvarianter. Å kunne ha samtaler med forskerne ved OpenAI fikk meg til å innse at grensen for AI-forskning er veldig tilgjengelig. Jeg ønsket opprinnelig å lære om den nåværende teknologien, men å være her de siste månedene har gitt meg forståelse for at jeg kan bidra meningsfullt til å fremme tilstanden til dyp læring og AI. Å være på OpenAI har også fått meg til å tenke mye på implikasjonene av modellene vi lager og måter å tilby slike modeller til verden samtidig som jeg minimerer potensiell skade.

lekesirkel

Studerer skaleringslover for transformatorarkitekturvarianter

Shola Oyedele

Jeg gikk nesten på fransk på college fordi jeg alltid har elsket språk. Jeg ser ofte på filmer og tv-serier på andre språk (ja - kdramas er øverst på listen), men jeg hadde aldri forestilt meg at min kjærlighet til språk ville føre til at jeg forsket i NLP. I forskningen undersøkte jeg avveiningene mellom modellytelse og kostnadene ved opplæring, og studerte skaleringslover på forskjellige transformatorarkitekturer for å forstå effekten av transformatorarkitektur på modellytelsen.

Alt om perspektivet mitt har endret seg siden jeg ble med i programmet. Det er svært få selskaper og institusjoner i verden som bruker maskinlæring i stor skala og har en visjon om hvor ML / AI-feltet er på vei. Enda færre er muligheter for de som ikke har forskningserfaring og en avansert grad, enn si et program fokusert på underrepresenterte grupper. Bare betydningen av å bli med på dette programmet i en tid da bransjen oppdager potensialet i GPT3, har endret visjonen min om hva fremtiden for teknologi tilbyr og hva min plass i det kan være. Jeg tror folk antar at du trenger en teknisk grad for å studere AI, men jeg var bare nysgjerrig på fremtiden og ønsket en del i å bygge den.

lekesirkel

Lære flere måter å oppføre seg i et kontinuerlig kontrollmiljø

Florentinsk (Tyna) Eloundou

Jeg søkte på OpenAI fordi jeg ønsket det dype privilegiet å kjempe med spørsmål som former stadig komplekse AI-systemer. Som en kamerunsk innfødt som vokste opp i USA, navigerer jeg i flere perspektiver (skolastisk, kulturelt og språklig) og var nysgjerrig på å lære hvordan AI lærer av menneskelige fellestrekk og forskjeller. De vanskelige fordelene og begrensningsteknologiprosessen kan noen ganger føre til feiljustering mellom en designers ide om suksess og dens analytiske spesifikasjon. Videre inneholder mange virkelige oppgaver flere mål, og nåværende tilnærminger innen forsterkningslæring gir ikke en direkte spak for å velge mellom Pareto-ekvivalente strategier. For å løse disse problemene forklarer jeg i prosjektet hvordan vi bruker "flere eksperter, flere mål" (MEMO) for å utforske en agents evne til å konsumere eksempler på suksess fra flere eksperter med forskjellige mål, og lære en enkelt betinget policy som kan være orientert etter skjønn av en veileder.

For nykommere i feltet vil jeg anbefale å gå sakte gjennom rene open source-implementeringer av kjente algoritmer mens du leser deres teoretiske forankring. Prøv å eksperimentere med designene ofte. Kursene til Fast.ai og Andrew Ng er gode ressurser for reisen.

Kilde: https://openai.com/blog/openai-scholars-2021-final-projects/

- &

- 11

- 2019

- 2021

- 7

- 9

- råd

- Aerospace

- AI

- ai forskning

- alex

- algoritmer

- andrew ng

- arkitektur

- Kunst

- Bank

- Berkeley

- merker

- bygge

- Bygning

- Karriere

- forårsaket

- konsernsjef

- endring

- Chicago

- Kinesisk

- Høyskole

- Selskaper

- Beregn

- databehandling

- selvtillit

- forbruke

- fortsette

- samtaler

- Coursera

- Covid-19

- Gjeldende

- Nåværende situasjon

- dato

- dataforsker

- dyp læring

- designer

- Utvikling

- Dimensjon

- oppdaget

- domener

- under COVID-19

- økosystem

- effektivitet

- energi

- ingeniør

- Ingeniørarbeid

- Engelsk

- Miljø

- eksperiment

- eksperter

- FAST

- Federal

- føderal reserve

- Federal Reserve Bank

- Endelig

- fitness

- Fokus

- Grunnleggeren

- framtid

- Gadgets

- spill

- Games

- GitHub

- grafiske nevrale nettverk

- flott

- Økende

- her.

- Hvordan

- Hvordan

- HTTPS

- IBM

- Tanken

- Påvirkning

- Inkludert

- bransjer

- industri

- påvirke

- Infrastruktur

- innsikt

- institusjoner

- interesse

- undersøke

- IT

- bli medlem

- merking

- Språk

- språk

- Lover

- føre

- LÆRE

- læring

- Leverage

- Begrenset

- Liste

- elsker

- maskinlæring

- måle

- Microsoft

- Microsoft Research

- ML

- modell

- modellering

- måneder

- Filmer

- nettverk

- neural

- nevrale nettverk

- nlp

- tilby

- Tilbud

- åpen

- åpen kildekode

- OpenAI

- Mening

- Meninger

- Annen

- andre

- Papir

- Ansatte

- ytelse

- perspektiv

- prospektet

- Fysikk

- politikk

- presentere

- program

- prosjekt

- prosjekter

- pytorch

- Quantum

- alle

- Lesning

- forsterkning læring

- forskning

- reservebank

- Ressurser

- Resultater

- Belønninger

- skalerbarhet

- Skala

- skalering

- sett

- Sølv

- Størrelse

- ferdigheter

- liten

- So

- Software

- programvareutvikling

- Software Engineer

- software engineering

- LØSE

- Rom

- bruke

- Tilstand

- statistikk

- Studer

- suksess

- støtte

- system

- Systemer

- Teknisk

- Teknologi

- test

- Fremtiden

- tid

- tokenization

- Tokeniseringer

- topp

- Kurs

- tv

- us

- verdi

- syn

- vr

- VR-spill

- washington

- Se

- nettsteder

- HVEM

- innenfor

- WordPress

- Arbeid

- verden

- verdt

- X