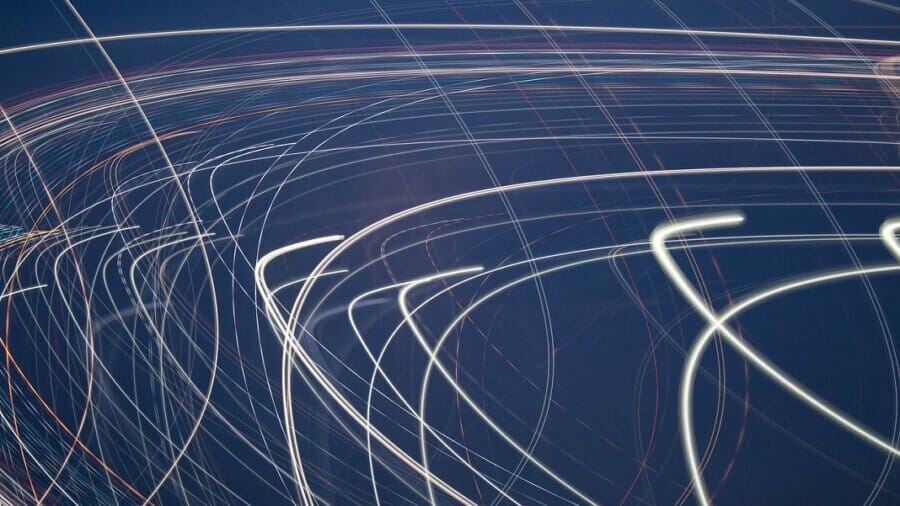

Etter hvert som AI-modeller blir stadig større, vil mengden penger og energi kreves for å trene dem har blitt et hot-button-problem. En ny tilnærming som omskriver en av de grunnleggende byggesteinene i disiplinen kan gi en mulig løsning.

Helt siden GPT-3 demonstrerte de betydelige hoppene i ytelse som kan oppnås ved ganske enkelt å økeNår det gjelder modellstørrelse, har ledere i AI-bransjen samlet ressurser i opplæring stadig mer massive nevrale nettverk.

Men dette koster enorme mengder penger, krever enorme dataressurser og bruker enorme mengder strøm. Det blir i økende grad sett på som et problem, ikke bare på grunn av miljømessige implikasjoner, men også fordi det gjør det vanskelig for mindre AI-antrekk å konkurrere, og som et resultat konsentrerer makten i hendene på industriledere.

Nå har imidlertid forskere fra Oxford University skissert en ny tilnærming som kan potensieltly halver treningstidene. De gjør det ved å omskrive en av de mest grunnleggende ingrediensene i dagens nevrale nettverksbaserte AI-systemer: tilbakeforplantning.

Hvordan et nevralt nettverk behandler data er styrt av styrken til forbindelsene mellom de forskjellige nevronene. Så for å få dem til å gjøre nyttig arbeid, må du først justere disse tilkoblingene til de behandler dataene slik du vil ha dem. Dette gjør du ved å trene nettverket på data som er relevant for problemet ved hjelp av en prosess som kalles tilbakepropagasjon, som er delt inn i to faser.

Foroverkjøringen innebærer å mate data gjennom nettverket og få det til å lage spådommer. I bakoverpasseringen brukes målinger av nøyaktigheten til disse spådommene for å gå tilbake gjennom nettverket og finne ut hvordan styrken til ulike koblinger bør justeres for å forbedre ytelsen. Ved å gjenta denne prosessen mange ganger med mye data, jobber nettverket gradvis mot en optimal konfigurasjon av tilkoblinger som løser problemet.

Denne repeterende prosessen er grunnen til at det tar så lang tid å trene opp AI, men Oxford-forskerne kan ha funnet en måte å forenkle ting på. Jegna pre-print lagt ut på arXiv, de deskribent en ny treningstilnærming som fjerner tilbakeleveringen helt. Algoritmen deres gjør i stedet estimater for hvordan vekter må gjøres be endret på foroverpasseringen, og det viser seg at disse tilnærmingene er nærme nok til å oppnå sammenlignbar ytelse med tilbakeforplantning.

Forskerne viste at tilnærmingen kan brukes til å trene en rekke forskjellige maskinlæringsalgoritmer, men fordi den bare involverer en foroverpasning, var den i stand til å kutte treningstiden med så mye som halvparten.

Det er et enkelt matematisk triks, Andrew Corbett fra University of Exeter i Storbritannia fortalte New Scientist, men covil bidra til å takle en av de mest presserende utfordringene AI står overfor i dag. "Det er en veldig, veldig viktig ting å løse, fordi det er flaskehalsen til maskinlæringsalgoritmer," sa han.

Hvor bredt anvendelig tilnærmingen er gjenstår imidlertid å se. I papiret deres viser forskerne at forskjellen i kjøretidskostnader krymper etter hvert som antall lag i et nevralt nettverk øker, noe som tyder på at teknikken kan ha avtagende avkastning med større modeller.

Forskerne bemerker imidlertid også at de har identifisert en rekke muligheter for å finjustere måten standard maskinlæringsalgoritmer fungerer for å passe bedre til metoden deres, noe som kan føre til ytterligere ytelsesgevinster.

Forskningen kan også potensielt bidra til et pågående mysterium innen menneskelig intelligens. Kunstige nevrale nettverk er fortsatt et av våre beste verktøy for å undersøke hvordan hjernen lærer, men det haDet har lenge vært kjent at tilbakepropagering ikke er biologisk plausibel på grunn av mangelen på noen bakoverkobling mellom nevroner. En læringstilnærming som bare krever et foroverpass kan bidra til å kaste lys over hvordan hjernen vår løser læringsproblemet.

Bilde Credit: Pexels / 9144 bilder

- "

- AI

- algoritme

- algoritmer

- beløp

- beløp

- aktuelt

- tilnærming

- kunstig

- bli

- BEST

- Bygning

- utfordringer

- databehandling

- Konfigurasjon

- Tilkoblinger

- Tilkobling

- bidra

- Kostnader

- kunne

- kreditt

- dato

- demonstrert

- forskjellig

- enorm

- miljømessige

- estimater

- vendt

- FAST

- raskere

- Først

- Forward

- funnet

- få

- hjelpe

- Hvordan

- HTTPS

- stort

- menneskelig

- viktig

- forbedre

- industri

- Intelligens

- utstedelse

- IT

- kjent

- større

- føre

- læring

- lett

- Lang

- maskin

- maskinlæring

- GJØR AT

- Making

- massive

- modell

- modeller

- penger

- mest

- nettverk

- nettverksbasert

- nettverk

- Antall

- Muligheter

- Oxford

- Oxford universitet

- Papir

- ytelse

- potensiell

- makt

- Spådommer

- Problem

- prosess

- Prosesser

- gi

- relevant

- påkrevd

- forskning

- forskere

- Ressurser

- avkastning

- Kjør

- Sa

- signifikant

- Enkelt

- Størrelse

- So

- LØSE

- fart

- splittet

- Systemer

- Gjennom

- i dag

- dagens

- verktøy

- Kurs

- Uk

- universitet

- ulike

- Arbeid

- trene

- virker