AI og konvensjonelle datamaskiner er en match made in hell.

Hovedårsaken er hvordan maskinvarebrikker er satt opp for øyeblikket. Basert på den tradisjonelle Von Neumann-arkitekturen, isolerer brikken minnelagring fra hovedprosessorene. Hver beregning er en marerittaktig pendling mandag morgen, med brikken som konstant skytter data frem og tilbake fra hvert rom, og danner en beryktet "minnevegg».

Hvis du noen gang har sittet fast i trafikken, vet du frustrasjonen: det tar tid og bortkastet energi. Etter hvert som AI-algoritmer blir stadig mer komplekse, blir problemet stadig verre.

Så hvorfor ikke designe en brikke basert på hjernen, en potensiell perfekt match for dype nevrale nett?

Skriv inn compute-in-memory, eller CIM, brikker. Disse brikkene, tro mot navnet sitt, beregner og lagrer minne på samme sted. Glem pendling; brikkene er svært effektive alternativer for arbeid hjemmefra, som eliminerer flaskehalsproblemet med datatrafikk og lover høyere effektivitet og lavere energiforbruk.

Eller slik er teorien. De fleste CIM-brikker som kjører AI-algoritmer har utelukkende fokusert på brikkedesign, og viser frem egenskapene deres ved å bruke simuleringer av brikken i stedet for å kjøre oppgaver på fullverdig maskinvare. Brikkene sliter også med å tilpasse seg flere forskjellige AI-oppgaver – bildegjenkjenning, stemmeoppfatning – noe som begrenser integreringen i smarttelefoner eller andre hverdagslige enheter.

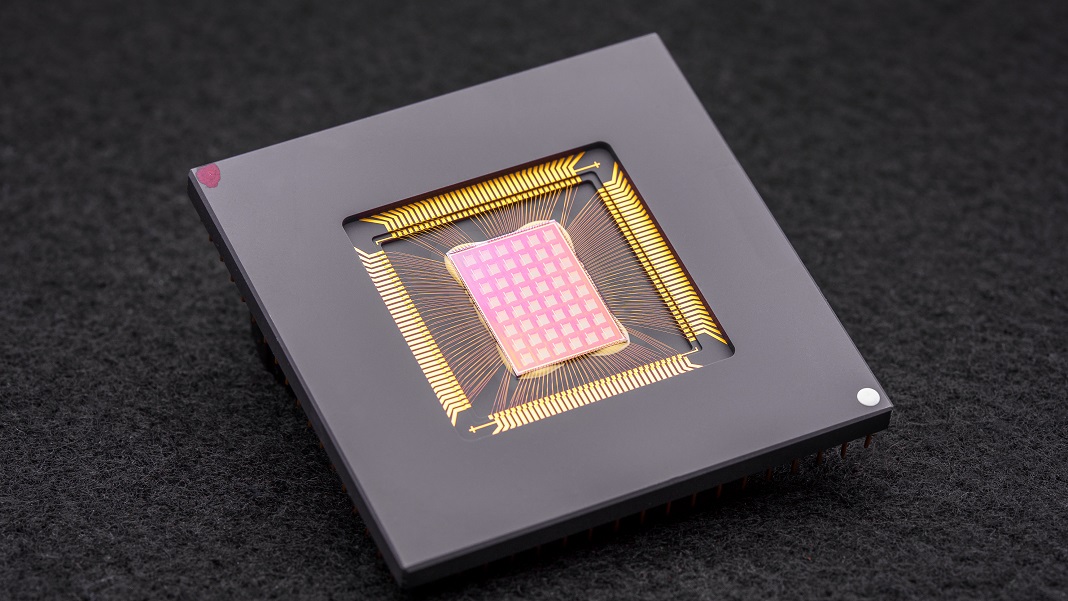

Denne måneden en studie in Natur oppgradert CIM fra grunnen av. I stedet for å fokusere utelukkende på brikkens design, har det internasjonale teamet – ledet av nevromorfe maskinvareeksperter Dr. H.S. Philip Wong ved Stanford og Dr. Gert Cauwenberghs ved UC San Diego – optimaliserte hele oppsettet, fra teknologi til arkitektur til algoritmer som kalibrerer maskinvaren.

Den resulterende NeuRRAM-brikken er en kraftig nevromorf databehandling med 48 parallelle kjerner og 3 millioner minneceller. Ekstremt allsidig taklet brikken flere AI-standardoppgaver – som å lese håndskrevne tall, identifisere biler og andre objekter i bilder og dekode stemmeopptak – med over 84 prosent nøyaktighet.

Selv om suksessraten kan virke middelmådig, konkurrerer den med eksisterende digitale brikker, men sparer dramatisk energi. For forfatterne er det et skritt nærmere å bringe AI direkte til enhetene våre i stedet for å måtte sende data til skyen for beregning.

"Å få disse beregningene gjort på brikken i stedet for å sende informasjon til og fra skyen kan muliggjøre raskere, sikrere, billigere og mer skalerbar AI i fremtiden, og gi flere mennesker tilgang til AI-kraft," sa wong.

Nevral inspirasjon

AI-spesifikke brikker er en nå en forbløffende krone et dusin. Fra Googles Tensor Processing Unit (TPU) og Teslas Dojo-superdatamaskinarkitektur til Baidu og Amazon, investerer teknologigiganter millioner i AI-brikkenes gullrush for å bygge prosessorer som støtter stadig mer sofistikerte dyplæringsalgoritmer. Noen til og med utnytte maskinlæring for å designe brikkearkitekturer skreddersydd for AI-programvare, og bringer løpet full sirkel.

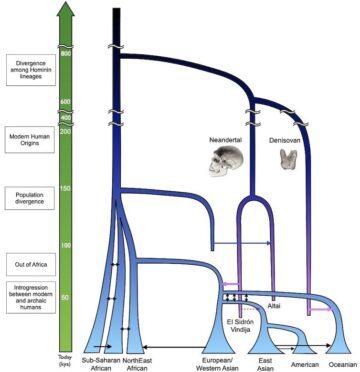

Et spesielt spennende konsept kommer rett fra hjernen. Når data passerer gjennom nevronene våre, "kobles" de til nettverk gjennom fysiske "dokker" kalt synapser. Disse strukturene, som sitter på toppen av nevrale grener som små sopp, er multitaskere: de både beregner og lagrer data gjennom endringer i proteinsammensetningen deres.

Med andre ord, nevroner, i motsetning til klassiske datamaskiner, trenger ikke å overføre data fra minnet til CPUer. Dette gir hjernen sin fordel i forhold til digitale enheter: den er svært energieffektiv og utfører flere beregninger samtidig, alt pakket inn i en tre-kilos gelé fylt inne i skallen.

Hvorfor ikke gjenskape aspekter av hjernen?

Enter nevromorf databehandling. Et hack var å bruke RRAM-er, eller resistive minneenheter med tilfeldig tilgang (også kalt "memristorer"). RRAM-er lagrer minne selv når de er koblet fra strøm ved å endre motstanden til maskinvaren. I likhet med synapser kan disse komponentene pakkes inn i tette arrays på et lite område, og skaper kretser som er i stand til svært komplekse beregninger uten bulk. Kombinert med CMOS, en fabrikasjonsprosess for å bygge kretser i våre nåværende mikroprosessorer og brikker, duoen blir enda kraftigere for å kjøre dyplæringsalgoritmer.

Men det har en kostnad. "Den svært parallelle analoge beregningen innen RRAM-CIM-arkitektur gir overlegen effektivitet, men gjør det utfordrende å realisere samme nivå av funksjonell fleksibilitet og beregningsnøyaktighet som i digitale kretser," sa forfatterne.

Optimalisering Genie

Den nye studien fordypet seg i hver del av en RRAM-CIM-brikke, og redesignet den for praktisk bruk.

Det starter med teknologi. NeuRRAM har 48 kjerner som beregner parallelt, med RRAM-enheter fysisk sammenvevd i CMOS-kretser. Som et nevron kan hver kjerne slås av individuelt når den ikke er i bruk, og spare energi mens minnet er lagret på RRAM.

Disse RRAM-cellene – alle tre millioner av dem – er koblet sammen slik at data kan overføres i begge retninger. Det er en avgjørende design som lar brikken fleksibelt tilpasse seg flere forskjellige typer AI-algoritmer, forklarte forfatterne. For eksempel er en type dype nevrale nett, CNN (convolutional neural network), spesielt god til datasyn, men trenger data for å flyte i en enkelt retning. I motsetning til dette behandler LSTM-er, en type dype nevrale nett som ofte brukes til lydgjenkjenning, data for å matche signaler med tid. I likhet med synapser koder brikken hvor sterkt ett RRAM "nevron" kobles til et annet.

Denne arkitekturen gjorde det mulig å finjustere dataflyten for å minimere trafikkork. Som å utvide enkeltfeltstrafikk til flerfelts, kan brikken duplisere et nettverks nåværende "minne" fra de fleste beregningsintensive problemer, slik at flere kjerner analyserer problemet samtidig.

En siste forbedring av tidligere CIM-brikker var en sterkere bro mellom hjernelignende beregninger – ofte analoge – og digital prosessering. Her bruker brikken en nevronkrets som enkelt kan konvertere analog beregning til digitale signaler. Det er et steg opp fra tidligere "kraft- og område-hungrige" oppsett, forklarte forfatterne.

Optimaliseringene fungerte. Etter å ha satt teorien sin på prøve, produserte teamet NeuRRAM-brikken og utviklet algoritmer for å programmere maskinvaren for forskjellige algoritmer – som Play Station 5 som kjører forskjellige spill.

I en rekke benchmark-tester presterte brikken som en mester. Ved å kjøre en syv-lags CNN på brikken, hadde NeuRRAM mindre enn én prosent feilrate ved å gjenkjenne håndskrevne sifre ved å bruke den populære MNIST-databasen.

Den utmerket seg også på vanskeligere oppgaver. Ved å laste et annet populært dypt nevralt nett, LSTM, var brikken omtrent 85 prosent riktig når den ble utfordret med Googles talekommandogjenkjenning. Ved å bruke bare åtte kjerner, var brikken – som kjører på enda en AI-arkitektur – i stand til å gjenopprette støyende bilder, noe som reduserer feil med omtrent 70 prosent.

Og så?

Ett ord: energi.

De fleste AI-algoritmer er totalenergisvin. NeuRRAM opererte til halvparten av energikostnadene til tidligere toppmoderne RRAM-CIM-brikker, og oversatte løftet om energisparing med nevromorf databehandling ytterligere til virkelighet.

Men studiens fremstående er dens strategi. Altfor ofte når de designer brikker, må forskere balansere effektivitet, allsidighet og nøyaktighet for flere oppgaver – beregninger som ofte er i strid med hverandre. Problemet blir enda tøffere når all databehandling gjøres direkte på maskinvaren. NeuRRAM viste at det er mulig å kjempe mot alle dyrene samtidig.

Strategien som brukes her kan brukes til å optimalisere andre nevromorfe dataenheter som f.eks faseendringsminneteknologis, sa forfatterne.

Foreløpig er NeuRRAM et proof-of-concept, som viser at en fysisk brikke – i stedet for en simulering av den – fungerer etter hensikten. Men det er rom for forbedringer, inkludert ytterligere skalering av RRAM-er og krymping av størrelsen til en dag som potensielt passer inn i telefonene våre.

"Kanskje i dag brukes den til å gjøre enkle AI-oppgaver som søkeordoppsporing eller menneskelig deteksjon, men i morgen kan det muliggjøre en helt annen brukeropplevelse. Se for deg sanntids videoanalyse kombinert med talegjenkjenning, alt i en liten enhet. sa studieforfatter Dr. Weier Wan. "Som forsker og ingeniør er ambisjonen min å bringe forskningsinnovasjoner fra laboratorier til praktisk bruk."

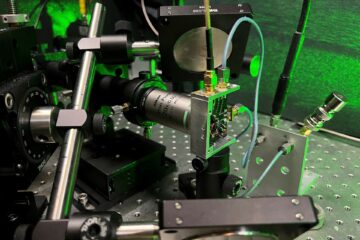

Bilde Credit: David Baillot/University of California San Diego