Komentarz Jak dotąd w tym roku w USA miało miejsce ponad 250 masowych strzelanin, a zwolennicy sztucznej inteligencji uważają, że mają rozwiązanie. Nic dziwnego, że nie kontrola broni, ale lepsza technologia.

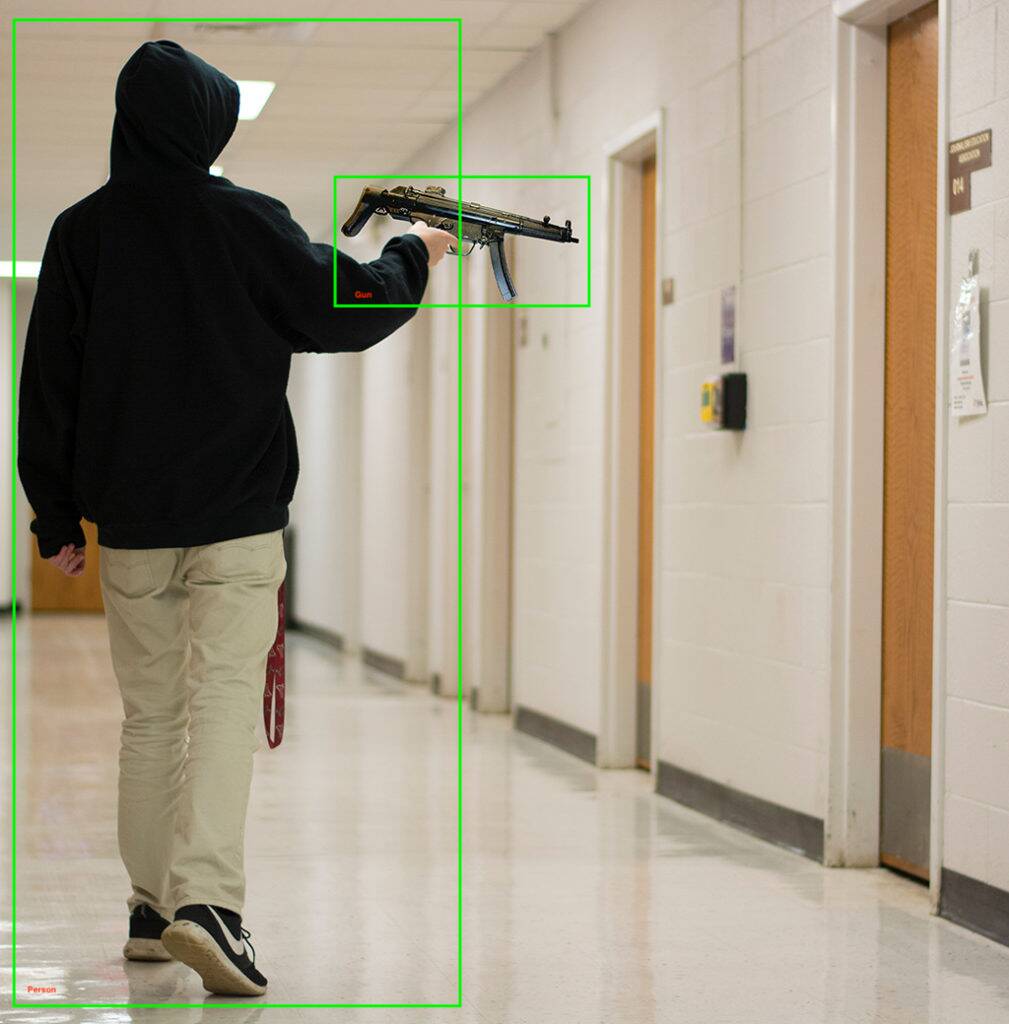

Firma Kogniz, zajmująca się uczeniem maszynowym, ogłosiła we wtorek, że dodaje gotowe do wdrożenia model wykrywania pistoletu do swojej platformy komputerowej wizji. System, jak nam powiedziano, może wykrywać broń widzianą przez kamery bezpieczeństwa i wysyłać powiadomienia do zagrożonych, powiadamiając policję, blokując budynki i wykonując inne zadania związane z bezpieczeństwem.

Oprócz wykrywania broni palnej, Kogniz używa swoich innych modułów widzenia komputerowego, aby zauważyć nietypowe zachowania, takie jak dzieci biegnące korytarzami lub ktoś wspinający się przez okno, co może wskazywać na aktywnego strzelca.

Jeśli zastanawiasz się nad fałszywym alarmem lub wskaźnikiem błędów kodu, Kogniz mówi, że ma „wieloprzebiegową sztuczną inteligencję” i „wyszkolony zespół ludzkich weryfikatorów” sprawdzających wyniki swojego oprogramowania do wykrywania. Albo z zadowoleniem przyjmujesz ten dodatkowy poziom potwierdzenia, albo postrzegasz go jako technologię, która potencjalnie spada na ludzi właśnie wtedy, gdy komputery są najbardziej potrzebne.

„[Nasze rozwiązanie] znacznie ułatwia firmom, agencjom rządowym, szkołom i szpitalom przygotowanie się, a następnie zmniejszenie szkód wyrządzonych przez aktywną strzelankę”, powiedział Daniel Putterman, dyrektor generalny Kogniz.

Kogniz nie jest pierwszą firmą zajmującą się widzeniem komputerowym, która wkroczyła do gry w rozpoznawanie broni – istnieje pokaźna lista firm wdrażających podobną technologię, a niektóre, takie jak ZeroEyes, specjalizują się wyłącznie w wykrywaniu broni palnej.

„Rozciągając swoją uwagę na wiele ofert, programiści są mniej w stanie zapewnić najlepsze usługi w zakresie wykrywania broni”, powiedział ZeroEyes w blogu. Technologia ZeroEyes została wdrożona w szkołach w 14 stanach, w tym Oksfordzkie Liceum w metrze Detroit, gdzie w zeszłym roku 15-letni strzelec zabił cztery i ranił siedem.

Inni dostawcy – tacy jak Defendry, który ma pakiet zabezpieczeń, w tym aplikację przycisku paniki, czujniki dźwiękowe wystrzału, drony reagujące jako pierwsze i sztuczną inteligencję do wykrywania broni; i Omnilert – znajdują się na tym przygnębiającym rynku wzrostu. Inne firmy zajmujące się wykrywaniem broni AI to Arcarith, Athena Securities i Scylla.

Czy rzeczywiście jest wystarczająco dużo czasu?

W 2019 r. reakcja policji na masową strzelaninę w Dayton w stanie Ohio wyniosła zaledwie 32 sekundy, podczas których zginęło dziewięć osób. Strzelanina w 2021 r. w zakładzie FedEx w Indianapolis, w której zginęło dziewięć osób, również się skończyła, zanim policja zdążyła przybyć, mimo że zrobili to w ciągu kilku minut.

Oba te przypadki rodzą pytanie, czy wykrywanie broni AI może skrócić czas reakcji na tyle, aby uratować życie. Zwłaszcza jeśli funkcjonariusze są zbyt przestraszeni lub nie chcą właściwie reagować, jak na przykład w przypadku masowego morderstwa w Uvalde.

Zaproponowano kilka innych metod zapobiegania masowym strzelaniom w oparciu o sztuczną inteligencję, takich jak: inteligentne pistolety które nie wystrzelą, jeśli wykryją ludzki cel. Inni zaproponowali szkolenie AI na podstawie danych z poprzednich strzelanin, lokalnych zakupów broni i danych społeczno-ekonomicznych, aby znaleźć trendy wskazujące na planowaną strzelaninę, a także skanowanie mediów społecznościowych pod kątem podobnych wskaźników.

Jest także Stronniczość AI, A dobrze udokumentowany problem że nawet różnorodne zbiory danych i zbilansowane szkolenia wydaje się, że nie mogę rozwiązać. Przeprowadź wdrożenie technologii rozpoznawania twarzy i broni w 2020 r. w okręgu szkolnym w Nowym Jorku: wiadomości e-mail między okręgiem szkolnym a firmą, która wdrożyła system, często wyrażają obawy dotyczące tego problemu błędna identyfikacja rzeczy, takie jak uchwyty do mioteł do broni.

W rozmowie z publikacją z Utah, Deseret News, starszy analityk ds. polityki ACLU, Jay Stanley powiedziany obawiał się, że komputerowe systemy wizyjne mogą doprowadzić do świata, „w którym ludzie unikają robienia czegoś tak prostego, jak skakanie po chodniku z obawy przed uruchomieniem detektorów anomalii i przesłuchaniem przez policję”.

Jedno z możliwych zastosowań sztucznej inteligencji może być bardziej obiecujące: 2018 „The Puzzle of Monogamous Marriage” z Centrum Medycznego Szpitala Dziecięcego w Cincinnati stwierdził, że analiza sesji terapeutycznych prowadzona przez sztuczną inteligencję zgadzała się z ocenami zagrożenia dokonywanymi przez psychiatrów i doradców w 91% przypadków. Dodanie danych demograficznych i społeczno-ekonomicznych tylko poprawiło wyniki w identyfikacji młodych ludzi, którzy byli zagrożeni popełnieniem aktu przemocy.

Czy przy tak wielu potencjalnych komplikacjach uczenie maszynowe jest naprawdę gotowe do zapobiegania masowym morderstwom?

Przemoc z użyciem broni to zabójca numer jeden dzieci i nastolatków w Ameryce, zabijając średnio 12 młodych ludzi i raniąc 32 kolejne każdego dnia. Sztuczna inteligencja może pomóc, ale bez usuwania jej niedociągnięć, być może potrzebne są również mniej podejścia technologicznego. Silniejsza, szerzej dostępna opieka psychiatryczna może być dobrym początkiem.

Na początku tego miesiąca prezydent Biden nazywa między innymi za zakaz posiadania broni szturmowej, rozszerzone kontrole przeszłości i ograniczenia pojemności magazynka, które nazwał „racjonalnymi, zdroworozsądkowymi środkami”. ®

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- Rejestr

- zefirnet